Rangliste

Beliebte Inhalte

Inhalte mit der höchsten Reputation seit 24.10.2020 in allen Bereichen anzeigen

-

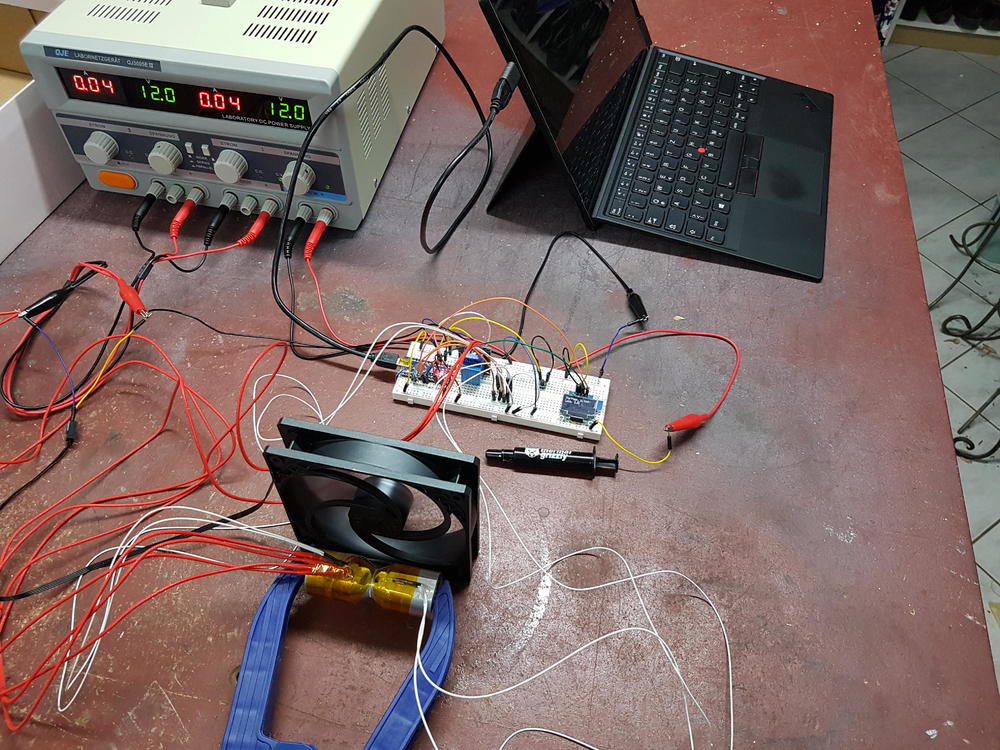

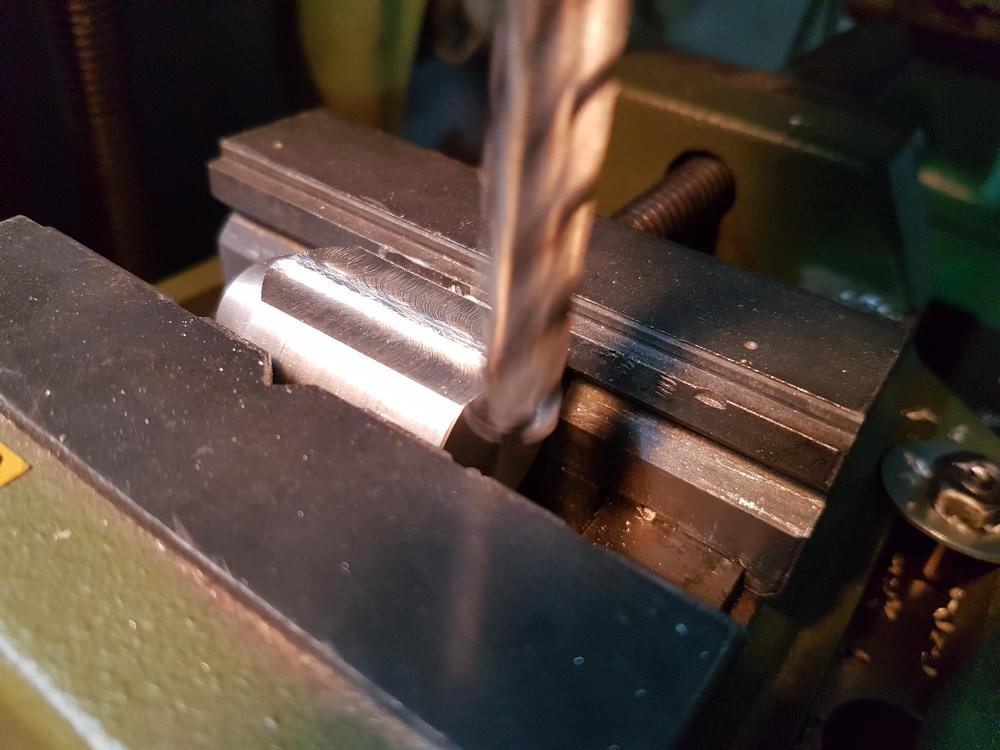

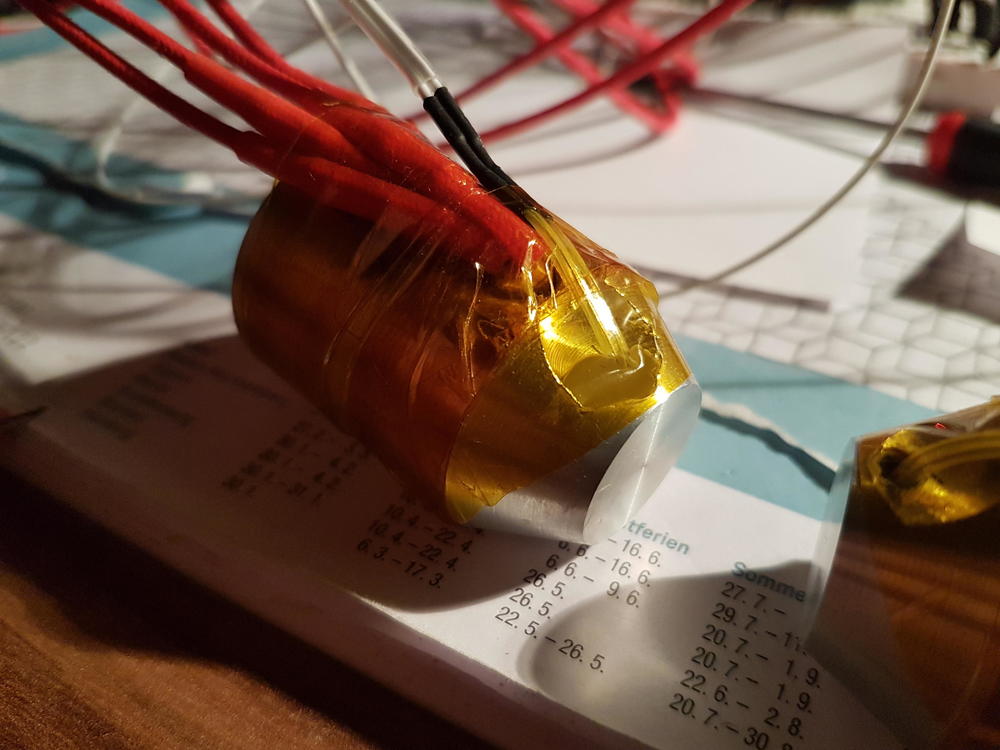

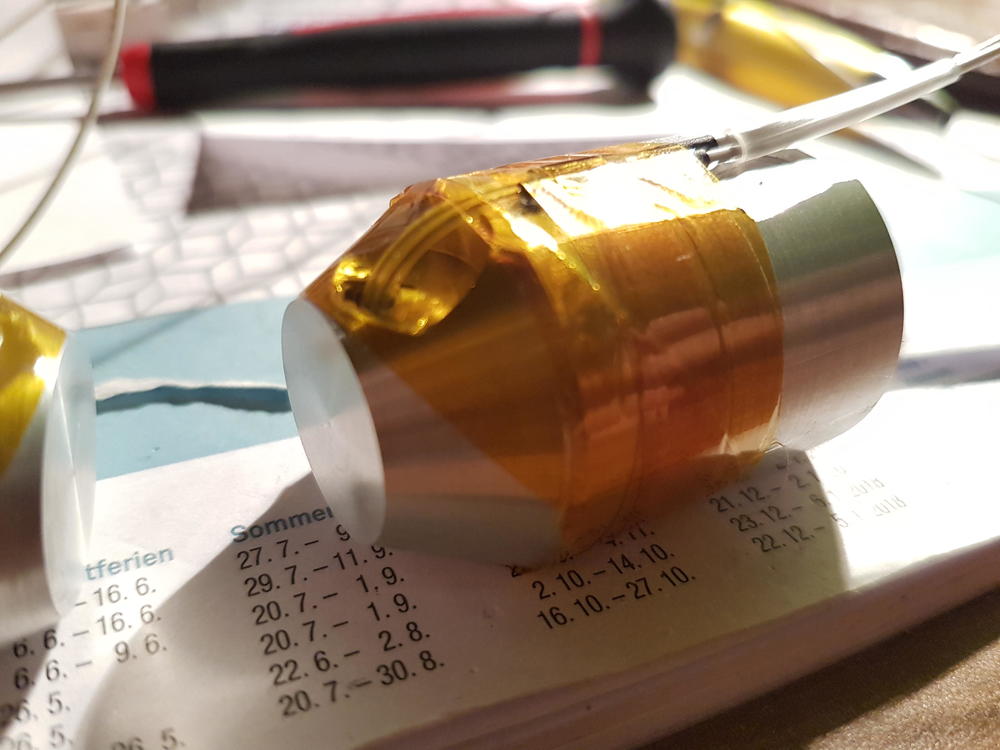

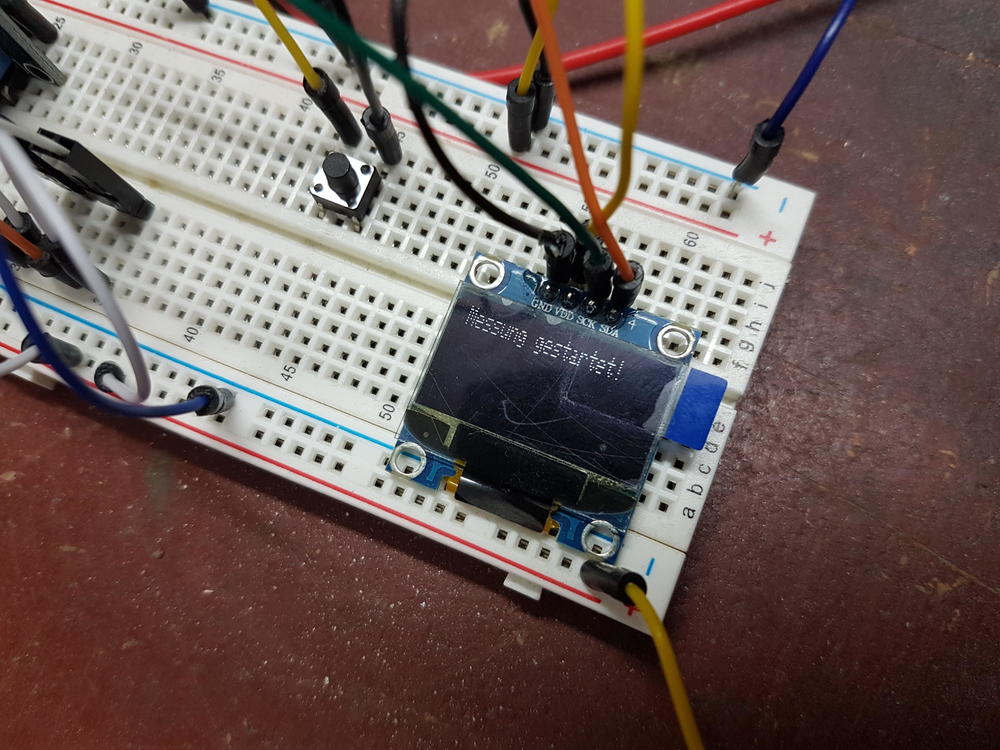

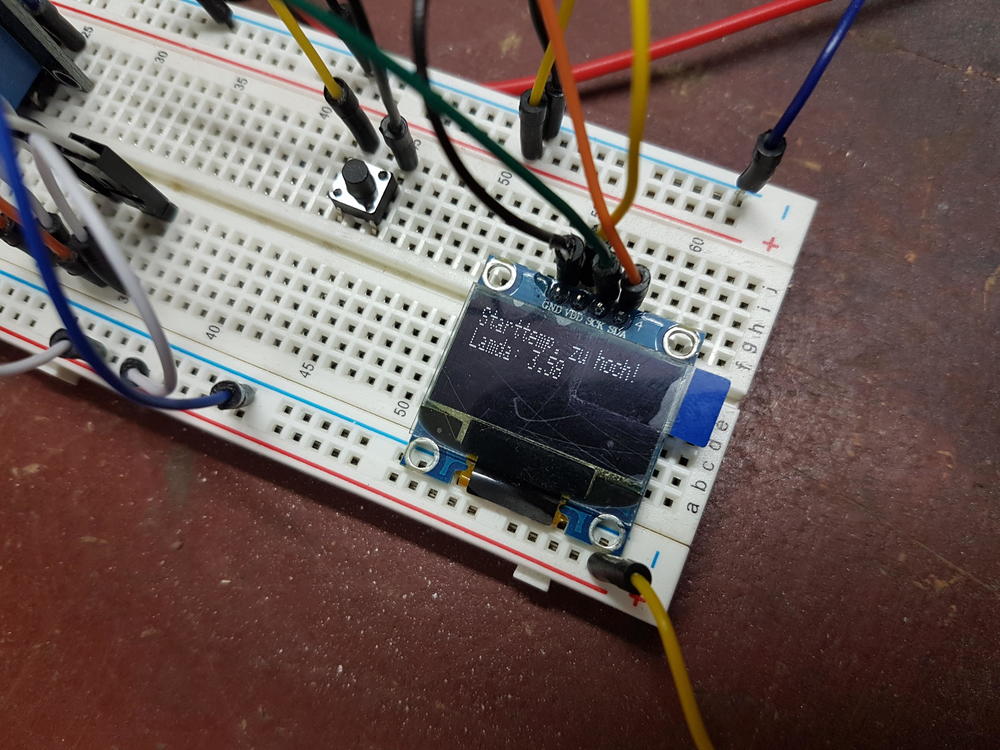

Moin zusammen, wie ihr sicher alle schon am eigenen Leib erfahren musstet, kann die Frage: "Was ist eigentlich die beste Wärmeleitpaste?" zu einem Kleinkrieg der Meinungen führen. Häufig kommen dabei Aussagen wie "Also bei mir läuft es seit dem 3°C kühler!" oder "Die Herstellerangaben stimmen nicht!" auf. Ich habe mir in den letzten zwei Wochen das Ziel gesetzt, mich mal wissenschaftlich mit dem Thema zu beschäftigen und, so hoffe ich, endlich Klarheit in diese Thematik zu bringen. Zunächst zu den oft gehörten und hier frei zitierten Aussagen: "Also bei mir läuft es seit dem 3°C kühler!" mag bei dem Autor stimmen, trägt aber keinerlei Aussagekraft für andere Systeme. Tatsächliche Abwärme, Lufttemperatur und Luftfeuchtigkeit, Nutzungsverhalten, Gehäuse, Kühloberfläche und Wärmeleitwege haben einen viel zu großen Einfluss. Selbst die Schlussfolgerung "besser als die alte Paste" ist mit Vorsicht zu genießen. Pasten altern viel zu unterschiedlich und auch die Temperatur, bei der sie getestet werden ist maßgeblich. Dazu aber im nächsten Absatz mehr. Sehr verwundert hat mich die Aussage: "Die Herstellerangaben stimmen nicht!". Ich konnte mir kaum vorstellen, dass die Hersteller auf ihren Verpackungen lügen. Viel zu groß ist die Gefahr sich damit selbst sein "Image-Grab" zu schaufeln. Bei der Recherche ist mir ein wesentlicher Punkt aufgefallen: Es steht nie dabei, in welchem Temperaturbereich der Wärmeleitwert gemessen wurde, oder bei welcher Schichtstärke. Die Wärmeleitfähigkeit von Flüssigkeiten (mit einem flüchtigen Bestandteil) nimmt mit steigender Temperatur ab. Das hängt mit dem Phasenverhalten der einzelnen Bestandteile der Paste zusammen. Wurde vom Hersteller also bei einer sehr geringen Temperatur gemessen, kann das die Wärmeleitfähigkeit positiv beeinflussen. Auch die Schichtdicke ist nicht uninteressant. Der Wärmeübergang an den Oberflächen der Paste ist schlechter als im Inneren. Also kann eine Dicke Schicht die Werte des Herstellers auch schönen. Aber Vorsicht! Das bedeutet nicht, dass eine dicke Schicht in PC besser ist. So oder so ist die Leitfähigkeit der Paste schlechter als die von Kupfer oder Aluminium. Daher sollte die Schicht natürlich IMMER so dünn wie möglich sein. Wie wir sehen konnten gibt es einige Möglichkeiten für die Hersteller die Ergebnisse zu beeinflussen. Doch wie bekommt man jetzt heraus welche Paste für welchen Anwendungsfall die beste ist? Zu diesem Zwecke habe ich mit einen Versuch überlegt. Wen nur die Ergebnisse interessieren, der kann weiter unten gucken. Für die technisch Interessierten unter euch (ich tippe auf die Mehrheit) habe ich versucht mein Vorgehen (hoffentlich verständlich) zusammen zu tragen. Grundaufbau und Idee: Der Versuch besteht aus einem leistungsstarken Labornetzteil, einem Steckbrett mit Arduino zur Datenverarbeitung, einem Laptop zur Anpassung der Prüfparameter, einem Lüfter zum schnelleren Abkühlen nach dem Versuch und.... dem eigentlichen Experiment. Das besteht aus zwei identischen Aluminiumkörpern mit Sensoren und Heizelementen. Beide Körper haben eine sehr ebene Prüffläche auf die die Wärmeleitpaste aufgetragen wird. Mit einer kräftigen Kunststoffklemme wird der Anpressdruck erzeugt. Die beiden Blöcke habe ich aus Aluminium gedreht und gefräst. Sie haben genau die gleichen Abmaße, was bei der Berechnung der thermischen Kapazität wichtig wird. Außerdem habe ich die Messoberfläche sehr fein geschlichtet, um eine spiegelnd glatte und Ebene Auftragsfläche für die Paste zu erzeugen. Anschließend habe ich den ersten Block mit zwei Keramikheizelementen ausgestattet. Diese eigenen sich besonders gut, da sie die Wärme über einen elektrischen Widerstand erzeugen und somit einen Wirkungsgrad von fast 100% haben. Jedes Element hat ca. 40W Wärmeleistung. Außerdem habe ich einen Temperaturfühler (NTC-Thermistor mit 100k) nur einen Millimeter hinter der Messfläche in der Mitte angebracht. Der zweite Block bekam nur einen Sensor und keine Heizelemente. Die Idee hinter dem Aufbau: Wenn der erste Block erwärmt wird beginnt ein Wärmestrom durch die Prüffläche und die Wärmeleitpaste in den zweiten Block zu fließen. Dieser Wärmestrom ist, in Abhängigkeit der Schichtdicke, der Auflagefläche und der Temperaturdifferenz, begrenzt durch den Wärmeleitwert zwischen den Prüfflächen. Thermodynamik 🤮 Ich muss zugeben, dass Thermodynamik nicht mein Lieblingsfach im Studium war. Jedoch ist das hier ein relativ einfacher Zusammenhang und somit nicht ganz so sauer, wie es meiner Überschrift aufstößt. Für die Berechnung des Wärmeleitwerts benötigen wir folgende Größen: Den Wärmefluss Qp [W] Den Abstand zwischen den Messflächen l [m] Die Fläche der Messflächen A [m²] Die Temperaturdifferenz der Messflächen dT [°K] Gesucht ist der Wärmeleitwert lamda [W/m*K] = [W*m/m²*K]. Nun ist leider die Wärmeleistung der Heizelemente nicht gleich dem Wärmefluss zwischen den Blöcken. Jeder kennt dieses Phänomen aus dem Alltag. Stellt man einen Topf auf den Herd, so dauert es eine Weile, bis er heiß genug zum kochen ist. Das liegt an der Wärmekapazität. Um das zu erklären ist es zunächst wichtig zu verstehen, dass Wärme und Temperatur nicht die gleichen Dinge sind. Wärme ist eine Energieform, weshalb ihre Einheit auch Joule oder Wattsekunde ist - daher auch der Wärmefluss in Watt! Die Temperatur gibt an, wie viel Energie in Abhängigkeit der Wärmekapazität ein einer bestimmten Menge eines bestimmten Stoffes enthalten ist. Das ist sehr kompliziert ausgedrückt, was im Grunde auch jeder von zuhause kennt. Man braucht mehr Energie um ein kg Wasser zu erhitzen als ein kg Luft. Die Einheit der Wärmekapazität ist J / kg * K (Joule pro Kilogramm mal Kelvin). Aluminium besitzt eine Wärmekapazität von 900 J/kg*K. Da ein Joule gleich einer Wattsekunde ist, kann man sagen, dass man 900W braucht um 1kg Alu um ein Grad Kelvin in einer Sekunde zu erwärmen. Werden nun beim Versuch die Blöcke erwärmt, kann man anhand dieses Zusammenhangs und der Heizdauer die Leistung berechnen, die in das Alu geflossen ist. Rechnet man die beiden Leistungen der Blöcke zusammen. Erhält man eine Leistung, die knapp unter der Elektrischen Leistung liegt. Die Differenz ist Wärme, die von den Blöcken an die Luft abgegeben wurde. Daraus wird ein Korrekturwert berechnet, der zusammen mit der Leistung des zweiten Blocks den Wärmestrom durch die Paste ergibt. Ab hier ist es einfach. Der Anstand der Messflächen ergab sich als 0,05mm und die Oberfläche ist aus der Konstruktion bekannt. Somit kann der Wärmeleitwert berechnet werden. Versuchsdurchführung und Ergebnisse Durch einen Druck auf einen kleinen Taster wir die Messung gestartet. Von der Raumtemperatur ausgehend habe ich auf 35°C, 50°C und 100°C erhitzt. Am Ende des Versuchs wurde mir das Messergebnis auf einem kleinen OLED angezeigt. Ich habe auch die Wärmeleitfähigkeit eines Motoröls gemessen, da diese dort sehr genau im Datenblatt angegeben wurde und konnte damit die Richtigkeit meiner Messergebnisse sehr gut belegen. Alle Werte lassen sich mit einer Genauigkeit von 0,02W/m*K reproduzieren. Ich habe folgende Pasten getestet: Thermal Grizzly Kryonaut fast 5 Jahre alt aber noch sehr flüssig und nicht eingetrocknet angegeben mit 12,5W/m*K Thermal Grizzly Kryonaut 1g Packung (war bei meinem Kühlblock dabei) kein Jahr alt aber schon ziemlich hart aber noch nicht trocken angegeben mit 12,5W/m*K Industrielle Wärmeleitpaste angegeben mit 1,73W/m*K Wärmeleitmittel 20°C bis 35°C 20°C bis 50°C 20°C bis 100°C Luftspalt (0,01mm) 0,17 W/m*K X X Thermal Grizzly (0,05mm) alt 7,03 W/m*K 4,24 W/m*K 1,68 W/m*K Thermal Grizzly (0,05mm) 1g Packung 2,40 W/m*K 1,48 W/m*K 1,48 W/m*K Motoröl 15W40 0,48 W/m*K 0,38 W/m*K 0,24 W/m*K Industriepaste 3,58 W/m*K 1,97 W/m*K 1,32 W/m*K Alle Angaben mache ich nach bestem Wissen und Gewissen aber ich hafte natürlich nicht für etwaige Fehler, die mir bei der Messung unterlaufen sein könnten. Als nächstes möchte ich gern von euch wissen, welche Pasten am interessantesten zum testen sind. Ich werde mir auf jeden Fall frische Thermal Grizzly Kryonaut und Arctic MX5 besorgen. Aber wenn ihr noch interessante Pasten für mich habt, lasst es mich gerne wissen. In Zukunft soll mein Prüfaufbau das Steckbrett verlassen. Ich werde eine Platine und ein eigenes Netzteil mit interner Leistungsmessung ergänzen um die Genauigkeit und die Bedienfreundlichkeit zu erhöhen. Falls ihr Ideen dazu habt auch immer her damit. Vielleicht hat ja sogar der eine oder andere an einem fertigen Produkt. Ich hoffe Ihr habt Spaß mit meinem kleinen Versuch und findet die Ergebnisse (die noch folgen werden) hilfreich. LG11 Punkte

-

Kurztest Razer Blade 18 und Asus Scar G18 So, hab sowohl das Blade 18 als auch das Scar G18 ausgepackt und getestet. Am interessantesten für mich war, wie viel Leistungsaufnahme die (starken) CPUs bei Dual-Load in einem noch erträglichen (4X dbA) Lüfter-Profil ("Balanced" oder ähnlich) abführen können/dürfen. Außerdem war für mich interessant, wie die Charakteristik der Lüfter ist. Zur (permanenten, also PL1) CPU-Leistungsaufnahme im „Balanced-Mode“. Bei z.B. FarCry 6, was auch ordentlich CPU-Leistung für viele fps möchte, fällt die CPU bereits nach kurzer Zeit auf ca. 45 W (Blade 18) bzw. 55 W (Scar G18). Das ist definitiv zu wenig, hierdurch fallen die fps auch ordentlich und CPU-Limits verschärfen sich deutlich. Für mich indiskutabel: FarCry 6 Savegame im CPU-Limit (wenig Load auf der GPU) im Leistungs-/Lüfter-Profil "Balanced" (beim Scar G18 heißt es „Leistung“) 10900K (Area 51m R2) bei um die 125 W: 92 fps 13950HX (Blade 18) bei um die 45 W: 103 fps 13980HX (Scar G18) bei um die 55 W: 118 fps 13900K (Mini-ITX-Desktop) bei um die 105 W: 161 fps Hinweis 1: Der in der Überschrift genannte Leistungs-/Lüfter-Modus bezieht sich natürlich nur auf das Blade 18 und Scar G18, das Area 51m R2 lief im Silent-Modus und der Desktop ja eh völlig individuell Hinweis 2: Beim Area 51m R2 wird bei um die 125 W im Silent-Profil (!) das langfristige Temp-Limit erreicht, sonst wären wohl noch paar fps mehr drinnen. Würde die GPU voll arbeiten, wären aber etwas weniger Watt möglich, aber wie gesagt: Silent-Profil! Die anderen beiden Laptops dürfen halt einfach langfristig gar nicht mehr (PL1) Hinweis 3: Egal ob die GPU voll arbeitet oder nicht, beim Desktop wird bei um die 105 W mein langfristige Temp-Limit erreicht (das Mini-ITX-Gehäuse ist ja sehr klein und es wird ein kleiner CPU-Kühler verwendet, den ich auch noch zusätzlich auf leise getrimmt habe. Was der 13900K aber bei um die 105 W abliefert, ist ja absolut beeindruckend). Mit mehr Lüfter-rpm und/oder einem größeren CPU-Kühler würden noch mehr als 161 fps möglich sein. Der Abstand zu den mobilen Top-CPUs bei Dual-Load in den 18er Laptops ist ja aber jetzt schon riesig. Bei um die 90 W liefert der 13900K übrigens noch immer 156 fps - wie gesagt 161 bei um die 105 W). Hinweis 4: In dem Beispiel / Spiel mögen für viele auch bereits die 92 fps des Alienware Area 51m R2 / 10900K ausreichend sein. Aber erstens gibt es üblere Stellen im Spiel, und zweitens gibt es mittlerweile so einige Spiele, wo man die fps quasi durch 2 teilen kann, und dann bleibt bei allen Laptops nicht mehr viel über bzw. nicht einmal stabile 60 fps in entsprechenden Szenen. Das mag bei solchen Spielen auf schlechte Entwicklung / Optimierung / Ports zurück zu führen sein, aber was will man machen, wenn einem diese Spiele gefallen... Das Scar G18 ist schneller als das Blade 18, was nicht nur durch die höhere Leistungsaufnahme zu erklären ist. Einer der Gründe ist die etwas besser taktende CPU, ein weiterer vielleicht der Ram (nicht verglichen). Beim maximalem Leistungs-/Lüfter-Profil (5X dbA) sind dann im gleichen Test ca. 65 W bei beiden dauerhaft möglich. Natürlich liegen die ersten wenigen Minuten bei beiden über 100 W an. Ein so lautes (Hilfe!) Lüfter-Profil ist für mich indiskutabel. Zudem ist die Leistungsaufnahme für meinen Geschmack immer noch zu wenig: FarCry 6 Savegame im CPU-Limit (wenig Load auf der GPU) im maximalen Leistungs-/Lüfter-Modus 10900K (Area 51m R2) bei um die 125 W: 92 fps 13950HX (Blade 18) bei um die 65 W: 110 fps 13980HX (Scar G18) bei um die 65 W: 118 fps 13900K (Mini-ITX-Desktop) bei um die 105 W: 161 fps Die ganzen Zahlen schwanken minimal, ist quasi jeweils ungefähr ein Mittelwert. Es geht ja auch nicht darum, ob es hier und da 1-2 fps weniger oder mehr sind, man sieht überall große Unterschiede. An der Stelle nochmal gesagt: Es geht hier um ein CPU-Limit, die GPU ist jeweils bei weitem nicht ausgelastet. Es spielt also keine Rolle, dass im Mini-ITX-Desktop eine schnellere 4080-Desktop-Karte verbaut ist, die fps-Differenzen kommen alleine durch die CPU-Unterschiede zu Stande. Übrigens werden die CPUs der beiden Laptops, auch im maximalen Leistungs-/Lüfter-Profil, im Dual-Load schon sehr heiß. Das künstliche Limit also z.B. mit ThrottleStop zu umgehen (sofern möglich) würde hier nicht viel bringen. Viel ist halt relativ, müsste man testen und schauen ob einem das reicht. Ich habe auch mal beim Blade die Leistung der GPU deutlich reduziert (weit unter 70 W), dann hat die CPU in FarCry 6 tatsächlich - scheinbar dauerhaft zwischen deutlich bessere 90-110 W geschwankt. Aber ab 70-80 W auf der GPU (und das braucht man ja mindestens schon...) fällt sie dann auf die genannten ca. 65 W ab. Wahrscheinlich irgendwann so oder so. 90-110 W bringen übrigens schon 12X-13X (je nach Laptop) fps bei FarCry 6, aber man wird sie halt nur in den ersten wenigen Minuten zu Gesicht bekommen... (im CPU-Limit in genau diesem Savegame bzw. an der Stelle im Spiel). Wie ich gestern schon gepostet habe, kann das MSI GT77 Titan oder auch das XMG Neo 16 (sicher auch 17) teilweise mehr als 65 W durchschnittlich abführen (laut computerbase.de), und das auch bei Dual-Load. Das Blade 18 und Scar G18 jedoch nicht, wenn die GPU stock oder auch mit UV arbeitet. Und das ist definitiv in manchen Spielen ein riesen Nachteil (heftigeres CPU-Limit hier und da). Ich glaube nicht daran, dass es beim m18 großartig anders sein wird. Und das MSI oder das XMG gefällt mir nicht bzw. lässt so viel Leistungsaufnahme auf der CPU auch nur in (für mich) viel zu lauten Leistungs-/Lüfter-Profilen zu, was ja bekanntermaßen für mich sowieso ein absolutes Ausschlusskriterium ist. Das würde natürlich auch das m18 betreffen. Zur Charakteristik der Lüfter Blade 18: Gar nicht so übel, auch wenn ich es nicht rauschig nennen würde. Rauschig ist es für mich erst, wenn ein Lüfter sich mehr rauschig anhört, als die anderen Geräusche. Ein Area 51m R2 würde ich als rauschig bezeichnen, auch wenn man dort noch was anderes raushört, aber das macht eben keine 50% aus. Richtig rauschig sind meines Erachtens z.B. gewisse Desktop-Lüfter von Noctua Scar G18: Schlechter finde ich. Hat noch weniger mit Rauschen zu tun, irgendwie mehrere unangenehme Geräusche. Zudem heftiges coil-whine, was ich beim Blade 18 nicht bemerkt habe. Es ist lauter wie bei einigen Highend-Desktop-GPUs... Auf die Lautstärke jeweils brauche ich nicht einzugehen - beide viel zu laut. Und leiser betreiben ist wegen zu starker Drosselung, sei es thermisch oder künstlich, nicht vernünftig möglich. Display: Allgemein: 18 Zoll wirken erstmal mega toll und modern (dünner Rand für so ein großes Display). Und man benötigt eigentlich auch kein 27“ mehr auf dem Schreibtisch, man ist ja näher dran. Aber viele von euch nutzen ja eh größere Displays als 27 Zoll auf dem Schreibtisch. Blade 18: Katastrophe, wie @pitha1337 schon schrieb. Flickering vom Feinsten (auch in Windows - das wird sicher noch irgendwann gefixt), dazu sieht man das „Netz“ des Displays. Bei der Auflösung bei 18“ müsste das nicht sein, ist einfach kein gutes Panel. Scar G18: Deutlich besseres / zufriedenstellendes Panel, ohne die Farben beurteilt zu haben. Ich gehe auch nicht auf Glowing und Clouding ein, das haben beide ganz gut gehabt... Anmutung & Qualität Blade 18: Natürlich super gut. Scar G18: In live deutlich wertiger als ich bisher so an Bildern und Videos gesehen habe. Ich habe es aber auch bisher nur kurz mit Tageslicht gesehen. Meine aber auch die Oberflächen und das wenig knarrt oder sowas. Sollte man sich aber auf jeden Fall live anschauen, wenn der Rest passt / es einen interessiert Auf Tastatur, Design, Sound, Webcam, Akkulaufzeit usw. gehe ich jetzt nicht ein. Wenn ihr Fragen habt, schießt los. Dann noch für @captn.ko Undervolting @ CPU: Hab wirklich keinen Nerv das noch zu testen, sorry, zumindest nicht mehr heute. Ich schicke es aber erst Montag oder so zurück, insofern ist noch Zeit. Wie im Artikel von gestern steht, geht beim Scar G18 nur 30 mV übers Bios, beim Blade sicher nicht mehr. Und selbst wenn, die CPU hat andere Probleme - auch mit UV… PL-Reduktion @ GPU: Ist bei beiden über z.B. Afterburner möglich, im Gegensatz zu älteren Ampere-/Turning-Laptops. Noch besser - vorallem für Teillast - ist natürlich die Reduktion der Maximalspannung (UV) über z.B. den Afterburner Curve Editor (was natürlich auch wie immer funktioniert). Computerbase hatte aber mit der PL-Reduktion über Afterburner teilweise Probleme, so dass sich nicht alle Spiele daran gehalten haben. Das habe ich jetzt nicht getestet. Fazit Wie ich hier geschrieben hatte, benötige ich (nun definitiv glücklicherweise) nicht mehr unbedingt ein Gaming-Laptop, und werde mein Mini-ITX-Desktop behalten bzw. einen Zweiten für meine Frau bauen (welcher das Area 51m R2 Laptop ersetzt. Für mobile Zwecke bzw. Mitnahme Urlaube / Hotels, wo wir nicht zocken, haben wir ein 16" Macbook Pro). Nach diesem Test sind im Prinzip alle Gaming-Laptops - unabhängig vom Lüfter-Profil - nicht für mich (als Haupt-Spiele-PC) zu gebrauchen. Ein Area 51m (R2) durfte noch im Silent-/Balanced-Profil ins CPU-Temperatur-Limit laufen (und das entsprechende Kühlsystem hierzu war vorhanden!), das hätte man wenigstens wieder so machen können, anstatt in leisen und mittleren Lüfter-Profilen künstliche Leistungsaufnahme(TDP)-Limits zu setzen. Schade, aber schon seit Jahren bei allen Herstellern und Modellen die ich kenne Normalität. Aber manche Modelle würden auch wegen schlechtem Kühlsystem nicht mehr Leistungsaufnahme im entsprechenden Lüfter-Profil schaffen, teilweise macht es also Sinn... außerdem liegen so nicht immer 95-100 Grad an, was den Käufer beruhigt. Im Vergleich zum 13900K im Desktop ist die mobile Variante - unabhängig der Leistungsaufnahme - deutlich langsamer wie man sieht. Aber das war ja schon immer so und wird wohl auch so bleiben. Das einzige was wirklich toll ist, ist natürlich die Effizienz bzw. die Perfomance der CPUs bei nur 45-65 W. Aber wenn man den Desktop-13900K auf 45-65 W reduzieren würde, wäre das ähnlich. Ich glaube man muss abschließend einfach festhalten und akzeptieren, dass eine hohe dauerhafte (PL1) Leistungsaufnahme von z.B. um die 100 W auf der mobilen CPU bei gleichzeitiger GPU-Load - wenn überhaupt (bei vielen Gaming-Laptops schon mal nicht) - nur mit sehr lautem Leistungs-/Lüfter-Profil möglich ist, was für mich absolut nicht in frage kommt. Es müsste sich vorher für mich also grundlegend das Kühlsystem ändern und/oder die Chips dürften nicht mehr so viel Leistungsaufnahme benötigen. Vorher kann wohl kein Gaming-Laptop mehr für mich in frage kommen. Eine absolute Ausnahme war eigentlich das Area 51m (R2). Möglicherweise auch das Clevo X170KM-G/XMG Ultra 17 (hatte ich nie getestet und wird wie das Area 51m nicht mehr mit aktueller Gen versorgt). Im Grunde hat sich also mit der neuen Gaming-Laptop-Generation jetzt gar nichts geändert. Die 18 Zoll Gaming-Laptops sind in allem etwas besser, aber eben halt auch nicht mehr. edit: Drei Hinweise unter den fps-Werten (FarCry 6 Test) hinzugefügt.10 Punkte

-

*keine Spoiler* Ich habe Cyberpunk 2077 seit über einer Woche durch, wollte die Eindrücke aber etwas sacken lassen, bevor ich etwas dazu hier schreibe. Ich hab das Spiel als männlicher V mit einem Fokus auf Itelligenz gespielt, also als Netrunner/Hacker. Mit meiner GTX 1080 musste ich die Grafik runter drehen, 2560x1080 bei hohen Details mit 30 bis 40 FPS. Während dem Spiel gab es viele Stellen die mich beeindruckt habe und direkt nach dem Ende war ich richtig geflascht. Was für ein Ritt . Egal ob es die Grafik war, die Gestaltung der Stadt, die Musik oder die erzählte Geschichte des Hautstrangs und auch einiger Nebenmissionen. Die Hauptgeschichte hat mir durchgehen sehr gut gefallen. Dabei lernt man zwei Charaktäre kennen, mit denen man jeweils eine Nebengeschichte erleben kann. Beide haben mir gut gefallen. Dazu gibt es noch vier größere Questreihen, die ich erlebt habe und eine eigene, kleine Geschichte erzählen, wovon eine ein sehr verstörendes Ende nehmen kann (war ein sehr goßer WTF Moment bei mir). Ein paar weitere Auftraggeber erscheinen immer mal wieder, vergeben aber eher wiederkehrende Aufträge mit ein paar Highlights, mit denen man die Stadt aber gut kennen lernt. Eine kleine Quest muss ich hier empfehlen: Taxiservice Delamain. Machen! Alles habe ich in Night City nicht gesehen, nach 55 Stunden lief bei mir der Abspann. Neben der Hautgeschichte habe ich alle größeren Nebengeschichten und ein paar andere Quests erledig. Das waren die intensivsten 55 Studen, die ich in den letzten Jahren gespielt habe! Es war auch das erste umfangreiche Spiel, das ich innerhlab knapp 3 Wochen durch hatte. Auch wenn der Start für mich durch die Berichterstattung der vielen Fehler im Spiel etwas getrübt war, habe ich es definitiv nicht bereut direkt bei Release zu spielen. Einen Plotstopper hatte ich nicht. Ein Mal konnte ich optionale Charaktäre nicht ansprechen. Ansonsten nur kleinere Glitshes. Im nachhinein fällt mir schon auf, dass die offene Welt und Stadt nicht and GTA V herankommt. The Witcher 3 hat ein rundere aund ausgereiftere Geschichte erzählt. Auch waren die Nebenquest bei der The Witcher 3 abwechslungsreicher als in Cyberpunk. Das ist aber Kritik auch höchstem Niveau, denn die beiden Spiele sind das Beste, was in den letzten Jahren auf dem Markt gekommen ist. Wenn es einen DLC gibt oder "New Game Plus" kehre ich auf jeden Fall zurück nach Night City. Bis dahin hat Nvidia und AMD es auf jeden Fall verpasst mir eine neue Grafikkarte zu verkaufen, denn die brauche ich jetzt erstmal nicht mehr8 Punkte

-

Das Thema DSR wird immer mal - unter anderem von mir - in einigen Posts erwähnt. Es gibt hierzu im Forum aber noch keine Anleitung und ich finde, dass das Thema hier zu kurz kommt, gerade da viele eine 2080 oder stärker haben, jedoch nur ein 1920x1080px-Display. Deswegen diese Anleitung, auf die ich dann zukünftig bei Bedarf verlinken kann. Mittels DSR von Nvidia ist es möglich, Spiele in 2560x1440px oder 3840x2160px (oder auch anderen Auflösungen) zu spielen, obwohl das interne Display z.B. nur 1920x1080px unterstützt. Sobald ihr DSR aktiviert habt, könnt ihr diese Auflösungen in Spielen auswählen, so als hättet ihr ein Display, welches höhere Auflösungen unterstützt. Wie geht das? Nvidia Systemsteuerung öffnen „3D-Einstellungen verwalten“ ihr seid nun im Reiter "Globale Einstellungen". Dort wählt ihr bei „DSR-Faktoren“ 1,78x (2560x1440px), 2,25x (2880x1620px) sowie 4,00x (3840x2160px). Die anderen sind eigentlich uninteressant Darunter erscheint nun „DSR-Glättung“ welches auf 33% steht. Das sieht aber zu verwaschen aus. Wählt 20% aus. Dies ist vorallem für 2560x1440px wichtig, da es sonst zu grieselig ist. Bei 3840x2160px könntet ihr sogar 0% Smoothness nutzen, was dann am besten aussähe. Ihr könnt diesen Wert aber nicht für jeden Faktor konfigurieren, sondern nur global. Insofern sind 20% wegen 2560x1440px und auch 2880x1620px die beste Wahl Das wars. Jetzt könnt ihr euer Spiel starten und in den Spiel-Einstellungen taucht nun auch 2560x1440px, 2880x1620px und 3840x2160px auf. Einfach auswählen und das höhere Rendering genießen. Euer 1920x1080px Display bleibt natürlich technisch stets ein solches Display, die gerenderte Auflösung steigt jedoch, dies beschert euch einen Optik-Vorteil. Noch besser wäre es natürlich, wenn euer Display auch nativ die höhere Auflösung beherrschen würde (dann wäre es noch schärfer). Aber es lohnt sich trotzdem. Allgemeine Empfehlung: Wenn ihr grundsätzlich über genügend Leistung verfügt, und ihr nicht so viele fps braucht, wählt im Spiel 3840x2160px. Sofern ihr (neben 1920x1080px) nur diese Auflösung nutzt, könnt ihr wie oben schon angedeutet den Smoothness-Wert auf 0% stellen. Solltet ihr auch andere (Zwischen-)Auflösungen nutzen wollen, was sehr wahrscheinlich ist, so wählt wie gesagt 20% aus. Sofern ihr ein Laptop mit HDMI 2.0 (also keine Nvidia 30XX) habt und einen 120Hz-TV benutzt: Dadurch dass der TV kein DisplayPort 1.4 hat und euer HDMI Ausgang am Laptop nur HDMI 2.0 hat, könnt ihr 120 Hz nur bis 2560x1440px haben. Bei höheren Auflösungen seid ihr auf 60 Hz beschränkt. In diesem Fall empfehle ich keine höhere Auflösung als 2560x1440px zu nutzen, es sei denn euch macht 60 Hz und V-Sync nichts aus. Denn sonst kommt keine richtige Freude auf (meiner Ansicht nach), auch mit G-Sync nicht. In dem Fall aktiviert nur den Faktor 1,78x. 2560x1440px sind aber immerhin auch schon die 1,78 Fache Auflösung gegenüber 1920x1080... Sofern ihr ein Laptop mit HDM 2.1 habt und einen 120Hz-TV benutzt: Statt Faktor 1,78x (2560x1440px) könnt ihr nun auch 2880x1620px (Faktor 2,25x) benutzen und ihr habt trotzdem noch 120 Hz. Die Auflösung ist etwas höher und somit noch schärfer. Zudem lässt sie sich für das Display mathematisch gesehen besser umrechnen, was zu einer noch besseren Schärfe führt. Grundsätzlich sind die Faktoren 2,25x und 4,00x am besten, sie benötigen die wenigsten Filter. Gerade aber TVs beherrschen Upscaling sehr gut, hier werdet ihr zwischen 2560x1440px und 2880x1620px nur sehr wenige Unterschiede sehen. Bedenkt jedoch, dass die höhere Auflösung mehr Leistung benötigt. Sofern ihr ein Laptop (egal ob HDMI 2.0 oder HDMI 2.1) habt und einen 120 Hz oder höher Monitor benutzt: Hier gilt das Gleiche. Neben 2560x1440px könnt ihr dank DisplayPort 1.4 (schließt den Monitor also per Display Port an) auch 2880x1620px oder höher nutzen, ohne auf 60 Hz beschränkt zu sein. Sobald ihr eben einen 120Hz-TV benutzt, egal ob ihr auch schon einen externen Monitor nutzt oder nicht, muss klar sein, dass der TV kein Display-Port hat. Ein Laptop mit HDMI 2.0 (alle bis RTX 2080) macht dann nur Spaß (120 Hz!) am TV mit maximal 2560x1440px. (Beim 120 Hz-TV setze ich natürlich jetzt mal voraus, dass dieser bereits einen HDMI 2.1 Eingang hat, z.B. LG C9). Dann noch ein Hinweis: Egal ob ihr mit eurem internen Display spielt, oder mit dem Monitor (oder mit dem TV), nutzt immer die gleiche Auflösung. Sofern jedes Display die genutzte Einstellung/Auflösung unterstützt, bleibt diese erhalten. Sprich ihr müsst nur einmal die richtige Auflösung im Spiel auswählen, und schon bleibt sie für immer eingespeichert, egal mit welchem Display ihr spielt. -> das ist normalerweise nicht der Fall! Oder zumindest nicht bei jedem Spiel. Beispiel: Ihr zockt ein Spiel mit 1920x1080px an eurem Alienware-Display, also das vom Laptop. Dann schließt ihr ein Monitor oder TV an. Dort ist dann natürlich 1920x1080px auch ausgewählt. So wollt ihr wahrscheinlich an eurem 2560x1440px- oder 3840x2160px-Monitor (oder TV) aber nicht spielen, also erhöht ihr manuell in den Spiel-Einstellungen die Auflösung. Was passiert beim nächsten mal wenn ihr wieder am Alienware spielt? Richtig, dort wird dann wieder 1920x1080 gesetzt (weil eine höhere Auflösung vom internen Display ja nicht unterstützt wird) und beim nächsten mal Spielen am Monitor/TV müsst ihr die höhere Auflösung wieder manuell auswählen… nervig ohne Ende. Hier hilft euch DSR nun ungemein. Ihr spielt nun auch einfach am Alienware-Display bzw. eben überall mit 2560x1440px, 2880x1620px oder 3840x2160px, fertig. Welche Vorteile hat das Ganze also zusammengefasst? Optik: die Spiele sehen besser aus, für eine 2080 bietet sich in vielen Spielen 2560x1440px oder 2880x1620px an, damit hat man dann noch oft mindestens 60 fps. 3840x2160px solltet ihr nur in älteren oder nicht anfordernden Titeln auswählen, es sei denn ihr habt eine 3080 mit 150+ Watt oder unter 60 fps macht euch nichts aus (mir schon) Komfort: das Spiel merkt sich dauerhaft diese Auflösung. Wenn ihr wie schon gesagt ab und zu am internen Display spielt, und dann wieder am Monitor oder TV, müsst ihr bei vielen Spielen ständig wieder zwischen den verschiedenen Auflösungen wechseln (sofern ihr am Monitor oder TV eine höhere Auflösung verwenden wollt). Wenn ihr aber DSR aktiv habt, und bei allen Displays die gleiche Auflösung verwendet, bleibt diese dauerhaft eingespeichert und euch der ständige Wechsel der Auflösung in den Spiel-Settings erspart) Ihr könnt übrigens DSR aktiv haben, und wenn ihr den Monitor (oder TV) angeschlossen habt, nicht. Sprich die Nvidia Systemsteuerung unterscheidet hier je nach Display. Ihr könnt DSR natürlich auch dafür benutzen, um eurem schon höher aufgelösten 2560x1440px-Monitor 5120x2880px oder eurem 3840x2160px-Monitor 7680x4320px beizubringen… das kostet dann aber richtig Leistung... Welche Nachteile hat das Ganze? Ihr braucht natürlich mehr Leistung, habt also weniger fps. DSR verhält sich leistungstechnisch fast exakt genau so, wie als wenn ihr nativ eine höhere Auflösung hättet. Bei Spielen, die ihr konstant mit über 100 (oder 200) fps spielen wollt, z.B. Shooter wie CoD Modern Warfare oder Coldwar, empfiehlt es sich weiterhin die 1920x1080px-Auflösung zu nutzen (es sei denn ihr habt eine 3080 mit 150+ Watt, dann geht dort evtl. auch 2560x1440px). Aber für viele Spiele, die ihr z.B. in Third-Person mit Controller spielt, sind - zumindest nach meinem Geschmack - ca. 60-90 fps und 2560x1440px, 2880x1620px oder 3840x2160px die deutlich bessere Wahl als ca. 120 fps bei 1920x1080px. PS: Ich habe in dieser Anleitung bewusst keine Wörter wie QHD, 1440p, UHD, 4k usw. benutzt, weil manchen nicht jedes bekannt sein dürfte. Mit der stets ausgeschriebenen Auflösung, z.B. 2560x1440px, kann aber jeder was anfangen.7 Punkte

-

Ich würde dir als erstes mal empfehlen, zu versuchen dich klar auszudrücken. Entschuldige das ich es so sage, aber bei deinem Geschreibsel bekommt man echt Augenkrebs. Wenn du der Meinung bist die Lüfter funktionieren nicht, dann starte dein Notebook und drücke dabei F12. Im folgenden Menü wählst du Diagnostics aus. Da kann man die Lüfter einzeln testen.6 Punkte

-

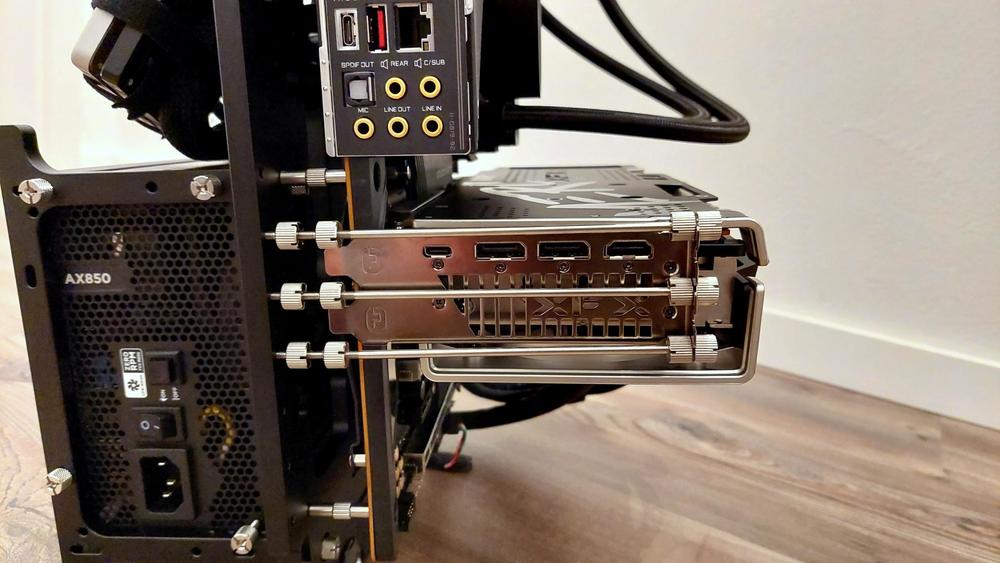

Zum einen mit den drei Streben links, die erstaunlicher mehr Halt geben als gedacht und zum anderem mit einem selbst angefertigtem Anti-Sag-Mount. Hab halt drei Streben genommen, um die maximale Stabilität zu erreichen. Ich wusste aber schon vor dem Kauf, dass eine Lösung gegen GPU-Sag bei diesem "Gehäuse" definitiv ein Problem werden wird. Insbesondere bei der langen und schweren Karte, die ich habe. Letztendlich dachte ich mir, dass mir schon eine passende Lösung einfallen wird, wenn ich das Case zu Hause habe. Für den Anti-Sag-Mount habe ich dann ein 12mm dickes Aluminiumrohr genommen, es auf den passenden Winkel gebogen, ein Gewinde oben und unten reingeschnitten und schwarz lackiert. Das Teil ist so stabil, das hält die GPU mit Leichtigkeit alleine. Bin jedenfalls sehr zufrieden damit. Auch Standfüße gegen das nach vorne Kippen musste ich mir anfertigen. Das war jetzt aber weniger ein Problem. Hab jetzt die Tage noch ein wenig Beleuchtung montiert und bin soweit jetzt erstmal fertig. Bin sehr zufrieden mit dem Gehäuse. Ist einfach mal was anderes und nimmt nur sehr wenig Platz ein. Leise ist es auch, da kaum Lüfter verbaut sind.6 Punkte

-

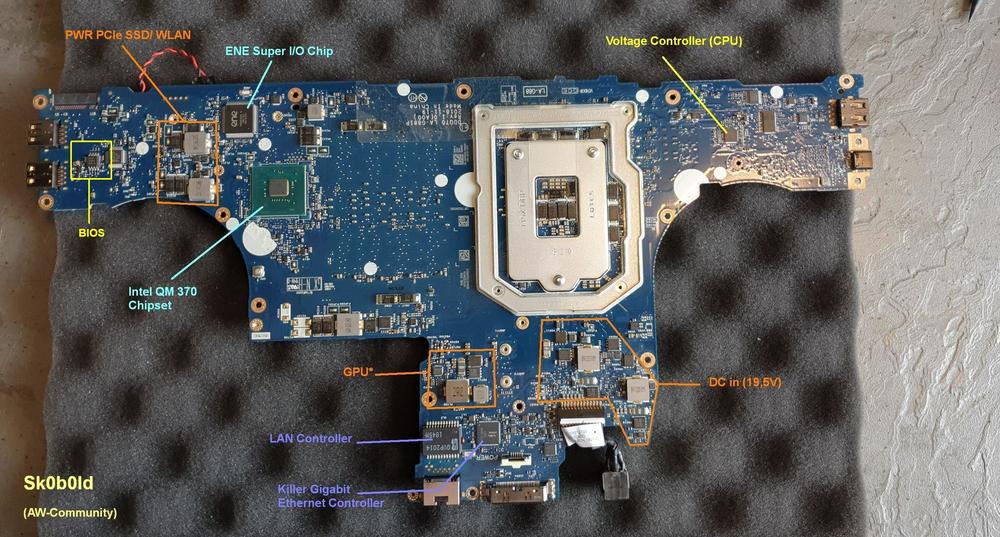

Ich gehe mal davon aus, dass du nichts "gelöscht", sondern einfach Secure Boot von enabled auf disabled gestellt hast. Korrigiere mich da bitte, falls ich falsch liege. Wäre mir aber neu, wenn man da einfach irgendwelche Einträge löschen kann. Ansonsten sehe ich da kein Problem, dass du irgendwelche Settings dort angepasst hast. Dafür ist das BIOS schließlich auch da. Zunächst mal was Allgemeines zu der ganzen BIOS-Geschichte und den vielen Lösungsansätzen. Es hilft ungemein, wenn man sich einmal vor Augen hält, was das BIOS eigentlich macht, wie es arbeitet und welche Funktionen es implementiert hat. Hört sich möglicherweise etwas komisch an, erklärt aber das aktuelle Verhalten und die gescheiterten Lösungsansätze bislang, auch wenn man jeden einzelnen Ansatz an der Stelle löblich erwähnen muss, denn so ein Engagement zur Lösungsfindung ist ja auch nicht selbstverständlich. Jedenfalls, wenn man den Lappy/ Rechner startet, beginnt das BIOS-Programm mit dem Power On Self Test (POST). Dies ist eine vordefinierte Reihenfolge, wo verschiedene Hardware gecheckt wird. Vereinfacht gesagt, BIOS: "CPU bist du da?" CPU: "jo, bin da." BIOS: "RAM, bist du da?" RAM: "jo, bin da." usw. In der Realität werden natürlich weitaus mehr Daten ausgetauscht, aber die Funktionsweise sollte verständlich sein. Viele werden das von euch auch schon lange kennen, aber ich werde auf diesen Punkt immer wieder zurückkommen, deshalb spreche ich es jetzt an. Man muss immer Hinterkopf behalten, dass viele Funktionen wie das Boot- oder Recovery-Menü eine Funktion eines funktionierenden BIOS ist. Ist das BIOS aber beschädigt, lassen auch diese Funktionen normalerweise nicht mehr starten. Nach jetzigem Wissensstand, schätze ich, dass das BIOS einfach beschädigt ist. Warum das BIOS aber beschädigt wurde, ist schwer zu sagen. Vielleicht ist ein Bug im BIOS selbst, so dass eine ganz bestimmte Einstellung dazu führt, dass das BIOS fehlerhaft gespeichert wird. Vielleicht gab's beim Speichern selbst irgendwie ein Problem. Lag ein Undervolting-Offset zufällig vor? Wurde beim Speichern bzw. beim erneuten Booten der USB-Stick oder andere Hardware währenddessen entfernt (Wackelkontakt oder ähnliches)? Speziell diese UV-Geschichte ist gar nicht so neu. Viele betreiben ihr Notebook mit einem UV-Offset, vergessen aber schnell, dass man bei einem BIOS-Update das UV-Offset vorher herausnehmen sollte. Wenn dann mitten im BIOS-Update (oder beim Speichern von Settings) die CPU abschmiert, ist das BIOS meist unbrauchbar danach. Auch Schadsoftware auf dem USB-Stick könnte eine Ursache sein. Halte ich zwar für sehr gering, aber ausschließen will ich es auch nicht. Nicht jede Schadsoftware ist für Windows gemacht und damit im OS sichtbar. Ist halt ein bisschen verdächtig, dass es ausgerechnet nach dem Ausstellen von Secure Boot zu dem Problem gekommen ist. Dann die Sache mit den Peep-Codes. Das Gedudel anfangs ist der Hinweis, dass ein Boot-Fehler vorliegt. Dann piept er 3x, dann 2x und am Ende 1x und anschließend geht die Schleife von vorne los. In deinem Fall gehe ich davon aus, dass das BIOS beschädigt ist und er (das BIOS-Programm) den POST nicht vernünftig abschließen bzw. starten kann. Allein die Tatsache, dass der 1x Beep-Code (BIOS ROM-Fehler) da ist, erklärt wahrscheinlich den 2x- und 3x Beep-Code. Warum der 3x-Beep-Code vor dem 1x- und 2x-Beep-Code kommt, kann ich nur spekulieren (wahrscheinlich Reihenfolge des Speicherns und Ausgeben unterschiedlich). Demnach gehe ich davon aus, dass das fehlerhafte BIOS-Programm gar nicht PCH und RAM abcheckt und entsprechend auch keine Antwort erhält, wodurch die Fehlercodes automatisch hinterlegt werden. Wie gesagt, dass ist nur ein Erklärungsversuch meinerseits, der aber nicht zwingend stimmen muss. Jedoch macht das für mich am meisten Sinn, weil ich davon ausgehe, dass RAM und PCH völlig in Ordnung ist. Auch den Lösungsansatz mit der SSD halt ich für wenig erfolgversprechend. Das BIOS interessiert ein bootbares Medium erst, wenn alles ordnungsgemäß durchgelaufen ist. Da aber das BIOS schon vorher rumzickt, wird die SSD zu dem Zeitpunkt noch gar nichts zu melden haben. Den Lösungsansatz mit dem RAM wird wahrscheinlich auch nicht zum Erfolg führen, auch wenn ich diesen Lösungsansatz gut nachvollziehen kann. Ich habe diesen Fehler bei einem Alienware-Gerät mal provoziert. Der Fehler kommt meist zustande, wenn beim POST die RAM-Daten (Timings, Sub-Timings, Voltage) aus dem SPD-Speicher fehlerhaft gespeichert und nicht auf dem RAM angewendet werden können. In meinem Fall hat nur noch ein CMOS-Reset geholfen, damit das BIOS die RAM-Daten aus dem SPD-Speicher neu einliest. Die genannten Punkte sind keineswegs falsch und werden zum Teil auch so im Service-Manual erwähnt. Tatsächlich ist es in der Realität aber etwas anders. Die Stromkreise bei dem BIOS-Chip laufen in der Regel getrennt voneinander. Mal ein anderes Beispiel in dem Zusammenhang: Viele Desktop-Mainboards, ab einer bestimmten Preisklasse (meist OC-Feature) haben einen Clear CMOS-Button (viele min. ein Jumper). Dieser Knopf unterbricht einfach nur die Stromzufuhr von der CMOS-Batterie zum BIOS-Chip. Hier reicht schon eine Unterbrechung von weniger als eine Sekunde aus, um den BIOS-Chip komplett auf Default zu setzen. Wenn man RAM-OC macht, ist das Feature (oder ReTry) echt Gold wert. Im Beispiel Laptop und Service-Manual, wird aber meist eine Vorgehensweise empfohlen, die auf nahezu alle Notebook-Typen (idiotensicher) übertragbar ist. Deshalb Powerdrain, 5-15 Minuten CMOS-Batterie abklemmen, Akku raus usw. Wenn ich richtig informiert bin, hat das schon fast historische Hintergründe, wo in den damaligen Notebooks Kondensatoren und andere Elektrokomponenten verbaut wurden, die deutlich länger den Strom gespeichert haben und auch die Stromkreise und BIOS-Chips waren anders. Da an der Vorgehensweise aber nichts falsch ist, hat's man immer dabei belassen. Ich will damit nur sagen, dass modarim an sich schon alles richtig gemacht und es keinen Unterschied mehr macht, ob er die CMOS-Batterie 5 Minuten oder eine Stunde abklemmt. Wenn das Notebook einmal vollständig (inkl. CMOS) stromlos war, war das schon richtig so. Ja, weil die Recovery-Funktion, eine Funktion eines funktionierenden BIOS ist. Ich will natürlich nichts ausschließen und keinen Lösungsversuch ungetestet lassen, aber ich würde meine Erwartungen nicht zu hoch setzen. Das Area 51m-Mainboard hat mehrere BIOS-Chips. Mit etwas Glück läuft die Recovery-Funktion vielleicht über den anderen Chip. In den allermeisten Fällen, in einem Preisbereich, wo es sich aus meiner Sicht nicht mehr lohnt, derart viel Geld in ein "altes" Gerät zu investieren. Meist bist du über 1.000€ los und das für irgendeinen gebrauchten Kram und wenn das Board am Ende immer noch nicht läuft, verlierst du noch mal Geld. Für's gleiche Geld (+ das, was für das Area 51m noch bekommst) kannst du auf ebay KA schon ein fast gleichwertiges, funktionierendes Gerät holen. Vielleicht sogar schon besser. Ich gehe jetzt nicht auf jeden Lösungsversuch ein, verweise aber nochmals auf den am Anfang genannten Punkt mit der Funktionsweise des BIOS. F12 mit Bootloader-Menü wurde bereits bestätigt, dass es nicht geht. Demnach braucht er auch kein DVD-Laufwerk oder sonst was anzuschließen. Diese Geschichte mit der CD/ DVD ist sowieso nur im Legacy-Mode vordefiniert, wo man kein Bootmanager zur Verfügung hat, sondern eine feste Prio bzw. die man selbst festlegt. Mit UEFI hat man auch zeitlich den Bootmanger aktiviert, der automatisch nach'm MBR sucht. AHCI/ RAID on ist ein Punkt ja, aber soweit kommt erst gar nicht. Dieser Punkt ist erst interessant, wenn der POST durchgelaufen ist und es darum geht, wie die bootbaren Laufwerke angesprochen werden sollen. Externe Gerät werden ziemlich funktionieren (drehen und leuchten), da auch andere (Strom-)Komponenten wie Tastaturbeleuchtung, Lüfter, Lautsprecher etc. funktionieren. Teilweise läuft der 5V-Kreislauf ohne Logik und wird direkt ausgegeben. So wie auch Charge-USB usw. Ehrlich gesagt, sehe auch hier die größten Erfolgschancen. Das Gerät, welches man dafür braucht, ist -DAS- beispielsweise. Ich sag aber gleich vorab, dass ich damit keine Erfahrung habe. Ich hab es nur zufällig einmal im Einsatz gesehen. Wie so oft im Leben, muss man sich das mit Youtube und Co. wahrscheinlich selbst beibringen oder kennt jemanden zufällig. Falls alle Stricke reißen, hab ich vielleicht jemanden da (weiß nicht, ob er das macht. Muss ich selbst fragen). Der BIOS-Chip ist in der Regel ein achtbeinige Winbond-Chip (Vergleichsbild). Ich habe auch Bilder vom Area 51m R1 Mainboard da (im VRM-Thread), welcher aber der Main-BIOS Chip ist, weiß ich nicht exakt. Hier mal das Mainboard von beiden Seiten: Auf den ersten Blick, würde ich die beiden Chips auf der linken Seite vermuten, tendenziell den auf der Rückseite als Main. Oberhalb und rechts vom RAM finden sich noch zwei weitere Winbond-Chips, die etwas kleiner sind. Glaube zwar nicht, dass die mit dem BIOS was zu tun haben, aber völlig ungeachtet würde ich sie auch nicht lassen. Der oberhalb vom RAM wird ziemlich sicher für RAM-Profile sein. Anhand der CMOS Batterie und des Pin-Layout des BIOS-Chips, sollte man relativ leicht rausfinden können, welcher der BIOS-Chip ist.6 Punkte

-

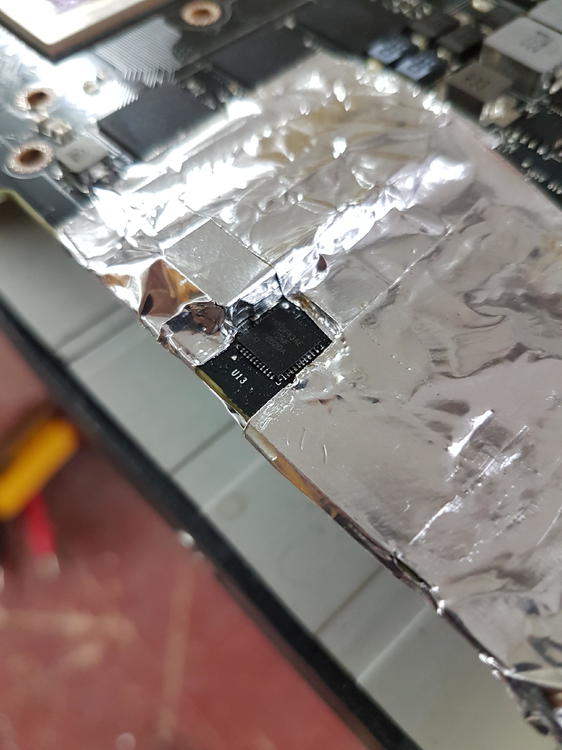

Die Titan lebt wieder! Es war tatsächlich ein Kurzschluss im 8Pin Stecker. Ohne Hilfe konnte ich das nur bis zu den unteren vier Mosfets nachverfolgen und wusste dann nicht weiter. Mehr durch Zufall habe ich dann ein Video gefunden, in dem jemand einen Mosfet auf einer EVGA 980 TI tauscht. Die vom PCB ziemlich identisch ist mit meiner Titan X. Das Video war sehr hilfreich (wenn auch sehr verwackelt), da dort erklärt wird, wie man herausfinden kann, welcher Mosfet schuld ist. Nach dem ich den Mosfet ausgelötet hatte, war der Kurzschluss schonmal weg. Den neuen Mosfet habe ich bei Digikey bestellt und gestern eingelötet. Nachdem ich nochmal überprüft habe, dass ich keinen Kurzschluss verursacht habe konnte ich die Karte testen. Sofort kam ein Bild - jedoch ging der PC aus, sobald ich einen Benchmark gestartet habe. Die Phase an der ich gearbeitet hab startete nicht. Ein paar der winzigen Kontakte rings um den Mosfet hatten sich beim Löten nicht richtig verbunden. Ich habe den Lötprozess bestimmt 20 Mal wiederholt, bis heute endlich die Karte stabil durch den Benchmark lief. Eine längere Zeit im Benchmark und eine kleine Runde Red Dead Redemption 2 später läuft die Karte immer noch ohne Probleme. Hier kann man beim untersten Mosfet Lötzinn an der Seite sehen. Das ist ein Indiz dafür, dass das der defekte Baustein ist. Durch das erhitzen beim Kurzschluss ist das Lot flüssig geworden und an der Seite ausgetreten. (Erklärung aus dem Video) Hier habe ich den Bereich um den defekten Mosfet abgeklebt, um keine anderen Teile mit abzulöten. Bei meinem Mosfet konnte man auch wie im Video den Kurzschluss zwischen zwei der großen Pads auf der Unterseite messen. Und hier haben wir den neuen Mosfet.6 Punkte

-

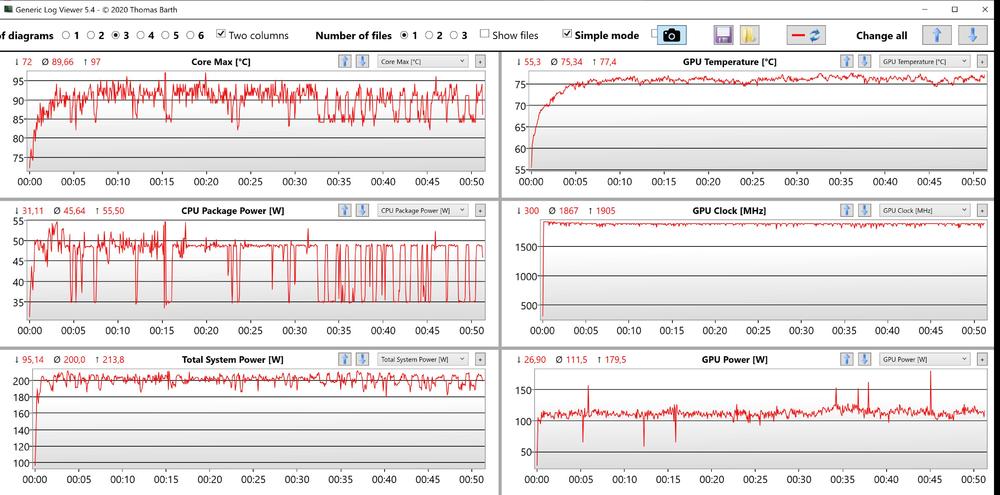

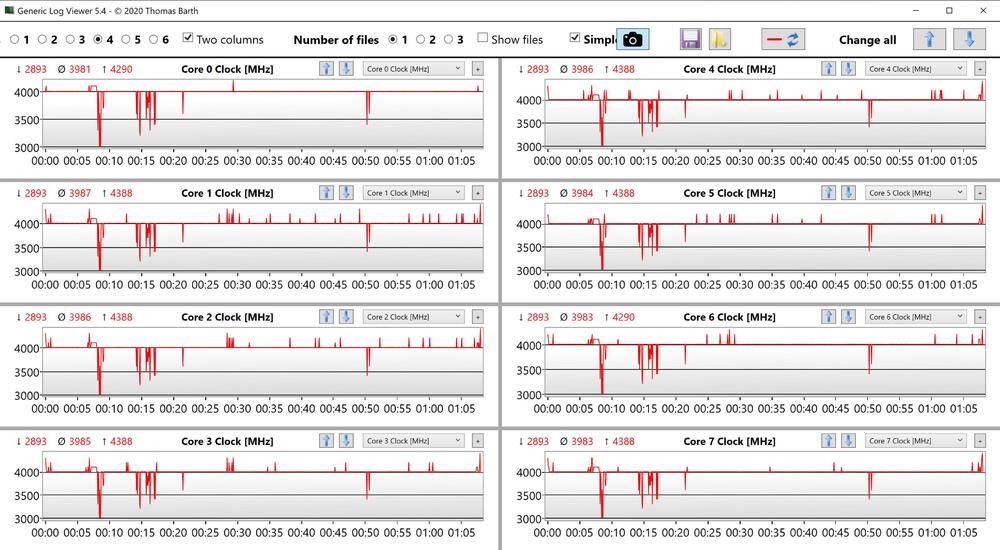

So, habe mein m17 R4 ja bekommen und es die letzten wenigen Stunden getestet. Soviel vorab: ich hab keinerlei Motivation, das Ding nochmal anzuschalten. Leider muss ich es ja noch zurücksetzen, werde mich dann jedoch in einem anderen Raum aufhalten... Außerdem werde ich euch noch den Gefallen tun, und testen, was ein U3 Kühler (im stillen Lüfter-Profil) bringt. Hierfür werde ich wohl Cyberpunk 2077 testen (CPU- und GPU-anfordernd) und entsprechend vergleichen. Ich poste das Ergebnis dann im U3-Kühler-Thread. Lüfter: Grauenhaft. Wie erwartet viel zu hochfrequent. Ungefähr so wie beim Razer Blade 17. Aber selbst einige von euch finden das ja nicht in Ordnung, ich bin also - zumindest an der Stelle - nicht überempfindlich. Das ist auch kein Problem einzelner Geräte, die Lüfter hören sich halt so an. Für mich fast typisch für so flache Notebook. Beim Razer z.B. hab ich zwei oder drei Stück getestet, um ein Montagsmodell auszuschließen. Selbst mit eigener Lüfter-Steuerung bei z.B. maximalen 2.000 RPM wären die Lüfter immernoch viel zu schlecht. Man hört ja bereits so schon, dass das unangenehme Geräusch auch bei niedrigen Drehzahlen vorhanden ist. Und ganz hohe Drehzahlen kommen für mich grundsätzlich nicht infrage, auch wenn dort nur ein Rauschen vorhanden wäre (laut ist es dann trotzdem). Und die Temperaturen sind bereits schon zu hoch - für eine Reduktion der Lüfter-Drehzahl ist eh kein Spielraum vorhanden. Leistung & Temperatur Eigentlich wollte ich mehrere Spiele testen, aber ein fünfminütiger Lauf von Cyberpunk 2077 in 1920x1080px hat mir schon verraten, dass die CPU sehr heiß läuft und auch zum Throtteln beginnt (mit -100mv). Mal zum Vergleich: m17 R4: Die CPU throttelt bereits nach kurzem auf 2,9-3,0 GHz bei allen 8 Kernen, da nach kurzer Zeit eben 100 Grad erreicht werden. Die Lüfter laufen hierbei 2500/2300 RPM (Lüfter-Profil Still). Es liegen ca. 25W an. Im Lüfter-Profil "Ausglichen" (schon ordentlich laut) steigt der Verbrauch auf über 50W, dann liegen 3,8-3,9 GHz an. Wie also schon von mir vermutet, und auch beim R2 gewesen, wird die CPU im Lüfter-Profil Still ordentlich kastriert. Die GPU läuft aufgrund eines 79 Grad Temperatur-Limits ebenfalls mit 100-200 MHz weniger Takt (geht bis 1.515 MHz runter) als im Profil Ausgeglichen. Die CPU-Temperatur im Profil Ausgeglichen und 3,8-3,9 GHz liegt bei 90-95 Grad. Ich hatte ihn etwas hochgebockt. Im Lüfter-Profil Still ist die Temperatur nach eingesetztem Throttling auf nur 2,9-3,0 GHz / 25W etwas geringer. Area 51m R1: Die CPU läuft ohne Throttling auf 4,7 GHz (bis zu 62% mehr Takt) auf allen 8 Kernen, Temperatur pendelt sich hier auch bei 90-95 Grad ein, aber mit eigener Lüfter-Steuerung bzw. sehr leisen 2000/2000 RPM (!). Bei dem Standard-Lüfter-Profil Still, also ohne Mods, wäre die Temperatur natürlich geringer (8X Grad). Und wenn ich die CPU auf 8x4,2 GHz (analog zum m17 R4) runtertakten würde, würden wir wohl von 6X-7X Grad sprechen. Das sind dann 20-30 Grad Unterschied. Der Verbrauch bei 4,7 GHz liegt bei um die 100 Watt. Wie beim m17 R4 liegen auch beim Area 51m -100mv an (eigentlich sogar nur -75mv). Wichtig: die Tests liefen nur wenige Minuten. Bei stundenlangen Spielen wird das Throttling einsetzen bzw. sich verschärfen. Beim Area 51m hat man etwas Spielraum, beim m17 R4 eben nicht. Ja, Cyberpunk 2077 ist für die CPU wirklich ein Hardcore-Test, die meisten Spiele benötigen weniger CPU-Last/Verbrauch. Aber solche Spiele müssen ja auch sein. Ja, das Area 51m R1 ist dicker und schwerer bzw. ein Desktop-Replacement, der Unterschied ist aber dennoch größer als gedacht. Ja, in lauteren Lüfter-Profilen ist ja das Throttling beim m17 R4 weniger bis gar nicht mehr der Fall, aber selbst das stille Lüfter-Profil ist eben auch schon fürchterlich piepsig und laut. Und das die 3080 gut ist und entsprechend schneller als eine 2080 ist, braucht man denke ich nicht zu vertiefen. Wäre ja auch schlimm wenn nicht. Habe ich jetzt gar nicht erst getestet bzw. genauer miteinander verglichen. Entsprechende Benchmark-Tests haben ja schon andere gemacht. In einigen Spielen wird man mit dem m17 R4 durch die deutlich geringere CPU-Leistung dennoch mehr fps-drops und weniger min-fps als mit dem Area 51m R1 mit 2080 haben. Die GPU-Leistung alleine ist in vielen und immer mehr Spielen nicht entscheidend, das Zusammenspiel von CPU und GPU ist wichtig. Konkretes Beispiel: in Cyberpunk 2077 hab ich in der belebten Stadt mit dem Area 51m/2080 etwas mehr fps als mit dem m17 R4/3080. 😉 Ich wollte eigentlich aufwendigere Vergleichstests machen, aber bitte erwartet das nicht mehr von mir, ich halte es keine weiteren 5 Minuten mehr vor dem Teil aus, auch nicht im Profil Still oder im Idle, die Lüfter sind einfach auf jeder Stufe grauenhaft. Mein Fazit für das m17 R4: überraschend schwer (Gewicht), hatte ich nicht erwartet egal auf welcher Stufe die Lüfter laufen, sie sind immer viel zu hochfrequent selbst wenn die Charakteristik der Lüfter auf niedriger Drehzahl gut wäre: Lüfter leiser machen mit eigener Lüfter-Steuerung ist aufgrund der hohen Temperaturen nicht drinnen CPU-Leistung relativ schwach fürs Jahr 2021, und starkes Throttling ist im stillen Lüfter-Profil in vielen Situationen normal (2,9-3 GHz bei Cyberpunk 2077). wen ein dickeres/schwereres Area 51m (vielleicht bald R3 mit 3080) nicht stört, der kriegt hier was ganz anderes geboten. Das m17 R4 macht vieles deutlich schlechter, nur um ca. 34% dünner und ca. 36% leichter als ein Area 51m zu sein. Für mich persönlich einfach ein schlechter Tausch beziehungsweise ein schlechtes Verhältnis Dann noch meine Meinung zum Abkleben der Lüfter: Schön, wenn es was bringt. Dann auf jeden Fall machen. Ich glaube aber nicht, dass man damit den Großteil des hochfrequenten Geräusches wegbekommt. Etwas angenehmer glaube ich aber sofort. Außerdem braucht man für einigermaßen CPU-Leistung dann immernoch ein schnelleres Lüfter-Profil als Still. Es ist also für einige und vorallem für mich dann dennoch allgemein viel zu laut. Dann noch meine Meinung zur Aussage, dass das Area 51m zwei Netzteile braucht: Mit einem Mod braucht es nur noch ein Netzteil. Und für 30 Euro oder so kann man sich die beiden power jacks (dc in) als Ersatzteil hinlegen und wieder bei Verkauf zurückrüsten. Bei Reparatur / Techniker-Einsatz braucht man das gar nicht mal machen (ich spreche aus Erfahrung). Jetzt sagt ihr vielleicht, dass das ja ein Eingriff ist, den kaum jemand machen will: ja, aber ein LM-Repaste ist meiner Meinung nach ein vergleichbarer Eingriff. Dort könnte man sogar langfristig Spuren hinterlassen, bei dem Netzteil-Mod nicht.6 Punkte

-

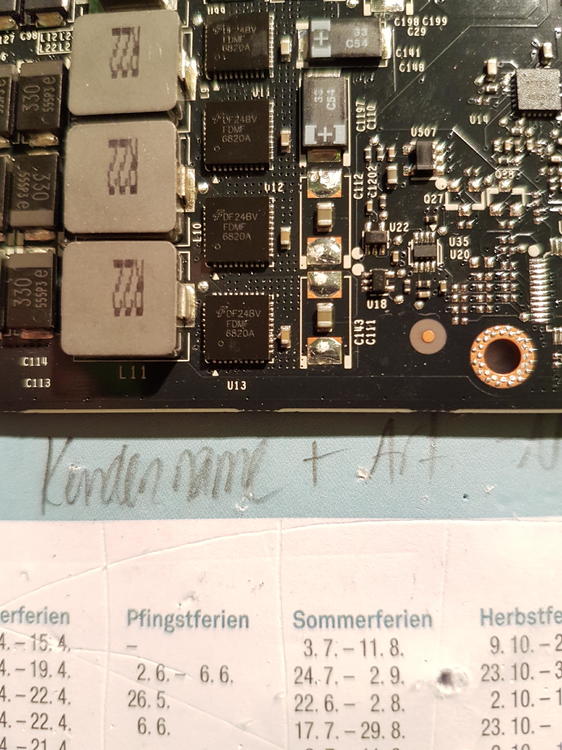

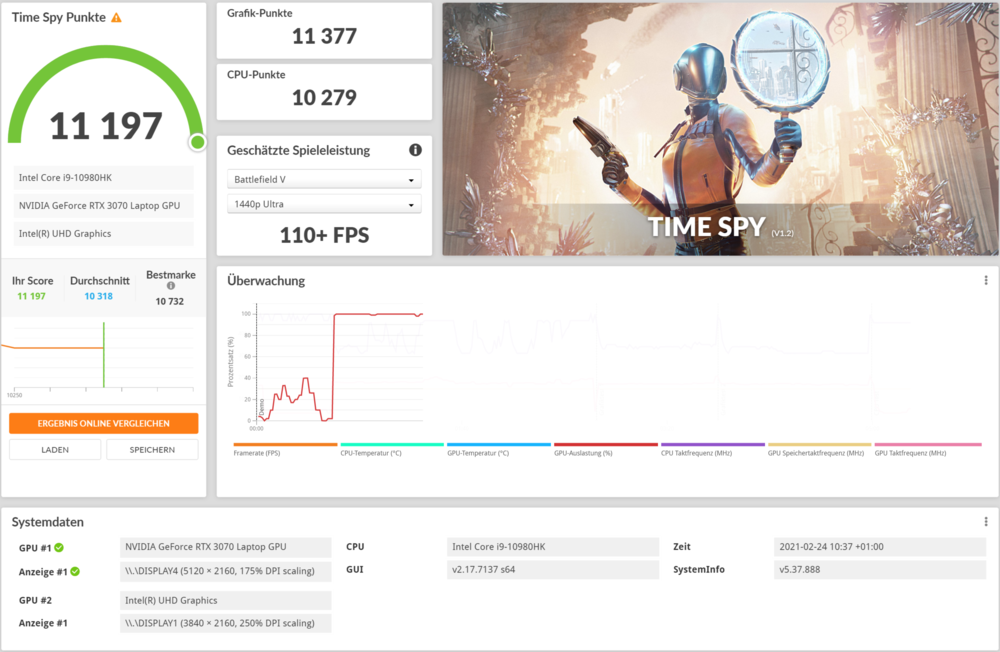

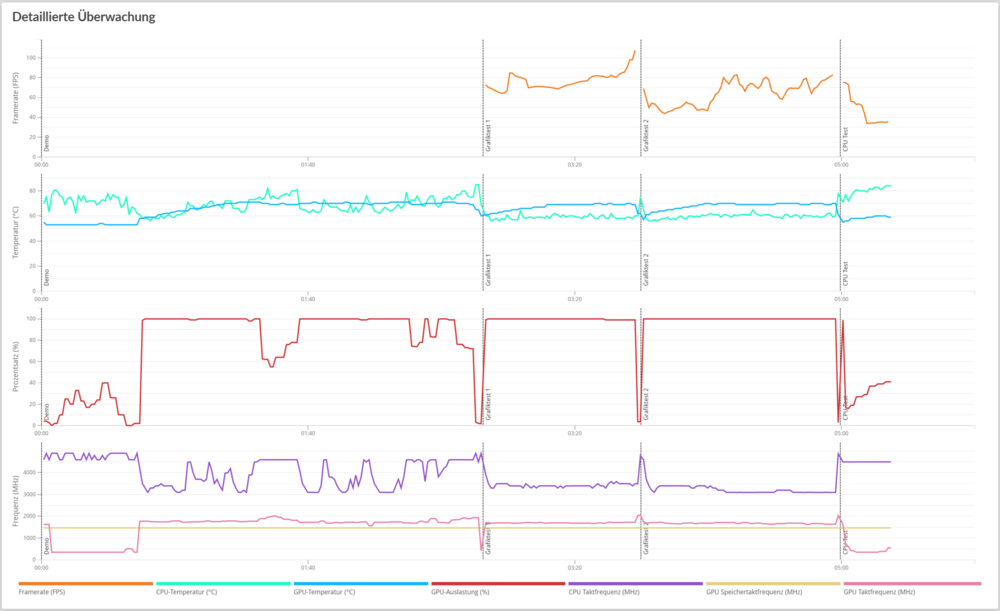

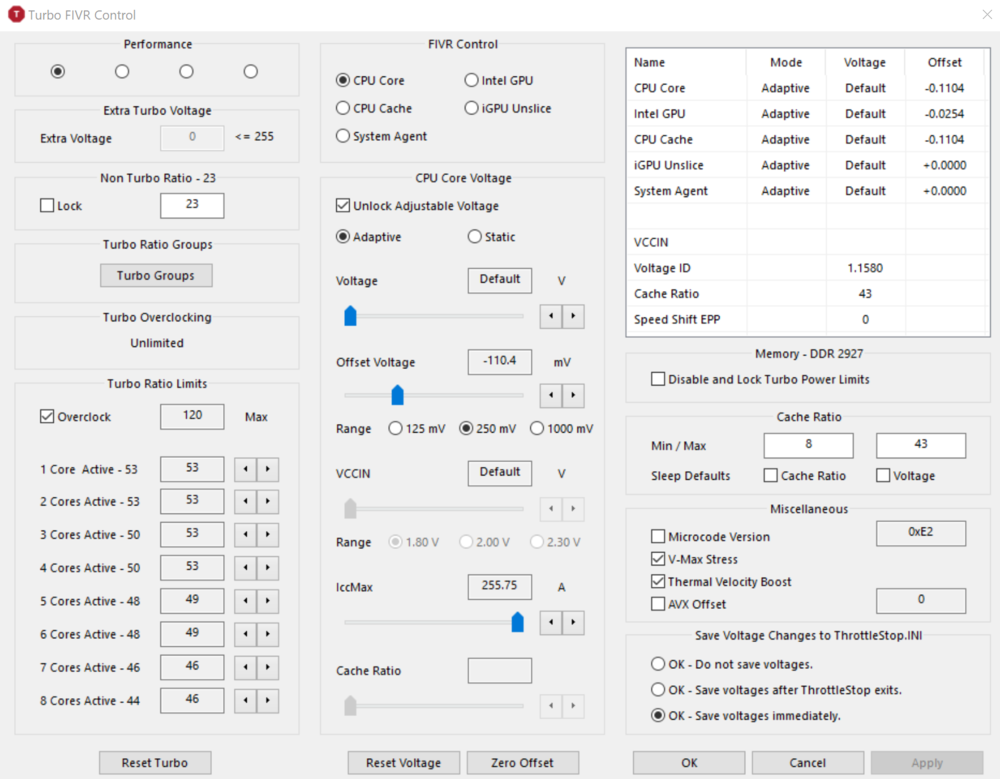

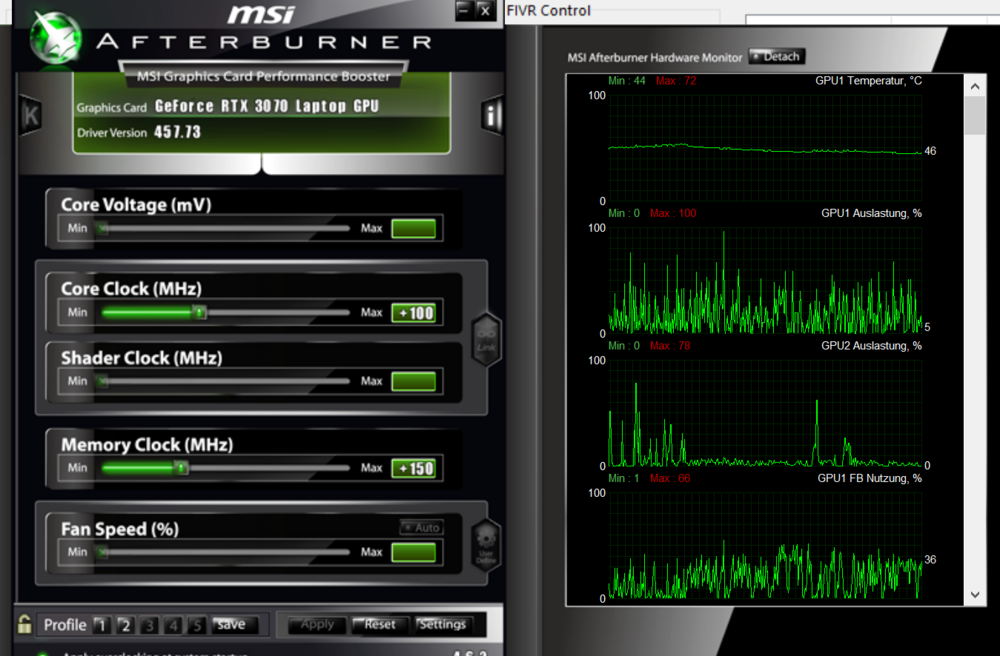

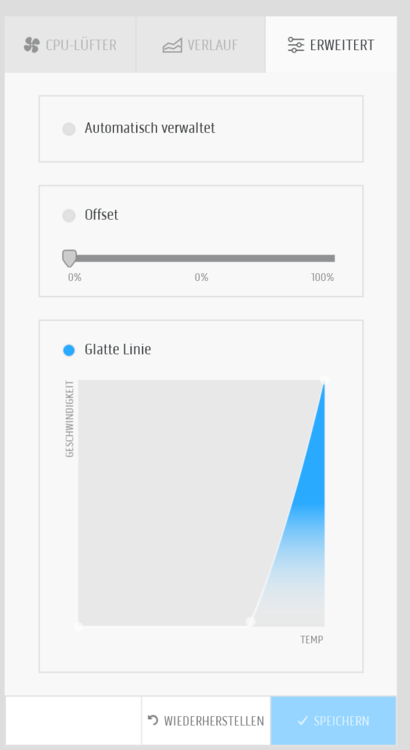

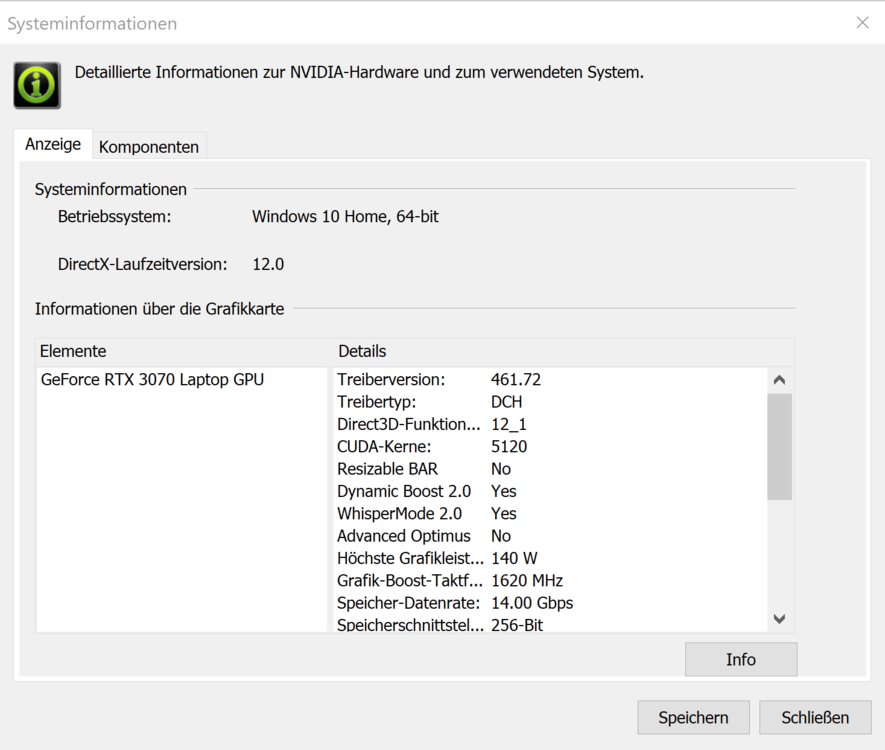

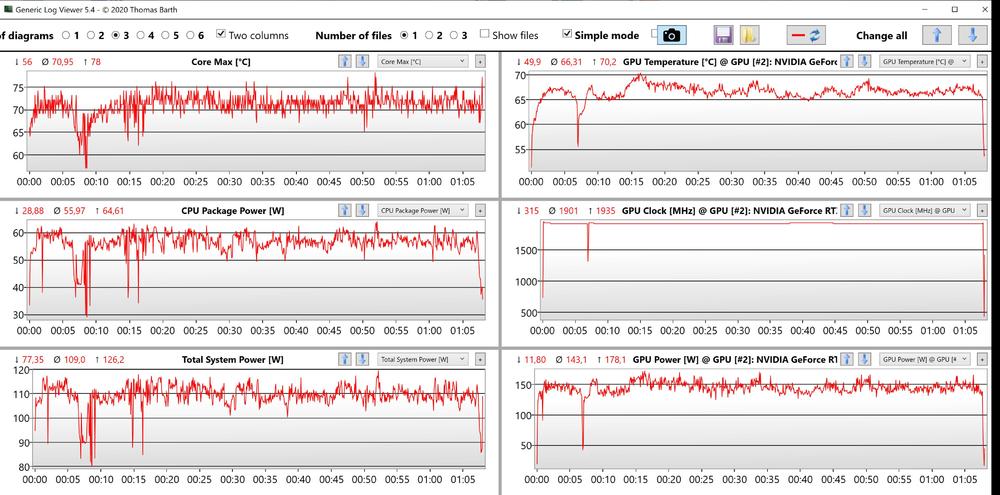

Servus aus dem Allgäu, da mir da Forum und ihr als Mitglieder bisher viel wichtige Infos geschenkt habt wollte ich jetzt meine Erfahrung und Werte ebenfalls mitteilen. Vieleicht hilft es jemandem bei der Entscheidung ob m17 oder nicht. Meine Werte als Bilder: mit der Konfig i9 und RTX 3070 bekommt man das 240 Watt Netzteil geliefert der i9, wie im geteilten Benchmark, lief mit UV und veränderten Turbo Ratio Limits in Throttlestop die GPU wurde mit +100 Core und +200 Memory im MSI Afterburner betrieben die Stabilität des Systems wurde mit AIDA64 Stresstest und 3dMark Dauertest gestern getestet und es lief ohne Probleme es wurden die Standardtreiber von Dell vom Auslieferungszustand verwendet Für die Lüfter nutze ich die "Glatte Linie" Funktion im ACC ab 70 bis 100 Grad Die GPU wird aber nur zum Spielen mit OC betrieben, im Alltag läuft sie mit den Standardwerten das Laptop steht auf einer IcyBox Halterung und hängt an einem VESA400 Arm in der Luft Meine Erfahrung: Ich hatte bisher ein Surface Book 2 15 und der Lüfter war fast genau so laut nach meinem Empfinden die pfeifenden, hundpfeife-ähnlichen, Lüftergeräusche gibt es bei mir definitiv nicht Die Tastatur ist super, ich mag sie. Sie ist weicher im Druck wie eine Logi MX Keys oder der MS Surface Tastatur die Verarbeitung ist einem Premiumprodukt angemessen im Idle ist der Lüfter kaum wahrzunehmen oder ganz aus das 4k Display ist super in der Bildqualität UV ist beim i9 nötig wenn man mehr Performance haben will Wieso i9 und 3070? Es wird, neben gelegentlichem Spielen, viel für Content Creation für Fotos und Texte genutzt sowie auch öfters bewegt. Daher sind kleineres Netzteil, 17 Zoll und weniger Grafikpower ein guter Mittelweg gewesen. Falls jemand noch mehr Werte braucht oder was wissen will einfach Fragen. Ich melde mich dann bei euch.6 Punkte

-

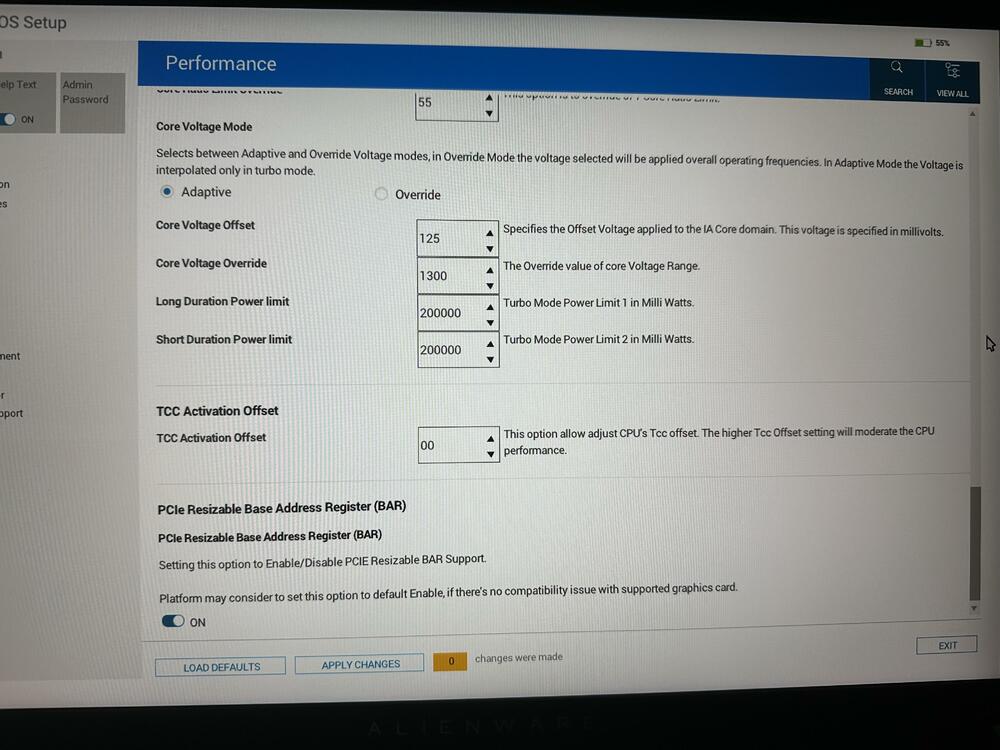

So sieht das unter performance im BIOS bei mir aus Hier noch mein Score mit den Settings von oben und im Overdrive Modus (AWCC). Bitte beachte aber, das ich komplett auf richtiges Liquid Metal gewechselt habe auf CPU und GPU. Hier noch der Score mit dem Performance/Leistung Modus im AWCC: Hier noch ein TS mit zusätzlich 250/1000Mhz OC auf GPU:5 Punkte

-

Das habe ich nicht probiert, ich musste irgendwann mal meine custom Settings laden und dann habe ich OC wieder aktiviert und den UV eingestellt. Bisher läuft das m18 astrein und am stärksten von allen von mir getesteten RTX4000er Notebooks. Ich weiß nicht ob es an Alienware liegt, aber hier steht Gaming im Fokus und das merkt man. Es funktioniert einfach Repaste kann sicherlich noch mehr rausholen, aber nicht zwingend notwendig. Sehr positiv überrascht bin ich tatsächlich vom Sound und von den Lüftern. Wenn ich mir was wünschen dürfte dann wäre es die Displayqualität aus dem Blade 16 und das Farbdesign vom X17/Area51m Ansonsten alles Top 👍🏻5 Punkte

-

Wenn du den nach Deutschland bringst wird Einfuhrumsatzsteuer fällig. Ich glaube kaum das sich das dann rechnet wenn noch mal 19% drauf kommen. ,,Überschreitet eine Ware die Freigrenze, etwa ein Notebook für 850 Euro, musst Du 850 Euro verzollen. Die Einfuhrabgaben sind auf den Gesamtwert der Ware zu bezahlen und nicht nur auf den Anteil, der die Freigrenze übersteigt.,, https://www.finanztip.de/einfuhrzoll/ Klar könnte man behaupten das man das Ding vor der Reise gekauft hat aber erkläre dann mal die QWERTY Tastatur. Doof sind die ja auch nicht und: ,,Befinden sich nach Abzug des Freibetrags Waren für mehr als 700 Euro im Gepäck und werten die Behörden das Verhalten als nicht nur leichtfertig, leiten die Zöllner in der Regel ein Strafverfahren wegen versuchter Steuerhinterziehung ein.,, Auf einen Versuch würde ich es nicht ankommen lassen. Wäre mir zu viel HickHack und potentielles Theater, seis wegen Zoll oder Garantie.5 Punkte

-

Egal wie früh du nach News schaust, pitha schaut früher!😂😉😎5 Punkte

-

Moin, ich bin neu hier im Forum. Eigentlich wollte ich mich letztes Jahr schon bei Euch anmelden, nachdem ich den Aurora R11 zum Geburtstag geschenkt bekommen hatte. Hier nochmal ein kurzer Hinweis für die Admins. Bei einer neu Registrierung kann ich nur ältere Alienware Rechner auswählen. Der R11 oder auch mein jetziger Rechner, der R13 ist leider nicht mit auswählbar, das nur kurz zur Info Nun zum eigentlichen Thema. Ich bin seit Anfang Januar 22 stolzer Besitzer eines Aurora R13 mit folgender Config: Aurora R13 mit Kyro Tech + Seitenfenster und zusätzlicher Seitenabdeckung I9-12900KF 32GB DDR5 mit 4400 MHz Geforce RTX 3080 LHR 750 Watt Netzteil Eigentlich war ich letztes Jahr bereits mit dem R11 unzufrieden. Permanente Throttling Probleme durch Überhitzung der CPU (I7-10700 KF) machten mir zu schaffen und war kurzzeitig am überlegen ob ich das ganze System wieder an Dell zurücksende. Durch den Engpass der Grafikkarten hab ich mich aber dazu entschlossen das System zu behalten und habe jede Menge Arbeit reingesteckt um das System in den Griff zu bekommen. Dabei wurden jegliche Lüfter ausgetauscht, eine neue und bessere Wärmeleitpaste verwendet und die CPU "undervoltet", als auch entsprechend die Wattzahl bei TDP PL1 und 2 geändert. Seitdem läuft der Rechner recht zufriedenstellend. Nicht perfekt aber ok. Seit der Ankündigung des R13 war ich sofort verknallt. Für mich ist der R13 vom Design her einer der schönsten Computer die ich bisher gesehen habe und ich habe schon etliche gesehen (wie immer Geschmacksache). Ich bin 51 Jahre alt und habe mir über die Jahre meine PC's immer selber zusammengestellt und zusammengebaut. Ich bin mittlerweile aber auch faul geworden und durch die jetzige Marksituation interessieren mich Komplettsysteme mehr, da ich auch bei Dell bzw Alienware einen 3 Jahre Premium Support genieße (beim 11er sind es 2 Jahre). Wie dem auch sei, beim R11 musste ich durch den Lockdown letztes Jahr knapp 3 Monate auf die Lieferung warten und war überrascht das es beim R13 gerade mal 1 Woche gedauert hatte. Vom Bestellprozess bis zur Lieferung war das für Dell Verhältnisse Lichtgeschwindigkeit! Nun zum eigentlichen Feedback des Aurora's R13: Ich habe die Kiste auf der Dellseite mit gerade mal 3 von 5 Sternen bewertet, warum das ? Trotz der Kyro-Tech Lösung und des größeres Gehäuses + der 2 zusätzlichen Lüfter, habe ich das gleiche Problem wie damals mit dem R11. Das Ganze System drosselt in kürzester Zeit wenn R23 läuft, dabei wird der komplette Rechner so unerträglich laut (wie beim R11 nur noch ein tick lauter) das ich es kaum mehr am Arbeitsplatz aushalte und ich den Computer 2 Räume weiter immer noch als störend empfinde. Unglaublich aber war, Dell hat leider immer noch nichts dazu gelernt und ich bin mir sehr sicher, das der I9-12900KF völlig ungeeignet für eine 120mm AiO Kühlung ist. Vielleicht ist es beim I7-12700KF etwas anderes, aber ich kann den I9 für dieses System leider nicht empfehlen. Ich verstehe auch nicht, wie man so einen Computer auf den Markt schmeißen kann (da er ja sogar in Kooperation mit Intel entstanden ist und Intel für diesen auch Werbung macht). Der Dell Kundendienst ist hierbei auch mal wieder eine Katastrophe da die Mitarbeiter leider kein Plan haben. Außer ein zurücksenden oder Gutscheine für den nächsten Einkauf, können die einem nicht wirklich weiter helfen. Also was tun, zurücksenden ? nein...ich will und möchte den Rechner dennoch behalten und eigentlich bin ich auch ein alter Alienware Fanboy 😉 Was hab ich getan. Nun, das Gleiche wie damals mit dem R11. Als Wärmeleitpaste habe ich diesmal die Thermal Grizzly Kryonaut Extreme genommen und habe dadurch ca. 2 bis 3 Grad einsparen können. Auch die Lüfter habe ich mit den Noctua NF-A12x25 PWM chromax.black.swap getauscht. Hierbei eine kleine Info. Nicht die Noctua NF-A12x25 PWM in Braun nehmen, da beide Lüfter nicht zentriert im vorderen Gehäuse sitzen. Es sieht etwas dämlich aus, wenn man vorn auf dem Rechner sieht und 2 braune Lüfter durch Luken die nicht zentriert sitzen. Leider klappt das "Undervolting" mit ThrottleStop nicht mehr vernünftig unter Windows 11. Kein Plan warum, aber jedesmal wenn ich dort eine Einstellung vornehme läuft der komplette Rechner mit gefühlt 1Mhz und es hilft nur ein Reboot. Überhaupt ist Windows 11 bisher eine Vollkatastrophe. Ich frage mich welche Drogen bei Microsoft konsumiert werden. Viele Programme wie ThrottleStop (einer meiner wichtigsten Tools) funktionieren nicht mehr vernünftig und es liegt nicht am Tool, sondern an den Sicherheitseinstellungen von Windows 11. Spiele wie bspw Star Citizen liefen auf Win10 wesentlich weicher und flüssiger mit meinem R11 (wo ist der Performancesprung mit dem MS für Win11 seit Ewigkeiten wirbt ?). Die ganze Oberfläche ist sehr gewöhnungsbedürftig. Aber leider muss ich ja Win 11 nutzen um das volle Potenzial des I9 auszuschöpfen. Ich muss nun auf XTU zurückgreifen, da mir das AW Bios auch keine Möglichkeiten bietet, dass Throttling in den Griff zu bekommen (eigentlich ein Wahnwitz für ein System das knapp 4K kostet). Ich habe eine etwas aggressivere Einstellung in XTU eingestellt. Core Voltage Offset und die Performance/Efficient Cache Voltage Offsets habe ich mittlerweile auf -0,120 V und die CPU auf 125 Watt beschränkt. Im Boost für 56 Sekunden auf 190 Watt. Der Rechner läuft nun sauber und rund, wird nicht mehr so heiss und ist dadurch auch schön leise. So wie es eigentlich sein müsste. Aber nein, ich habe dadurch leider wieder heftigste Performance Einbußen. Im R23 kann ich zufrieden sein die 18K im Multi zu knacken. Hier übrigens mal ein Link zum Thread den ich direkt bei Intel gepostet habe, da mir Dell wie ich ja erwähnt habe, außer ein zurücksenden nicht weiterhelfen konnte. Der Thread ist leider in englisch und ich bin im englisch leider nicht so bewandert ...vielleicht interessiert es den ein oder anderen ja. https://community.intel.com/t5/Processors/INTEL-DIAGNOSTIC-TOOL-FAILING-Brand-String-CPUFreq/m-p/1356498/emcs_t/S2h8ZW1haWx8dG9waWNfc3Vic2NyaXB0aW9ufEtaNE5BTEg5UE5VWFFVfDEzNTY0OTh8U1VCU0NSSVBUSU9OU3xoSw#M56196 Lange Rede, kurzer Sinn...kann ich den Aurora R13 mit I9 empfehlen ? ganz klares NEIN! Dell hat außer dem schicken Design nichts dazu gelernt. Es werden immer noch Bauteile verbaut, die nicht wirklich zusammen passen. Dell wirbt nun, das durch die Größe des neuen Gehäuses nun die Möglichkeit besteht, in Zukunft bessere und längere Grafikkarten zu verbauen, was an sich ja auch ein cool und ein Sprung nach vorn ist. Nur was nutzt mir ein 750 Watt Netzteil wenn ich eine 3090TI einbauen möchte ? Facepalm5 Punkte

-

Ich und die meisten User hier würden dir dringend davon abraten einen Desktop von Dell zu kaufen. Ich selbst wollte auch mal einen alienware Desktop kaufen. Ein area51 oder ein Aurora. Das im Aurora nur sehr kurze gpus rein passten hat mich zum glück davon abgehalten es zu kaufen. Ich hab mir dann ein System von Mindfactory zusammen bauen lassen mit meiner wunschkonfiguration für über 1000 Euro günstiger als ein vergleichbares Alienware Aurora. Die Nachteile des aurora welche mir gerade einfallen - billigste Materialen - zu teuer - schlechte Kühlung - zu kleines case für große gpus - schlechte Software - Sehr schlechte Leistung im vergleich zu denselben Komponenten in einem guten case. - zu laut Aber aktuell würde ich jetzt kein System mit 3070 kaufen 1,5 Jahre nach Release und noch über UvP.5 Punkte

-

Alienware Aurora R13 eine riesen Enttäuschung Hallo liebe Community, ich hatte mich seit langer Zeit auf einen Alienware gefreut, also habe ich mir für viel Geld den neuen Aurora R13 gekauft. Leider ist das Gerät eine riesen Enttäuschung und wird auch mein letztes Gerät von Dell gewesen sein. Der PC ist laut und wird einfach nur extrem heiß 100° inklusiver CPU Drosselung (Streetfight Flüssigkeits Kühlung). Auch die groß angepriesene Cryotech Kühlung dürfte laut anderen Berichten und Aussage des Kundendienstes nicht ausreichend für dieses System sein. Selbst wenn Ihr später mal Teile wechseln wollt, könnt Ihr das nur bedingt, da Dell anscheinend nur Hauseigene Teile als Kompatibel ansieht und das BIOS sodermaßen abgespeckt und nutzlos ist, dass ihr dort wenig einstellen könnt. Ihr wollt die "Düsentriebwerks-Lüfter" tauschen? Reines Glücksspiel, durch Dells internes Überwachungssystem bekommt Ihr den Bios Fan Error. Ihr könnt keine Lüfter Ports deaktivieren oder freilassen ohne das dieser Fehler auftritt. Das Alienware Commandcenter ist eine Katastrophe und höchstens für die RGB Beleuchtung zu gebrauchen. Lüfterkurven könnt Ihr damit nicht vernünftig einstellen. XMP Profil ist im BIOS gesperrt, der Arbeitsspeicher ist auf 4400 MHZ begrenzt, obwohl er 4800 MHZ könnte. Wenn Ihr nicht von vornherein für 300€ die Cryokühlung und das Fensterseitenteil kauft, bekommt Ihr einen PC der innen nicht schwarz ist, sondern metallisch. Außerdem fehlt das Lightbar mit dem Schriftzug Alienware im Innengehäuse. Ein späteres Upgrade mit Dell-Teilen ist aber eh hinfällig da Ihr noch nicht mal DELL'S Hauseigene Teile nachkaufen könnt. Entweder sind diese nicht verfügbar oder der Kundendienst hat keine Ahnung wovon Ihr überhaut sprecht.... Fragen an die Fa. DELL: - Seit Jahren sind diese Probleme bekannt, vor allem die der starken Hitzeentwicklung, warum ändern Sie das nicht? - Wenn Sie ein neues Produkt designen, wird das überhaupt bei Ihnen getestet? - Ich erwarte als Endkunde von Ihnen ein Produkt mit dem ich Spaß habe und keins an dem ich selber basteln muss um z.B. Temperaturen in den Griff zubekommen. Und wenn Sie dem Kunden so ein schlecht designtes Produkt zusammenstellen finden Sie dann nicht, dass Sie dem Kunden die Freiheit lassen sollten simple Teile wie Lüfter durch hochwertigere Produkte als Ihre auszutauschen, ohne danach vor gravierenden Problemen zustehen? Bitte fügen Sie Ihrem System wenigstens die Möglichkeit hinzu, Lüfterports über das BIOS zu deaktivieren oder geben Sie uns eine Möglichkeit diese BIOS Fehlermeldungen auszublenden.... Sie würden vielen Kunden einen großen Gefallen tuen, mit nur solch kleinen Änderungen. Sie könnten dieses leicht über ein Update ermöglichen. FAZIT: Wenn man Premium Hersteller sein will, dann muss man es auch richtig machen! Ich bin sehr enttäuscht über meinen Einkauf bei Ihnen... Vielen Dank für Ihre Aufmerksamkeit. Habe diesen Text mal ins DELL Forum geschrieben. Vielleicht hilft es dem Ein oder Anderen bei der Entscheidungsfindung oder DELL ändert mal grundlegend etwas an Ihrem System. VON MIR GIBT ES FÜR DEN AURORA R13 EINEN DICKEN DAUMEN NACH UNTEN!5 Punkte

-

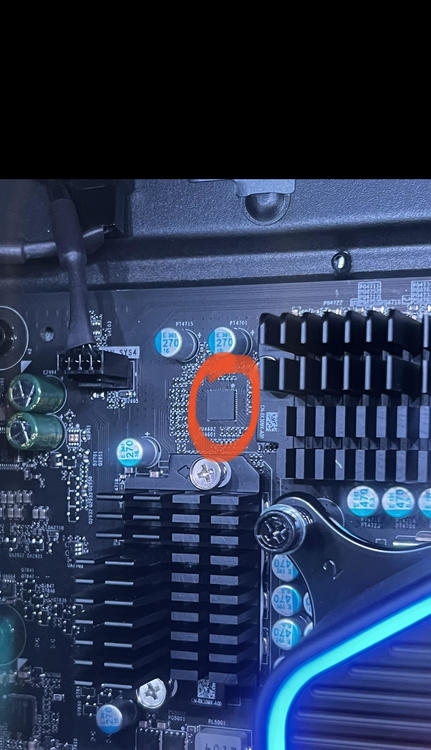

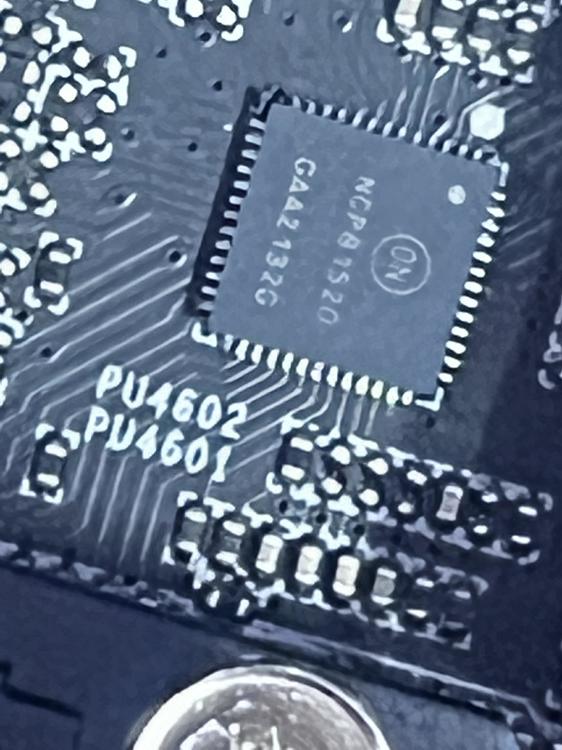

Genau, das Mainboard hat eben keine ATX Maße und entsprechend sind Bohrungen und Dimensionen anders. selbst Anschlüsse der Stromversorgung sind eigenes Design. also müsste im fall eines Wechsels hier auch ein neues Netzteil eingeplant werden. Dann kann man besser bei dem bleiben, dass man hat. währe ein €-Grab. Der Controller Chip für die Spannungsversorgung ist ein "ON NCP81520" zu dem bekommt man nur relativ wenige infos. Mein Chinesisch ist aber auch nicht gerade das beste. du findest Ihn in der Ecke zwischen den Kühlern der CPU Stomversorgung. Ich habe ein kleines Video gemacht zum Thema Auspacken, erste Eindrücke und den Umbau der Lüfter.5 Punkte

-

Hey, mein Rechner ist jetzt da aber ich lag lange mit einer Blöden Corona Infektion Flach. Ich habe den Rechner aber schon aufgebaut und habe ihn hier und da schon getestet. bevor er in betrieb genommen wurde, habe ich die Gehäuselüfter entfernt und sie gegen Noctua NF-A 12X25 ersetzt. Die sind echt sehr leise. Einzig der Lüfter am Radiator ist deutlich hörbar, sogar sehr deutlich. Die Pumpe selbst ist angenehm leise. Zu den ersten Ergebnissen. 3DMark Time Spy 18.954 P. CineBench R23 Multi 25.581 P. im geschlossenem Gehäuse und 1.856 P im Singel Die CPU Temperaturen gehen sehr schnell auf 90-93 grad im CineBench sodass ich erstmal alles Zerlegt habe und neue Wärmeleitpaste (MX4) aufgetragen habe. zumindest jetzt erreiche ich nur noch etwa 85 Grad im selben Benchmark jedoch ohne höhere Punktezahl. Zu erwarten sind wohl normalerweise etwa 27.500P im Multi. Hier Denke ich aber das Dell da einfach die Sicherheit sehr hoch geschrieben hat. Die CPU erreicht hier Maximal 231W selbst im LV2. Normalerweise ist der 12900KF auf 241W ausgelegt. Die Spannungsversorgung der CPU ist mit insgesamt 8 Phasen aber auch nicht gerade sehr gut. Reicht bestimmt aus aber Optimal sieht anders aus. Vergleichbare Boards von Asus und Co haben locker die doppelte Anzahl an Spannungswandlern. Lustig auch, dass der Spannungswandler Controller eigentlich für Notebooks verwendet wird. Ich muss mich mal mit dem Thema Manuelles OC im Bios auseinander Setzen. Die M2 SSD (2TB kommt als PCI-E 4 Version mit 4 Lanes und Schafft laut CrystalDiskMark 6513MB/s Read und 4997MB/s Write. Die Seagate Baracuda 2TB HDD schafft im Selben Test 204MB/s Read und 105MB/s Write. Zu der verbauten RTX 3090 kann man nichts sagen. Sie hat etwa die Leistung der Founders Edition jedoch lässt sich das Power Target nicht mal um einen Prozentpunkt anheben. Hier hat Dell eine Sperre eingebaut. Lustig auch das Thema RAM. Hier sind 2x 32GB DDR5 4800Mhz Cl38 verbaut. Das System begrenzt jedoch auf 4400Mhz und lässt sich auch nicht erhöhen. Die entsprechenden Funktionen im Bios sind ausgegraut oder gar nicht erst vorhanden. Der Ram selbst kommt von SK Hynix PC5 4800B. Weitere Lüfteranschlüsse sind ebenso wenig vorhanden wie zusätzliche Stromanschlüsse. Hier ist neben den beiden Stomanschlüssen für je eine HDD oben und eine SSD unten im Gehäuse, noch 2x 6+2Pin für Grafikkarten vorhanden. Jedoch bietet das Mainboard keine 2te PCI-E Schnittstelle für eine weitere Graka, noch das Gehäuse, hier ist direkt unter der RTX 3090 sofort das Netzteil zu finden. Ich erwarte heute noch eine Lieferung eines 92mm Noctua Lüfters (Noctua NF-A9x14 HS-PWM) den ich hinten am Gehäuse anbringen will und eine Push/Pull Configuration möglich machen soll. Dafür sieht das Gehäuse entsprechende Bohrlöcher hinter dem Radiator vor und über die Klappe mit der die Graka an dem Gehäuse gesichert wird lässt sich das PWM Kabel ins Gehäuse führen. Hier werde ich einfach ein Y-Kabel verwenden und entsprechend mit dem Push-Lüfter eine Einheit Bilden. Dann werden wir mal Sehen ob sich an den Temperaturen noch etwas machen lässt. Ich bin insgesamt etwas enttäuscht vom dem Gesamtkonzept, zumal das Mainboard sich nicht wechseln lässt ohne auf das Gehäuse zu verzichten, und die Kühlung der CPU, die sich als Stinknormale 120mm AIO herausgestellt hat deutlich unterdimensioniert ist für eine 241W CPU. Hier sieht man normalerweise 100W pro 120mm Kühlfläche MAXIMAL vor. Hier hätte also normalerweise eine 360mm AIO verbaut sein müssen um die Temperaturen in den Griff zu bekommen und das wird bestimmt auch einer der Gründe sein, warum die CPU "nur" 230W leistet und nur 8 Phasen für die Stromversorgung bekommt. Sobald die Push/Pull Configuration steht, melde ich mich wieder.5 Punkte

-

5 Punkte

-

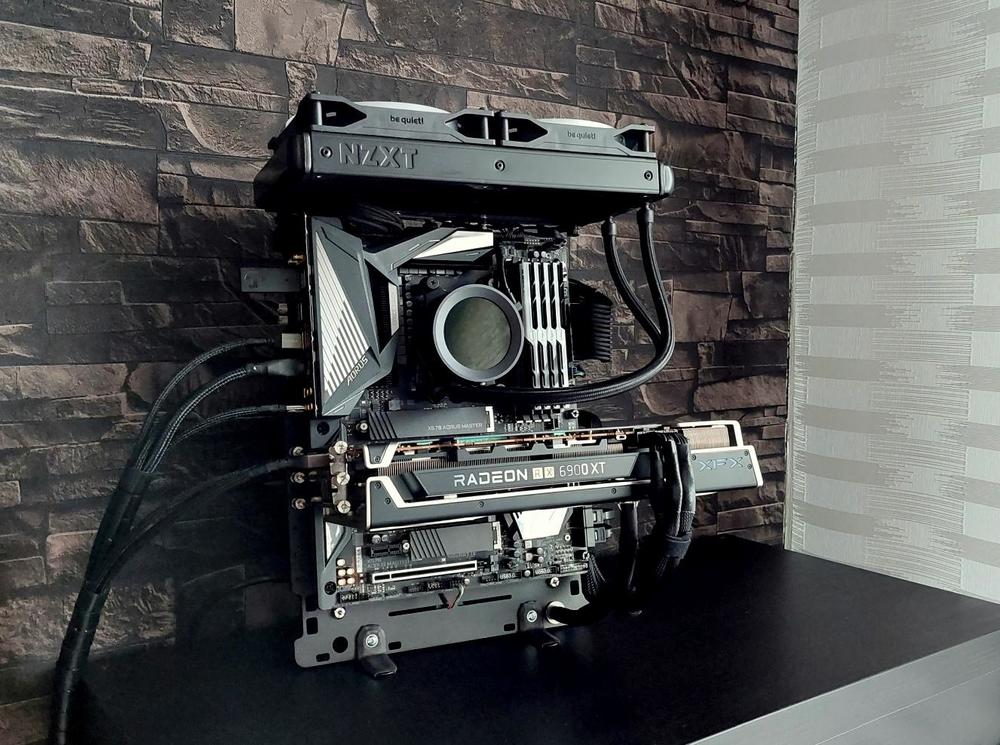

Hab mir für's Büro ein kleines Upgrade gegönnt. Folgende Specs sind verbaut: - AMD Ryzen-5 5600G (mit iGPU) - B550i Aorus Pro AX - Scythe Big Shuriken 3 (Low-Profil Kühler) - 16GB G.Skill Trident Z (2x 8GB) @ 3.800 MHz CL16-16-16-32 (Sam B-Die) - 2x m.2 NVMe Samsung 970 EvoPlus 500GB - 400w BeQuiet Pure Power 10 (80+ Gold) (war über) - Beleuchtung: Wingboost 3 aRGB Lüfter & Phantkes Halo für PSU - Zweckentfremdetes offenes DIY-Case Da ich die Hardware gerne sichtbar haben wollte, habe ich diesmal ein bewegliches und offenes DIY-Case gebastelt. Anfangs wollte ich ein Testbench (für ITX) oder sowas ähnliches holen, aber das fand ich einfach viel zu teuer. Das DIY-Case hat mich nur 28 € und wenig Bastel-Zeit gekostet. Das "Gehäuse" kann man ganz nach seinem Belieben einstellen, da die Scharniere alle beweglich sind: Ein wenig RGB durfte auch nicht fehlen, weswegen der Wingboost Lüfter noch oben drauf kam und ins Netzteil habe ich ein Halo-Ring verbaut. Normalerweise gehören die oben drauf, aber das sah bisschen unschön aus. Die Temperaturen sind natürlich Top und der 5600G ist wirklich fix unterwegs. Also die neuen APUs von AMD sind schon nicht übel. Wenn man Lust hat, könnte man eine GPU anschließen und hätte direkt ein fertiges Gaming-Rig.5 Punkte

-

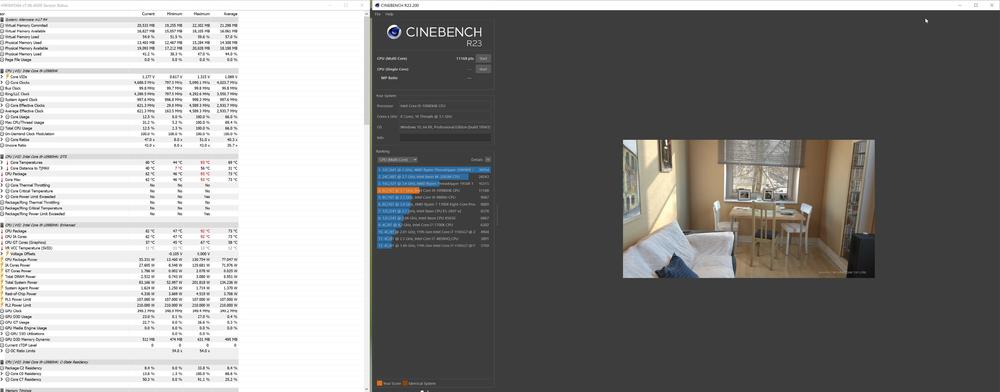

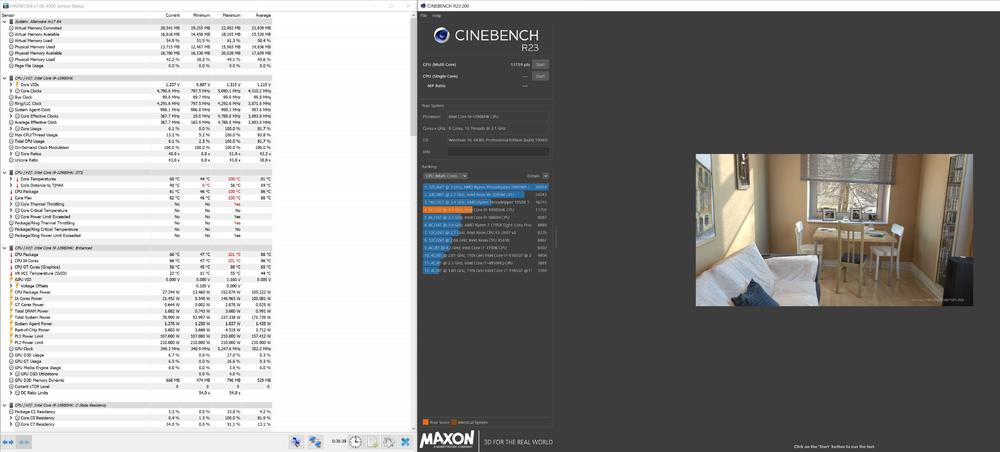

Hallo zusammen, nachdem die X17 Serie nun da ist wollte ich meine Erfahrungen und Updates geben wie es um den m17 R4 aktuell bei mir steht. Man landet ja bei der Suche nach 17 Zoll Gaming-Notebooks oft auch hier. Ich nutze den i9 und die RTX 3070 (beide Chips mit LM Repaste). Zusätzlich habe ich über den AGA Port eine 6900XT dran hängen seit ein paar Monaten und nutze ihn nahezu immer. Hier aktuelle Werte von Cinebench R23 und AWCC Fusion Custome Curve und Cinebench R23 mit Höchstleistung und TimeSpy mit AGA: Nachdem ich den AGA komplett auseinander genommen habe steckt der AGA aktuell in einem ITX Gehäuse inkl. einem PCIE16x Riserkabel ohne nennenswerten Performanceverlust. Da kommt bald ein kleines Projekt bei mir, in dem ich den AGA in einen Kasten stecken möchte um das Laptop oben drauf stellen zu können. Dann bin ich etwas mobiler. Das ITX Gehäuse ist viel zu dick für das, was SFX und Graka benötigen. Zusätzlich will ich 3 Noctua Lüfter verbauen damit ich einen AGA + Notebook-Kühler habe. Gerade wegen dem AGA ist der m17 mein Laptop geblieben. Ausreichend Power für unterwegs und eine geniale Option mit viel Power für zu Hause durch den AGA. AMD Radeon RX 6900 XT Grafikkarten Benchmark Resultat - Intel Core i9-10980HK Processor,Alienware Alienware m17 R4.pdf5 Punkte

-

Hier mal das Win11 ISO + Workaround, so dass ihr es auf den meisten Systemen zum Laufen bekommt.5 Punkte

-

@hysterix und @Nuestra Ihr wurdet von mehreren Usern bereits mehrfach gebeten, eure persönlichen Differenzen außerhalb der öffentlich einsehbaren Themen auszutragen. Dies ist eine offizielle, noch freundliche, Verwarnung. Wenn ihr eure Off-Topic Streitigkeiten nicht augenblicklich beilegt, werdet ihr aus disziplinarischen Gründen mit einer zeitlichen Postingsperre belegt, die sich bei weiterer Missachtung potenzieren wird.5 Punkte

-

5 Punkte

-