-

Gesamte Inhalte

1.967 -

Benutzer seit

-

Letzter Besuch

-

Tagessiege

274

Inhaltstyp

Profile

Forum

Downloads

Treiberreihenfolgen

Alienware Geräte-Lexikon

Alle Inhalte von Sk0b0ld

-

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Ich kann's dir nur wärmstens ans Herz legen. Ich selber habe unheimlich viel über Notebooks und allgemein Leistungsbewertung mit diesem Programm gelernt. Wenn du wirklich wissen willst, was das Notebook macht und welche Leistung du wirklich nutzen kannst, kommst du nicht um diese Software herum. Auch für Umbauten, Fehleranalyse, Leistungsbewertung, Mods usw. ist sie essenziell wichtig, weil du nur so echte vergleichbare Daten generieren kannst und auch überprüfen, ob und wie viel eine Änderung ausmacht. Dein oberes Bild von XTU mit den 87w Package Power ist da ein gutes Beispiel. Alleinstehend sagt der Wert gar nichts aus und du bist davon ausgegangen, dass du 100% deiner CPU-Leistung nutzen kannst. Wenn das so wäre, würdest du einen ähnlichen Score in CB R23 wie ich haben. Deshalb ist Hwinfo da so hilfreich, weil es dir zeigt, warum das eben nicht so ist und an welchen Stellschrauben (Temperatur, Powerlimits etc.) du noch drehen musst bzw. wo noch Potenzial ist. Insbesondere wenn du irgendwelche Mods ausprobierst, wie das mit Lüftern oder den Schrauben auf der Heatsink, musst du für dich selbst wissen, ob die Veränderung besser oder schlechter am Ende sind. Höhere Temperaturen sind nicht zwingend ein Indiz, dass ein Mod schlechter ist. Ein Mod kann auch zu einer höheren Leistung führen, so das die Temps erstmal gleich oder ein wenig höher ausfallen, dennoch aber in Anbetracht der Mehrleistung lohnenswert sind. Wenn HWinfo für dich noch viele Fragen aufwirft, schau dir echt mal in Ruhe meinen HWinfo-Thread an. Dort habe ich das wichtigste erklärt. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

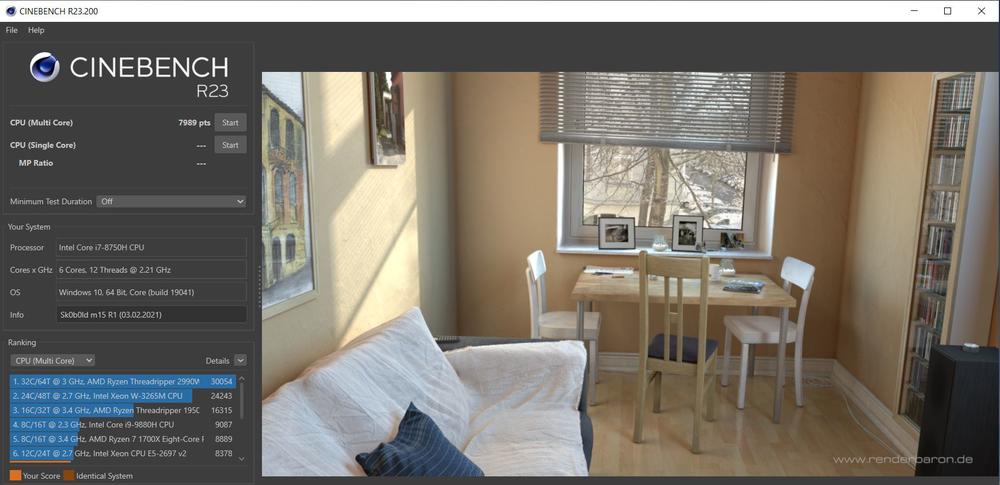

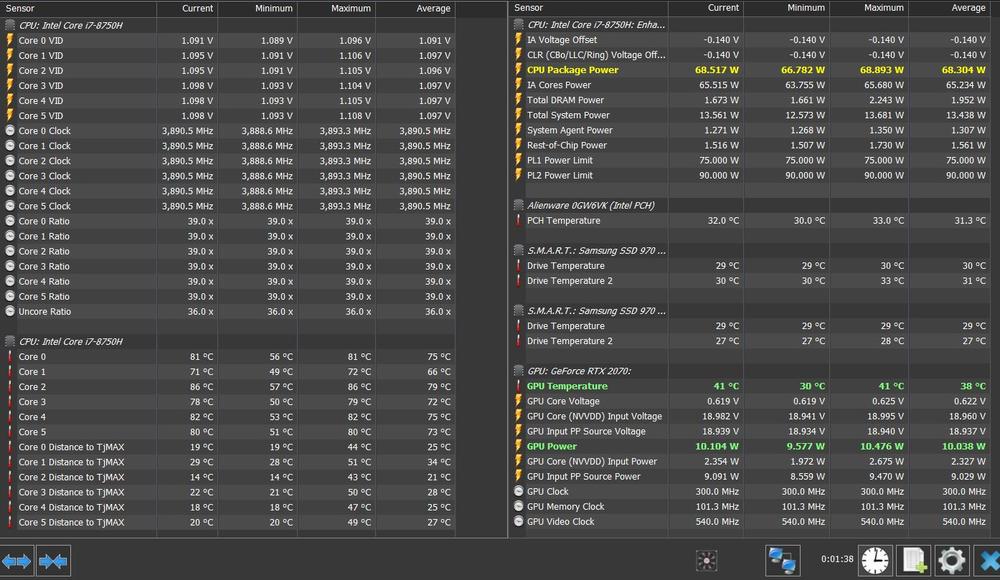

Selbst wenn du die beste Kühlung der Welt hast, bringt dir das letztendlich nicht viel, weil dein PL trotzdem nicht die volle Leistung erlauben wird. Deshalb solltest du abchecken, ob du mit deiner BIOS Version noch undervolten kannst. Ein kleiner Screenshot ist immer ganz nett. Hier mal mein Ergebnis vom Cinebench R23: und hier noch mal ein HWinfo Log, den ich während des Benchmarks festgehalten habe: Im direkten Vergleich mit deinem HWinfo Log siehst du vielleicht jetzt besser den Unterschied. Ich habe meinen HWinfo-Log ca. 1-2 Sekunden nach Beginn des Benchmarks gestartet (Uhr Symbol) und 1-2 Sekunden bevor der Benchmark endet, den Log via Screenshot festgehalten. So hat man nur die reinen Last-Werte ohne Verfälschung von Idle-Werten. Dies ist auch sehr gut an den MIN-Werten erkennbar. Während bei mir im CPU Package Power 66,78w im MIN-Wert stehen, sind es bei dir 12,45w. Das ist ein Unterschied von über 50w. Selbiges gilt auch für die Zeit. Der Benchmark braucht bei voller CPU Leistung ca. 1:40, was mit 1:38 (98 Sek.) relativ nah dran kommt. In deinem HWinfo-Log haben wir 3:32 (212 Sek.). Das ist mehr als Doppelte der Zeit und dementsprechend eine hohe Verfälschung durch Idle-Werte. Deswegen ist der HWinfo Log von dir gerade mal für die Max-Werte aussagekräftig. -

Weil's gerade zur aktuellen Situation so gut passt. Für Schnäppchenjäger mit den richtigen Fähigkeiten wär das was:

-

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Einen speziellen "Modus" gibt es so nicht. Man musst das über Throttle Stop machen. XTU würde ich nicht empfehlen. Wahrscheinlich erlaubt Intel' XTU das schon Out of the box nicht. Wenn du eine 2080Ti dran hängen hast, kann das durchaus schneller passieren als man meint und dann kannst du nicht die volle GPU-Leistung nutzen. Auch wenn man beispielsweise Videos rendert, hat man über einen längeren Zeitraum 100% CPU Auslastung. Der HWinfo Log ist ganz nett, jedoch durch die idle-Werte mit 12w im MIN wenig aufschlussreich. Wie viel Punkte hast du denn in dem Benchmark gehabt? Ich mach mal später auch ein CB-Run zum Vergleich. Wie gesagt, ich habe das Notebook in allen möglichen Variationen (mit/ ohne Kühler, LM, WLP etc.) durchgetestet. Mit'm Kühler drunter und LM kommt man schon sehr weit. Die volle Leistung schaffst du aber dennoch nicht zu nutzen, weil bei 75w nun mal Schluss ist. Die 90w im PL2 halten nur 30 Sekunden und sind eher für kurzzeitige Boosts gedacht. Core-Multi von 41x bezieht sich immer nur auf Single-Core, all Core Turbo ist auf 39x festgesetzt. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Wenn du Spaß daran hast und die Möglichkeiten, spricht natürlich absolut nichts gegen. Ich bastel und teste ja auch gern. Mir ging es hier mehr um die technische Begrenzung deiner genannten Leistung unter den beschriebenen Parametern. In meinem Testing mit den m15 R1 war es technisch nicht möglich die volle Leistung der CPU dauerhaft zu halten. Die Powerlimits von 75/90w lassen das einfach nicht zu. Erst mit einem undervolt von -128mV bleibt man knapp unter den 75w, wo man dauerhaft die volle Leistung nutzen kann, vorausgesetzt kann diese Leistung auch kühlen, was mit so einem U3-Kühler weniger ein Problem ist. Ich hätte dieses Argument von Anfang an behaupten könnten, weiß aber nicht, ob du mir das glaubt hättest. Deswegen habe ich das mit dem Cinebench R23 angesprochen. Dort sieht anhand der Punkte, ob die volle Leistung der CPU dauerhaft gehalten werden kann oder nicht. Bei deiner BIOS Version bin ich mir nicht sicher, ich vermute es handelt sich um die Version 2.6.0 (statt 2.0.6). Also sprich die aktuellste Version. Ich weiß auch gar nicht ob UV in dieser Version überhaupt noch möglich ist. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Letztendlich kannst du solche Mods machen, wirst aber bei der Baugröße und Leistungsspektrum nicht viel reißen können. Die Heatsink mit den Kühllamellen und Heatpipes bleibt unverändert, der CPU Heat-Output bleibt ebenfalls gleich und nur weil ein Hauch mehr Luft durchgeht, wird die Kühlung nicht automatisch besser. Der CPU Lüfter vom AW17 R3 kann bei 5V DC bei 100% Lüftergeschwindigkeit (0,50A) ca. 10 CFM erzeugen. Dieser Lüfter ist sowohl breiter als auch größer als die vom m15 R1. Der neuere und größere GPU-Lüfter vom AW17 R4 10.8 CFM (0,40A), der kleine CPU-Lüfter immerhin 11,0 CFM (0,50A). Welche Verbesserung ist nu zu erwarten, wenn du jetzt die Neigung der Lüfterblätter veränderst? Die Nachfolger m15 R2 und R3 haben dieselbe Neigung, haben jedoch mehr Blätter und sind drehfreudiger. Fraglich ist auch, ob der Hersteller nicht schon das volle Potenzial von der Lüfter ausgenutzt hat. Mir stellt sich die Frage, warum so ein Aufwand, wenn du deine CPU doch dauerhaft bei 100% Last problemlos betreiben kannst? -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Ich habe mich auch ein paar Jährchen mit Quadro-, Hexa-Coptern usw. beschäftigt. Flugsport und Notebook-Lüfter sind doch schon zwei verschiedene Welten. Ich habe zuhause einige Heatsinks mit Lüftern da und nutze sie häufig für irgendwelche Tests (Beispiel). Ich habe probeweise mal einen Lüfter abgenommen und ehrlich gesagt war der Lüfter danach hin. Nach der Montage eierte er und erzeugte ein leichtes Schleifgeräusch. Ich kann nur davon abraten den Lüfter vom Rotor abzunehmen. Letztendlich kann das jeder selbst entscheiden, sollte sich aber vorher informieren, ob er Ersatz bekommt, falls es nicht so klappt wie erhofft. Welchen anderen Lüfter willst du dort einsetzten? Hast du einen Link davon? Ein Lüfter der mehr Luft umwälzt, sollte auch einen höheren Innenwiderstand erzeugen. Das könnte die Elektronik vielleicht nicht so toll finden auf Dauer. Ich bin immer noch sehr gespannt, ob das tatsächlich so ist. Über'n CB Lauf würde ich mich freuen. -

Performance-technisch denke ich eher weniger. Selbst mit'm meinem "alten" 6-Kerner (8750H) ist das Notebook fix unterwegs. Bei Benchmarks usw. wirst du das natürlich sehen. Was viel wichtiger ist, ob du es temperatur-technisch im Alltag sehen wirst. Desto wärmer die CPUs laufen, desto lauter wird auch das Notebook. Bei Intel mit Plundervolt ist das immer so ne Sache und AMD lässt sich nicht wirklich großartig undervolten (nach meinem jetzigen Kenntnisstand). Bisschen geht wohl was, ist aber nicht weltbewegend. Insgesamt aber verbraucht der Ryzen weniger Strom.

-

-

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

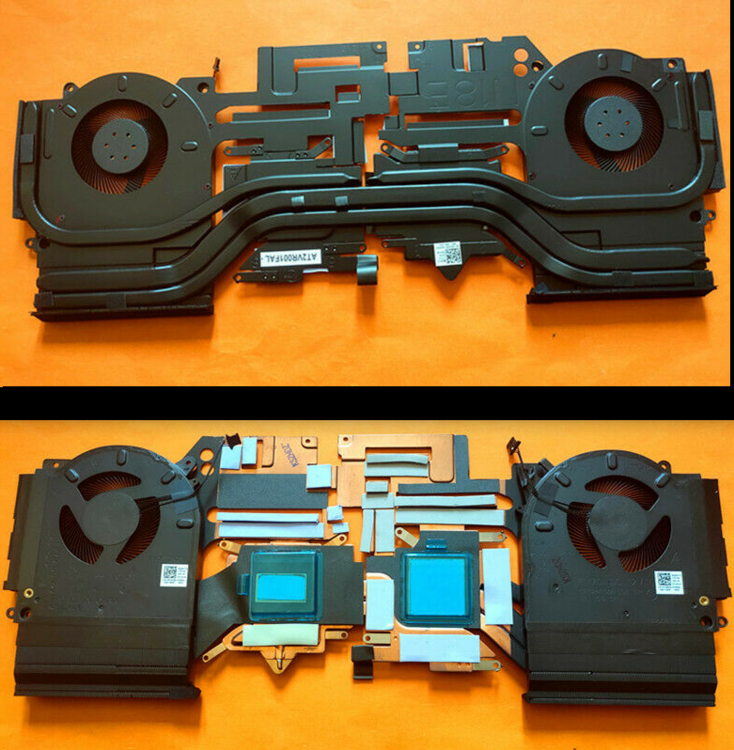

Die Begründung finde es etwas unverständlich, weil so ein Kühler selbst auf 100% leiser ist als das Notebook, wenn es auf 50% dreht und man schon einen signifikanten Kühlungsvorteil erreicht, wenn man den U3-Kühler auf 20-30% Lüftergewindigkeit drehen lässt. Die Daten dazu habe ich oben gepostet. Zudem wird das Notebook mit so einem Kühler deutlich leiser, weil es durch den erhöhten Kühlungsvorteil selbst dann weniger kühlt. 1. Anhand der Drehzahlen, ausgewertet über HWinfo, kann man sehr deutlich erkennen, dass die Lüfter das nicht tun. 2. Haben sich die Lüfter im idle mit so einem Kühler teilweise komplett aufgehört zu drehen (0 rpm), weil das Notebook ausreichend gekühlt wird. Ebenfalls ausgewertet über HWinfo. Die Logs habe ich mehrfach hier im Forum gepostet. 3. Mein damaliger R4 und mein R5 laufen praktisch seit, ich glaube 4 Jahren mittlerweile, ausschließlich mit dem Kühler und die Lappys laufen nach wie vor perfekt und sind täglich im Einsatz. Das weiß ich daher, weil die Notebooks zu meinen Arbeitskollegen gewandert sind. 4. Beim m15 R1 kommt die USB Version mit den Noctua NF-A8 Lüfter zum Einsatz. Die Lüfter sind zwar gut, haben aber bei weitem weder die Kraft, noch den statischen Druck die Lüfter des Notebooks zum Drehen zu bringen. Hinzu kommt dann noch die Bodenplatte, die Luftstrom abdämpft. Genau so wie das Mesh bei den oben genannten Notebooks. 5. Ich habe unzählige HWinfo-Auswertungen gepostet (Beispiel) mit und ohne den U3-Kühler und in diesen Fällen kamen immer die NF-A12 Lüfter zum Einsatz. Also die Lüfter mit dem höchsten statischen Druck und diese liefen, je nach Testing, immer auf 100% und dennoch haben sich die Lüfter RPM's des Notebooks im direkten Vergleich ohne den U3-Kühler nicht verändert. Das habe ich sowohl mit mehreren Notebooks hier getestet, als auch andere User, die sich den U3-Kühler bei mir geholt haben. Diesbezüglich hatten wir unzählige HWinfo Logs hier, wo man die RPMs sehen konnte. 6. Würden die NB-Lüfter sich großartig durch den U3-Kühler bewegen, könnte man das sehr einfach über HWinfo sehen. Selbst wenn man den Lüfter per Hand andreht oder ausbremst lässt sich auswerten, weil das PWM-Signal allein durch die Rotation übermittelt wird. 7. Kann man behaupten, dass wir im Bezug auf dein angeführtes Argument Langzeiterfahrungen mit externen Kühlern haben (Betrieb über mehrere Jahre) und es bislang nie negative Einschränkungen gab. Ich bin mir nicht sicher, was du damit meinst. NB-Lüfter kannst du nicht austauschen und extern geht kaum was über den NF-A12. Das geht nur noch mit Lüftern, die 2.500 rpm+ drehen und dann wird's aber richtig laut und aus meiner Sicht nicht mehr wirklich für den Alltag zu gebrauchen. Zumal der Kühlungsvorteil kaum noch besser wird. Im Repaste-Guide zum m15 R1 habe auch verschiedene Heatsinks im direkten Vergleich mit Fotos gepostet. Der Anpressdruck, die verschiedenen Aussparungen für die Pads usw. unterscheiden sich je nach Ausstattung, weil beispielsweise eine GTX 1070MQ andere VRM-Komponenten mit anderen Höhen besitzt als ein RTX 2060 oder 2070MQ. Deswegen haben die Heatsinks unterschiedliche Teilenummern. Wenn du jetzt eine andere Heatsink verwendest, was grundsätzlich geht sofern die Verschraubpunkte gleich bleiben, musst du sicherstellen, dass alle VRM-Komponenten gekühlt werden. Befinden sich die Aussparungen an anderen Stellen, kann es deine gesamte Heatsink anheben bzw. sie kommt nicht tief genug runter. -

Alienware m15 R1 Alienware m15 mit Amplifier Probleme

Sk0b0ld antwortete auf EL_TORO's Thema in Allgemeines & Troubleshooting

Der aktuelle AGA ist EOL und ob es einen Nachfolger geben wird, steht in den Sternen. Aktuell sieht es nicht danach aus. 😨 Oh ha..... nur mal so ne Frage. Hast du die kleinen SMDs von der GPU geschützt? Irgendein Auslaufschutz oder so? Also ich hatte auch LM auf der GPU. Hatte nie Probleme. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

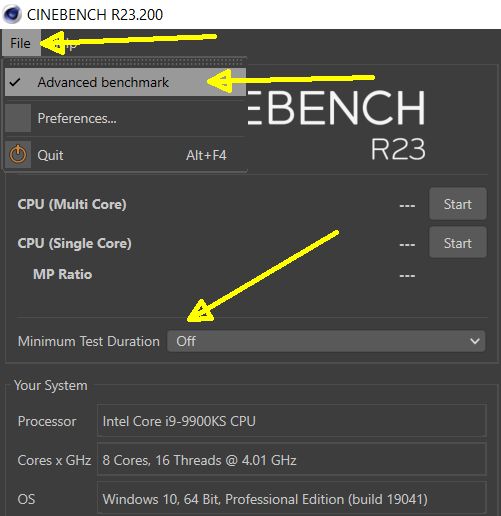

Die Sache ist, dass ich häufig Fremdgeräte repaste und die Leute mir und auf meiner Erfahrung vertrauen. Solche Risiken kann ich nicht verantworten. Viele kennen mich hier und wissen auch wie penibel ich teste und auswerte. Dazu gehört der auch der m15 R1 und gerade das Modell habe ich in fast jeder Konfiguration hier getestet. Das PL 75/90w wird auch bei dir vorhanden sein, da wir das gleiche VRM-Layout haben. Die Temperaturen, die du in deinem Setup genannt hast, weichen relativ stark von den Daten, aus meinem Testing, ab. Daher vermute ich, dass du die Daten falsch interpretierst. Weswegen ich den Thread mit HWinfo angesprochen und um einen Screenshot gebeten habe. Wenn man 30-60 Minuten spielt, sieht man sehr schnell, wo sich die Temperaturen und Leistungsdaten einpendeln. Da du den AGA vermutlich benutzt, habe ich keine Referenz, aber die CPU ist in dem Fall gleich und diese kann man für sich alleine mit Cinebench testen und vergleichen. Dann sehen wir, ob deine CPU tatsächlich nicht drosselt. Ich kann's mir zwar nicht vorstellen, lasse mich aber jederzeit eines Besseren belehren. Vielleicht schaltet dein AGA das PL2 dauerhaft frei oder so. Noch eine Sache zum Cinebench. Den Punktestand bencht du, indem du oben im Reiter: File --> Advanced Benchmark --> Minimum Test Duration --> auf Off einstellst. Dann einfach bei CPU (Multi Core) auf Start drücken und abwarten. Ne kurze Info wie du getestet hast, wäre vielleicht noch hilfreich (mit U3-Kühler, Lüfterprofil, etc.). Wovon ich dir abrate, ist rauszugehen oder so. Mit LM im Board sollte man Minusgrade bzw. einstellige Plusgrade vermeiden. LM ist kein Wasser und gefriert schon deutlich früher und zusammen mit deinem Anpressdruck wäre das sicherlich nicht ratsam. Nicht das ich glaube, dass du das machst, aber im NBR-Forum hab ich solche Sachen schon erlebt. Ich wollte es zumindest mal erwähnt haben. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Welche Ausstattung hast du eigentlich genau? Ich kopiere mal meine Liste von oben als Referenz: CPU: Intel i7-8750H GPU: RTX 2070 Max-Q 8GB RAM: 32 GB @ 2.666 MHz SSD: 2x m.2 PCIe SSD Display: FHD 144Hz 90Wh Akku BIOS Version 2.5.0 Um zu überprüfen, ob deine CPU dauerhaft die volle Leistung (ohne Undervolting) halten kann, kannst einen Cinebench R23 machen. Der Benchmark ist kostenlos im MS-Store erhältlich. Anhand der Punkte ist das sehr einfach nachvollziehbar. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

Guck mal in meinen Repaste-Guide zum m15 R1. Der Anpressdruck ist nicht zu schwach, es könnten nur die falschen Wärmeleitpads drin sein, die die Heatsink hochdrücken. Abgesehen davon sind alle Pads ausnahmslos festgeklebt und an zwei Stellen fehlen die Pads. Hab das m15 R1 schon locker 5-6 mal gemacht. Jedes mal der gleiche Pfusch. Bezüglich HWinfo, stehen alle wichtigen Informationen hier drin: Dann bin ich mal auf dein Ergebnis gespannt. -

Alienware m15 R1 Alienware m15 R1 (Testbericht, Modding, Benchmarks etc)

Sk0b0ld antwortete auf Sk0b0ld's Thema in Erfahrungsberichte & Benchmarks

@EL_TORO ich habe mal dein Beitrag verschoben, weil ich so erstmal nichts über den externen U3-Kühler gelesen habe. Das kann man machen, ich würde es jedoch nicht empfehlen. Wenn du Metall über nacktes Silizium zu fest anziehst, kann der besonders dünne CPU-Chip brechen oder eine Ecke und dann war's das. Das kann auch noch nachträglich durch die Thermodynamik passieren. Guck mal in diversen Foren wo es um Direct-DIE Kühlung geht. Die Schrauben sind nicht zu kurz, sie besitzen aus den oben genannten Gründen einen festen Stopp-Punkt. Bezüglich deines Ergebnisses, bin ich mir nicht ob die Daten richtig interpretiert werden. Das m15 R1 hat ein PL1 von 75w und PL2 von 90w. 86w ist möglich, jedoch nur 30 Sekunden (Intel TAU). Wie sehen deine Temps und Stromwerte aus, wenn du beispielsweise ne halbe Stunde zockst? Ein HWinfo Screenshot wäre da sehr hilfreich. Das kleine Bild von XTU sag recht wenig aus. edit, ok du betreibst scheinbar dein System über'n AGA. -

Vielen Dank für deinen (wie immer) detaillierten Bericht zu den Settings und Optimierungen. Schon interessant, dass die Kühlleistung des Kühlers beim Area 51m so stark vom eingestellten Setting abhängt. Das macht den U3-Kühler für den Area 51m umso interessanter. Denn dadurch kann man das Notebook, angesichts der Leistung, immer noch super leise betreiben. 1.900/1.900 rpm ist ja weniger als die Hälfte und ich fand das Area 51m eigentlich schon so sehr leise unter Last. Gut, ich bin auch andere Notebooks gewohnt 😄, weiß jedoch ein leises System sehr zu schätzen. Am Desktop-PC finde ich das immer sehr angenehm. Man ist am zocken und hört so gut wie gar nichts vom System.

-

ahh.. jetzt hat's mich erwischt 😅 sorry.

-

Stephen hat ein neues Video zu Dynamic Boost und Resizable Bar online gestellt. Und mal wieder zeigt sich, dass Leistung sich immer noch über Power definiert. Keine Ahnung, ob zukünftige Treiber hier noch was großartig reißen können. -Video-

-

Alienware m17 R3 4K 60hz vs FHD 144hz

Sk0b0ld antwortete auf Nilhilist's Thema in Kauftipps & Entscheidungshilfen

Irgendwo lässt sich jede Größe, jedes Display und jede Ausstattung begründen. Ich war immer ein Verfechter von 17" Notebooks und schnellen Displays mit G-Sync. Seit dem AW17 R4 wollte ich nicht mehr auf QHD verzichten und wenn die Leistung stimmt, macht dieses Display wirklich Spaß. Dumm nur, wenn so ein Display nicht mehr zur Auswahl steht. Wieso man UHD bei einem Notebook nimmt, war mir zu dem Zeitpunkt irgendwie immer ein Rätsel. Bis ich so ein Display mal live gesehen habe. Wenn Zocken nicht die Haupttätigkeit ist, kann UHD aber durchaus Sinn machen und mit 500nits ist es zudem meist deutlich heller. Die Farbwiedergabe ist auch oftmals besser. Seit dem flachen m15 R1, muss ich aber zugeben, dass solch mobile Geräte auch ihre Vorzüge haben. In meinem Fall liegt das aber größtenteils daran, dass ich jederzeit auf'n Desktop-System zocken kann. Aus heutiger Sicht würde ich eher zu 15"ern mit ordentlich Leistung und OLED Display greifen. Bei den 17"ern gibt's das leider nicht. Gerade das OLED Display ist so krass anders als jedes andere NB-Display. Ist echt ein Unterschied wie Tag und Nacht. Wenn ich mal zocke, sind das eher Single-Player wie AC Valhalla, FarCry, Ghost Recon, SOTTR usw. Die Online-Shooter wie PUBG, Apex usw. sind für mich als Gelegenheitsspieler nichts (mehr). Daher genieße ich lieber Ton, Grafik und Bild, wo nicht jede FPS entscheidend ist und gerade auf'm OLED Display sind die Farben richtig schön knackig. Optional als ergänzende Lösung könnte man sich ein gescheiten IPS Gaming-Monitor holen, der sowieso alle mal besser ist als jedes gängige Notebook Display und dann darauf zocken solange man das Notebook stationär betreibt. Anschlüsse und ausreichend Leistung bieten die Notebooks ja. So könnte man auf dem NB-Display schön HWinfo laufen lassen und auf der Gaming-Monitor zocken. Ich kann aber auch genauso gut Leute verstehen, die das perfekte Gesamtpaket in einem Gerät haben wollen und nicht auf irgendwelche externe Lösungen zurückgreifen möchten. Zumindest schadet es nicht, mal über alle Aspekte im Vorfeld zu sprechen, bevor man so eine große Summe Geld investiert. -

Alienware m17 R3 4K 60hz vs FHD 144hz

Sk0b0ld antwortete auf Nilhilist's Thema in Kauftipps & Entscheidungshilfen

Das hängt immer so ein bisschen von den persönlichen Bedürfnissen ab. Wenn's beim 15"er bleibt, definitiv beim OLED Panel. Das wird dir jeder bestätigen, der das Panel schon mal live gesehen hat oder besitzt @pitha1337. Dieses Panel gibt's jedoch nur mit 60Hz (aber immerhin 1ms) und in 4K. QHD Auflösung sollte aber dennoch gut aussehen. In Kombination mit einer 3080 macht dieses Panel aus meiner Sicht am meisten Sinn. Bei einer 3080 und FHD Auflösung kann man schnell im CPU-Limit sitzen und nicht das volle Potenzial der GPU nutzen. Hinzu kommt, dass durch die geringere Auflösung in FHD, die Last auf CPU höher ist und man evtl. Dynamic Boost nicht nutzen kann. Bei den 17" Modelle ist dagegen das FHD Panel die einzige vernünftige Entscheidung, weil der UHD Panel dort kein OLED ist und mit 25ms nicht besonders schnell. Grundsätzlich sehe ich das auch so, konnte jedoch keinen Unterschied beim m15 R1 mit'm 144Hz Panel feststellen. Lief trotz fehlenden G-Sync butterweich ohne Schmieren oder Tearing. FHD 60Hz Panel sah dagegen schon ganz anders aus. -

Eluktronics haben ihr Lineup aktualisiert. Wohoo, auch Max-P Grafikkarten gibt's wieder. Max-Q GPUs gibt's bei XMG. Immerhin mit TDP-Angabe, aber irgendwie macht's jeder wie er will.

-

Wenn der i9 zum i7 nicht mehr Kerne bietet, kann man sich den bei den dünnen Geräten sparen. Bei meinem m15 R1 damals war der 8950HK zu dem 8750H nicht frei übertaktbar. Im BIOS gab es keine Performance-Settings und bei TS war alles ausgegraut. Der einzige Unterschied waren die 300Mhz all Core Takt mehr (39x --> 42x) und ein 3w höheres PL.

-

Major Hardware hat heute auch ein Video zum Duo hochgeladen. Ist zwar das alte Modell mit 2070MQ, fand das Video aber dennoch ganz gut, weil er gut erklärt wie das Notebook so in der praxis. Mittlerweile muss ich wirklich zugeben, dass ich das Notebook auch sehr interessant finde. So'n HWinfo-Screen unten im kleinen Display wäre schon was feines. https://www.youtube.com/watch?v=veNWCkld5fU

-

AW17 R4 & R5 sind da ehrlich gesagt schlimmer. AW hat diese Frage schon zum Teil in meinem neulich geposteten Reddit-Link im Interview beantwortet. So eine Änderung, die derart viele Geräte betreffen würde, hat enorme Auswirkungen auf den Herstellungs- und Fertigungsprozess. Um das zu bewerkstelligen, müsste man Fertigungsstraßen ändern, neue Zulieferer ins Boot holen, Arbeitsabläufe anpassen usw. Dell könnte das sicherlich umsetzen, denn schließlich gehören sie mit zu den größten Tech-Giganten, jedoch hat der Konzern mehrfach in der Vergangenheit (Stichwort: XMP bei Area 51m R2, Downgrade-Sperre durch Gsync etc.) und auch vor kurzem (TCC "Feature") gezeigt, das sich das mit Software-Tricks deutlich eleganter und gewinnbringender lösen lässt. Dell ist eben kein ASUS und dementsprechend liegen die Prioritäten woanders. Also die Kombination i9 + 2080 hat definitiv die VC-Heatsink gehabt, jedoch nur CPU-seitig (glaub ich). Die Kombination i7 + 2080 hatte soweit ich weiß auch die VC-Heatsink. Alles da drunter hatte die "normale" HS. Jetzt haben sie halt die etwas schwächere HS aus'm Portfolio geschmissen und bauen nur die etwas "bessere" Heatsink in die Geräte ein. Mir stellt sich die Frage, warum AW das nicht schon vorher so gemacht hat. Kann ja nur ein Kostenpunkt sein.... Das haben sie auch schon beim AW17 R4 gemacht. Dort habe ich die HS nachträglich auf die größere umgebaut. edit, Bezüglich m17 R4, ich habe mir noch mal die Heatsink vom m17 R3 genau angeschaut, weil ich mir nicht sicher war. Ich sehe keinen Fillport bei der GPU. Daher vermute ich, dass die VC nur bei der CPU bleiben wird. Das, was dort so hervorsteht, ist bloß ein Plastikcover zum Schutz der aufgetragenen WLP.

-

Biete

Alienware Area 51m Darksie of the Moon Notebook mit Garantie inkl. Vindicator 18" Rucksack *PREIS-UPDATE*

Biete

Alienware Area 51m Darksie of the Moon Notebook mit Garantie inkl. Vindicator 18" Rucksack *PREIS-UPDATE*

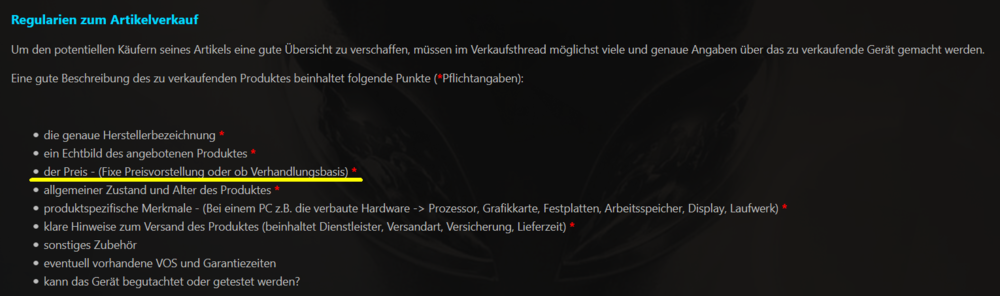

Sk0b0ld antwortete auf shadowlord's Thema in Marktplatz

Der Preis wäre nicht nur interessant, sondern gehört auch zu den Pflichtangaben, wenn man hier im Marktplatz was verkaufen will. Deshalb verweise ich auf unsere Marktplatzregeln und bitte dich @shadowlord einen Preis/ VHB zeitnah einzutragen. Andernfalls wird die Anzeige gelöscht.