Rangliste

Beliebte Inhalte

Inhalte mit der höchsten Reputation seit 05.02.2025 in allen Bereichen anzeigen

-

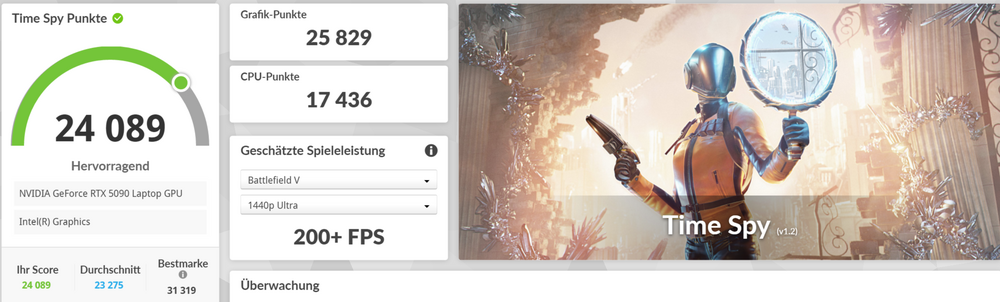

Hallo zusammen, wie versprochen, hier meine ersten Eindrücke zum neuen Alienware Area-51 16. Da ich auch das aktuelle Razer Blade 16 hier habe, bot sich ein direkter Vergleich natürlich an (mit dem Disclaimer, dass es natürlich unterschiedliche Gewichtsklassen sind...). Haptik, Design & Verarbeitung: Der Monolith Das Alienware ist "built like a tank". Die Verarbeitung ist überragend, die Materialien fühlen sich absolut hochwertig an, und es gibt bisher nichts, was knarzt oder nachgibt. Interessanterweise fühlt es sich beim Tragen leichter an, als sein Gewicht vermuten lässt – beim HP Omen war das bei mir genau umgekehrt. Trotz seiner Masse hatte ich mehr "Wucht" erwartet, das Gewicht ist im Alltag also weniger schlimm als befürchtet. Durch die Masse wirkt es auch minimal wertiger, als das Blade, wobei beide auf einem sehr hohem Niveau sind. Beim Design hebt sich Alienware meiner Meinung nach positiv vom Einheitsbrei ab. Der leichte Schimmer auf dem Gehäuse und der grüne Touch des Alu-Chassis wirken fast schon mysteriös und deutlich "erwachsener" als bei manch anderem Gaming-Boliden (einige RGB-Lösungen bei der Konkurrenz sind mMn einfach uninspiriert und draufgeklatscht). Dagegen ist das Blade sehr dezent und fast schon langweilig – was man hier bevorzugt, ist natürlich reine Ansichtssache. Für mich hat das Alienware damit nur etwas mehr Charakter. Mit dem Glas unterm Laptop kann ich nichts anfangen Der einzige positive Punkt für mich hier ist, dass ich hier ein besseres Gefühl habe, den Laptop aufm Schoß zu haben. Normal – und auch so beim Blade – sind exakt an den Stellen die Lüfter-Intakes. Beim Alienware ist es hinterm Glas und oben unterm Display. Exhaust seitlich und hinten. Ein ergonomischer Vorteil für das Alienware sind die abgerundeten Kanten, die eine super angenehme Handballenauflage schaffen. Beim Blade ist das zwar auch gut, aber hier hilft vor allem die geringere Gehäusetiefe. Grundsätzlich finde ich es gut, dass es Ports auch hinten gibt, nur ist es im mobilen Einsatz unbequemer, wenn man nicht mal eben schnell seitlich was einstecken kann. Hier finde ich, dass das XMG Neo 16 2025 die beste Lösung von allen hat, weil es beides abdeckt. Weiterer Punkt, den man wissen sollte: Das Ding ist sehr groß für 16". Durch das "Thermal Shelf" (der Überhang hinten) ist es sehr tief und braucht mehr Platz als normal auf dem Schreibtisch. Mobilität ist hier definitiv Nebensache. Das Blade ist und bleibt einfach mobiler. Tastatur & Touchpad: Licht und Schatten Tastatur: Hier hat Alienware für mich leicht die Nase vorn. Der Hub ist super, das Tippgefühl ist zwar etwas "mushy" (weich), aber ich kann darauf extrem schnell und fehlerfrei schreiben. Sie wirkt insgesamt einen Ticken stabiler als die im Blade. Die Beleuchtung ist bei beiden top. Touchpad: Kleiner Vorteil für das Blade. Beide haben fantastische Gleiteigenschaften, aber der Klick des Alienware ist leider blechern und fühlt sich billig an, weshalb ich hier fast nur noch "Tap-to-Click" nutze. Dazu kommt, dass es für heutige Verhältnisse fast schon zu klein ist. Das Touchpad des Blade ist dagegen eine andere Liga: satter, leiser und haptisch hochwertig. Zwar löse ich beim Blade trotzdem öfter mal versehentlich Klicks aus, was nervig ist- und damit Vorteil Alienware, wo das nicht passiert - aber unterm Strich gewinnt es für mich dennoch. Ich liebe aber das RGB auf dem Touchpad 😉 Ein QoL-Sieg für das Blade ist auch die Software-Integration: Per FN-Taste leuchten nur die Sonderfunktionen auf, und per Shortcut kann man bequem durch alle Performance-Modi wechseln. Bei Alienware sind die Makrotasten umständlicher und wenig vielseitig zu belegen, zudem gibt es nur einen Shortcut für den "Overdrive"-Modus (der mit fast 60 dB an einen Düsenjet erinnert). Software ist auch die Achillesferse des Alienware... Hier muss Alienware dringend nachbessern. Das Command Center ist und bleibt eine Baustelle: Es lädt oft nicht korrekt, setzt Einstellungen willkürlich zurück und erzeugt manchmal hohe Systemlast. Razers Synapse ist hier einfach voraus, u.a. durch automatischen Wechsel auf 60 Hz im Akkubetrieb, einfaches Undervolting und die Auswahl von Farbprofilen – es ist durchdachter und ressourcensparender. Synapse ist jetzt auch nicht gerade der König auf dem Markt und hat Probleme, aber AWCC ist für mich der letzte Platz unter den namhaften Notebook-Hersteller. Lautstärke, Kühlung & Akku: Die große Enttäuschung Lautstärke: Unter Volllast sind beide laut und man sollte Kopfhörer aufhaben. Im "Balanced"-Modus hat das Alienware aber einen Vorteil: Mit 155W TGP ist es kaum schlechter, aber spürbar leiser, während das Blade diese Leistung nur im lauteren "Performance"-Modus erreicht. Balanced ist beim Blade auch angenehmer, aber hier gibt es dann der Thin&Light-Kategorie geschuldet nur noch bis maximal 125W. Trotzdem beachtlich für die Größe und das Gewicht. Für viele wird es auch aktuell kaum ein Unterschied beim Spielen ausmachen. Akku: Reden wir nicht lange drumherum: Das Blade gewinnt hier mit riesigem Abstand. Temperaturempfinden & Kühlung: Hier wird es kompliziert und für mich zur kleinen Enttäuschung beim Alienware, weil aufgrund des Gewicht und der Stellfläche die mit Abstand beste Kühlung erwartet hätte (über 3,3kg!). Das Alienware wird bei oberflächlichen Tests besser abschneiden, nur liegt hier der Teufel im Detail. Zwar hat das Blade extreme Hotspots (oberhalb der Tastatur und am Boden verbrennt man sich fast die Finger), im Alltag fühlt es sich aber trotzdem teils angenehmer an. Warum? Die Tastatur des Blade bleibt minimal kühler, weil hier u.a. die Intake-Kühler durch die Tastatur dazu beitragen. Es sind aber beide in dem Bereich ganz gut. Allerdings: Das Blade bläst keine heiße Luft auf die rechte Seite – als Maus-Nutzer ist das beim Alienware extrem nervig. Die Kühlung des Intel-Chips im Alienware und die Abstimmung des Systems sind fragwürdig. Selbst bei simplen Steam-Downloads springt die CPU auf fast 100 °C. Es dauert auch merklich länger, bis das Gerät wieder abkühlt. In Spielen ist es wiederum in Ordnung, es gibt oft nur einen kurzen Temperatur-Spike auf bis zu 105 °C (und das kann ja auch in der Software nach unten begrenzen), bevor es sich unter 90 °C einpendelt, aber das Verhalten bei Alltagsaufgaben ist einfach nicht gut gelöst. Im Idle ist es auch oft warm, weil die CPU oft bei über 60 Grad ist. Beim Blade ist die CPU nicht so potent und zeigt allgemein weniger Watt, jedoch merkt man es einfach, wenn es im Durchschnitt 15 Grad weniger sind. Möglicherweise liegt hier die Schwachstelle im Kühlkonzept: Die rückseitigen Ports limitieren die verfügbare Fläche für die Lüfterauslässe. Lenovo geht hier beim Legion bewusst den umgekehrten Weg und priorisiert die Kühlung über die Anordnung der Ports... Das ergibt Sinn, wenn Alienware davon ausgeht, dass das AW viel häufiger als Desktop Replacement eingesetzt wird. Dann sind die Ports hinten wichtiger, als eine bessere Oberflächenkühlung z.B. Die GPU-Kühlung ist im Alienware dafür erste Klasse. Die Wattzahlen und Taktraten sind sehr stabil. Beim relativen Max-TGP der beiden Geräte, liegt das Alienware gut 5 Grad niedriger. Display & Lautsprecher: Eine Frage der Priorität Lautsprecher: Die Speaker im Area-51 16 sind ein klarer Rückschritt zum Vorgänger (X16 R2). Die des Blade sind zwar leiser, klingen aber viel klarer, haben mehr Tiefe und eine bessere Ton-Trennung. Die Blade-Lautsprecher würde ich auch schon eher als Durchschnitt bezeichnen.... Display: Das IPS-Panel des Alienware ist gut, keine Frage, und sogar etwas heller. Sobald man aber Spiele wie Dune oder Alan Wake 2 startet, ist der Unterschied bei Schwarzwerten und Kontrast zum OLED des Blade signifikant. Dafür hat das matte Display des Alienware bei Lichteinfall Vorteile, da es weniger reflektiert. Beim Glossy-Screen des Blade sieht man dann gerne mal sich selbst, auch wenn die Farben dafür noch einen Tick kräftiger wirken. Ein persönliches Plus für das Alienware: Das Display ist etwas höher gebaut, was ich ergonomischer finde. Andere werden sich aber möglicherweise an den Bezels stören 😉 Noch ein IPS-Nachteil: Die höhere Helligkeit erkauft man sich dann auf höchster Helligkeitsstufe wieder mit stärker in Erscheinung tretenden Lichthöfen/schwächerem Kontrast. Kurzer Performance-Check (muss hier noch mehr testen) Alienware Area-51 16: Core Ultra 275HX, RTX 5080 - habe ich für 3.5k Euro vergünstigt bekommen. Razer Blade 16: AMD "HX 370", RTX 5090 - ebenfalls 15% Rabatt und damit bei 4.1k Euro. Time Spy Benchmark: Alienware: Overdrive-Modus mit werksseitigem OC: CPU ~16.900 | GPU ~22.600 Performance-Modus (leiser): CPU ~16.200 | GPU ~22.000 Razer Blade (Performance-Modus ohne OC) CPU ~10.000 | GPU ~22.500 (mit Cooling Pad sind über 24k drin) Fazit zur Performance: In Spielen nehmen sie sich oft nicht viel. Bei CPU-lastigen Titeln hat das Alienware dank der besseren 1%-Lows einen stabileren Eindruck hinterlassen. Sobald die reine GPU-Last (z.B. in 4K) dominiert, zieht die 5090 im Blade leicht davon. Und damit das Blade mit dem 5080-Alienware mitkommt, braucht es eine 5090 und ist damit natürlich teurer. Mein erstes Fazit Puh, keine leichte Entscheidung, denn es sind zwei fundamental unterschiedliche Ansätze für ein High-End-Notebook. Aber nach den ersten Tagen ist meine Tendenz. Ich bleibe wohl beim Blade. Hier die Zusammenfassung, warum: Was für das Alienware Area-51 16 spricht: ✅ Einzigartiges, mutiges Design; kreativer RGB-Einsatz ✅ Absolute Top-Verarbeitung, Ergonomie und Stabilität ✅ Geniales Tippgefühl auf der Tastatur ✅ Guter Balanced-Modus, der hohe Leistung bei moderater Lautstärke ermöglicht ✅ Stärkere CPU-Leistung und bessere 1%-Lows in CPU-lastigen Spielen. Außerdem standhafte GPU-Werte am Maximum. Spielerfahrung stabiler. ✅ Mattes Display, das bei Lichteinfall Vorteile hat; höhere Helligkeit ✅ Hotspots nicht übertrieben heiß, sondern höchstens warm Was für das Razer Blade 16 spricht: ✅ Deutlich mobiler und kompakter - dafür von der Leistung beachtlich ✅ Ebenfalls tolle Verarbeitung ✅ Tolles OLED-Display (Farben, Kontrast) ✅ Bessere und klarere Lautsprecher ✅ Ausgereiftere, durchdachte und leichtere Software ✅ Angenehmeres Kühlungs-Empfinden im Alltag (trotz extremer Hotspots) ✅ Weit überlegene Akkulaufzeit ✅ Bessere Gesamterfahrung beim Touchpad Das fragwürdige Temperaturmanagement bei Alltagsaufgaben, das IPS-Display und die unausgereifte Software sind für mich beim Alienware aktuell die größten Dealbreaker.9 Punkte

-

Wo genau nicht? Anspielung/ Verdeutlichung was man aktuell für's Geld bekommt im mobilen Gaming-Segment. Leistungszuwachs für eine "neue" Generation ist halt schwach/ enttäuschend, gerade im Hinblick auf die Preise. In der Vergangenheit war es oftmals so, dass eine neue Mobile-Generation die alte Desktop-Generation geschlagen hat. Beispiel Time Spy Graphics (oberen 10% inkl. OC, wo Desktop GPUs sogar im Vorteil sind): - 1080 Desktop: 9.500 vs. 2080 Mobile: 12.000 - 3080 Desktop: 20.800 vs. 4090 Mobile: 25.500 (xx90 GPU = xx80er Chip) Da ich beides besitze, mit beidem viel Zeit in 3D Mark verbringe, zieht man natürlich auch den Vergleich. Hat auch nichts mit Äpfeln und Birnen zu tun. Der Leistungssprung für eine "neue Gen" (so vermarktet und bepreist es Nvidia) ist enttäuschend, sowohl im Mobile als auch im Desktop (Desktop 4090/ 5090 jetzt mal außen vor). Wobei im Desktop-Bereich die GPU-Preise teilweise ein normales Niveau erreicht haben. Joa... schaut man in die Vergangenheit, wo die Notebook-Leistung noch grob stimmte, vergleicht man gerne Obst 😎 und erinnert man sich an die glorreichen Zeiten des Area 51m mit 9900K und 2080m zurück, konnte man das Wort "Desktop Replacement" in Bezug auf Leistung noch wirklich ernst nehmen.6 Punkte

-

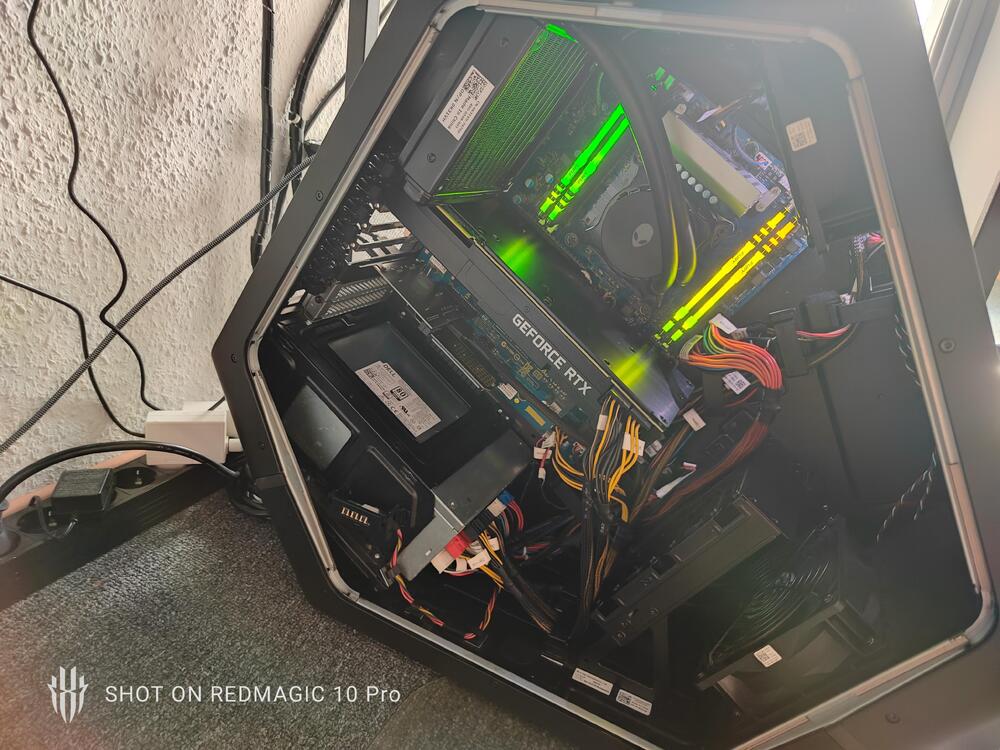

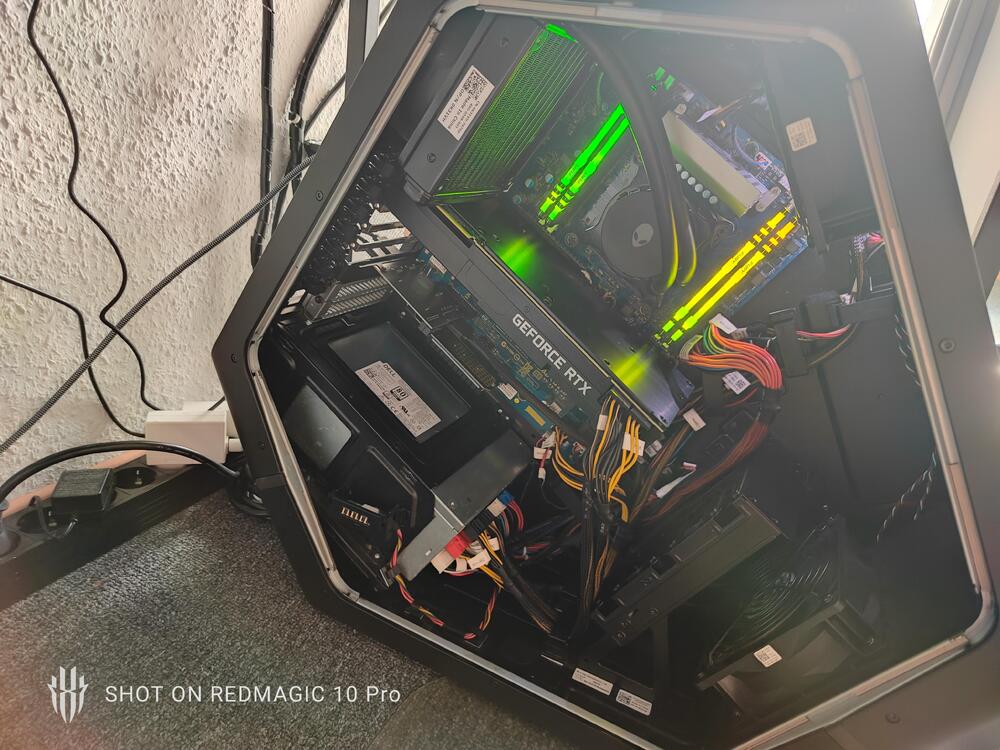

Moin, Bis 30cm länge und Dualslot Design sollte alles problemlos funktionieren. Ich habe den R14 und die sind ja ähnlich. Serie hat meiner 2x 8 Pin. Mit evtl. und falls erforderlich, Adaptern sollte das aber kein Problem sein mit Stromversorgung und Kühlung auch. In meinem habe ich eine 3080ti von Kfa2 verbaut, die hat sogar Triple Slot, ein echter Brocken, auch länger als 30cm. Musste dafür allerdings dann den Luftleitkasten mit Kneifzange und Dremel etwas bearbeiten. Trotz der enge ist mit den Temperaturen noch alles im grünen Bereich. Sieht dann so aus s.Bilder Gruß5 Punkte

-

Hallo zusammen, wie würdet ihr bei einer Windows 11 Neuinstallation vorgehen. Hier meine Vorgehensweise bei einem Alienware 18 Area-51 (noch nicht durchgeführt, nur zur Information): 1. Mit dem Media Creation Tool von Microsoft einen Windows 11 USB Stick erstellen. 2. Von der Dell Support Seite alle Treiber und das Alienware Command Center für das Alienware 18 Area-51 herunterladen und ebenfalls auf einen USB Stick sichern, bis auf die 3 folgende: - NVDIA Grafikkartentreiber direkt von der NVIDIA Seite - Intel Killer Performance Suite (LAN und WLAN) direkt von der Intel Seite - Intel Bluetooth Treiber direkt von der Intel Seite Mache ich immer so, weil aktueller und LAN und WLAN Treiber in einem Paket enthalten sind. 3. Beim Start des Laptops mit der Taste F2 das Bios öffnen und unter "Storage" von RAID auf AHCI eintellen, damit Windows 11 problemlos und ohne das einbinden weiterer Treiber installiert werden kann. Achtung: Durch Veränderung dieser Einstellung, ist die Windows Installation unbrauchbar, das heißt eine Windows Neuinstallation ist danach zwingend notwendig. 4. Beim Start des Laptops mit der Taste F12 das Bootmenü öffnen und vom USB Stick booten. 5. Dem Installationsassistenten folgen und bei der Auswahl der Partitionen, alle löschen. 6. "Nicht zugewiesener Speicherplatz" auswählen und die Installation starten (Partitionen werden automatisch erstellt). 7. Sobald der Ersteinrichtungsassistent startet, die Taste F10 drücken und im sich öffnenten Fenster folgendes eingeben: OOBE\BYPASSNRO und mit Enter bestätigen. Dadurch ist es möglich, Windows 11 mit einem lokalen Windows Benutzerkonto einzurichten, anstatt mit einem Microsoft Konto. Ich persönlich bevorzuge ein lokales Windows Benutzerkonto. 8. Nach erneutem Start des Ersteinrichtungsassistenten, diesem folgen. Sobald gefragt wird nach dem Internet, einfach folgendes auswählen: "Ich habe kein Internet" Dies wird erst durch die oben beschriebene Maßnahme unter Punkt 7 zur Auswahl angeboten. 9. Nach dem man sich durch Ersteinrichtungsassistenten durchgearbeitet hat, startet das erste mal Windows 11 und man befindet sich auf dem Desktop. 10. Als nächstes offline also ohne bestehende Internetverbindung, alle Treiber und das Alienware Command Center installieren. Zum Thema Treiberreihenfolge, werde ich mich zu einem späteren Zeitpunkt äußern, um nicht den Rahmen zu sprengen. 11. Bevor man online geht, in den Windows 11 Gruppenrichtlinien (nur in Windows 11 Pro enthalten) einstellen, das über Windows Update keine Gerätetreiber installiert bzw. aktualisiert werden. Dadurch wird auch das BIOS nicht automatisch über Windows Update aktualisiert. Kurz eine Erklärung wie man dies einstellt: Öffnen Sie den Gruppenrichtlinien-Editor ( gpedit.msc ), navigieren Sie zu Computerkonfiguration > Administrative Vorlagen > Windows-Komponenten > Windows Update > Vom Windows Update angebotene Updates verwalten und aktivieren Sie die Richtlinie Keine Treiber in Windows Updates einschließen. Danch Windows neustarten. 12. Online gehen und Windows Updates usw. installieren, so wie man sein System haben möchte. Was haltet ihr von dieser sehr detaillierten von mir beschriebenen und selbst erarbeiteten Vorgehensweise, zur Neuinstallation von Windows 11, mit allen Treiber und dem Alienware Command Center, inklusive eines lokalen Windows Benutzerkontos? Vielleicht konnte ich auch einigen helfen? Diese Anleitung lässt sich auch problemlos auf andere Alienware Laptops übertragen, wie bspw. dem Alienware m18 R1 oder dem Alienware m18 R2, um nur zwei Beispiele zu nennen. Auch weitere sollten möglich sein. Bin gespannt auf eure Meinung!!!4 Punkte

-

Was ich vergessen habe zu erwähnen, den "Intel Rapid Storage Technology" Treiber habe ich bewusst nicht in die Liste mit aufgenommen, weil durch die Umstellung im BIOS von RAID auf AHCI dieser nicht mehr notwendig ist. @der allgäuer Natürlich hast du recht, eine Windows Neuinstallation ist keine Raketenwissenschaft und so wie du es machst oder machen würdest, ist auch eine Option die sicherlich funktioniert. Aber ich bevorzuge eine Windows Installation die so sauber wie möglich ist, ohne irgendwelche extra Tools oder Programme, da bin ich etwas eigen. Auch ich mache das schon seit vielen Jahren so und noch nie irgendwelche Probleme gehabt. Aber im Endeffekt stellt sich heraus, das beide Methoden sehr gut funktionieren. Mein Ziel ist es auch Leute die ihr Alienware Laptop/Notebook komplett neu aufsetzen wollen, einen Hilfeansatz bzw. eine Komplettlösung zu geben, wie dies in der Praxis umzusetzen ist. Daher gibt es jetzt schon zwei Lösungen, die funktionieren, was ich sehr gut finde. Ich würde ich sagen, weiter so!!!4 Punkte

-

Wie versprochen füge ich nachträglich die Treiberreihenfolge hinzu, so wie es meiner Meinung nach am sinnvollsten ist. Ich denke, gerade in diesem Teil der Windows Neuinstallation, gibt es viele verschiedene Meinungen, welche Treiber und vorallem welche Reihenfolge die richtige oder bessere ist? Treiber: 1. Intel Chipset 2. Intel Management Engine 3. Intel Integrated Sensor Solution 4. Intel Innovation Platform Framework 5. Intel PPM Provisioning Package 6. Intel Dynamic Tuning 7. Intel AI Boost 8. Intel Platform Monitoring Technology 9. Intel HID Event Filter 10. Intel Serial IO 11. Killer LAN und WLAN 12. Killer Bluetooth 13. Intel Graphics 14. NVIDIA Graphics 15. Realtek High Definition Audio 16. Realtek Memory Card Reader 17. Dolby Vision 18. Windows Studio Effects Programme: 1. Alienware Command Center4 Punkte

-

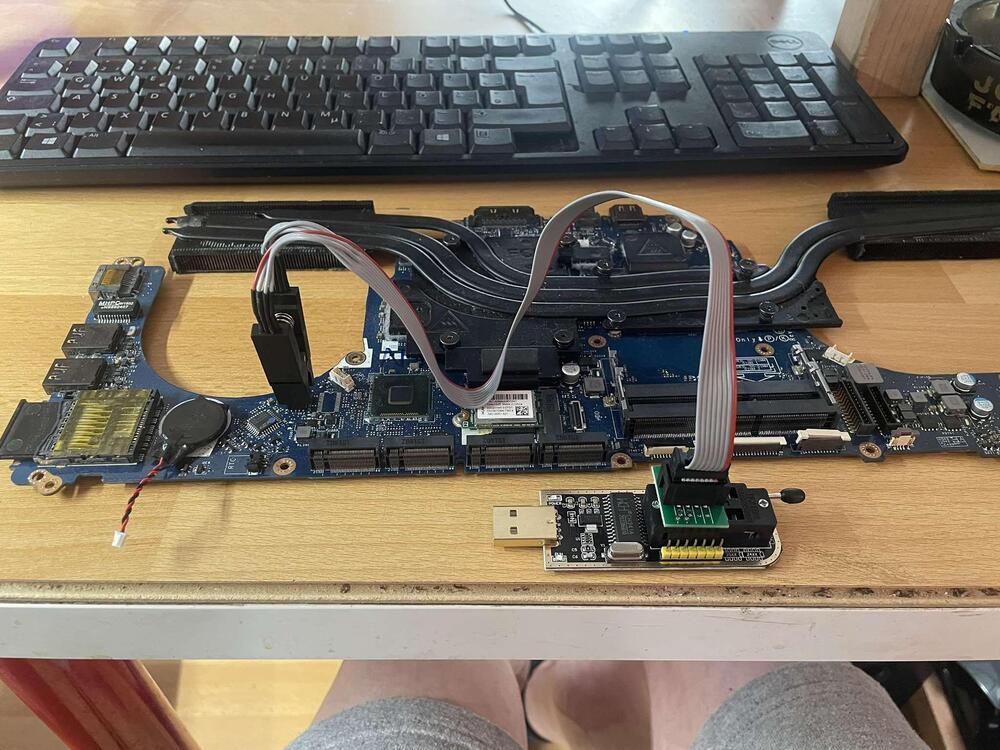

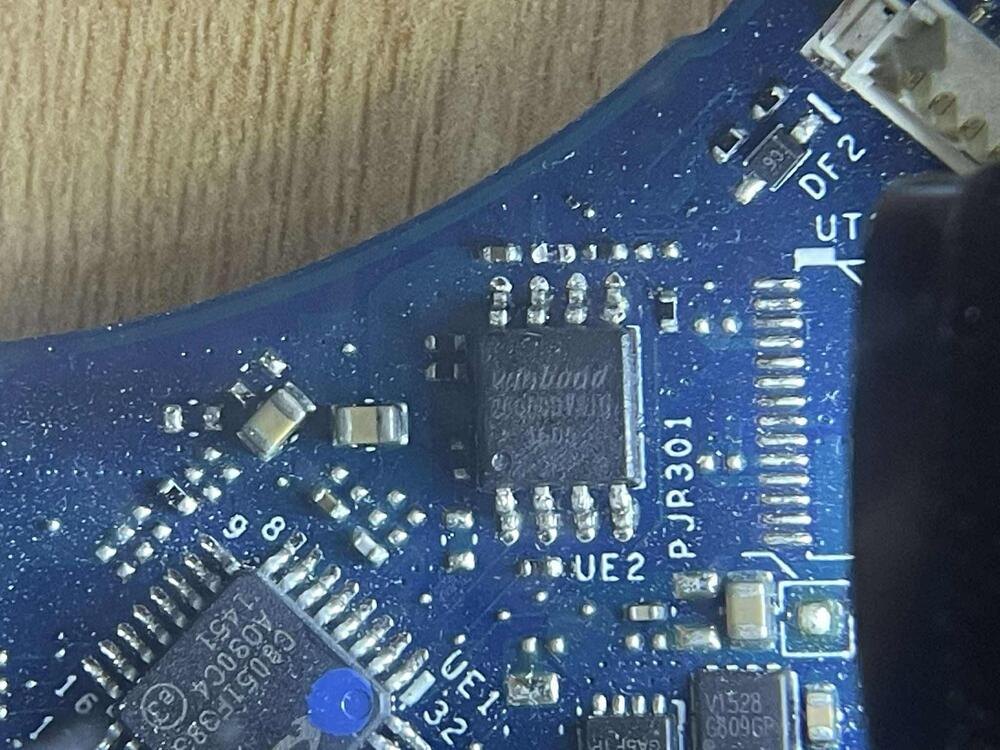

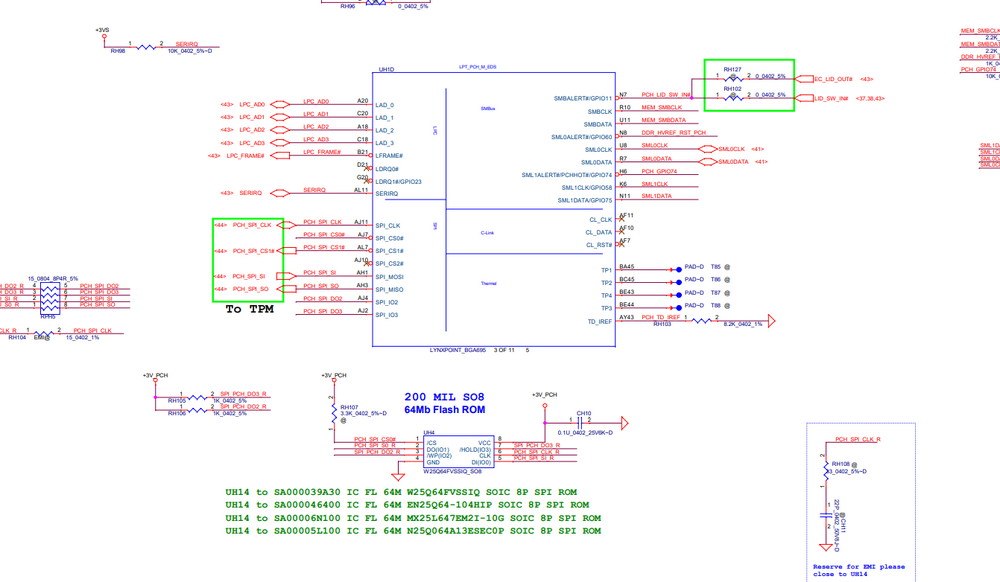

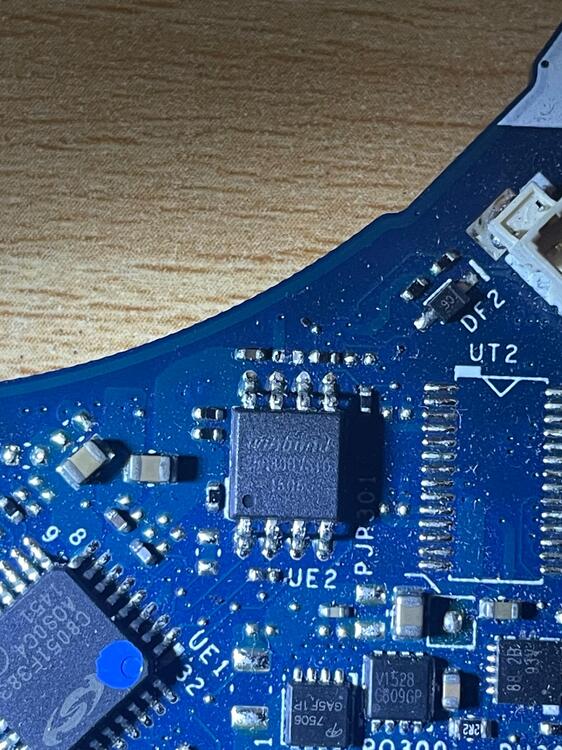

So melde mich Hier mal mit einem kurzem Update : 😁. ### Folgendes ist bisher geschehen --> Identifikation der beiden Bios Chips . Einmal ein Windbond W25@80DVSIG für das EC-Bios Einmal ein Gigadevice GD25B64BSIG für das eigentliche Bios . Es hat ewig gedauert die beiden zu identifizieren da die Beschriftung auf den Chips sehr schwer lesbar sind . Anmerken möchte ich hierbei noch das es anscheinend verschiedene Chips auf dem Mainboard ( LA-B753P ) gibt . Im Anhang ein Schema des Boards . So nachdem ich dies nun erledigt hatte und mir für beide Bios Chips die passende Firmware geladen habe folgte das nächste Problem Die Klemmen des CH341a - Programmer´s ( SOIC8-IC-Clip ) sind recht billig verarbeitet und hatten schlechten Kontakt mit dem Chip - worauf die Software ( ASProgrammer - Neoprogrammer ) immer Fehler angezeigt haben 😮 Nun gut - 2 neue Clips bestellt und weitergehts Das EC Bios konnte ich bisher ( scheinbar ) erfolgreich flashen Nur der GD25B64BSIG - eigentliches Bios - wird in der Liste nicht aufgeführt und ich muss wahrscheinlich einen anderen Typ wählen -- Zeitaufwendig 😮 Ich bleibe jedenfalls am Ball , da ich keinen Zeitdruck verspüre Anhang : Schemata des Mainboards als PDF Einige Fotos Wünsche Euch noch einen schönen Abend Dell Alienware 17 LA-B753P Rev0.1(X00).pdf4 Punkte

-

Erstmal fertig für heute 🥴😴 Benchmarks bestanden, allerdings braucht die Graka wohl neue WLP und Pad's. 90 Grad Peak und sonst 87 Grad sind mir zuviel. Ist ne Gigabyte RTX 2080 Super. Ach und n bischen OC muss auch noch drin sein am System 👋😏 Jetzt aber erstmal Feierabend. Huch das eine Foto etwas verwischt 🙈4 Punkte

-

Mannomann, du kommst aber für einen Neuling,(ist per se sehr willkommen und nicht abwertend gemeint), aber sehr forsch hier um die Ecke. Warum User Nuestra hier angemeldet ist, dürfte Anhand seiner Beiträge , Gerätepark und Zeit die er hier angemeldet ist ja wohl klar sein. Wenn man Mitglied in einem, sagen wir mal, Markenbezogenen Forum wie dieses hier eines ist, ist es durchaus berechtigt eben auch die Produkte dieser Marke zu kritisieren und auch mal über den Tellerrand zu schauen was z.B. andere Hersteller im Vergleich zu bieten haben oder besser/schlechter machen usw. Auch Eigenbau o.ä. hat hier seinen Platz und das ist auch gut so. Mich beschleicht das Gefühl du fühlst dich irgendwie provoziert oder auf den Schlips getreten das dein Intel in manchen Bereichen nun mal langsamer ist und das ist ein Fakt. Freu dich doch das er für dich so klasse Performt und du zufrieden bist, aber jetzt mit kopierten Texten von KI/Chatgpt usw. und unbelegbaren Bildern zu kommen ist ein wenig albern und lächerlich finde ich persönlich zumindest. Es belegt und beweist hier gar nichts. Als Spieler und AW richtet sich immer noch an sie, würde ich auch zu AMD greifen mittlerweile schon länger, wenn möglich. Das war nicht immer so, aber diese Systeme sind im Gaming nun mal performanter geworden die letzten Jahre und das ist auch klar belegbar. Mir gefällt der neue Area 51 auch sehr gut, dennoch ist er deutlich überteuert wie (fast) immer bei AW und co. und halt immer noch OEM. Auch wenn AW sich jetzt endlich mal langsam öffnet Richtung aufrüsten mit Produkten von Drittherstellern und nun gewisse Standards einhält. Alle Desktops davor, nicht die legacy Geräte !, waren allesamt eine mittlere bis schwere Katastrophe (Games Nexus usw. belegen dies recht anschaulich). Ich kann es auch aus eigener Erfahrung sagen, mein Aurora R14 ist in allen Bereichen langsamer und schlechter gekühlt, lauter als ein Eigenbau mit den selben Komponenten. Das Dell/AW eigendesign MB ist der hauptsächlich limitierende Faktor. Dennoch habe ich mich für dieses Gerät entschieden, aber auch nur weil ich es gebraucht günstig bekommen habe und mir das Design gefällt. Zudem bin ich AW Fanboy, der aber auch nicht jeden Tanz von Dell/AW mitmacht und manche Dinge durchaus kritisch sehe und auch belegbare Kritik gelten lasse, trotz Fanstatus. Es empfiehlt sich Userprofile anzuschauen, bevor man jemanden Fragen wie deine stellt. Also lass es gut sein , erfreue dich an deinem Area51 und akzeptiere andere Meinungen und belegbare Fakten und nun Feuer frei! 😉 🙈3 Punkte

-

ich Möchte mich nochmal herzlich bedanken. es scheint nun alles in ordnung zu sein. liebe Grüße3 Punkte

-

Dem Vorpost ist nichts hinzuzufügen, genau so vorgehen! Du kannst von der Dell Webseite die Treiber auch ohne den Support Assist ganz in Ruhe durchgehen bei Bedarf anhaken und in einem Rutsch manuell herunterladen. Die Option steht rechts neben Automatische Suche ganz groß 😉 Beispiel: Support für Alienware 17 | Treiber und Downloads | Dell Deutschland https://share.google/DzN8hg03Nt1rVb0xd P.S.: Wenn nicht alle benötigten Treiber unter Auswahl Win 10 x64 erscheinen dann so lange das nächst niedrigere OS auswählen bis der gewünschte,benötigte Treiber zum Download erscheint. Es lohnt sich im allgemeinen bei Dell ein Konto zu erstellen, dort kann man alle seine Geräte unter "Meine Produkte" hinzufügen samt Service Tag, das erleichtert die Übersicht und das wiederfinden bei Bedarf enorm!3 Punkte

-

Hallo @paradox, Die passenden Treiber für dein Gerät solltest du auf der Dell-Support Seite angezeigt bekommen indem du deinen Service TAG (findest unten auf Gerät oder im BIOS) dort eingibst. Da gibt es dann auch eine Übersicht welche Hardware bei deinem Gerät konfiguriert bzw. verbaut wurde. die genannten Symptome deuten auf die "Support-Assist" Software hin, deinstalliere diese testweise mal bitte. dazu gehe im Geräte-Manager beim betreffenden Gerät auf Eigenschaften->Details->HardwareIDs und poste hier mal den entsprechenden Wert, dann schauen wir worum es sich handelt. diese sollten sich über das Command Center steuern lassen3 Punkte

-

Hi zusammen, wie einige mitbekommen haben, hatte ich ja mehrere aktuelle Gaming-Laptops getestet, jedoch keins behalten. Nach wie vor bzw. wie in den letzten wenigen Jahren schon, komme ich zu dem Entschluss, dass ein Gaming-Laptop für mich einfach keinen Sinn macht. Um das Thema für mich selber abzuschließen, hatte ich mir alle Vor- und Nachteile auch nochmal aufgeschrieben. Manche schwanken vielleicht aktuell oder in Zukunft zwischen Gaming-Laptop und (ITX-)Desktop und dann ist meine nachfolgende Auflistung evtl. hilfreich. Vorteile/Neutral Gaming-Laptop Gaming-Laptop überall aufklappbar bzw. nutzbar. Somit kann auch im Zug oder im Hotel ordentlich gespielt werden. Ich bin aber so gut wie nie allein in einem Zug oder Hotel, und wenn doch, dann reicht mir in dem Moment mein mobiles 14" Laptop mit langer Akkulaufzeit und genügend Leistung für Surfen, Mailen usw. (und das ein oder andere Spiel läuft für die seltenen Momente im Jahr sogar auch drauf, wenn ich unbedingt spielen möchte) mit Gaming-Laptop wird kein Monitor sowie keine Tastatur am Schreibtisch benötigt, sofern einem dieser allein ausreicht (die meisten Personen nutzen wohl aber noch externe Peripherie) Gaming-Laptop bei Transport leichter/kleiner (ich nehme meinen ITX-Desktop in einer Tasche einmal die Woche wo mit hin, finde ihn persönlich aber für kurze Wege nicht zu schwer, trage ihn mit einer Hand am Tragegriff der Tasche) Nachteile Gaming-Laptop (ITX-)Desktop hat je nach Spiel 60-120% (mehrere Spiele gecheckt) höhere GPU-Leistung @Gaming (mobile 5090 vs Desktop-5090) (ITX-)Desktop hat je nach Spiel 30-180% (mehrere Spiele gecheckt) höhere CPU-Leistung @Gaming (275HX/285HX/9955HX3D vs 9800X3D) Gaming-Laptop auch im Alltag bzw. bei Office-Anwendungen, Installationen usw. spürbar langsamer / mehr lag Gaming-Laptop deutlich lauter (vorallem im Couchmaster mit laufendem TV im Hintergrund schlecht) mit Gaming-Laptop spürbare Abwärme bei Tastatur usw. Gaming-Laptop blöd zu positionieren (viel Stellfläche), wenn Laptop an kleinem Schreibtisch @Monitor/Tastatur oder am TV am Lowboard genutzt werden soll mit Gaming-Laptop keine Tastatur-Wahl sowie freie Positionierung derer möglich (im Couchmaster oder bei Nutzung ohne Monitor sowie externer Tastatur am Schreibtisch) bei Gaming-Laptop Bildschirm/Sicht/Blick (im Couchmaster oder ohne externen Monitor am Schreibtisch) auf Dauer zu weit unten - bei mobilem 18"-Monitor für ITX-Desktop flexibel verstellbarer Fuß vorhanden. Mit einem solchen mobilen 18"-Monitor kann auch flexibel das Bild an verschiedenen Standorten (mit langem USB-C-Video-Kabel, adaptiert auf DP @ Desktop-5090) mit voller sowie leiser ITX-Desktop-Leistung ausgegeben werden (z.B. in Couchmaster/Couch, am Esstisch, auf der Terrasse) Kosten und Aufrüstbarkeit lasse ich mal außen vor. Ich möchte hier keine Diskussion für das Für- und Wider anstoßen, ein Gaming-Laptop hat definitiv seine Daseinsberechtigung - mindestens wie schon gesagt für Zug/Hotel. Das sind einfach meine subjektiven Gedanken zum Thema und vielleicht hilft es dem ein oder anderen oder eben auch nicht. Manchmal schwankt ja der ein oder andere zwischen Gaming-Laptop- oder Desktop-Kauf. Es ist auch so, dass manch einer (z.B. @pitha1337) sich einfach allgemein nur für kleine Laptop-Technik begeistern kann und damit viel lieber spielt bzw. Leidenschaft für aufbringen kann. Für diesen Fall bringen pragmatische Vor- und Nachteilslisten sowieso wenig. Grüße edit: Hier noch ein Foto vom Einsatz eines mobilen 17,3"-Monitors (gibt auch 18") im Couchmaster mit nebenbei laufendem 77"-TV im Hintergrund. Auf dem Foto sieht es so aus, als sehe ich nur ca. die Hälfte des TV-Bildes, das stimmt aber nicht - ich sehe etwa 80% davon. Wenn ich den Monitor etwas weiter runter machen würde (Standfuß ist flexibel) dann sogar 90-100%. Ich habe das Foto nur von etwas weiter unten aufgenommen, da ich wollte, dass man die Kissen + Platte (Couchmaster) sieht. Der 17,3-/18"-Monitor wirkt wie 27-32" am Schreibtisch, weil man ja entsprechend nah dran sitzt (knapp 60 cm Abstand von Display zu Augen). Der Monitor holt sich das Bild vom ITX-Desktop. Damit das Ganze mit einem Kabel funktioniert, benötigt man einen speziellen Adapter von DP auf USB-C sowie ein entsprechend langes USB-C-Video-Kabel. Damit funktioniert auch G-Sync (compatible). Ich nutze einen bequemen sowie offenen Over-Ear-Kopfhörer, so bekomme ich sowohl im Spiel alles mit, als auch im Hintergrund im TV. Für manch einen ist beides gleichzeitig möglicherweise zu viel, für mich ist es genau das Richtige, zumindest wenn ich Serien schaue. Es gibt wenige Momente in ner Serie / in nem Spiel, wo ich dann schonmal kurz Pause drücken muss, aber das ist recht selten. Bei Singleplayer-Spielen ist es ja allgemein jederzeit wunderbar möglich, ebenfalls bei Netflix & Co.. Neue Filme schaue ich mir dann schon ohne Gaming parallel an. Es ist nicht so, dass ich jeden Abend spiele. Aber bei den meisten Serien wie gesagt funktioniert beides gleichzeitig für mich gut.3 Punkte

-

Hallo, ich habe das neue Netzteil erhalten und gestern abend sofort eingebaut. Ich habe mir ein original Netzteil bestellt. Auf ebay gibt es da einige. Wenn die Option Preisvorschlag aktiviert ist, kann man auch einen einigermaßen normalen Preis angeboten bekommen. Ich habe 150€ dafür bezahlt. Nageneu und original Dell. Da ich kein 750W Teil gefunden hatte, habe ich mir ein 1000W Netzteil gekauft. Es hat diese Artikelnummer/ Bezeichnung: R61D8 1000W Liteon Der Einbau war easy. Auch die Stecker paßten alle wunderbar und ich testete das Gerät mit der alten RTX3060 drin. Der Alienware R13 hatte sofort Strom, alle Lüfter liefen. Nur sah ich auf dem Monitor erst kein Bild. Ich schaltete den 2. Monitor an und dort war dann der Win Login Bildschirm zu sehen. Puh Schnell zum ersten Monitor geswitched per Win+P. Die neue Grafikkarte hatte ich danach auch eingebaut. Das war ja eine Inno3D RTX 5070ti mit 16GB. Diese lief auch, aber ich mußte tatsächlich den Nvidia Treiber, der mit der RTX 3060 lief deinstallieren und anschließend neu aufspielen. Nun wurde die neue Grafikkarte auch erkannt und verrichtet von nun an (hoffentlich zuverlässig ) ihren Dienst. Zur Leistung kann ich noch nichts genaues sagen, werde mich dazu aber noch einmal melden (ich war gestern abend einfach zu müde um das auch noch auszuprobieren). Danke ans Forum! Ihr habt einen nicht unwesentlichen Beitrag dazu geleistet, dass ich mein System upgraden konnte. Danke!3 Punkte

-

@AIXtreme2k: Das ist korrekt. Der Alienware 17 R4 unterstützt offiziell kein Windows 11 (siehe hier: https://www.dell.com/support/home/de-de/drivers/supportedos/alienware-17-laptop?ref=oscompatibilitymsg und hier: https://www.dell.com/support/kbdoc/de-de/000189820/windows-11-geräteunterstützung-und-mindestanforderungen). Wenn man trotzdem Windows 11 installieren möchte, so kann man dies z. Bsp. mit "Flyoobe" (siehe hier: https://github.com/builtbybel/Flyoobe) oder "Rufus" (siehe hier: https://rufus.ie/de/) tun, denn mit diesen beiden Tools lassen sich u. a. auch die entsprechenden Installationssperren für ältere nicht Windows 11 kompatible Hardware deaktivieren.😉3 Punkte

-

Hier zwei Bilder vom Alienwarestand, ich bin selbst nicht dort aber mein Stiefsohn hat sie mir geschickt, er fand den AW Stand aber nicht sonderlich spektakulär. Merch gab's wohl auch nix, Schade😓 So'n Schlüsselband o.ä. hätte mich schon erfreut, die werden wohl auch immer geiziger😉🥴 Ist von hier jemand dort?3 Punkte

-

Super DANKE... Hab den "SupportAssist" deinstalliert und sofort ist Ruhe. Werde das jetzt erstmal weiter beobachten und dann Rückinfo geben.3 Punkte

-

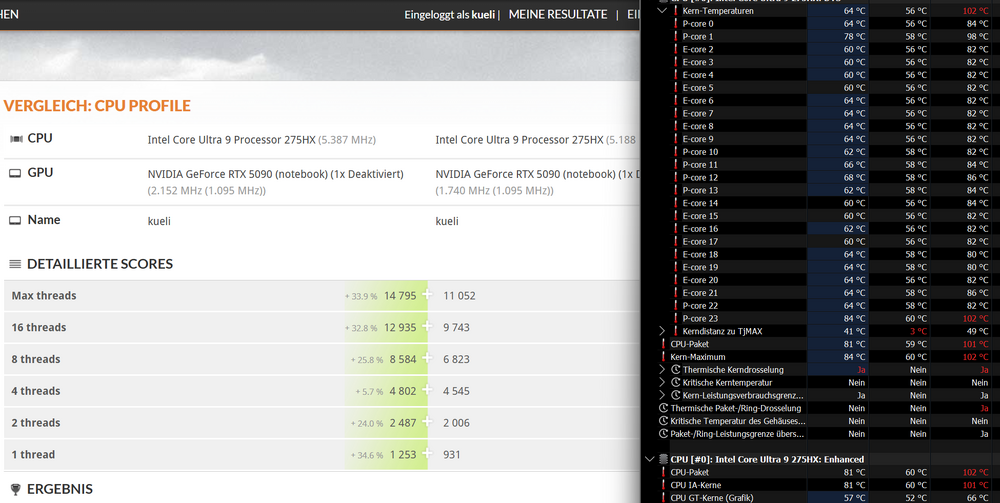

So nochmal ein Update zu meinem 16". Der neue Laptop ist da und fühle mich damit sehr viel wohler. Der P23 ist auch etwas wärmer, aber insgesamt laufen die Temperaturen stabiler und auch im CPU Test von 3DMark wird besser performt, die Lüfter drehen nicht so schnell auf und der Laptop wirkt auch gefühlt etwas kühler. Habe das TPC Offset schon auf 100Grad runtergesetzt bei meinen Tests. Links ist der neue Lappi - rechts der alte, der auch nicht so viel hochgetaktet hatte wegen der Temperatur Die Durchschnittstemperaturen liegen jetzt bei 55-65 Grad3 Punkte

-

3 Punkte

-

Da muss ich widersprechen. Es ging ja in der Vergangenheit bereits, selbst Desktop Komponenten wo CPUs weit jenseits der 100w und gpus mit 200w kombiniert gekühlt werden konnten. Und das war noch ohne fette Vapor-Chamber. Clevo hat selbst 2x 200w GTX 1080 im SLI samt 10900K im Notebook ohne Probleme gekühlt. Es geht, wenn man will. Die Hersteller wollen nur nicht und das unterstütze ich nicht. Schimpftirade Start: Ja Temperaturen sind bei Notebooks immer ein Thema. Wir haben uns aber von ,,throttling ist der absolute Worstcase,, zu ,,throttling ab leichter Last,, entwickelt. Den Nutzern wurde gebetsmühlenartig über Jahre weis gemacht das Throttling kein Fehler, bzw schlecht ausgelegte Kühlung, sondern ein Feature ist. ,,Turbo boost,, ,,thermal Velocity Boost,, ,,maximale Turbo Leistungsaufnahme,, etc PP. Alles so windige Bezeichnungen um Throttling massentauglich zu machen. Sorry, musste mal raus 🫡 Schimpftirade Ende.3 Punkte

-

Mir ist das völlig egal, wofür die Leute ihr Geld raushauen. Find Gaming-Notebooks aktuell nur ziemlich langweilig und sowohl leistungstechnisch als auch preislich sehr unattraktiv. Release Date der (Desktop) RTX 4080 war November 2022 und eine aktuelle Mobile 5090 schafft's nicht mal ne alte 80er Karte zu schlagen, zumindest gemessen an 3D Mark Ergebnissen (beide Fälle Benchmark optimierte Werte) - Time Spy Graphics: 30.700 vs. 26-27.500 - Time Spy Extreme Graphics: 15.000 vs. 12-13.000 - Port Royal: 19.800 vs. 17-18.000 - Steel Nomad: 7800 vs. 7000 und wir sprechen hier vom einem Gerät weit oberhalb von 4.000€ (normalerweise). Ein Vergleich mit Desktop 4090/ 5090 braucht man gar nicht erst anzufangen. Hinzu kommt noch, dass UV, RAM-Tweaking, Optimierungen wie Fan Control, Modding etc. teilweise immer schwerer wird umzusetzen, wenn nicht gar unmöglich. Also im Grunde, alles was Spaß macht, wird ein Riegel vorgeschoben. Dann die fragwürdigen Hardware-Konfigs (Display, RAM z. B.), nach wie vor kein mobiler 9800X3D (8-Kerner) und insgesamt der Abstand zur Desktop-Leistung. Alles so Sachen, die jetzt nicht unbedingt für Gaming-Notebooks sprechen. Jedenfalls aus meiner Sicht.3 Punkte

-

Evtl. versuchst du die Bios-Defaults blind zu laden: 1. Lappi Hochfahren, dabei F2 drücken 2. F9 zum defaults laden drücken->ENTER 3. F10 zum Speichern und Neustart->ENTER3 Punkte

-

Eigentlich ist folgendes die offiziell von Dell vorgeschlagene Bios Recovery Methode: https://www.dell.com/support/kbdoc/de-de/000132453/wiederherstellen-des-bios-auf-einem-dell-computer-oder-tablet-nach-start-oder-post-fehlern3 Punkte

-

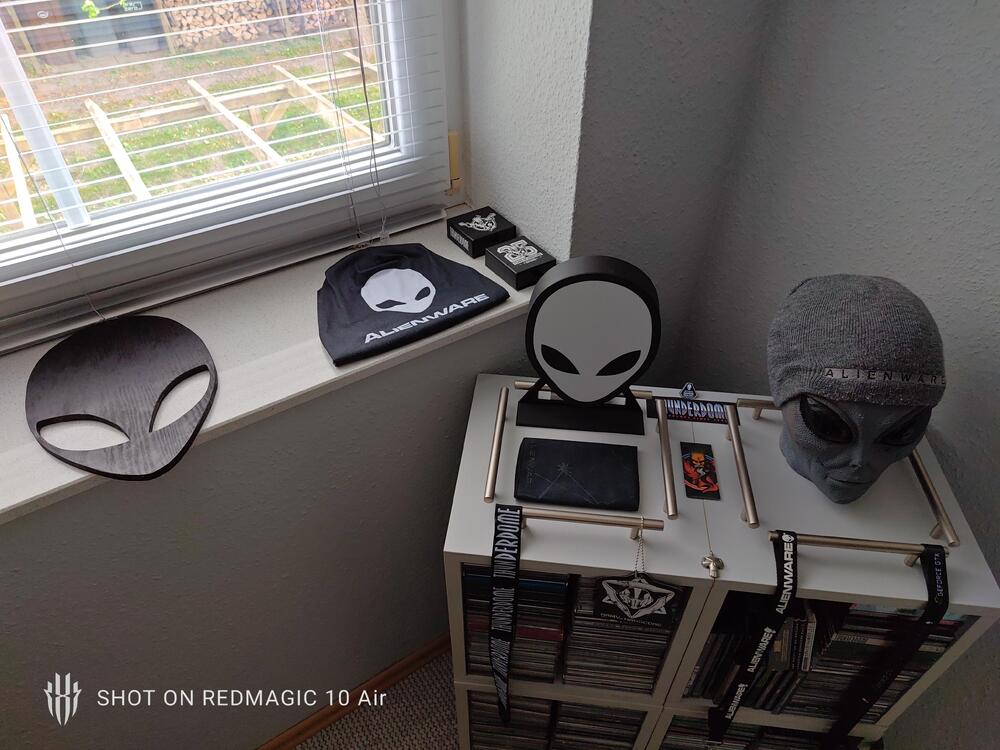

Hi, Auf Hinweis in einem anderen Thread, hier jetzt der passende Thread bezüglich eurer Altgeräte, zeigt her eure Goldstücke! Ich fange sodann mal an mit meinem Area51 ALX: Ist das komplette original Setup incl. aller Peripherie und dem guten alten 23 Monitor😉 , so wie man es damals konfigurieren und bestellen konnte wenn man genug Kleingeld übrig hatte🙈👽😉Den auf dem Bild zu sehenden ollen Drucker mal außen vor 😉 Ich habe alle meine Retro Sachen im Netz, eBay/Kleinanzeigen usw. in den vergangenen Jahren zu guten oder auch manchmal überhöhten Preisen zusammen gesammelt. Aber Hobby und Vernunft passen halt manchmal nicht zusammen 😉 Der Area 51 R2: Der AW "Altar"😅 Wohnzimmer PC, der gute AW X51 R2: Habe noch unzählige gesammelte Merch Gegenstände/Klamotten usw, aber das würde den Rahmen sprengen erstmal.3 Punkte

-

Eine Sache sollte man vor Neuinstallation kompromitierter Rechner immer vorsichtshalber machen: BIOS flashen wg. UEFI Rootkits. Weil ich es hier noch nicht gelesen habe: Das allererste, was man machen sollte nachdem man gehackt wurde, ist das Password vom E-Mail-Account von einem unkompromittierten Rechner/Handy zu ändern. Falls der Hacker das Passwort schon geändert hat, sofort den E-Mail-Provider kontaktieren. Das ist deshalb wichtig, weil diese ganzen Passwort-Vergessen Mechanismen meistens über die E-Mail-Adresse laufen. Sehr empfehlenswert ist es auch sich für solche Passwort-Vergessen Sachen eine separate E-Mail-Adresse zuzulegen, deren Passwort man nur zuhause auf Papier hat. Nicht bequem, aber sicher. Es ist hilfreich, wo möglich für 2FA Hardware-Tokens verwenden. Die sind mittlerweile nicht mehr so teuer z.B. YubiKey ab 60€ oder Token2 ab 13,50€. 2FA ist nicht sicher, wenn der dazugehörige E-Mail-Account, das Handy, etc. ebenfalls kompromitiert werden kann. Außerdem ist es eine gute Idee Software, wenn möglich, Software über Winget zu installieren (Microsoft Store => App Installer). Das ist ein Kommandozeilen Tool um Software zu installieren und zu verwalten. Vor allem kann man sich sehr einfach Updates anzeigen lassen und installieren. Das spart eine Menge Zeit den Rechner up2date zu halten.3 Punkte

-

@kroenen04: Dann hast Du ja nochmal "Glück im Unglück gehabt", dass nicht noch mehr bzw. weiterer monetärer Schaden entstanden ist. Das Vorhandensein älterer nicht mehr aktueller bzw. unsicherer Software wird häufig unterschätzt. Oft hat man solche "Software-/App-/Daten-Leichen" gar nicht mehr im Blick oder die entsprechenden Ordner/Verknüpfungen/Registrierungseinträge sind nur noch rudimentär vorhanden und werden dem User gar nicht mehr angezeigt, bis dann so etwas passiert wie in Deinem Fall. Off-topic: Wenn der (kostenlose) Support von Microsoft Windows 10 im Oktober diesen Jahres eingestellt wird und viele User das Betriebssystem dann trotzdem (sei es aus Unwissenheit oder mangels Windows 11 Support auf älterer nicht unterstützer Hardware ) "ungeschützt" weiter nutzen und damit online im Internet unterwegs sind, werden sich solche und ähnliche Betrugsfälle häufen. Aber selbst bei aktueller Hardware und entsprechendem Schutz ist man doch nie ganz vor diesen "Menschen" sicher.☹️3 Punkte

-

Da wäre ich ja schon gleich sehr angefressen!!!! Den Originalkarton ohne Umverpackung geschickt, Beulen,Kratzer drin schon und der Versandaufkleber oben drauf gepappt. Wurde der Umkarton jetzt bei den neuen auch schon weggespart? 🤬😡Das Gerät an sich , Donnerwetter im Extrakarton mit Tasche, die ein wenig an die guten Samttaschen von früher erinnern, immerhin. Sorry, mir sind solche Kleinigkeiten bei den Preisen wichtig, anderen vielleicht nicht so, soll ja auch welche geben die OVP's entsorgen 😳🙈😫Bevor ein Unhold sowas hier vorhat: OVP's von AW zu mir!😉oder wo im Müll zum wieder rausholen🤣, es sei denn noch schlimmer, zerstört damit es besser in die Tonne passt 😱🫣. Die Farbe leuchtet aber viel blauer als ich es mir vorgestellt habe, dennoch ganz schick das Teil, obwohl sich mir der Sinn von Gorillaglas und Sichtfenster auf der Unterseite immer noch nicht erschließt 🤔 Vielleicht um ein Alleinstellungsmerkmal zu kreieren?k.A Das neuere GAN Netzteil mit Alienhead weiß auch zu gefallen 👍😁 Im dunklen Grau/Schwarz, im hellen Blau, find ich ganz gelungen, sowie das Design allgemein bis auf die Unterseiten Geschichte. Sieht nett aus , sieht man nur sehr selten denke ich oder auf ner LAN Party hochkant stellen um zu Posen 🤣 Wenn ich Bedarf und die Kohle übrig hätte wäre der meinerseits gekauft, trotz aller Kompromisse die für den einen mehr stören und für den anderen weniger. Da hat AW ja mal was einigermaßen ansprechendes rausgehauen, Tests und Kinderkrankheiten bleiben natürlich abzuwarten. Was ich übrigens schon länger schade finde ist, dass der AW Schriftzug am Display bei den neuen, seit der Powerful Serie meine ich, nicht mehr beleuchtet ist. 😢 Huch, gerade erst gesehen: Wo ist der ein/aus Knopf abgeblieben ne schnöde Taste auf der Tastatur 😫 Der Stylischte Powerbutton den ich kenne nicht mehr beleuchtet thronend über der Tastatur? 😳😱🫣😢 Ihr könnt mich ruhig kleinlich nennen, aber das der gute AW Powerbutton fehlt ist für mich ne Schande, würde mich sehr sehr und dauerhaft bei jedem ein und ausschalten nerven 🙈3 Punkte

-

3 Punkte

-

Ich habe alles richtig gemacht, es auseinandergenommen, die Kontakte gereinigt (sie waren wie neu, kein einziger Defekt oder Staubkorn, sie glänzten, als kämen sie gerade vom Band). das Problem bleibt bestehen Hallo Jörg! Ich befürchte, dass tatsächlich ein Defekt am Mainboard oder an der Grafikkarte vorliegt. Das Problem in der Ukraine ist, dass es unglaublich schwierig ist, Ersatzteile für ALIENWARE zu finden. Auch der Versand über eBay funktioniert nicht; In meinem Land herrscht Krieg. Nachdem ich die Foren und Reddit gelesen hatte, bemerkte ich, dass einige Leute dieses Problem von Anfang an hatten. Vielleicht ist mir das Gleiche passiert und ich habe es einfach nicht bemerkt (ich wiederhole, der Laptop funktioniert einwandfrei). Das ist mir bei CYBERPUNK 2077: Phantom Liberty v. 2.21 aufgefallen. Mit aktiviertem DLSS – FPS 6–21. Es war sehr auffällig. So kam es beispielsweise bei anderen Spielen zu Einbrüchen auf bis zu 40 FPS, die optisch jedoch nicht auffielen. der FPS-Unterschied zwischen PCIe x8 und PCIe x1 beträgt etwa 30 % Ich kann nur auf ein gutes Servicecenter hoffen, das den problematischen Teil des Motherboards oder der Grafikkarte findet und ersetzt. Denn im Allgemeinen sind sie Arbeiter. Ich vermute einfach, dass ein defekter Transistor das gesamte System zerstören wird. Aufrichtig Vlad Zum Vergleich FURMARK PCIe x8 FURMARK PCIe x1 (meins) Die gleichen 30% niedrigeren Ich halte Sie auf dem Laufenden (obwohl ich in absehbarer Zeit keinen guten Dienst finden werde) und hoffe, dass jemand im Forum eine „Wunderpille“ findet, mit der ich das Problem ohne einen Dienst lösen kann 😃 Tut mir leid, wenn Google Translate etwas falsch gemacht hat 😃 Frohe Ostern, Jörg, dude08/15 und alle anderen, die diese Nachricht lesen (und alle, die das nicht tun😉🤗)3 Punkte

-

3 Punkte

-

Hi, also erstmal wünsche ich dir viel Kraft, dass das alles ohne weitere Probleme klappt und du zufrieden gestellt wirst. Aber ich muss schon sagen, den Laden so dermaßen schlecht zu reden und zu boykottieren finde ich schon etwas daneben. JA, es ist sehr ärgerlich, dass kein Techniker rausgeschickt wurde. Aber es wurde ja trotzdem direkt von Anfang an angeboten, dass Gerät einzuschicken. Natürlich sollte man Premium-Support erhalten, wenn man dafür viel Geld bezahlt. Ich kann bislang nur einen Reparaturauftrag bei Alienware/Dell verzeichnen, und das klappte reibungslos. Vielleicht ist es eine Verkettung von vielen blöden Zusammenhängen und es ist auch richtig diese Erfahrungen im Netz mit einer Community zu teilen... ob man jetzt die ganze Firma/Marke verteufeln muss, vor allem wenn man ja jahrelang IMMER sehr zufrieden war... weiß ich nicht. Wie gesagt. Ich hoffe es klappt am Ende so, wie es sein sollte. LG3 Punkte

-

Ich kann mich @pitha1337 im Grunde nur anschließen. @BerlinRockz Wenn ich das richtig verstanden habe, hattest Du ja vor etwa 3 Wochen den Vor-Ort-Service für den Austausch der Tastatur in Anspruch genommen. Dann, vor etwa 5 Tagen dann erneut Kontaktaufnahme mit Dell Support wegen der geschilderten Problemsituation. Während seitens Dell nur vorgeschlagen wird, das Gerät nunmehr einzuschicken ( sicher Abholung durch UPS), möchtest Du auf der Vor-Ort-Reparatur beharren. Ich hätte mir an Deiner Stelle auch gewünscht, dass wieder vor Ort repariert werden kann. Andererseits ist es für mich ehrlich gesagt nachvollziehbar, dass Dell das Gerät nun in der Werkstatt überprüfen will, wenn bei einem 5 Monate alten Gerät nach einem „Brand“, wie bei Dir offensichtlich, mehr als nur ein Teil beschädigt worden ist. Von der Rußverteilung bis in die Lüfter hinein mal abgesehen, ist ja nicht auszuschließen, dass nicht noch mehr Schaden entstanden ist. Gleichzeitig hat man eher dort die Möglichkeit auch den tatsächlichen Grund für den Schaden im Systemverbund zu analysieren. Das ist nochmal was anderes als Einzelteile zu testen. Schließlich soll die Lösung ja langfristig währen. Und ein Vor-Ort-Techniker tauscht in der Regel wirklich nur die Teile aus. Meiner Meinung nach spricht in Deinem Fall Vieles für eine ziemlich misslungene Kommunikation zwischen Dir und dem Dell Support. Andernfalls kann ich mir wirklich nicht erklären wie es zu einer derartigen Eskalation innerhalb von nur wenigen Tagen kommen kann. Dein „Fall“ ist ja noch ganz frisch und ich kann Dir aufgrund meiner Erfahrungen mit dem Dell Support nur raten, grundsätzlich immer freundlich zu kooperieren. In Deinem Fall würde ich deshalb Dell’s Ermessensspielraum, wie ein Schaden am besten beurteilt und behoben werden kann, respektieren, dh: Daten sichern, am besten anrufen, schnellstmöglich einen Abholtermin vereinbaren, damit nicht unnötig viel Zeit verschwendet wird. Je nach Ergebnis bekämest entweder Dein Gerät im funktionsfähigen Zustand zurück oder gar ein Ersatzgerät oder ein Refund. Der Zeitablauf würde so oder so von der Verfügbarkeit der benötigten Austauschkomponenten abhängen. Sofern von „refurbished“ Teilen die Rede ist, sind diese meines Wissens nicht abgenutzt, sondern auf Ihre Funktionsfähigkeit hin separat überprüft; z.T. aus nagelneuen Geräten der Baureihe, die aus verschiedensten Gründen (zB innerhalb von 14 Tagen) zurück gegangen sind. Generell können ab Fabrik eingebaute Komponenten auch fehlerhaft sein und dies sich erst im Nachhinein herausstellen. Sollten im Anschluß an eine Reparatur, sofern Du Dell überhaupt die Gelegenheit dazu gibst, etwa immer noch Hardware-Probleme auftauchen, ist es m.E. sehr unwahrscheinlich, dass man einem Wunsch nach Austausch oder Refund, nicht entsprechen würde. Wie gesagt, meine Empfehlung beruht auf Basis meiner jahrelangen positiven Erfahrungen mit dem Dell Support, die immer (!) ein Entgegenkommen gezeigt hat. Ich hoffe daher für Dich, dass sich eine weitergehende Eskalation vermeiden lässt und Du so letztlich zu einer vergleichsweise schnelleren Lösung gelangen kannst.3 Punkte

-

Mein Projekt restaurierung/Upgrade eines Area 51 R2 läuft bestens, er ist nach 4 Jahren im Keller erwacht heute das erste mal. Vorher "alles" komplett zerlegt, gereinigt, neuen RAM, neue Graka, neue SSD'S,WLP usw. läuft bis jetzt wie geschmiert die Kiste 👍 🙃😊😜Jetzt dabei am Win11 einrichten,Treiber usw.3 Punkte

-

@kroenen04: Solltest du unbedingt machen, ja. Waren beim Monitor Anschluss-Kabel dabei, z.B. ein HDMI-Kabel und/oder ein DP-Kabel? Diese solltest du nach Möglichkeit verwenden und kein anderes, da dann zu 100% die vollumfängliche Unterstützung des Monitors sichergestellt ist, vorausgesetzt es wurde PC-seitig korrekt angeschlossen, nach Möglichkeit direkt an der Grafikkarte. Auf ein zusätzliches Kabel, das als Verlängerung dient, solltest du verzichten, das kann zu Problemen führen. Dein Monitor unterstützt HDMI 2.0 und DP 1.4, deine 4080 HDMI 2.1. Und hier könnte evtl. schon das Problem liegen, bin mir da aber nicht 100% sicher, da manche Aussagen gegensätzlich sind. Es kann sein, dass bei deiner WQHD-Auflösung und HDMI 2.0 gar nicht 144 Bilder pro Sekunde übertragen werden können und daher die Synchronisations-Vorgänge, die V-Sync ausführen möchte, gar nicht funktionieren können. Hier bin ich mir aber wie gesagt nicht zu 100% sicher, evtl. kann hier jemand anderes etwas zu sagen. Daher würde ich an deiner Stelle, sofern das für dich nicht mit großem Aufwand und/oder Kosten verbunden ist, auf DP 1.4 wechseln. HDMI erscheint mir von der maximalen Leistung für deine Situation zu grenzwertig. Nachtrag : So, mein Verdacht hat sich nun bewahrheitet, HDMI 2.0 reicht für deine Situation nicht aus !! Auf der BenQ-Webseite gibt es eine Tabelle, ich verlinke dich mal dorthin, dann kannst du es selber sehen : Wann brauche ich wirklich HDMI 2.1 oder reicht HDMI 2.0 aus? | BenQ Deutschland Bei deiner Auflösung (3440x1440) benötigst du für 144Hz min. HDMI 2.1 . Das unterstützt zwar deine 4080, dein Monitor jedoch leider nicht . Von daher ist es jetzt natürlich klar, warum die Aktivierung von V-Sync nicht das bewirken kann, was es eigentlich soll, da die Basis-Voraussetzungen dafür bei dir nicht gegeben sind. Nachtrag 2 : Ich sehe gerade, du hattest das Problem bereits selber erkannt bzw. als Ursache in Betracht gezogen. Asche auf mein Haupt, das kommt davon wenn man nicht alles sorgfältig liest . Nachtrag 3 : Ganz unabhängig von deinem V-Sync-Problem : Freesync funktioniert offensichtlich auch mit NVidia-Karten . Dazu muss natürlich ebenfalls die Basis stimmen, was aktuell ja bei dir nicht der Fall ist. Daher solltest du wirklich bei dir von HDMI 2.0 zu DP 1.4 wechseln. Dann sollten sowohl V-Sync, als auch FreeSync bei dir funktionieren. Ist bei dir ein niedriger Input Lag Thema oder von Wichtigkeit, würde ich FreeSync nutzen. Stört dich ein Input Lag nicht und du möchtest deine HW nicht bis zum Anschlag ausreizen(Temperaturen), nimm besser V-Sync. Gruß Jörg3 Punkte

-

Ja, hab schon vor einigen Jahren mit Putty rumhantiert. Aus heutiger Sicht würde ich aber kein K5 Pro mehr empfehlen (damals gab's halt kaum was anderes). Wenn's um Wärmeleitpads geht --> Arctic TP-3 Wenn's um Putty geht --> CX-H1300 (13,5 W/mK) oder Upsiren UTP-8 Thermal Grizzly bietet seit neusten auch Putty in drei Abstufungen an. Igor's Lab hat sie getestet, falls dich die Unterschiede interessieren. Putty und Wärmeleitpads nur auf Hardware-Komponenten wie VRAM, VRM usw. Auf CPU und GPU sollte man wie vor auf klassische Paste, LM oder idealerweise auf Honeywell PTM7950 setzen.3 Punkte

-

Ich bin grundsätzlich immer gegen Staubschutz. Jeder Widerstand verringert den Airflow und verschlechtert somit die Kühlleistung, teilweise sogar erheblich. Hängt natürlich immer vom Einzelfall ab, was einem wichtiger ist und wie viel Staub das Gerät ausgesetzt ist. Je nach Ausprägung/ Belastung kann ein Staubschutz schon sehr sinnvoll sein. Meine Notebooks und der PC steht im Büro, wo ich sehr wenig Staub habe. Im Nicht-Gaming-Betrieb kann ich oftmals die Notebooks mit Kühler und Mods soweit runterkühlen, dass nie NB-Lüfter erst gar nicht angehen, wodurch sie auch kein Staub ansaugen können. Das klappt aber auch nur, wenn man unter bestimmten Temperaturschwelle bleibt. Wäre mal interessant zu wissen. Evtl. auch der Vergleich mit dem Topside-Kühler. Noise-normalized wird wohl außer Frage stehen. Problematisch ist aber sauberes und fehlerfreies Messen/ Vergleichen. Dadurch, dass die NB-Lüfter nicht auf eine feste RPM-Zahl fixiert werden können und an bestimmten Temperaturpunkten hängen, ist ein Vergleich schwierig. Kühlt man besser von Außen (z.B. mit einem Kühler) machen die NB-Lüfter selbst weniger = ergo man landet bei einer ähnlichen Temperatur, nur entsprechend leiser.3 Punkte

-

Grundsätzlich gute Idee, aber die ASUS-Pauschale hierfür ist völlig absurd. Mainboard mit BTF Anschluss (X870E Hero BFT ~700€) + ASUS 5090 mit BTF Anschluss 3.600€+ machen's halt maximal unattraktiv. Darüber hinaus hat Asus jetzt nicht gerade den besten Ruf, was Garantie-Abwicklung angeht. Gut, das hat irgendwie keiner der großen GPU-Hersteller, aber wenn man schon die Preisspitze ist, sollte zumindest dahingehend etwas besser sein als der Rest. Auch beim Thema Spulenfiepen ist ASUS nicht gerade empfehlenswert. Siehe Spulenfiepen-Thread im HWL. Ich selbst hatte mal ne Astral 5090 in ein System eingebaut. Schon krasse Karte, alles aus Metall und sehr hochwertig, aber das Spulenfiepen.... richtig übel. Für mich bei dem Preis (der non-BTF schon) und als "Silent-Fetischist" absolut nicht hinnehmbar. Auch wenn ich das Monitoring des 12-Pin Steckers echt feier. Optisch sieht's natürlich ziemlich schick und clean aus. Bezogen auf Kühlung aber, wird das Kabel keinerlei signifikanten Einfluss haben.2 Punkte

-

Fortnite lädt jetzt nochmal über Epic Launcher neu runter, morgen dann mal testen und mittags wird die Kiste abgeholt 😉Denn: Fehler gefunden!, es war der RAM bzw. das XMP Profil womit der Mist PC nicht klar kommt,(dude 08/15 hat ja auch darauf hingewiesen). Hätte ich auch schon früher testen sollen oder darauf kommen, aber irgendwann wird man unkonzentriert bzw. verlässt einem die Geduld. Hab mir im BIOS n Wolf gesucht wo man das XMP Profil deaktivieren kann, leider nix gefunden oder es geht nicht. Jetzt mit dem alten RAM der verbaut war läuft die Karre stabil. Vorhin nochmal alles wieder ausgebaut und nach Try and Error nacheinander getestet alles, dann wieder alles rein, Mannomann, nie wieder rufe ich bei sowas hier, ich mach das !🙈 So, Feierabend und null Bock mehr 😵😵😵2 Punkte

-

Gibt 3 Optionen: 1. neu kaufen. Widerrufsfrist ist weg also ab zu Kleinanzeigen damit und den Schaden begrenzen. Hast du die Möglichkeit mit deinem Kollegen Mal bei Mediamarkt oder einem örtlichen PC Laden vorbei zu fahren? Die sollten doch zumindest was fertiges spieletaugliches haben. Wäre zwar nicht meine bevorzugte Lösung, aber in Anbetracht das heute Freitag ist und die Kiste Heiligabend da sein muss wäre das vielleicht ne gängige Alternative wo ihr zeitnah was bekommt (hoffentlich) 2. Option ist hoffen das das verbaute Netzteil wenigstens mit ner 3060 / 4060 oder so zurecht kommt. Die müsst ihr aber auch erst Mal bekommen. Bestellen wäre mir zu heikel --> Elektronik Läden abtelefonieren ob was auf Lager ist. 3. Damit leben das die onboard GPU ist was sie ist. Für 1080p Low Fortnite scheint es zu reichen: https://youtu.be/LQ0eCFQqQAk?si=ixHSLw5dKAlNNMtu Das vorletzte Spiel ist Fortnite. Viel Glück das was Brauchbares drin ist. Das ist schon richtig, aber das funktioniert nur weil die Eltern sich oft nicht mal ein Minimum an Arbeit machen ( häufig auch kein Intresse haben) um sich etwas zu belesen. Da wird dann halt ,,irgendwas,, gekauft. Sehe ich im Bekanntenkreis auch immer wieder. Wenn ich nur ,,Spiele PC für Einsteiger,, bei Google eingeben, ist der dritte Link notebooksbilliger wo man schon taugliche Komplettpakete bekommt, die zumindest das können für das sie verkauft werden.2 Punkte

-

ACPI\CPL0002\2&DABA3FF&0 -> OSD Software: https://www.dell.com/support/home/en-uk/drivers/driversdetails?driverid=xfkfc&oscode=wt64a&productcode=alienware-17 ACPI\DELLABCE\2&DABA3FF&0 -> Airplane Mode Switch: https://www.dell.com/support/home/en-uk/drivers/driversdetails?driverid=90m6t&oscode=wt64a&productcode=alienware-17 ACPI\SMO8810\1 -> Free Fall Sensor: https://www.dell.com/support/home/en-uk/drivers/driversdetails?driverid=cwhjc&oscode=wt64a&productcode=alienware-17 passendes Command Center: https://www.dell.com/support/home/en-uk/drivers/driversdetails?driverid=9t1fg&oscode=wb64a&productcode=alienware-17 Hier noch alle verfügbaren Treiber für's AW 17 R1: Support für Alienware 17 | Treiber und Downloads | Dell Deutschland bitte im Fenster unter Reiter "Eigenschaft" -> "HardwareIDs" auswählen (wo bei dir "Gerätebeschreibung" steht)2 Punkte

-

@tribblejoker: Ich schließe mich @Svencore an und wünsche Dir natürlich weiterhin ganz viel Spaß beim Basteln mit Deinen Alienware Geräten. 😊 Ein letzter Satz noch zum Thema: Der Servicetag ist eine Kombination aus Buchstaben und Zahlen und eigentlich nichts anderes wie die Fahrgestellnummer (Fahrzeug-Identifizierungsnummer/FIN) beim KFZ.😉2 Punkte

-

2 Punkte

-

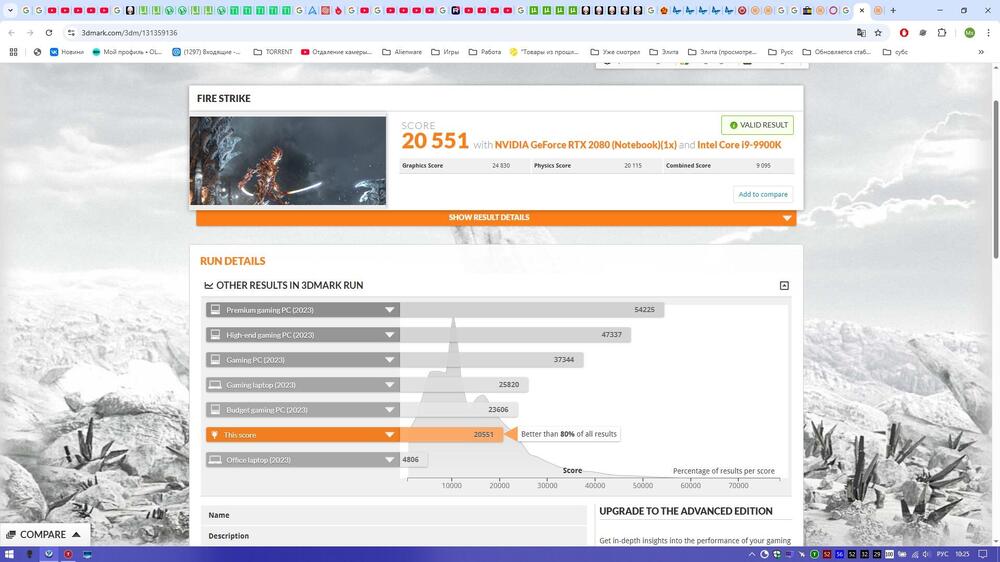

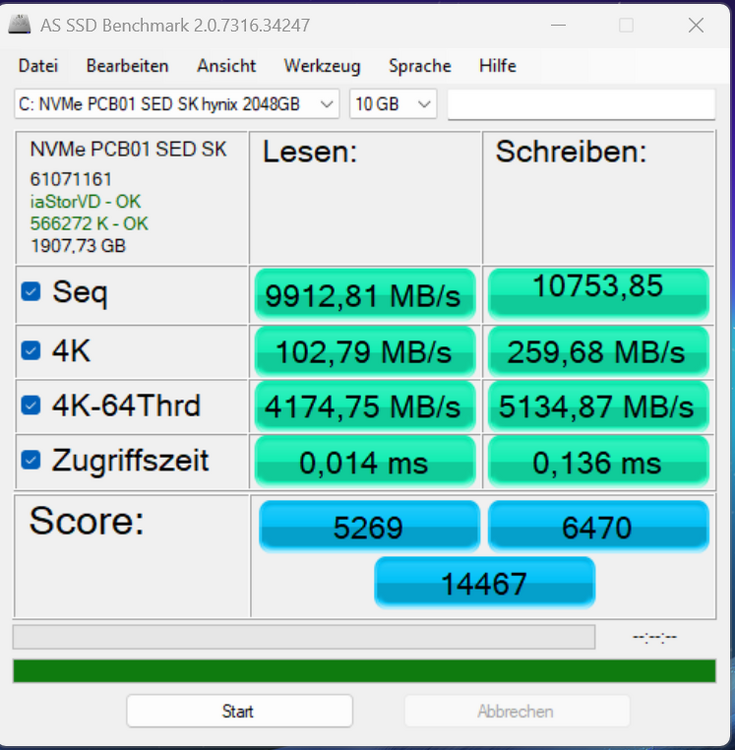

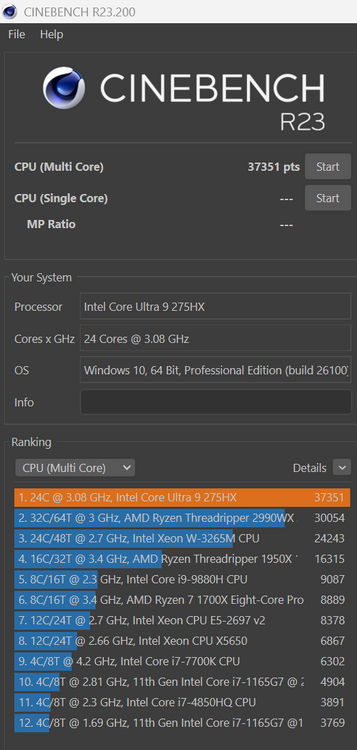

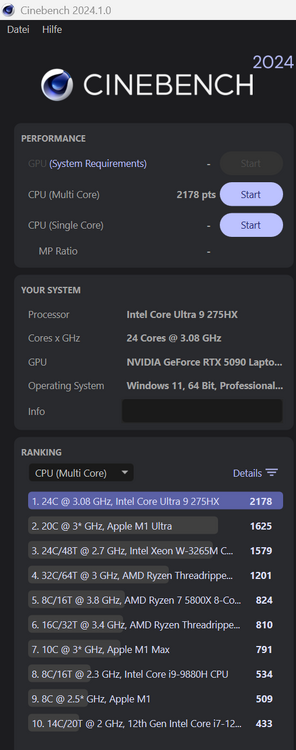

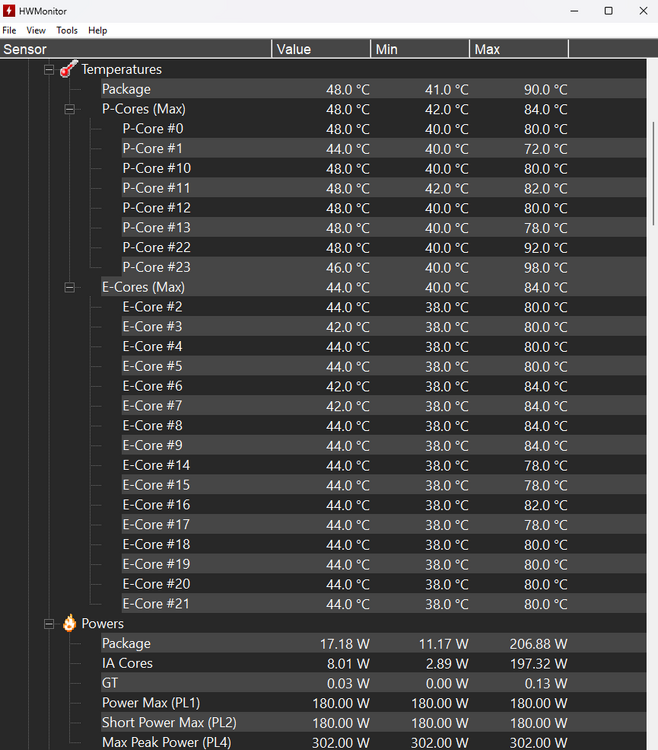

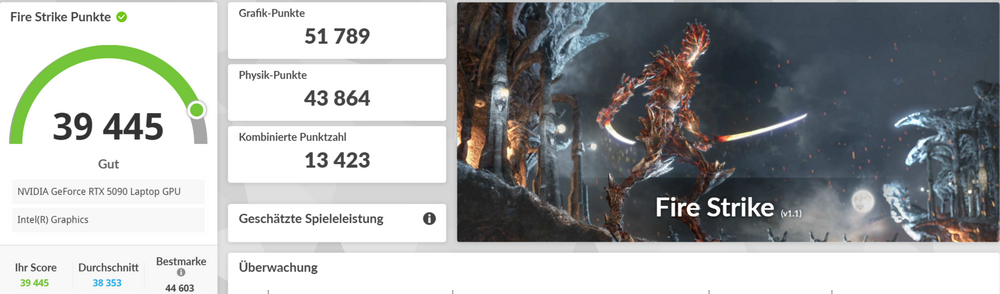

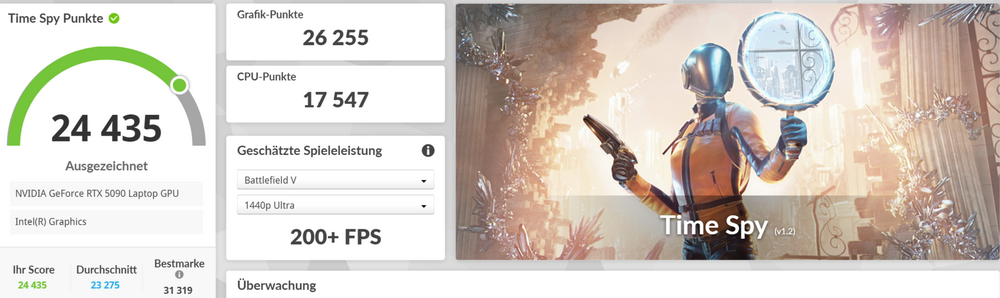

Ich bin gestern zum auspacken des Alienware 18 Area-51 gekommen und bis jetzt alles in Ordnung, in den ersten, 1 - 2 Tagen. Hier ein paar Benchmarkergebnisse: Lüfterprofil: Overdrive Windows Energieeinstellung: Ausbalanciert NVIDIA Treiber (neuester von der NVIDIA Seite): 580.88 BIOS Version: 1.5.3 Was mir aufgefallen ist, zwischen Lüfterprofil Ausgeglichen und Overdrive im Time Spy, nur sehr geringe Unterschiede. Desweiteren ist die CPU Temperatur im Cinebench R23 und Cinebench 2024 absolut akzeptabel: zwischen 70 und 84 Grad. Außer P-Core 22 = 92 Grad und P-Core 23 = 98 Grad. Das sind aber alles Max. Werte, die Durchschnittswerte sind zwischen ca. 70 - 80 Grad. Man muss auch Bedenken das Cinebench die CPU außergewöhnlich hoch belastet, was beim Gaming so nicht der Fall ist. 1. Screenshot: SSD Benchmark (Ich hoffe in Ordnung für eine Gen 5 Nvme SSD) 2. und 3. Screenshot: Cinebench R23 und 2024 im Multi Core 4. Screenshot: Temperaturen nach Cinebench (Max. Werte) 5. Screenshot: Fire Strike 6. Screenshot: Time Spy Overdrive 7. Screenshot: Time Spy Ausgeglichen2 Punkte

-

@Svencore: Es freut mich sehr zu lesen, dass auch Menschen aus einem prof. Umfeld nicht nachvollziehen können, warum man eine gegen Aufpreis bestellbare bessere Tastatur nur im USA-Layout bekommt. Gruß Jörg2 Punkte

-

Es ist einfach wirklich unglaub schön und gelungen, zumindest finde ich das. Die Designs sind absolut auf der Höhe der Zeit. Schlicht, Hochwertig, aber der Gewisse Alien Touch. Ich find es auch toll, das mittlerweile eine 5070 Konfiguration des 51 zur Verfügung steht. So kommt man in den Genuss des tollen Design schon ab 2899 EUR für das 18er oder 2549 EUR für das 16er. Ich habe mein letztes Alien nicht in der höchsten Kinfiguration gekauft und lag auch bei ca. 2.700 EUR - damit komme ich seit 2019 sehr gut zu recht. Wenn man dann wieder 5 bis 6 Jahre Ruhe hat, genügt mir das. Aber abwarten, was die Preise so machen. Ein A51 16 mit u7 und 5070 für ca. 2.000 € das wär's für mich.2 Punkte

-

Laden ist klar, das ist nichts Besonderes. Geht mir darum, ob es inzwischen möglich ist, das AW mit'm USB-C Netzteil dauerhaft zu betreiben, entsprechend dann mit eingeschränkten Powerlimits. Bei der Konkurrenz gibt's das ja schon länger. Fand's recht praktisch, wenn ich mal für 1-2 Tage von der Arbeit weg musste und eh wusste, dass ich nicht zum Zocken komme. Musste das Zeug zuhause dann nicht abbauen und nur das kleine (140w) USB-C Netzteil einpacken. Sind halt alles so kleine Sachen, die bei dem AW-Preispunkt einfach drin sein müssen mMn.2 Punkte

-

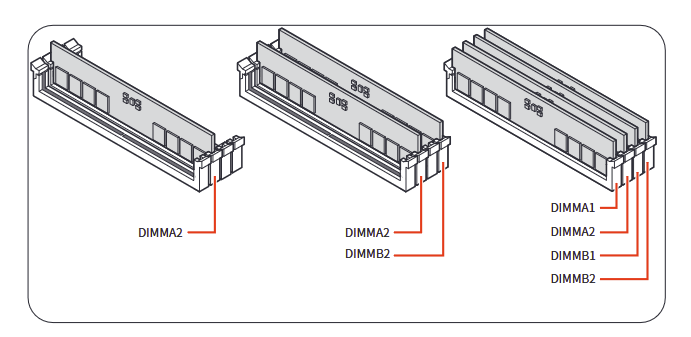

Ich halte mich bei OEM/ AW Kisten mittlerweile eher zurück. Weicht einfach zu oft vom üblichen Standard ab und möchte nichts falsches sagen/ empfehlen. Zum Thema: Vermutlich Dual Channel, weil bei zwei Sticks man RAM Kanal A und RAM Kanal B nimmt, normalerweise A2 und B2. Das würde auch bei vier RAM Sticks nicht anders sein, Kanal A (A1, A2) und Kanal B (B1, B2). So sieht das üblicherweise aus und wäre die Konfig, wie man die Sticks einsetzen würde: Dual Channel ist es ab dem Moment, wo man RAM Kanal A und B verwendet, also mit 2 oder 4 Sticks. Solche Informationen kannst auch gut in HWinfo64 überprüfen. Im Menü, nicht im Monitoring. Hatte hier vor vielen Jahren mal eine Anleitung geschrieben, da siehst du das auch:2 Punkte

-

2 Punkte

-

Ich beziehe mich mal auf Video von Hardwaredealz - Mainboard = kein Standard - Netzteil inkl. Stecker = Kein Standard - Kühler-Mount = kein Standard - Lüfter-Mount = Standard (unsicher) - RGB-Beleuchtung = kein Standard - Keine Kühlkörper auf SSD, RAM oder VRM - Nur zwei SSD Slots - Keine Lüfter im Top - BIOS nur peinlich Dazu dann der Preis... Auch mit AW Logo ist und bleibt es ne OEM Kiste, die in vielen Punkten signifikant schlechter ist, als irgendein Standard PC. Somit müssten AW Desktops schon mal gänzlich uninteressant sein. Hast ja den Vergleich. Ändert ja nichts an meiner Aussage. 30-90 Minuten YT gucken. Dann biste wieder auf Höhe der Zeit. So wie ich und jeder andere irgendwann bei Null angefangen hat, nur dass man es heute deutlich einfacher hat. Zum einen sind die Systeme heute "idiotensicherer", sprich deutlich schwieriger kaputt zu bekommen und zum anderen ist die Informationsdichte wesentlich größer. Zu fast jeder Frage lassen sich zig Foreneinträge und Videos finden. Aber wie gesagt, wenn man darauf keine Lust hat, lässt man sich die Kiste halt bauen. Was ich nicht wirklich verstehen kann, sind irgendwelche Umbau-/ Tuning- oder Upgrade-Maßnahmen bei den AW-/OEM Desktop-Kisten. Man kauft die Dinger ja primär, weil man nicht dran rumfummeln möchte. Wie es dann mit Garantie/ Premium Service aussieht, ist auch bedenklich, wenn da keine Dell-verifizierte Hardware drin ist (Anspielung auf den Area51, wo alles plötzlich besser sein soll). Aus geschäftlicher Sicht sowieso fraglich, ob man als Hersteller will, dass dort Non-Dell Parts reinpassen sollen.2 Punkte

-

Suche doch einfach mal, mit einem metallenem Gegenstand, das Palmrest bzw. den Deckel nach einer magnetischen Stelle ab. Hier die Positionen von einem Inspiron Gerät: https://www.dell.com/community/en/conversations/inspiron/inspiron-15-5567-lid-switch-reed-or-hall-location/647f828ef4ccf8a8de14ac312 Punkte

Diese Rangliste nutzt Berlin/GMT+01:00 als Grundlage

.thumb.jpg.4024e90166344449a9704f4ff655f0eb.jpg)

.thumb.jpg.6a0f1c2eecba90d71541704934e25071.jpg)