-

Gesamte Inhalte

1.967 -

Benutzer seit

-

Letzter Besuch

-

Tagessiege

274

Inhaltstyp

Profile

Forum

Downloads

Treiberreihenfolgen

Alienware Geräte-Lexikon

Alle Inhalte von Sk0b0ld

-

Das ist so nicht ganz richtig. Das habe ich nachweislich (Thread) in verschiedenen Konstellationen getestet und mit einer Wärmepistole nachgemessen. LM (auch schon ein Repaste mit besserer Paste) kann beispielsweise dafür sorgen, dass sich Palmrest, Tastatur usw. stärker erhitzt, weil durch den besseren Wärmeleitwert sich mehr Hitze in die gesamte Heatsink verteilt und damit alle umliegenden Teile mehr Wärme abbekommen/ aufnehmen. Die Hitze, die sonst bei der CPU wäre, ist dann woanders im Gehäuse. Ein klassisches (anderes) Beispiel war da der AW17 R4/ R5, den man gerne hinten angehoben hat, um bessere Temps auf CPU und GPU haben. Das hat auch gut funktioniert, jedoch auf Kosten von Gehäuse-, PCH-, RAM-Temps usw. Höher takten allein entscheidet noch nicht über die Leistung. Ist halt ein Unterschied, ob ich 4,8 Ghz im idle laufen habe oder im Gaming unter Last, Package Power ist da entscheidender. Mehr Kühlleistung erlaubt einen größeren Headroom für Rechenleistung. Gleichzeitig erlaubt auch eine bessere Kühlung (z.B. durch Repaste, Kühler etc.) bei gleichbleibender Leistung einen leiseren Betrieb. Ja, im Out of the box Zustand kann man das vielleicht so sehen. Area 51m mit +200w PL mal außen vor gelassen. Beim m15 R1 und R2 war es mit LM und Kühler absolut kein Problem in die PLs mit der CPU zu laufen. Im Gaming kann das bei einer Shared-Heatsink durchaus was anderes sein, aber mit solchen PLs macht auch CPU benchen ein wenig Spaß und da sind 90w, 110w etc. alles noch über einen gewissen Zeitrahmen kühlbar. Kann ich gut nachvollziehen. Sind jetzt nicht unbedingt die Geräte, an den man sich versuchen sollte. Aus meiner Sicht ist das bei den neuen Geräten auch nicht unbedingt notwendig. Wenn man bei WLP bleibt, kann man's sich eigentlich sparen, weil der Kühlungsvorteil sehr gering sein wird. Wenn man schon ein Repaste macht, dann am besten gleich auf LM, damit sich's auch lohnt. Solange du mit deiner Leistung und den Temps zufrieden bist, brauchst auch gar nichts "verschlimmbessern". Es gibt halt Leute, die die volle Leistung bezahlt haben und diese dann auch, im besten Fall dauerhaft sehen wollen (ich zähle mich dazu). Unter Umständen kommt man um LM, Kühler usw. nicht drum herum. Auch aus anderen Gesichtspunkten kann ein Kühler oder LM Sinn machen. Mit dem Kühler beispielsweise bleiben die Lüfter des Notebooks im idle vollständig aus und unter Last braucht man deutlich weniger RPM für die gleiche Kühlleistung. Temperaturen von PCH, SSDs, RAM, aber auch VRM oder Gehäuse können da einem wichtig sein. Beispiel: Drosselung durch PCH-Temps im m15 (Repaste m15 + testing). LM hab ich in meinem m15 drin, weil damit auch die Passiv-Kühlleistung steigt und durch die nicht-drehenden Lüfter der Akku länger durchhält.

-

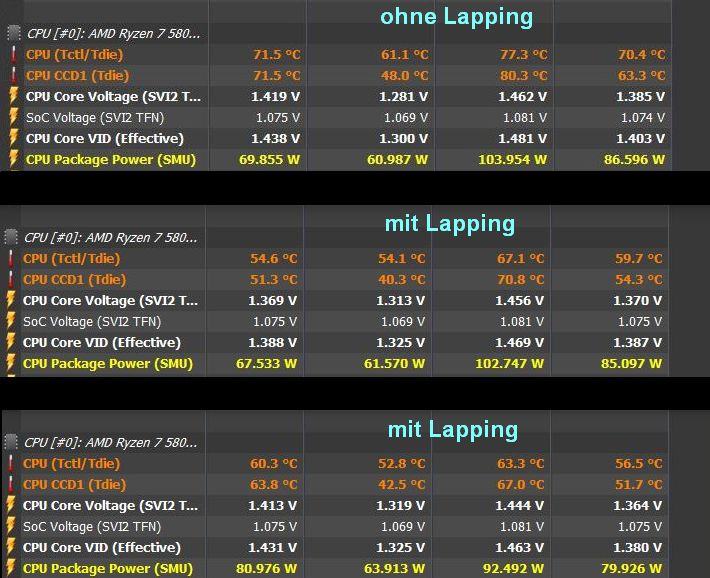

Jetzt nach dem Lapping kann ich das nicht exakt sagen, aber ich wollte das noch ohnehin austesten. Sonst so normal waren das knapp 150w in CB R23, mein ich (bin mir gerade nicht sicher). Beim 9900KS war mit der AIO 220w kein Thema. Der ließ sich weitaus einfacher kühlen. Also in meinem Testing hat sich gezeigt, dass ich mich nicht zwingend auf Takt verlassen kann, wenn's um Leistungsbewertung geht. Captn hatte es auch mal kurz angesprochen. Bei Ryzen ist der Effective Clock auch sehr wichtig. Im Daily-Setting habe ich den 5800X im PBO bei +50Mhz und im CO mit -19 all Core. Ist für mich so der beste Mix aus undervolting und bisschen optimieren. OC hat bei mir am besten mit festen Multi und Vcore funktioniert (PBO aus). Mach ich mal heute Abend, wenn's zeitlich passt. Dann hab ich auch gleich die Watt-Werte.

-

Man merkt halt das Frank Azor nicht mehr bei Alienware ist. Zu Zeiten wo er noch im Unternehmen war, waren die Geräte sicherlich auch nicht perfekt, aber irgendwo waren sie doch immer noch ein Alienware und das hat man gemerkt.

-

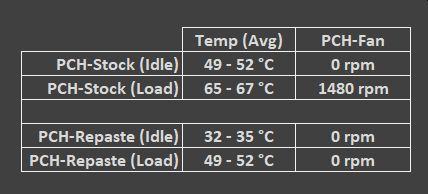

Deswegen habe mich mir die Kristall-Lightbars von den Royals geholt. Die kann man einzeln für paar Euros kaufen. Die verfälschen nicht die Farbe und leuchten um Welten besser. Passen sowohl auf die Neos als auch auf die Trident-Z RGB. Auf Seite 7 und 8 habe ich mehrere Bilder dazu. Der Tausch der Lightbars ist sehr einfach. Grundsätzlich hat mich mein Chipsatz-Lüfter nicht genervt, aber nach dem Repaste (siehe Beitrag zuvor) läuft der sowas von deutlich kühler, dass er im Betrieb, egal ob Zocken oder OC/ Bench-Session nun dauerhaft aus bleibt (wird einfach nicht mehr heiß genug). Lediglich beim Hochfahren geht er im POST kurz mal an. Sind gerade mal 10-15 Minuten Arbeit und hast dauerhaft bessere Temps aufn PCH. Zum VRM-Kühler kann ich nichts sagen, hab ja kein und mein VRM ist meilenweit von irgendwelchen kritischen Temperaturen entfernt. Ich denke, so viel anders wird das bei dir auch nicht sein. Soweit ich weiß, bringt der kleine Quirl eh fast nichts. Steck ihn doch einfach ab, wenn er dich nervt. Den Rest regelt die Gehäusebelüftung und die VRM-Heatsinks schon. Was haut denn dein 5800X mit der Wakü im CB R23 raus? Auch OC Werte würden mich mal interessieren. Was Temperaturen betrifft, hat Lapping (siehe oben) bei mir unheimlich viel gebracht. Ansonsten, schönes System. Freut mich zu sehen, was aus deinem Build geworden ist. GPU passt nicht so ganz ins Setting, aber das ist schon länger eh ein schwieriges Thema. Übrigens, laut einigen Usern aus dem HWLuxx Forum, war wohl der Button "Add" zwar da, soll aber wohl nicht funktioniert haben. Keine Ahnung ob's stimmt. Noch bin ich mit dem 5800X zufrieden. Wenn sich ne Gelegenheit ergibt, gucken wir mal.

-

Find das grau/ schwarz auch deutlich ansprechender. Die vorkonfigurierten Optionen sind jedoch.... ich sag mal langweilig.

-

Alienware m17 R4 Alienware m17 R4 Erfahrungsbericht

Sk0b0ld antwortete auf pitha1337's Thema in Erfahrungsberichte & Benchmarks

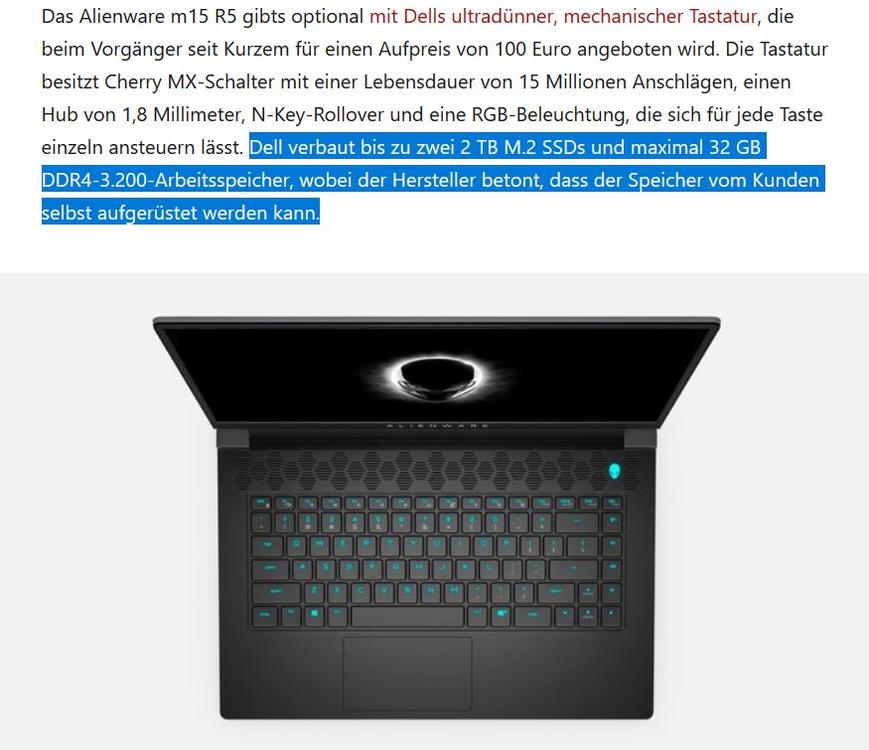

NotebookCheck (Link) behauptet das. Ich könnte schon durchaus vorstellen, dass das stimmt. War ja von Anfang ein massiver Kritikpunkt. m15 und m17 werden wie schon immer vom Mainboard-Layout, zumindest in diesem Punkt, identisch sein. -

-

Alienware m17 R4 Alienware m17 R4 Erfahrungsbericht

Sk0b0ld antwortete auf pitha1337's Thema in Erfahrungsberichte & Benchmarks

Gar keinen. Ist alles leider festgelöteter RAM. Erst das (noch kommende) m15/17 R5 haben wieder zwei Slots für SO-DIMM. Dann wohl aber auch bis 3.200 MHz XMP (D.O.C.P.) Unterstützung. -

Anders als bei der 2.000er Serie, hat NVIDIA die 3080 ordentlich beschnitten. Ich vermute mal, dass damit auch das Limit von den genannten 165w TGP begründet ist. 200w gingen ja bei den Notebooks vorher auch, zumindest war es rein technisch gesehen kein Problem (auf's Board-Layout bezogen). Dass NVIDIA den Boardpartner wenig Spielraum lässt, ist nichts neues. Ich weiß nicht, ob's nur mir so geht, aber irgendwie reizen mich Notebooks nicht mehr so sehr, wie das noch vor 1-2 Jahren der Fall war. Zu Zeiten der 2.000er RTX Serie kamen Notebooks wie das Area 51m problemlos an Desktop-Leistung ran. Heute muss man irgendwie einen Mix aus Leistung und Kompromissen eingehen und die Leistungsschere zwischen Desktop-Systemen und Notebooks wird wieder größer.

-

Hab nun komplett auf die Cooler Master MF 140 Halo Lüfter gewechselt. Gleiche Performance (bei 1.000rpm) wie die Alpenföhn Wingboost 3, dabei aber noch mal ne ganze Ecke leiser. Sehr empfehlenswerte Lüfter mit schicker Beleuchtung und gutem Preis-/ Leistungsverhältnis. Leider sind die Cooler Master Lüfter, zumindest in der 140mm Variante, aktuell nur in China zu bekommen.

-

Alienware 15 R3 AW 15 R3 Blackscreen

Sk0b0ld antwortete auf Stark22's Thema in Allgemeines & Troubleshooting

Wenn du mit einem Lötkolben umgehen kannst, kannst dir auch ganz einfach selbst den Ersatz fertig machen. Die verwendete Knopfzelle ist eine CR2032. Rotes Kabel kommt auf + (Oberseite) und schwarzes auf - (Unterseite). Anschließend Schrumpfschlauch/ Isoband drüber, fertig. Ansonsten würde ich mal mein Glück auf Ebay und AliExpress probieren. -

Ah ok. AMD Drop auch wieder verfügbar. 👍 Dort sind immer die besten Preise.

-

Ich vermute mal, dass du den 5950X für 889€ von Alternate verlinkt hast, oder? Der Link von dir geht leider nicht. Wie gesagt, aktuell ist es bei mir nicht akut. Wenn sich die Situation ergibt, dann ja. Welche CPU es am Ende auch wird, lappen werde ich sie wieder.

-

Ist leider wieder bei 939€. Ich warte, denk ich mal auf Warhol. Außer im Freundes-/ Bekanntenkreis will wieder jemand meine Hardware. Dann wird's wohl ein 5900X/ 5950X.

-

Ist ja schon langsam echt ein fairer Preis für den 16-Kerner. Danke für den Link. Ich war auch zwischendurch am überlegen, aber der gelappte 5800X läuft echt gut in meinem System. Wenn ich upgrade, dann wahrscheinlich auf AMD's letzte CPU-Reihe (Warhol), die für den AM4 Sockel kommt. Angeblich soll Ryzen 6000 wohl Mitte des Jahres schon erscheinen/ vorgestellt werden. Ich glaub da zwar nicht dran, aber das sehen wir dann. Quelle: PC Magazin

-

Das geht natürlich auch, ist aber eher was für die absoluten Rekordjäger. Den DIE schleifen ist halt auch mit sehr viel Risiko verbunden. Da man Ryzen 5000 nicht wirklich köpfen kann und Direct-Die sich dahingehend eh erledigt hat, ist das normale lapping/ schleifen des IHS eine gute Möglichkeit seine Temps zu verbessern. Ich bin immer noch begeistert wie gut das Endresultat ist. Also das mit dem Chipsatz muss man einfach mitnehmen. 10-15 Minuten Arbeit und gleich dauerhaft 15-20°C weniger. Zwar habe ich meinen PCH-Lüfter auch nie wirklich gehört, aber nun bleibt der PCH im Betrieb so kühl, dass der Lüfter dauerhaft ausbleibt. Ich denke, ein paar Grad wird's wohl ausmachen. Ist halt die Frage, ob du Lust hast dafür Geld auszugeben. Ich habe für 8g um die 12€ bezahlt, was angesichts der Menge und der Leistung absolut klar geht. Lässt sich super verteilen die Paste (Link). Das sind normale Temps für den X570 Chipsatz. Ab 65°C (zumindest bei mir) fängt der Lüfter an zu arbeiten. Ja, PCH (Platform Controller Hub = Chipsatz, ist die gleiche Bedeutung. Das Wort "Chipset" (deutsch Chipsatz) rührt einfach nur von den alten Systemen her, wo der Chipsatz aus der North- und South-Brigde bestand. Man ist halt bequem und belässt es bei dem alten Namen, weil jeder eh weiß, was gemeint ist. Heißt ja auch oft Chipset-Driver und nicht PCH-Driver.

-

Das müssen erst die Tests und Benchmarks zeigen. Im mobilen Sektor ist Ryzen nicht zwingend besser als Intel. Siehe Vergleich von Jarrod hierzu: Mit sehr großer Wahrscheinlichkeit leider nicht. Die OLED Panels gab es bislang immer nur bis max. 15" bei Notebooks. @Nuestra danke für die Fotos, wäre aber etwas schöner, wenn du die Bilder zuschneiden könntest. Dann kann man deinen Beitrag auch leichter lesen und die Bilder besser erkennen. Normalerweise kannst du bei jedem Handy direkt nach dem Screenshot das aufgenommene Bild zuschneiden. Bislang hatten alle meine Handys nach dem Screenshots die Buttons hierfür angezeigt. Ist halt der "Zuschneiden-Button". Dauert nur 2-3 Sekunden länger.

-

Alienware m15 R5 mit Ryzen (JarrodTech - Youtube) Damit ist der AGA Anschluss wohl auch Geschichte.

-

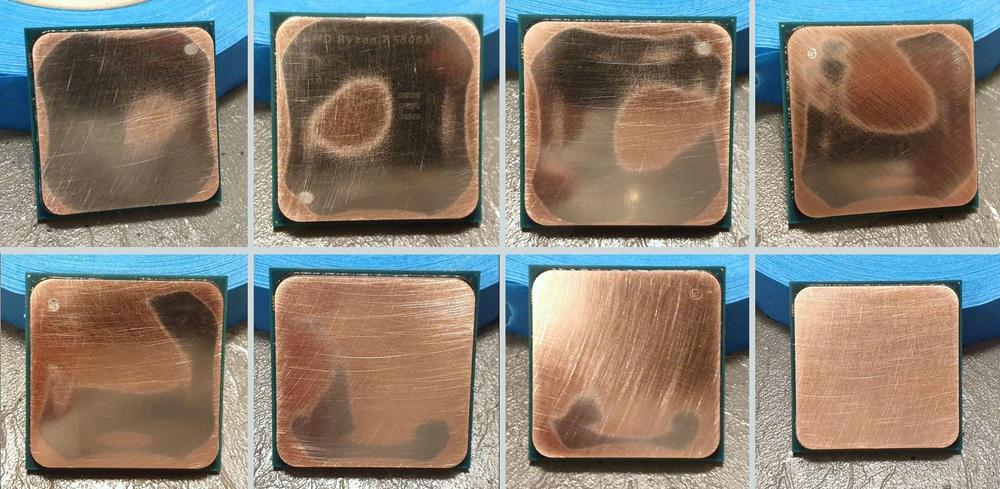

Ich konnte die Finger doch nicht still halten und habe nun meine CPU und die AIO abgeschliffen (lapping). Nun verstehe ich auch warum die Temperaturen so waren, wie sie waren. Wenn man Ryzen 5000 (auch schon 3000) hat und eine Asetek-Pumpe, was bei den meisten AIOs der Fall ist, kann sich Lapping zum Teil wirklich erheblich lohnen, weil sowohl die Kühlplatte als auch der IHS konvex ist. Zwei konvexe Oberflächen, die übereinander liegen, sind natürlich nicht so optimal für die Kühlung. Igor hatte die IHS-Thematik auch mal erwähnt. (Beitrag) Nun passen die Temperaturen auch wieder. Bei mir sind's jetzt konstant 10-12°C weniger auf der CPU und die hohen Spikes sind auch nicht mehr da. Hier mal einige Fotos, wo man auch mal sehen kann wie uneben die CPU eigentlich ist: Wirklich schlimm ist/ war aber eigentlich die AIO. Die war im Verhältnis zu der CPU sehr konvex und entsprechend musste viel abgetragen werden. Scheinbar sind die Kühlplatten für die Intel CPUs ausgelegt. Wenn man sich den Beitrag von Igor anschaut, würde die konvexe AIO perfekt in den konkaven IHS der Intel CPU passen. Jetzt, wo beide Oberflächen plan sind, kühlt es natürlich am besten, weil über den vollen IHS der Kontakt zur Kühlplatte gegeben ist. Ich bin mit dem Ergebnis mehr als zufrieden und bin froh, dass ich es doch gemacht habe. Im selben Zuge habe ich auch gleich mal den X570 Chipsatz gerepastet. Ich bin auf das Thema durch einen Reddit-Beitrag aufmerksam geworden, weil ein User behauptet hat, dass er durch einen Repaste 15-20°C teilweise rausgeholt hat. Da hab ich mich natürlich nicht lange bitten lassen und kann nun die behaupteten Ergebnisse ebenfalls bestätigen. Mein PCH-Lüfter bleibt jetzt auch unter Last dauerhaft aus. Das Wärmeleitpad, falls es überhaupt eins war, war totaler Müll. Der Repaste des Chipsatzes geht sehr einfach und schnell. Den Repaste des Chipsatzes und der CPU habe ich mit Arctic's neuer MX-5 gemacht. Eine absolut zu empfehlende Wärmeleitpaste. Aktuell meine Paste der Wahl.

-

AW2721D

Alienware AW2721D QHD-Monitor 240Hz

AW2721D

Alienware AW2721D QHD-Monitor 240Hz

Sk0b0ld antwortete auf OldMan13's Thema in Alienware Zubehör

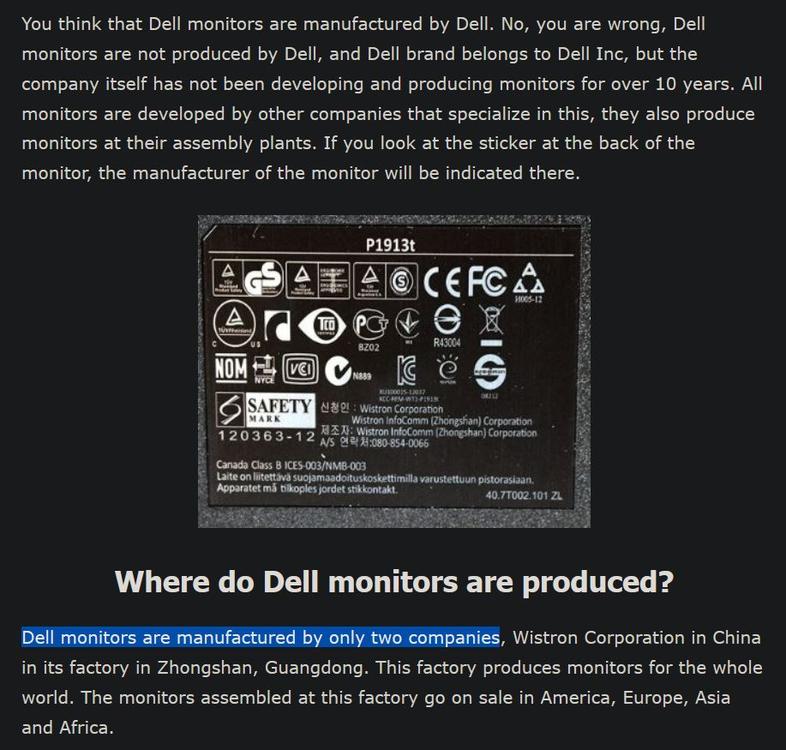

Ok, schon mal danke. Das AUO Panel bezog sich auf die 27" 1440p IPS 240Hz Variante, die zumindest laut -diesem- Bericht immer auf dem AUO Panel basiert. Daher hat's mich interessiert, von wem dein Panel bei großen 38"Zoller ist. Hatte da so auf dem ersten Blick nichts gefunden. -

AW2721D

Alienware AW2721D QHD-Monitor 240Hz

AW2721D

Alienware AW2721D QHD-Monitor 240Hz

Sk0b0ld antwortete auf OldMan13's Thema in Alienware Zubehör

Mit den Monitoren ist es genau das gleiche wie mit den Notebooks beispielsweise. Dell ist wie immer nur Auftraggeber, labelt die Monitore aber oft als Dell irgendwas um. Bei den Alienware-Monitoren bin ich mir gerade nicht sicher, ob sie die überhaupt umlabeln, sprich die Panels. Gibt nur wenige Hersteller auf der Welt, die überhaupt solche IPS-Displays fertigen können. Ich meine gelesen zu haben, dass dort ein Panel von AU-Optronics drin ist. -Hier- im Artikel steht auch drin, bei welchen zwei Herstellern Dell ihre Monitore fertigen lässt. @captn.ko Von welchen Hersteller ist dein Panel eigentlich? (Kannst du über HWinfo relativ einfach sehen). -

Alle Modelle (Notebooks) Bios beim M17X zurück setzen

Sk0b0ld antwortete auf BlackMile's Thema in Allgemeines & Troubleshooting

Die Version von der CD installiert. -

Alle Modelle (Notebooks) Bios beim M17X zurück setzen

Sk0b0ld antwortete auf BlackMile's Thema in Allgemeines & Troubleshooting

Und wieso willst du dein BIOS zurücksetzen, wenn du nur dein System formatiert hast? Das eine hat doch mit dem anderen nichts zu tun. Gleiches gilt auch für das Command Center. Warum müssen deiner Ansicht nach das Command Center und das BIOS die gleiche Versionsnummer haben? Die Beleuchtung wird nicht über's BIOS gesteuert, sondern über'n ENE Super I/O-Chip (ENE KB930), siehe Schaltdiagramm. Ist zwar bei mir schon sehr lange her, aber soweit ich mich erinnern kann, hatte ich auch einmal bei meinem M17x R4 Probleme mit dem Command Center und der Beleuchtung. Aus irgendeinem Grund konnte ich immer nur die Command-Center Version installieren, die auf der beiliegenden Alienware-CD war. 779810159_AW17xR4SchematicDoc.pdf -

Alle Modelle (Notebooks) Bios beim M17X zurück setzen

Sk0b0ld antwortete auf BlackMile's Thema in Allgemeines & Troubleshooting

Du kannst es versuchen. Würde mich aber wundern, wenn es daran liegen sollte. Normalerweise führt man diesen sogenannten "Power Drain" durch, also den Power-Knopf einige Sekunden drücken, nach dem der Akku entnommen wurde, um die Restspannung, die ggfs noch in den Kondis sitzt, zu entladen. Das hat so erstmal keinen Einfluss auf den BIOS-Chip, sondern ist nur eine Sicherheitsmaßnahme, wenn man vor hat an der Platine zu arbeiten. @M18x-Oldie Genau das wollte ich auch schon fragen. Warum/ Wann genau ist das Problem aufgetreten? Wie äußert sich das Problem? Was heißt für dich genau zurücksetzen? Nur die Settings oder auf eine ältere Version etc. Desto mehr Infos, desto höher die Wahrscheinlichkeit, dass man dir helfen kann. -

Alle Modelle (Notebooks) Bios beim M17X zurück setzen

Sk0b0ld antwortete auf BlackMile's Thema in Allgemeines & Troubleshooting

So wie bei fast jedem anderen BIOS vermute ich mal: - CMOS Batterie für einige Minuten/ Sekunden abklemmen - oder ins BIOS gehen (falls möglich) und Default Settings laden

.thumb.jpg.1afc22fba82eb3dea36a3a655cb85320.jpg)

.thumb.jpg.eb908d2d9a6a31a9dffd299cb9ff88a2.jpg)

.thumb.jpg.a783636b2466616770b12905ecd355eb.jpg)

.thumb.jpg.f0578a6a70862f79e7979dfe4d27e684.jpg)

.thumb.jpg.847f020e941a6e6ac10905b309d3d70c.jpg)

.thumb.jpg.1bc70d990a1f4384645c4cefe83a58d6.jpg)

.thumb.jpg.7bb0c07d146b94444e8dd72124046774.jpg)

.thumb.jpg.81829cfa2f82cd860d961e62b1363adf.jpg)

.thumb.jpg.a606850ad2a1360716a072cf276fef2e.jpg)

.thumb.jpg.fb8cbc09f1ac74a87e3e4b8e7546e700.jpg)

.thumb.jpg.4f8b5c1e61b52caafbd9ef0f73f65622.jpg)