Rangliste

Beliebte Inhalte

Inhalte mit der höchsten Reputation seit 18.09.2011 in allen Bereichen anzeigen

-

Da es gerade bei bastellustigen Alienwarebenutzern immer wieder dazu kommt, dass Grafikkarten in Notebooks verbaut werden die Dell nicht nativ angeboten hatte, werden Änderungen notwendig um den Treiber von nVidia installieren zu können. Fast genauso häufig wie dieser Treiber benötigt wird ist auch die Frage danach wie man den Treiber anpasst. Fangen wir jedoch einen Schritt vorher an. Wieso muss ein passender Treiber überhaupt erst manuell angepasst werden um installiert zu werden? Hier liegt die Verantwortung bei nVidia und deren Hardwareerkennung. Der Treiber kontrolliert leider nicht nur die HardwareID der Grafikkarte sondern die Kombination aus Notebook und Karte. Wenn nun eine dieser Kombinationen vom Hersteller, in unserem Fall Dell, nicht an nVidia gemeldet wurde taucht die ID nicht in der Erkennung auf. Und genau hier setzen wir nun an und holen dies nach. -Wie ist die HardwareID aufgebaut? -Welche Datei muss ich ändern? -Welche Änderungen müssen vorgenommen werden? -Muss ich sonst noch etwas beachten? Wie ist die HardwareID aufgebaut? Die Hardware-ID der Grafikkarte finden wir im Geräte-Manager. Wenn noch kein Treiber installiert ist heißt unsere Grafikkarte dort "Standart-VGA", "Microsoft-Standart-Anzeigegerät" oder ähnliches. Dieser Name ändert sich später durch den Treiber. Um dieses Tutorial möglichst leicht verständlich und nachvollziehbar zu gestallten ist es nicht unwichtig zu wissen wie die benötigte HardwareID aufgebaut ist. Nehmen wir uns als Beispiel eine GTX680m in einem M17xR2. PCI\VEN_10DE&DEV_11A0&SUBSYS_043A1028 VEN_10DE = nVidia DEV_11A0 = GTX 680M 043A = M17xR2 1028 = Dell Welche Datei muss ich ändern? Nachdem wir versucht haben den neuen Treiber von nVidia zu installieren und dieser Versuch abgebrochen wurde findet sich der bereits entpackte Treiber auf der Festplatte, meist unter C:\NVIDIA\DisplayDriver\VERSION\Win8_WinVista_Win7_64\International\Display.Driver\ In diesem Ordner befinden sich u.a. folgende INF-Dateien. nvaci.inf Acer, Gateway nvami.inf Asus nvaoi.inf Apple nvbli.inf HP nvcti.inf Compal nvcvi.inf Clevo nvdmi.inf Dell nvfmi.inf Fujitsu nvfui.inf Siemens nvhmi.inf HP nvloi.inf LG nvlti.inf Lenovo nvmi.inf MSI nvqni.inf NEC nvszci.inf Sony nvtdi.inf Toshiba Qosmio nvtsi.inf Toshiba Welche Datei hiervon wir nun ändern ist prizipiell egal, denn bei der Installation werden ohnehin alle Dateien nach einer passenden HardwareID durchforstet. Der Ordnung halber verwende ich jedoch die "nvdmi.inf". Welche Änderungen müssen vorgenommen werden? Kommen wir nun zum Kernthema. Es sind nur zwei Zeilen die wir der Datei hinzufügen müssen. Die erste Zeile sagt dem Treiber, dass unsere HardwareID kompatibel ist. Um die Stelle der ersten Änderung zu finden ist es wichtig zu wissen welches Betriebssystem verwendet wird. Sucht jeweils die Zeile die zu eurem OS passt. 1.1 Vista [NVIDIA_SetA_Devices.NTamd64.6.0] 1.2 Win7 [NVIDIA_SetA_Devices.NTamd64.6.1] 1.3 Win8 [NVIDIA_SetA_Devices.NTamd64.6.2] 1.4 Win8.1 [NVIDIA_SetA_Devices.NTamd64.6.3] In der Zeile darunter tragen wir nun folgendes ein: %NVIDIA_DEV.11A0.043A.1028% = Section033, PCI\VEN_10DE&DEV_11A0&SUBSYS_043A1028 Natürlich müsst ihr diese Zeile euerer HardwareID entsprechend anpassen. Die zweite Zeile die wir ändern sagt dem Treiber wie er die Karte anschließend benennen soll. Sucht die folgende Zeilen (OS ist dieses mal egal): DiskID1 = "NVIDIA Windows (64 bit) Driver Library Installation Disk 1" NVIDIA = "NVIDIA" NVIDIA_A = "NVIDIA" In der Zeile darunter tragen wir nun unsere Karte ein. In unserem Beispiel wäre dies: NVIDIA_DEV.11A0.043A.1028 = "NVIDIA Tuschkasten GTX 680M" Auch diese Zeile muss etsprechend eurer HardwareID angepasst werden. Anschließend müssen wir nur noch die Datei speichern und die Installation neu starten. Hierzu folgende Datei ausführen: C:\NVIDIA\DisplayDriver\VERSION\Win8_WinVista_Win7_64\International\setup.exe Muss ich sonst noch etwas beachten? Da der Treiber nun modifiziert ist stimmt er nicht mehr mit der digitalen Signatur überein. Bei Vista und Win7 ist dies nicht weiter schlimm. Hier muss man nur bestätigen, dass der Treiber dennoch installiert werden soll. Ab Win8 hingegen muss zuerst die Installation von nicht signierten Treibern zugelassen werden. Hierzu die Eingabeaufforderung öffnen (WinTaste+X) und folgendes eingeben: bcdedit /set {current} testsigning yes Danch Windows neu starten und den Treiber installieren. Um die Installation nicht signierter Treiber wieder zu unterbinden erneut die Eingabeaufforderung öffnen und folgendes eingeben: bcdedit /set {current} testsigning no Auch diese Änderung wird erst nach einem Neustart wirksam.25 Punkte

-

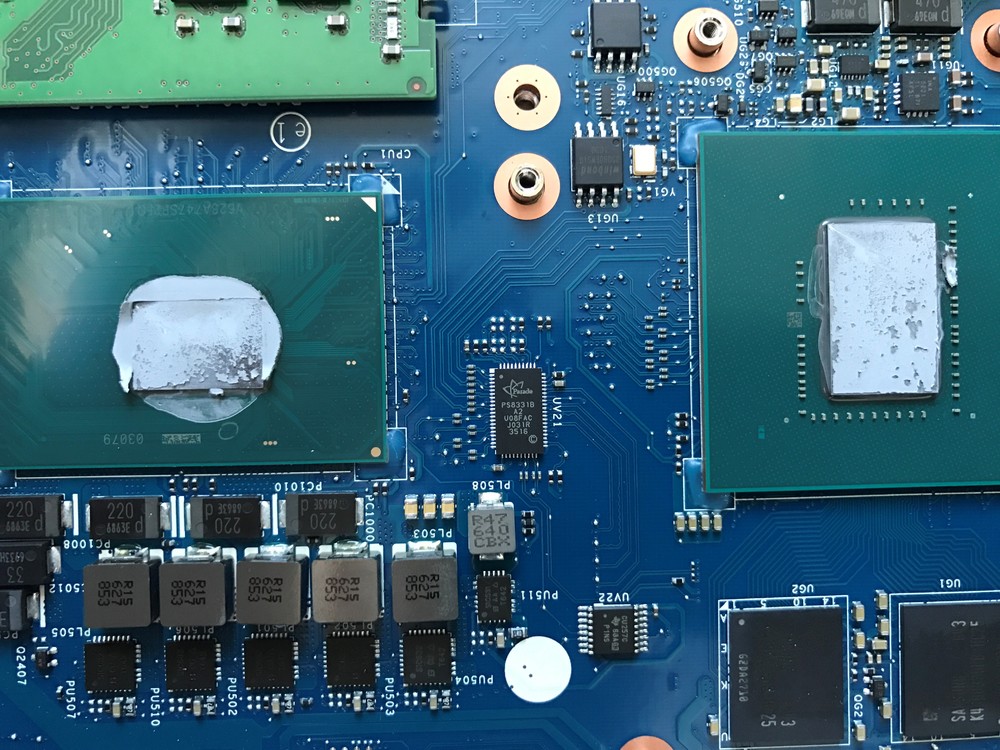

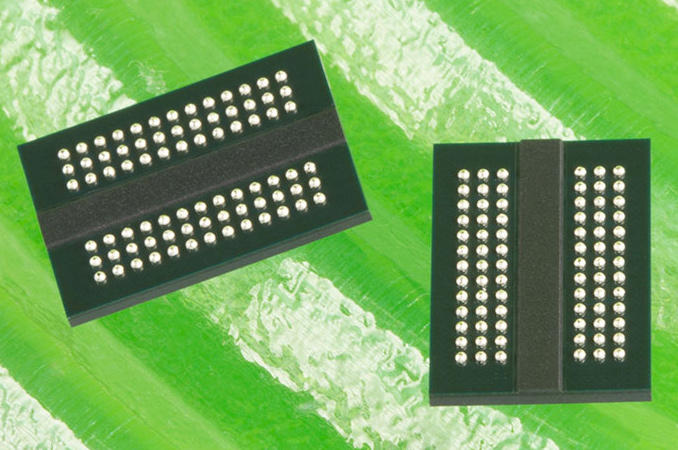

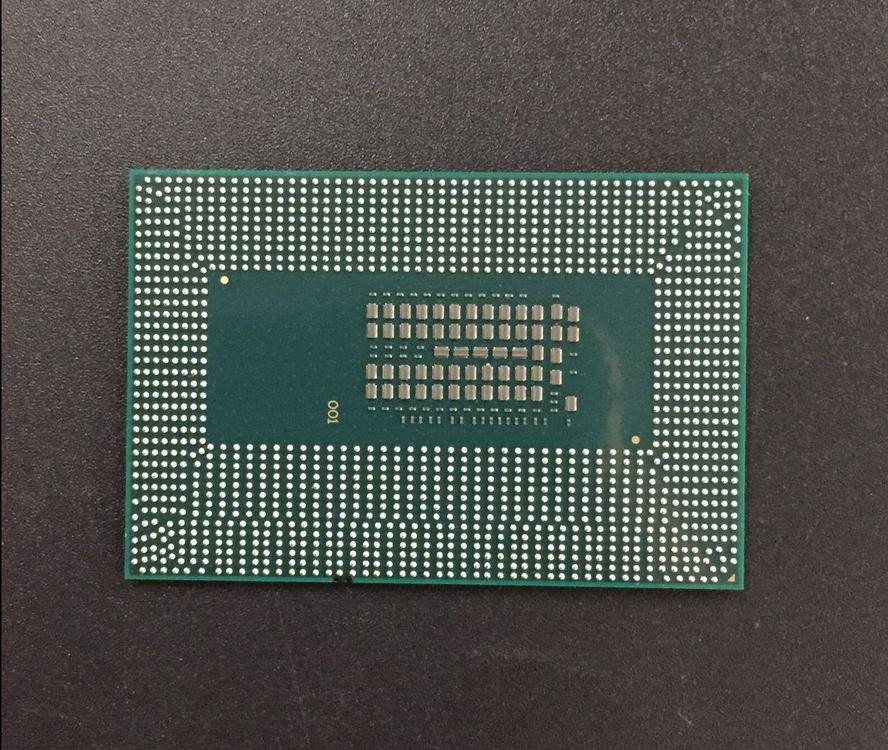

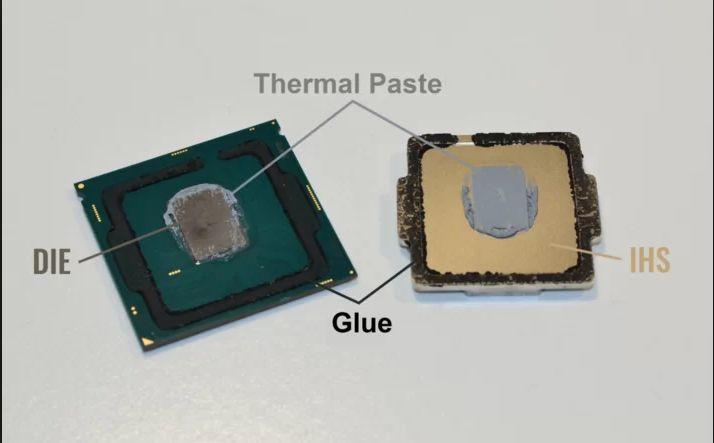

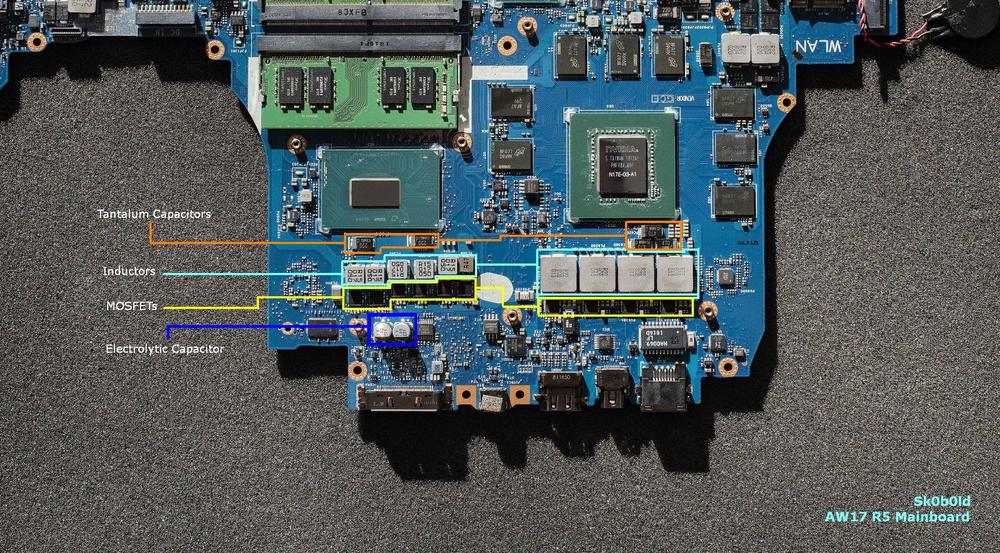

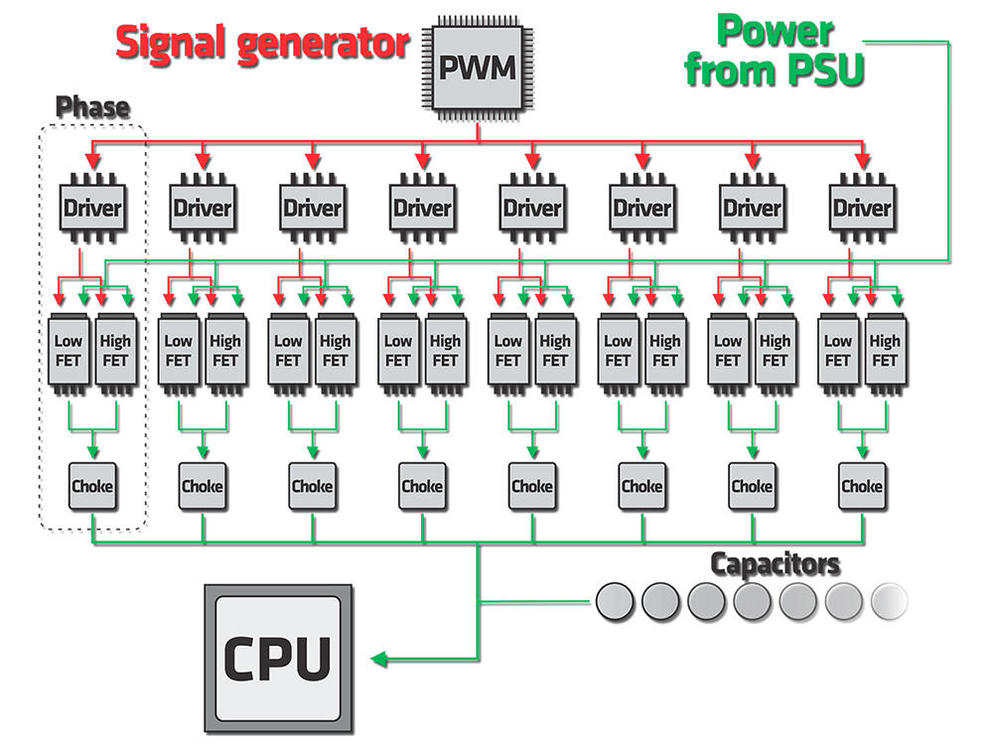

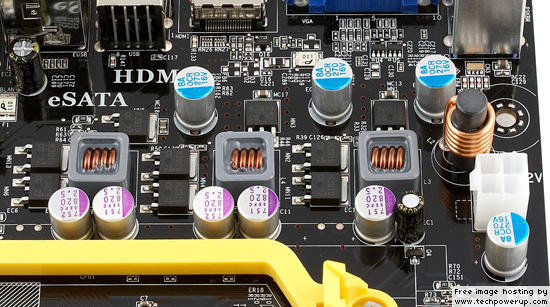

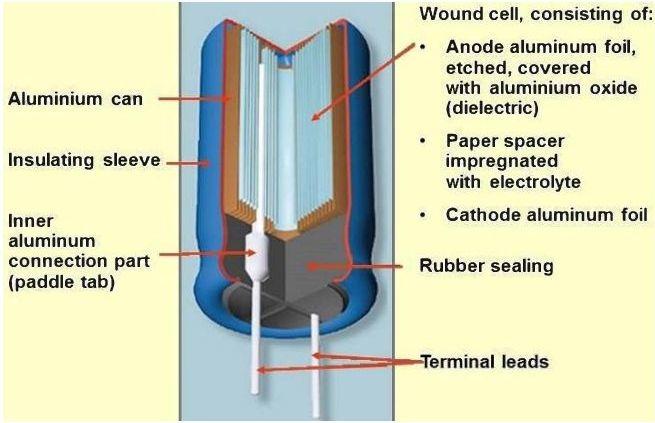

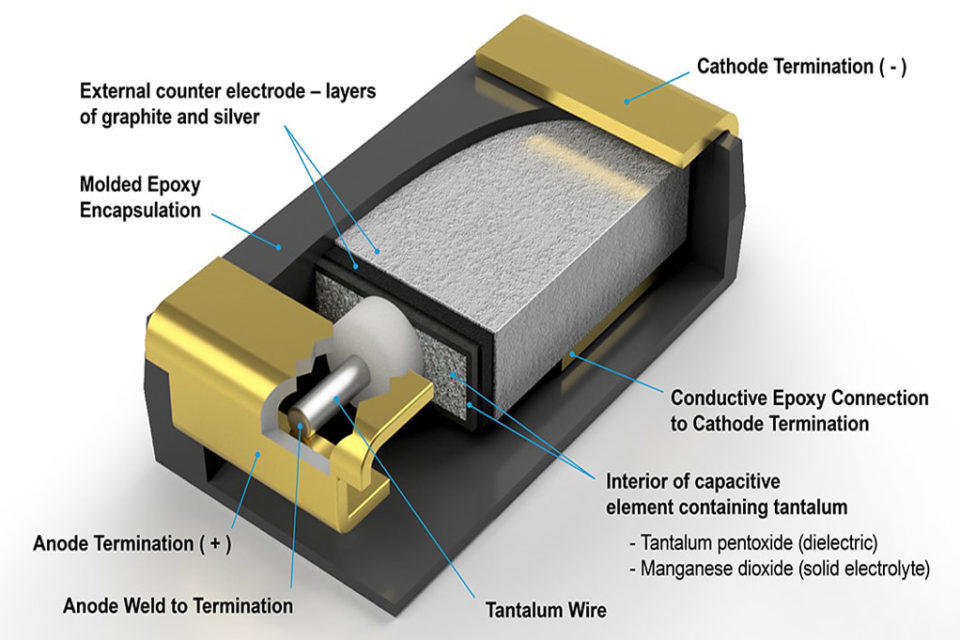

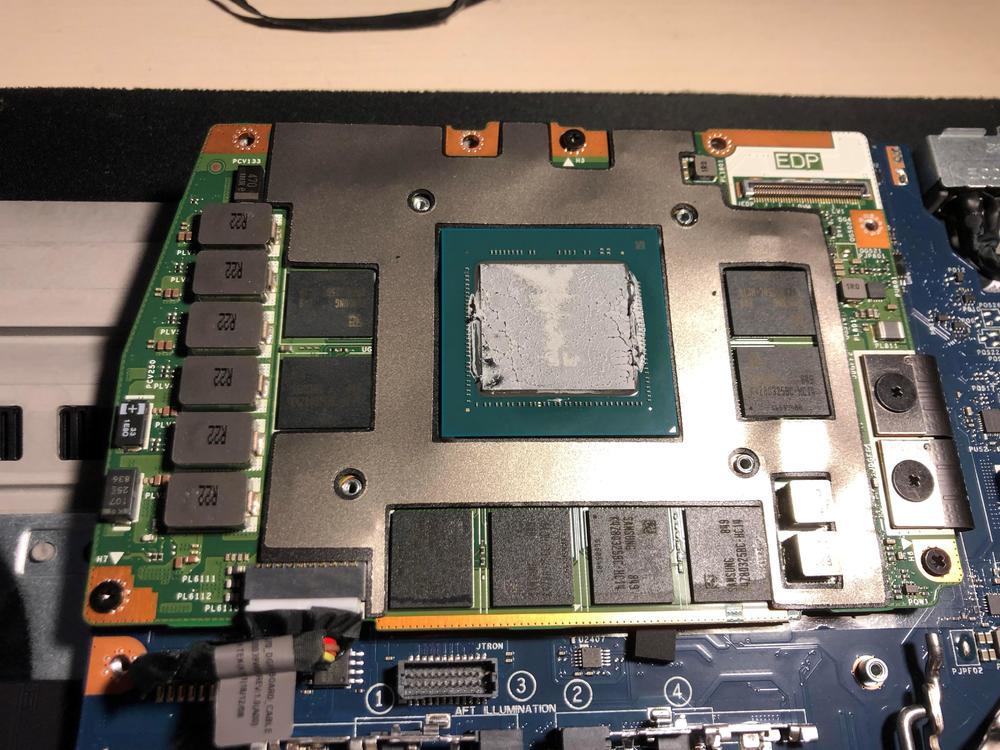

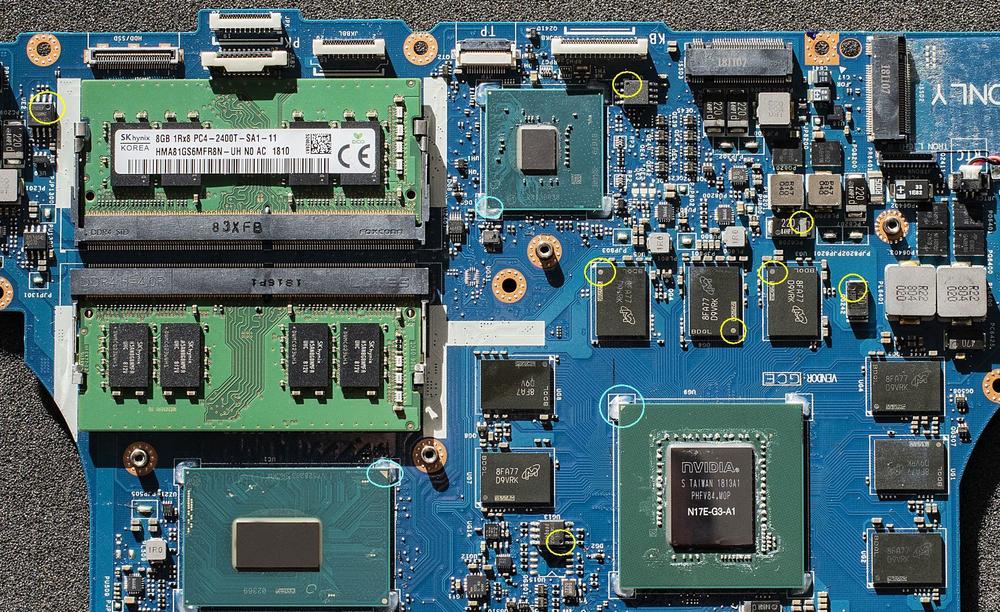

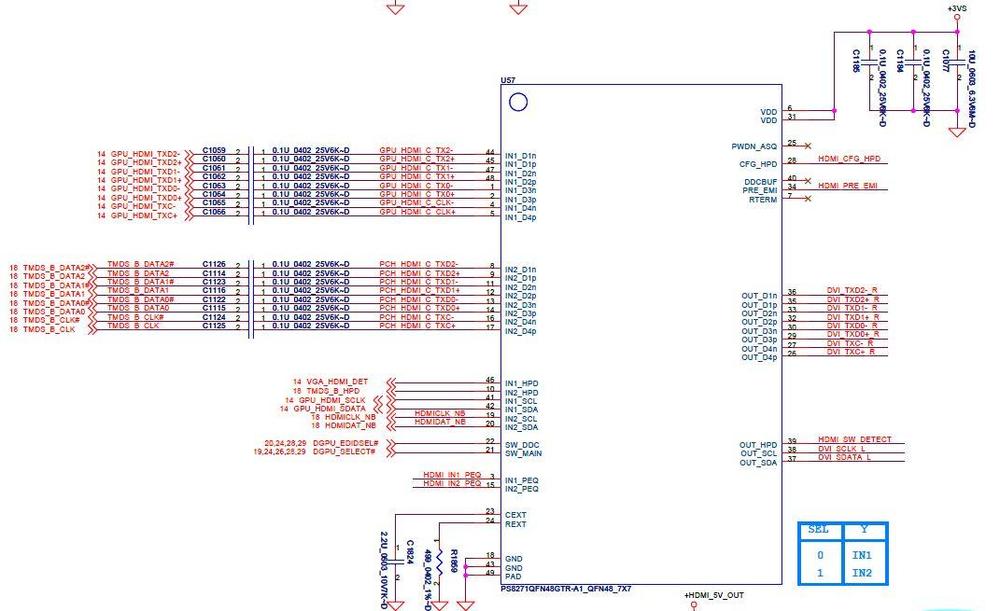

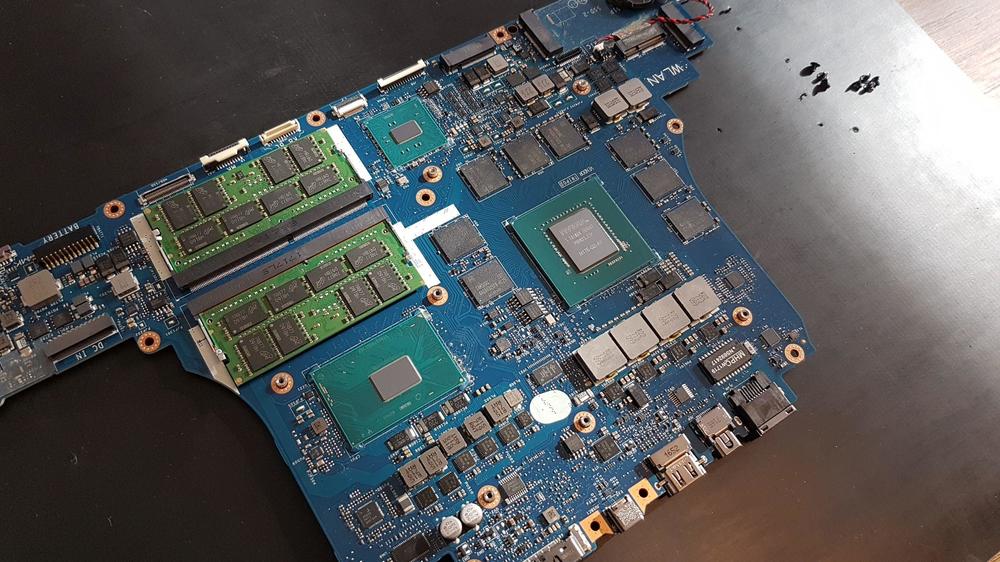

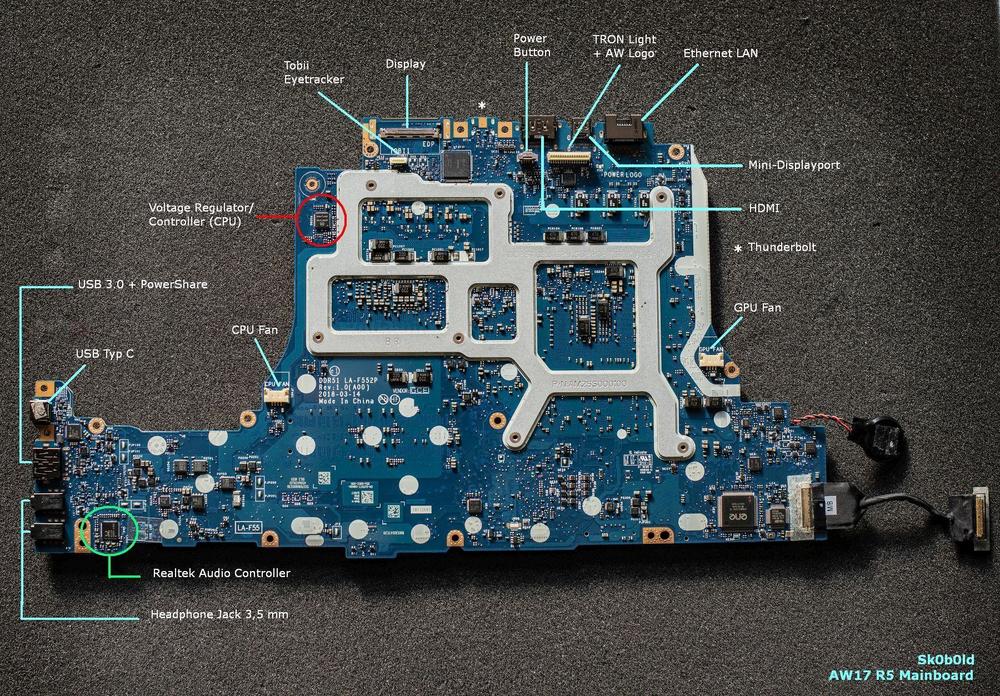

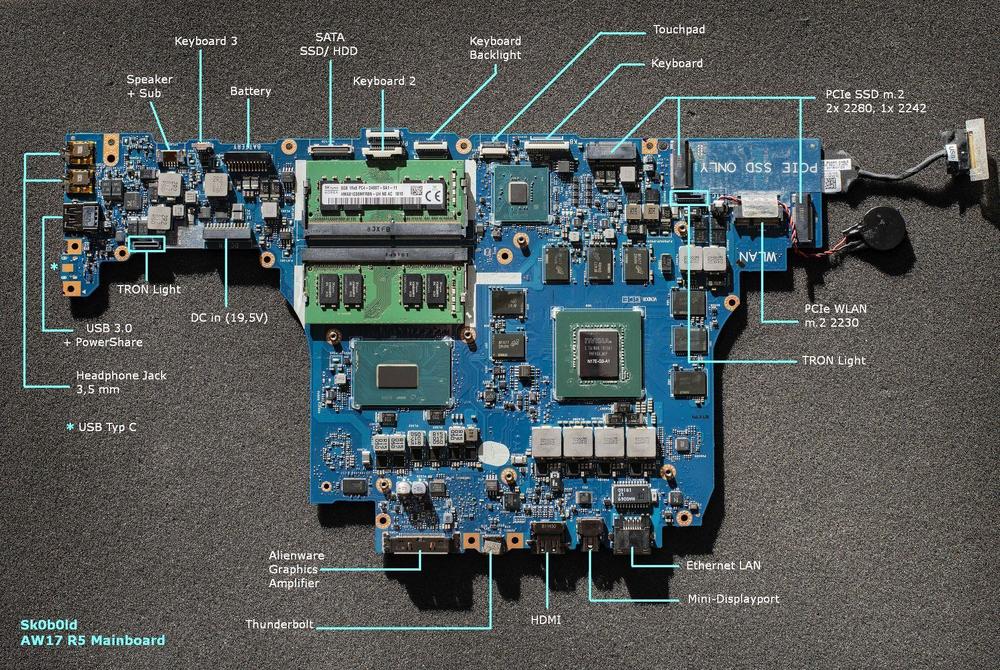

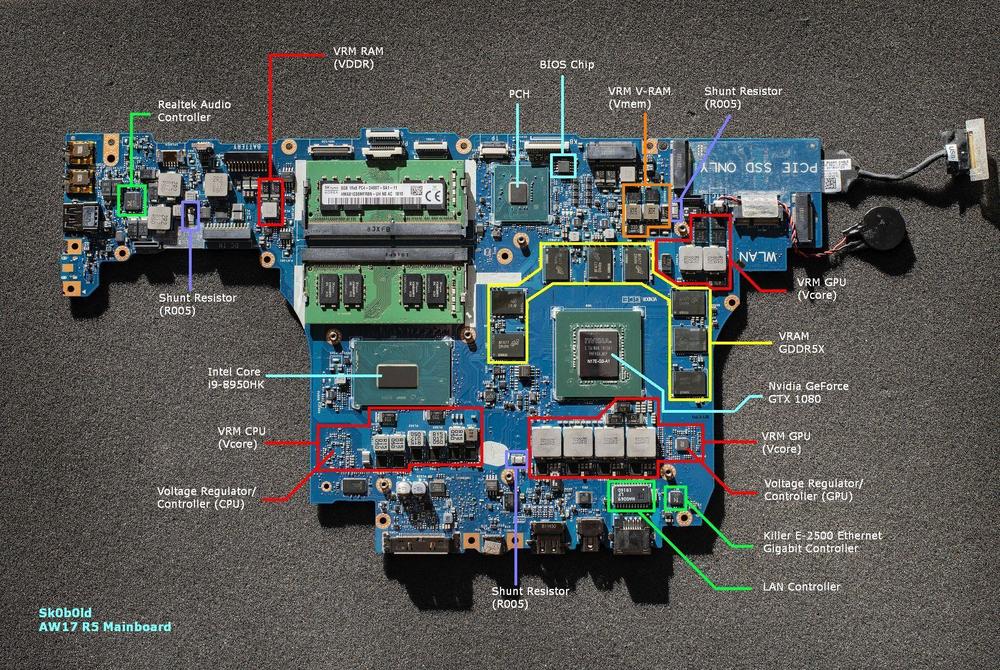

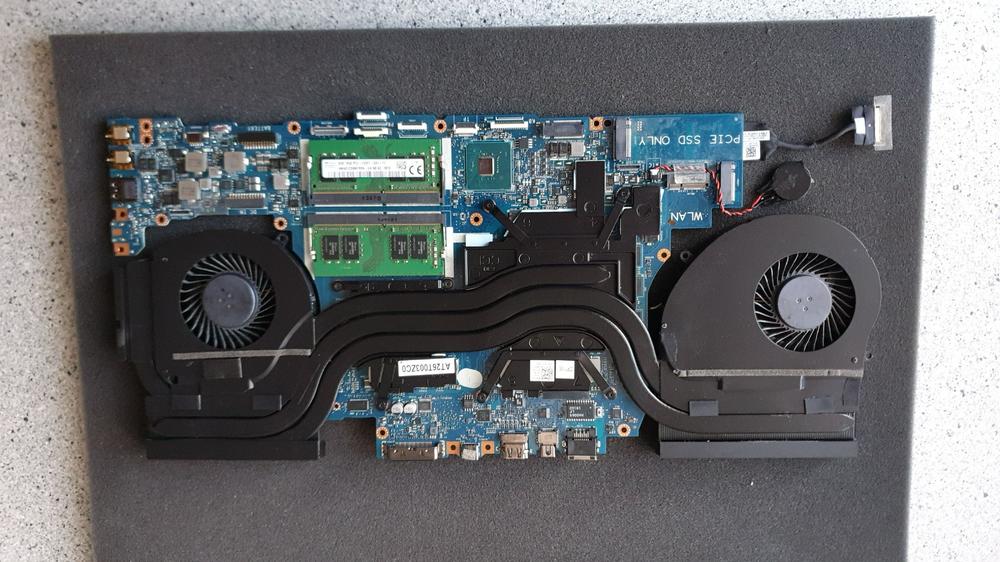

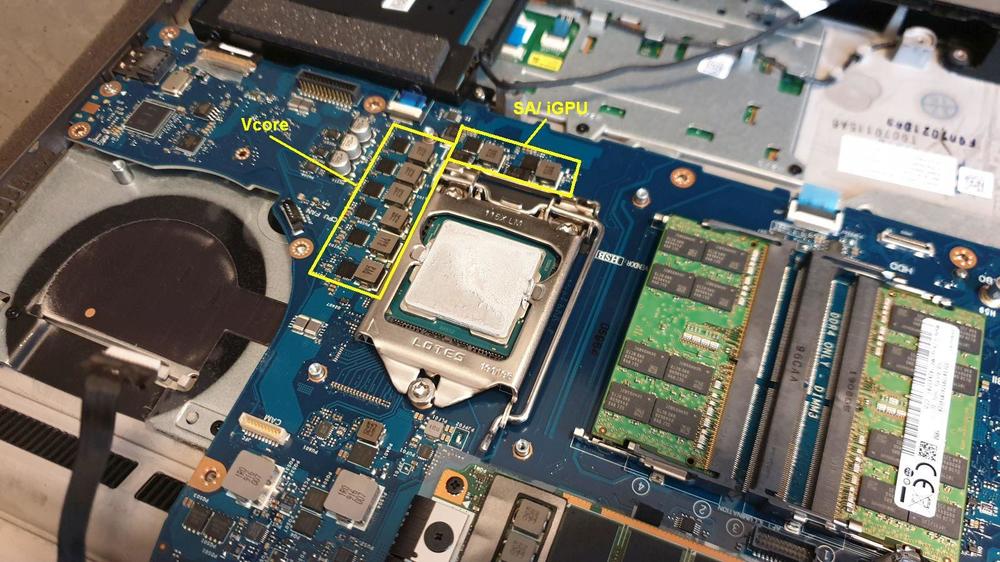

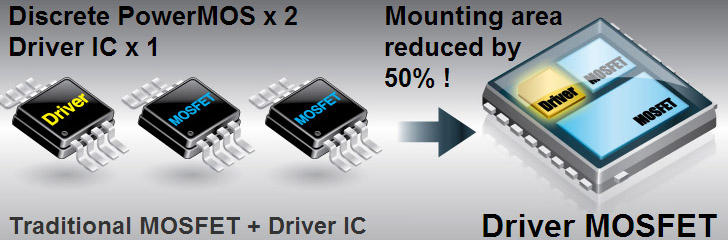

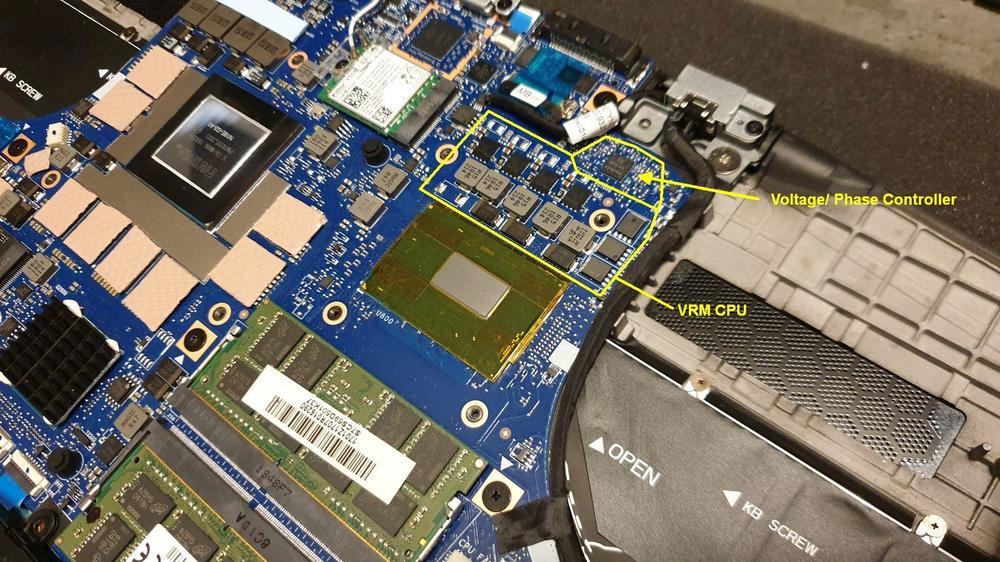

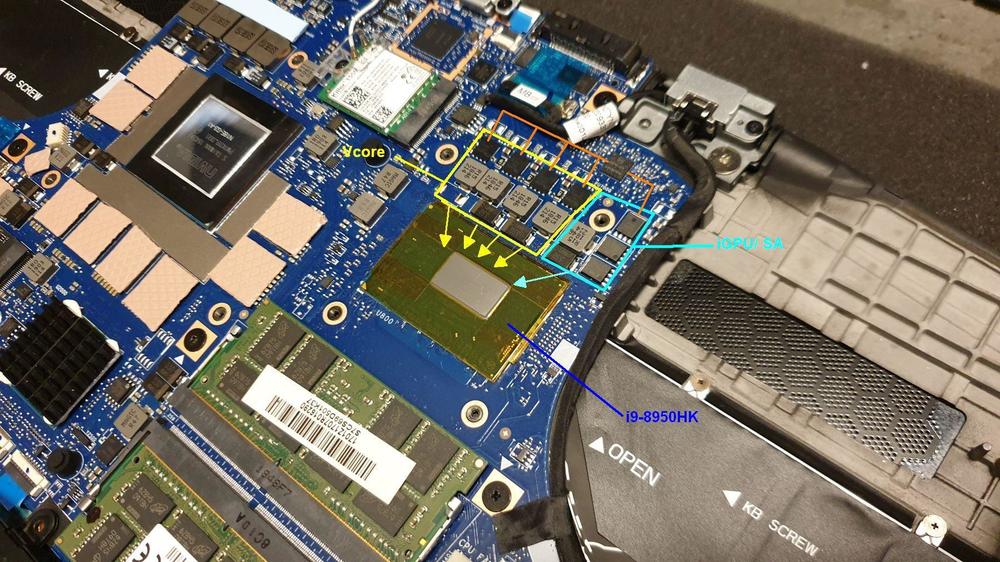

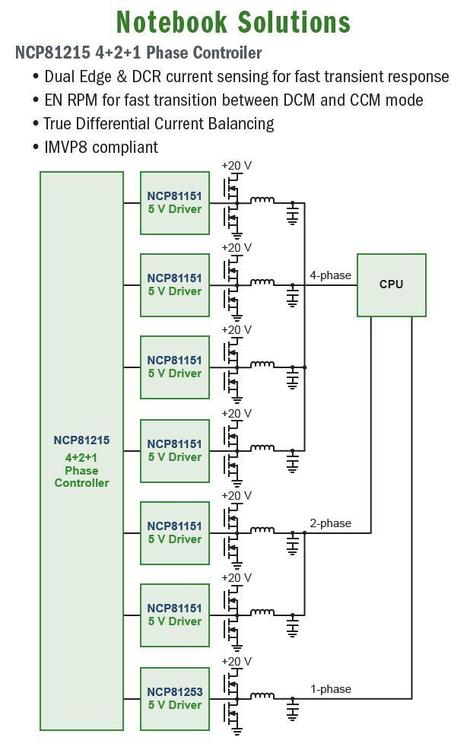

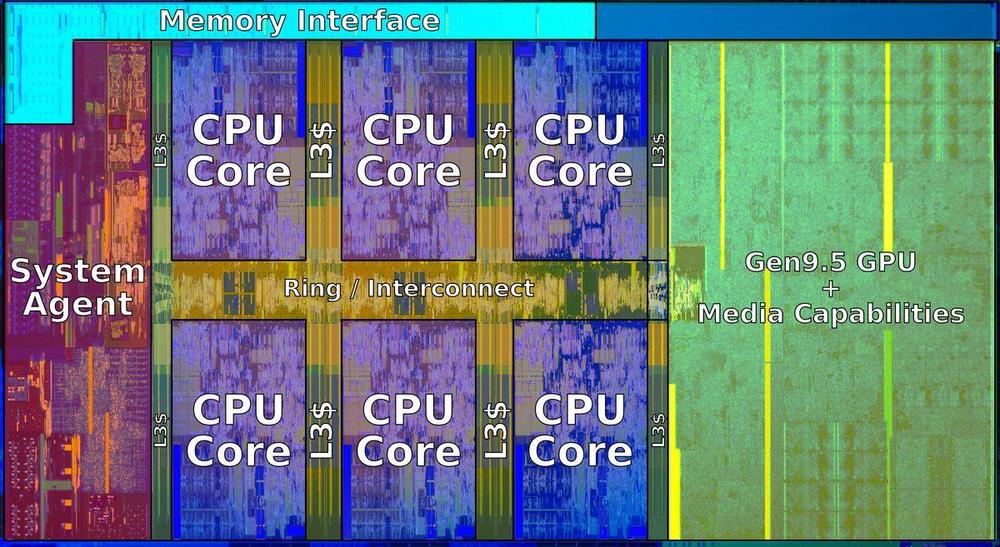

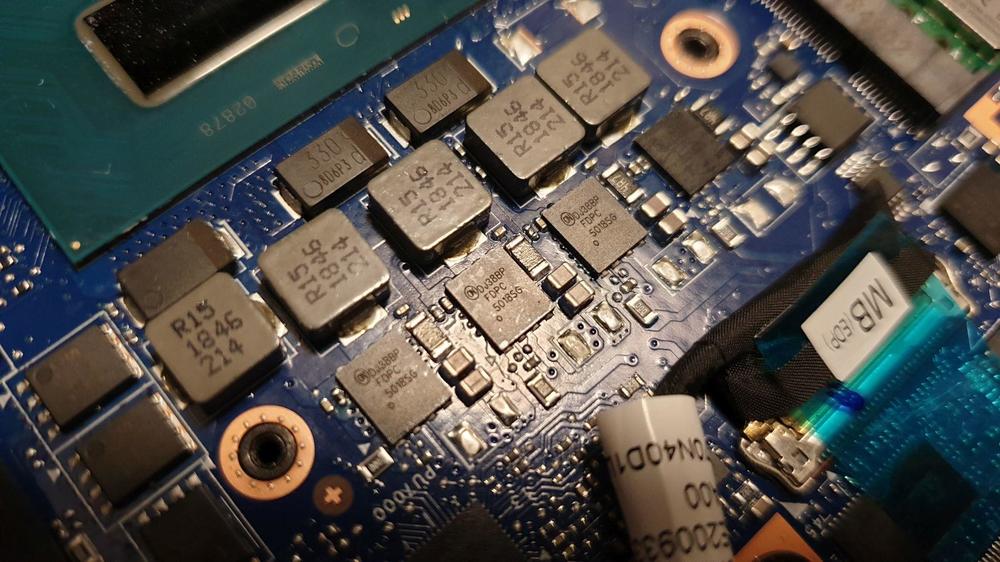

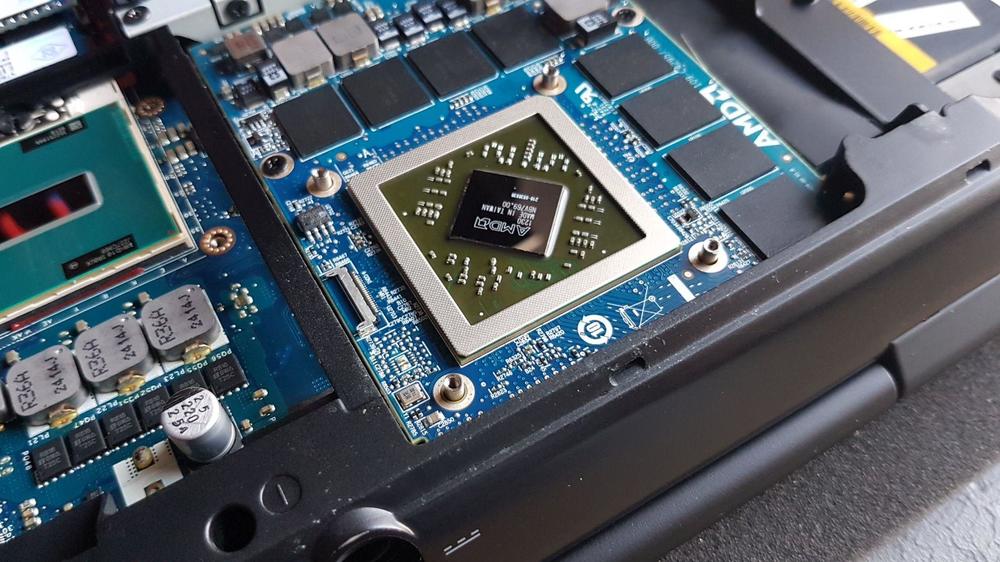

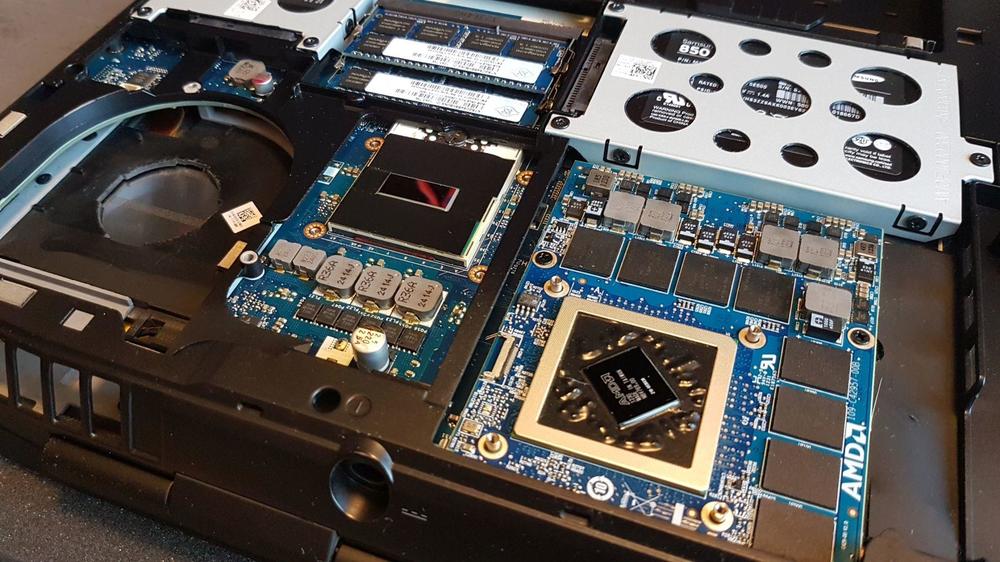

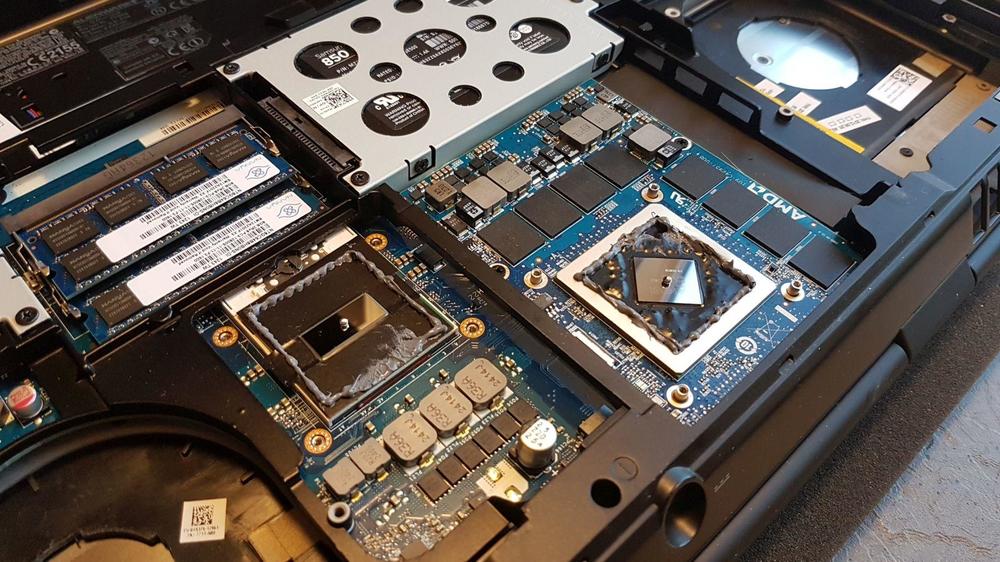

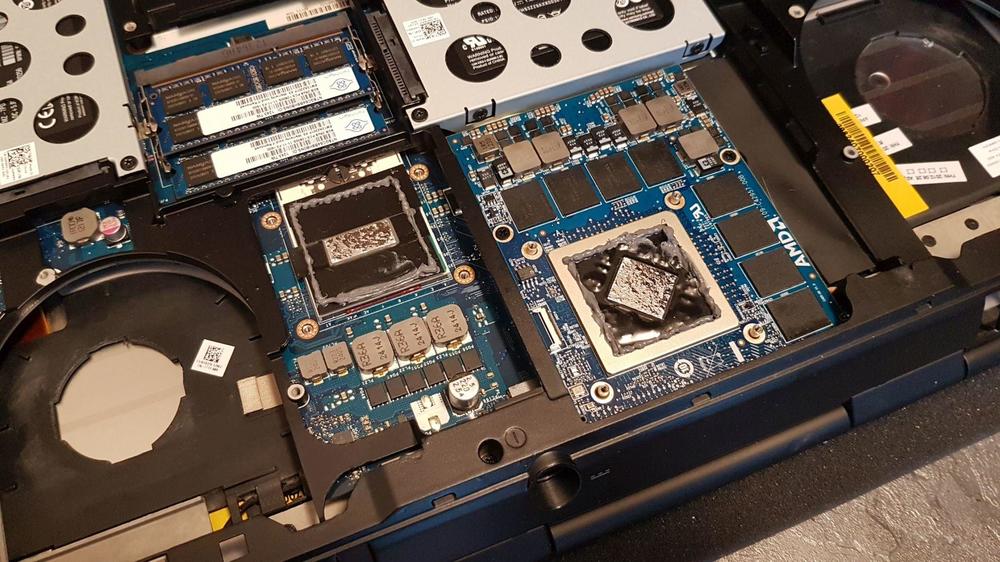

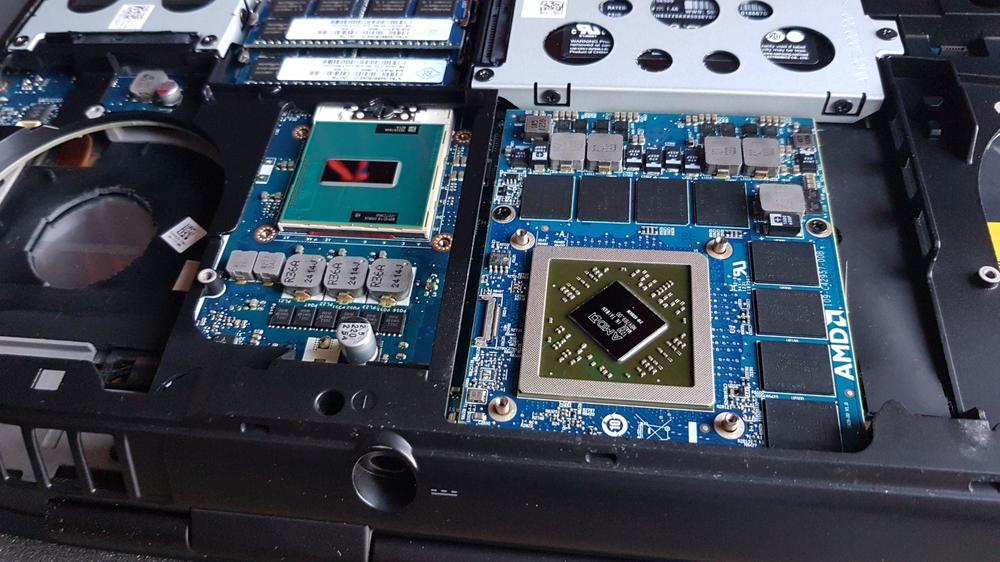

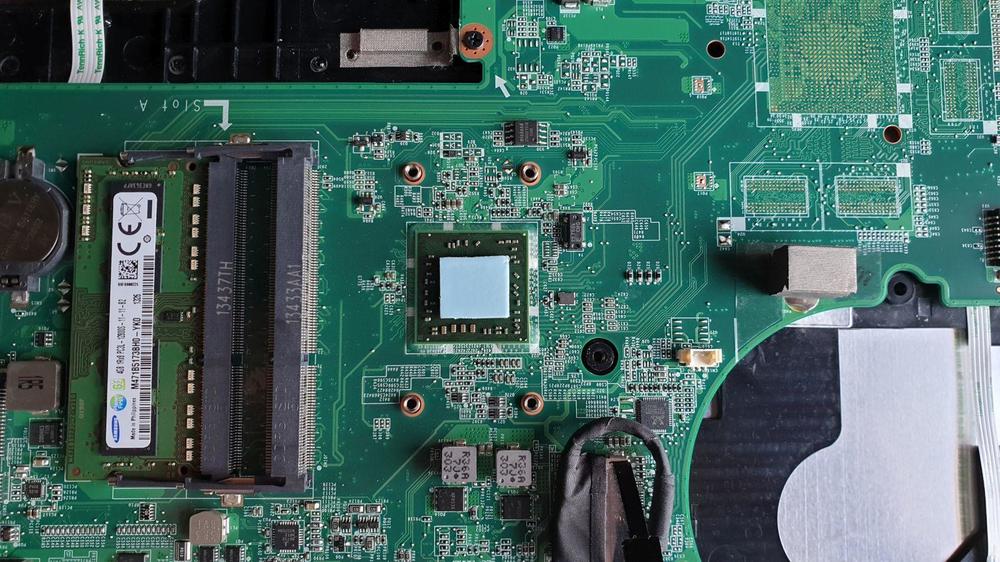

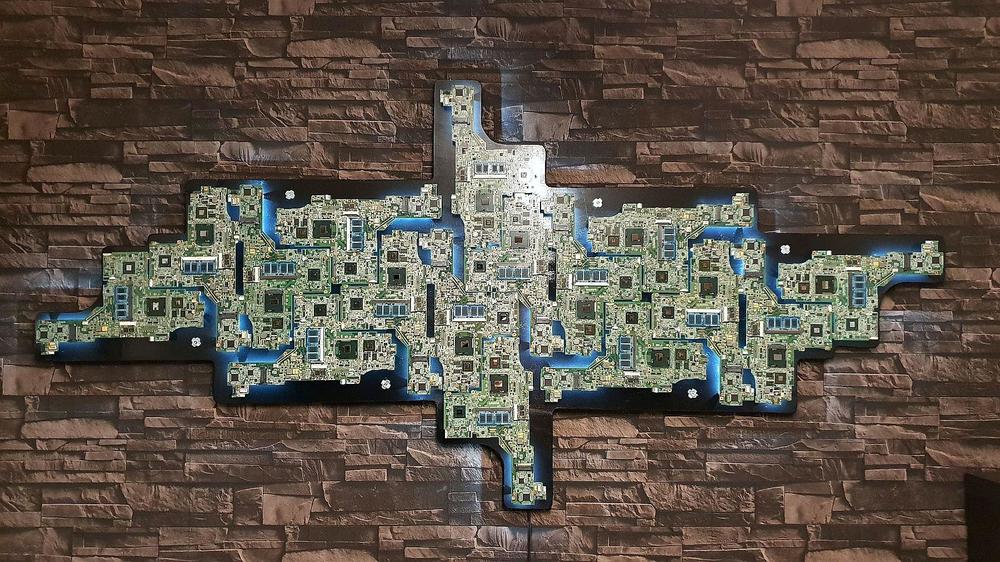

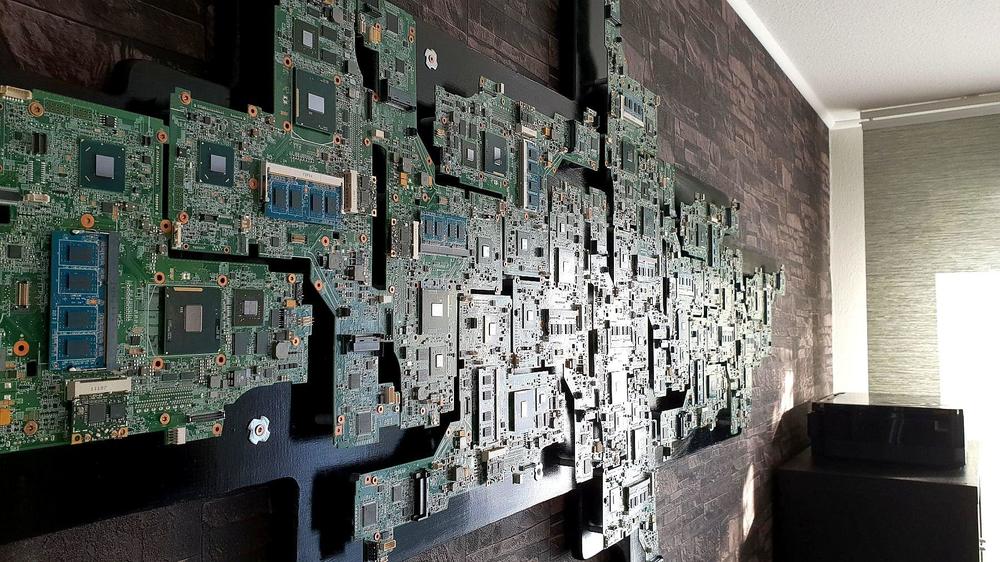

Auf der Suche nach der Ursache von Fehlern oder Problemen wie Rucklern/Freezes bei Spielen oder Spulenfiepen wird sich oft über VRM, Powerstages, MOSFETs, VRAM, Chokes usw. unterhalten. Nicht jeder weiß was diese Begriffe bedeuten und vor allem, wo sie auf dem Board sitzen und was sie eigentlich für Aufgaben haben. Gerade für Besitzer eines Gaming-Notebooks, die ihr System besser verstehen wollen, könnte der Thread eine gute Hilfe sein. Da ich mich gerne mit der Hardware (und Kühlung) beschäftige, habe ich mir gedacht, dass ich mir die Mühe mache und einen ausführlichen Beitrag zu dem Thema erstelle. Zusätzlich wollte ich noch ein paar Begriffe erläutern, die hier oft in den Beiträgen erwähnt werden. Gerade für Neulinge, die sich noch nicht lange mit dem Thema beschäftigen, kann das Fach-Chinesisch eine Herausforderung sein. So hat man gleich den Vorteil, dass man in zukünftigen Beiträgen nicht alles erklären braucht, sondern einfach auf den Thread hier verlinkt. Eine Sache gleich vorweg. Ich weiß auch nicht alles, versuche aber das was ich weiß, so richtig wie möglich zu beschreiben. Nehmt's mir also nicht übel, wenn vielleicht die ein oder andere Info nicht richtig ist. Gerade im Bezug auf das Mainboard sind offizielle Informationen kaum vorhanden. Dazu später aber noch mal mehr. Manchmal sind meine Quellen auch nicht immer richtig. Wenn jemand also etwas richtig stellen möchte, freue mich natürlich über Kritik. Schließlich lernt man davon nur. Über positives Feedback freue ich mich natürlich auch^^. PCB Dieser Begriff steht für "Printed Circuit Board". Im Grunde beschreibt es einfach die Platine auf dem die Chips und die anderen Komponenten sitzen. Also jede Grafikkarte, jedes Mainboard, RAM-Riegel ist/ hat ein PCB. Unser Notebook-Mainboard ist ein sogenanntes Multi-Layer PCB. Das bedeutet, das die Leiterbahnen nicht nur ober- und unterhalb auf dem Board liegen, sondern auch da zwischen auf mehreren Schichten. Aus wie viel Schichten genau das AW-Board besteht, konnte ich leider nicht rausfinden. Ich nehme an, dass es zwischen 10 und 20 Schichten liegen müsste. Aktuelle High-Rnf Grafikkarten liegen bei 15 Layern und mehr. (Link Wikipedia) BGA Auch ein Begriff, der hier öfter fällt. BGA steht für "Ball Grid Array" und beschreibt das Verfahren wie Chips (GPU, CPU, VRAM, etc) aufs PCB gebracht werden. In Forenkreises meint man mit einem BGA-Notebook, dass die wichtigsten Komponenten wie CPU und GPU festgelötet und somit nicht austauschbar sind. Zumindest nicht so einfach. Es hat jedoch den Vorteil, dass sich ein besonders flaches PCB realisieren lässt und somit auch die super flachen Notebooks. Als Beispiel: vor der Montage sieht ein GDDR5 Speicher-Chip und ein Intel Core i7-7820HK wie folgt aus: Wie die Kügelchen auf den Chip kommen, kann man hier in dem Video sehen. (Link Wikipedia BGA) DIE Als DIE bezeichnet man die Oberfläche eines Chips. In den meisten Fällen meint man damit die Oberfläche (Diffursionsschicht/ -sperre) von CPU, GPU oder PCH. Also meist das, was so schön spiegelt. Besonders oft fällt dieser Begriff in Kühlungsthemen, wo es darum geht wie der Kühlkörper (Heatsink) auf dem DIE aufliegt. Bitte nicht verwechseln mit einem IHS (Intergradet Heatspreader). Dieser ist z. B. bei Intel-Desktop CPUs auf dem DIE geklebt. Bei unseren AW-Notebooks ist der Heatspreader die große Kupferplatte auf dem Kühlkörper. (Link Wikipedia Heatspreader) Komponenten des Mainboards Die Erläuterungen der Komponenten habe ich anhand meines AW17 R5 Mainboards gemacht. Jedoch lassen sich die Sachen auch auf andere Notebooks wie beispielsweise dem Area51m übertragen, da sich in der Grundstruktur nicht so viel verändert. Ich werde nicht all zu tief ins Detail gehen, da ich sonst wahrscheinlich drei Tage für diesen Beitrag brauche. Also nur kurz und knapp und warum sie da sind und was sie machen. Ich fange mit der Spannungsversorgung von CPU und GPU an. Da CPU und GPU die leistungsstärksten Komponenten auf dem Board sind, benötigen sie dementsprechend eine speziell starke Spannungsversorgung. Das Schaubild ist zwar mehr auf einen Desktop-PC bezogen, funktioniert aber relativ gleich im Notebook. Die "Chokes", auch "Coils" oder in deutsch "Spulen" heißen richtigerweise Induktor. Der Begriff "Spule" kommt tatsächlich davon, dass sich im Inneren eine spulenähnliche Konstruktion (siehe Bild) befindet. Auch das Problem mit dem Spulenfiepen kommt genau aus diesem Bauteil. Sie können, je nach Modell und Last, in einer Frequenz takten, wo sie das menschliche Ohr hören kann. Zusammen mit dem Voltage-Controller, Doublern, MOSFETs und den Kondensatoren füttern sie die CPU/ GPU mit ausreichend Strom. VRM = Voltage Regulator Modul, bezeichnet die gesamte Einheit von Anfang bis Ende. Das nächste Bild beschreibt die Begriffe PCH, VRM, VRAM und wo diese auf dem Board liegen. Angefangen bei der GPU. Die Spannungsversorgung für den GTX 1080 Chip, ist Vcore GPU. Der Video-RAM (auch VRAM) hat seine eigene Spannungsversorgung, abgekürzt Vmem. Der Video-RAM beträgt 8 GB GDDR5X. Der Speicher kommt von Micron und das X steht einfach für einen etwas schnelleren Speicher. Guckt man sich die Bereiche zur Spannungsversorgung an, ist auch genau das der Bereich, den die Heatsink abdeckt (siehe Bild mit HS). Gerade die MOSFETs können sehr warm werden und es wirklich wichtig, dass die Bauteile gekühlt werden. Zwar werden Sie nur passiv und mit einem Wärmeleitpad gekühlt, aber das reicht schon für einen normalen Betrieb unter Last aus. Werden die Komponenten nicht richtig gekühlt und werden zu heiß, greift eine Schutzabschaltung ein, ähnlich wie bei der CPU. Meist macht sich das mit (dauerhaftes Intervall) kleinen Rucklern oder Freezes bemerkbar. Die Spannungsversorgung der CPU ist allgemein auf den gesamten Chip bezogen. Wahrscheinlich sind die beiden äußeren Induktoren rein für die iGPU. Der Rest wie Audio Controller usw. sollte klar sein. Der LAN Controller hat noch eine galvanische Trennung. Guckt man sich mit den Infos jetzt ein Area 51m PCB an, findet man viele Komponenten wieder. Mainboard von meinem alten AW17 R4: Anschlüsse auf dem AW17 R5 Board: Noch ein paar ergänzende Sachen. Viele Chips besitzen in einer der Ecken eine Markierung. Bei CPU und GPU sind das ein Dreieck bzw. ein Pfeil und bei den anderen Chips ein Punkt. Ich habe mal ein paar markiert. Von der CPU kennen das sicherlich viele. Die Markierungen sind dazu da den Chip richtig rum einzubauen. In einigen Schaltplänen ist die Markierung ebenfalls zu sehen. Falls es jemanden interessiert wie so ein Schaltplan im Einzelnen aussieht, einen Schaltplan vom M17x R4 hätte ich da: AW Schematics Document Was Aktuelles wird man leider nicht so einfach bekommen. Ich lade in den nächsten Tagen noch zwei High-Resolution Bilder vom R5 Mainboard hoch. Dann kann sich jeder einen besseren Blick vom PCB verschaffen.16 Punkte

-

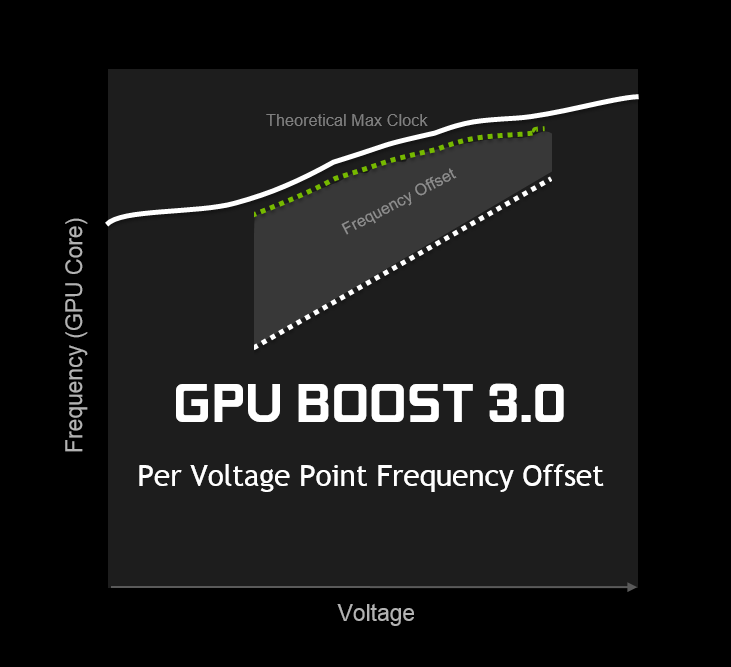

Hi Zusammen, Dies wird der erste Teil einer Reihe von Guides. In diesem möchte ich auf das GPU OC eingehen. Im nächsten Teil auf Displays, natürlich nur sofern Interesse von eurer Seite besteht. Das hier ist also sozusagen ein Testlauf Der eine oder andere hat vielleicht schon mal daran gedacht seine Grafikkarte (GPU) zu übertakten um noch etwas mehr Leistung zu bekommen, oder betreibt vielleicht sogar seine PCs seit jeher mit OC. in diesem Guide möchte ich euch das Übertakten von Pascal GPUs näher bringen, auf die Neuerungen eingehen und die Unterschiede zum Desktop Pascal OC aufzeigen. Am GPU OC gibt es per se erst mal keine großen Risiken. Wenn ihr euch halbwegs an diesen Guide haltet kann nichts schief gehen und ihr bekommt ein stabiles Setting mit dem ihr auch keine Angst haben müsst das es instabil ist. #####GPU OC Grundlagen##### OK, fangen wir bei den Grundlagen an. Ich bin der Meinung das es nicht zielführend ist nur zu erklären welche Regler verschoben werden müssen. Jeder sollte verstehen was er da tut um Fehler auch selber erkennen zu können. Das ist das Wichtigste. Deshalb auch: Wenn es Fragen gibt, stellt sie! Beim GPU OC wird die Taktrate der GPU (also des Grafikprozessors) angehoben um mehr Rechenbefehle in der gleichen Zeit abarbeiten zu können. Die GPU arbeitet mit dem Grafikspeicher (VRAM) zusammen. Beide Bereiche müssen aufeinander abgestimmt sein. Beispiel: GPU zu langsam -> Speicher ist nicht ausgelastet und hat Kapazitäten. Weitere Speicherübertaktung würde nichts bringen VRAM zu langsam -> Speicher ist nicht schnell genug um GPU mit Daten zu füttern bzw aufzunehmen. Weiteres GPU OC würde nichts bringen. Um also ein optimales Ergebnis zu erhalten muss ggfs beides Übertaktet werden. GPU: Bei der GPU kann ich den Takt solange erhöhen bis bei einer 3D Anwendung der Treiber abstürtzt oder der PC ausgeht, oder die Anwendung abstüzt. Für einen bestimmten Takt benötigt die GPU eine bestimmte Spannung. Gggfs muss man die anheben um einen Takt stabil zu bekommen. Dabei steigt auch die Verlustleistung und damit die Wärme, aber darauf gehe ich später ein. VRAM: Da kann man nicht viel falsch machen. Bei zu hohem Takt gibt es Grafikfehler oder einen Absturz. Mehr Spannung bringt selten etwas. Also entweder der Vram schafft den Takt oder nicht. Verlustleistung: P=UxI also die Leistung ergibt sich aus der Spannug und dem Strom. Wenn ich die Spannung bei selben Takt erhöhe steigt also auch der Verbrauch. Erhöhe ich dazu noch den Takt kommt auch mehr Strom hinzu was den Verbrauch umso mehr steigen lässt. Da elektrische Energie in einem PC zu einem sehr größen Teil in Wärme umgewandelt wird, erhöht sich logischerweise auch die Temperatur #####GPU OC VOR PASCAL##### Früher lief OC etwas anders als heute. Da hatte die GPU ihren festen 3D Takt. Man konnte solange den Takt anheben bis es instabil wurde. Hatte man eine gute Kühlung konnte man über die Spannung mehr Takt rausholen. Dabei stieg wie bereits angesprochen auch die Verlustleistung stark an. #####GPU OC MIT PASCAL##### Da wir mit Pascal aber einen Grafikchip bekommen haben der seine Verlustleistung überwacht läuft das OC heute etwas anders, bzw man muss auf andere Sachen achten um ein optimales Ergebnis zu bekommen. Aber fangen wir mit den neuen Funktionen an. BOOST 3.0: überwacht die Verlustleistung der GPU und die Temperatur und regelt danach den Takt in vorgegebenen Grenzen. Wird die Grafikkarte zu warm oder zuviel Leistung abgefragt, senkt die GPU den Takt. TEMPERATURLIMIT: Das Temperaturlimit gibt an, wann BOOST 3.0 den Takt massiv drosselt. POWERLIMIT: Gibt an, bei welcher Leistungsaufnahme der Takt gesenkt wird. Bei den Desktop Karten kann man das Powerlimit anheben um so höheren BOOST- Takt zu erhalten. das geht leider bei den Notebook Pascals nicht. Wir müssen also anders an das OC rangehen. Mit Pascal haben wir nicht mehr die Möglichkeit den Takt absolut zu bestimmen. Wir geben über ein Offset ein Takt +XX auf den Boost drauf. die Grafikkarte entscheidet dann anhand der Boost Parameter welchen Takt sie anlegt. Wenn also die Temperatur passt und das Powerlimit angehoben wurde kann die GPU somit ihren maximalen Boosttakt + Offset anlegen. Das ist die einfachste Möglichkeit für OC. Das ist durch das beschränkte Powerlimit bei den Notebook Pascals leider nicht so effktiv wie bei den Dekstop Karten Also machen wir es anders Wir haben seit Pascal glücklicherweise noch ein deutlich mächtigeres Instrument bekommen. Den Curve Editor im MSI AFTERBURNER #####DER CURVE EDITOR##### BOOST 3.0 hat viele Taktstufen die eine bestimmte Spannung anlegen. Der Curve Editor gibt uns die Möglichkeit für jede dieser Stufen ein eigenen Takt Offset einzutragen. Warum das so wichtig ist erklär ich später. Bei den Desktop Karte ist das Ziel das Powerlimit zu erhöhen um der GPU zu ermöglichen die maximale Spannung und Takt zu halten. Da wir das nicht anheben können müssen wir also die optimale Leistung aus unserem Powerlimit holen. Das ist eine curve von einer Desktop Karte. Ihr seht, der User hat Wert auf den Bereich um 1v gelegt und den bereich um 0.8xx V nicht erhöht. Das geht weil er das Powertarget anheben kann. Unsere Notebook Pascals legen bei 3D Anwendungen den Wert auf das Powerlimit. Um in diesem Limit zu bleiben ,,hüpfen,, die Karten über die Spannungs/Takt Kurve rauf und runter. also 1700mhz/0,81v -> 1770mhz/0,85v -> 1650mhz/0,77v um die 120W (GTX1070) einzuhalten. Wir versuchen jetzt also dieses Verhalten zu optimieren. Wie bereits gesagt erhöht die Spannung die Verlustleistung also auch die Ausnutzung des Powerlimits. Mein Ziel war es also die GPU in einen möglichst niedrigen Spannungsbereich zu zwingen und da den Takt zu erhöhen. Wenn ich also den Takt in den oberen Spannungsbereichen erhöhe steigt da auch die Leistungsaufnahme an und die GPU springt auf einen niedrigeren Spannungspunkt und senkt den Takt. Wir gewinnen also nicht viel. Deswegen erhöhe ich mit dem Curve Editor die unteren Spannungsbereiche stärker als die oberen. Damit bringe ich die GPU dazu auf die niedrigeren Spannungspunkte zu springen (Leistungsaufnahme senken) um da den Takt zu erhöhen (Powerlimit ausreizen). Damit habe ich am ende effektiv mehr Takt anliegen bei einer niedrigeren Spannung. Stadard hätte ich eine höhere Spanung mit weniger Takt. ich hoffe das ist halbwegs verständlich. Hier seht ihr die Standard Curve von der 1070 im Aw17R4 Hier die selbe GPU mit offset +200Mhz ich habe die interessante Stelle markiert. Der Maximaltakt steigt auf über 2100mhz. Wenn die GPU wenig Last hat taktet sie in diesen Bereich und stürtzt ab wenn das nicht stabil ist (was es sehr wahrscheinlich nicht sein wird! ) deswegen müssen wir da jetzt ansetzen. (siehe nächstes Bild) ich habe jeden Punkt ab 0,981v auf 2000mhz gezogen um den Takt auf maximal 2000mhz zu begrenzen. Die unteren Bereiche haben weiterhin ihre +200mhz anliegen. das wird umso wichtiger je höher man den Offset wählt. bei +250mhz liegen in der Spitze schon fast 2200mhz was selbstredend nicht stabil ist. Jetzt könnte der ein oder andere auf die Idee kommen den unteren Bereich auch zu begrenzen. Ähnlich wie folgendes Bild: Damit habe ich den minimalen Takt auf 1800mhz beschränkt. Die 1070 hat diese 1800mhz auch gehalten. Leider war aus irgendeinen Grund die Performance niedriger, wie in BF1 getestet stock: 80FPS -> @ 1600mhz Offset +200 auf 2000begrenzt: 92 FPS @ 1750Mhz Offset +2000 auf 2000 begrenzt und 1800 angehoben 88 FPS @ 1800Mhz ich kann mir das nur so erklären, dass die Curve einen graden Anstieg haben muss um die optimale Performance zu haben. Die Obere Begrenzung hat wiederum keinen Einfluss auf die Leistung in den unteren Bereichen. Das hat natürlich einen großen Nachteil: Man muss die einzelnen Spannungspunkte auf Stabilität testen. Dazu habe ich den Heaven Benchmark mit Fenstermodus im LOOP laufen lassen und daneben den Curve Edior auf gehabt. man sieht da sehr gut auf welchem Spannungspunkt die GPU sich grade befindet. Nun einfach die Entsprechenden Punkt anheben und schauen was sich verändert. Schmiert der Rechner ab war`s für den Punkt zu viel. Man sieht dann an welchem Punkt die GPU stehen geblieben ist. Das dauert, aber das Ergebnis lässt sich dann sehen Damit erreicht ihr die optimale Performance. Ihr könnt aber auch die Komplette Curve um einen kleinen -Offset verschieben und erneut testen. damit verschenkt ihr aber kleine Leistungsreserven weil ihr ja Takt von Spannungspunkten nehmt die eventuell schon stabil waren. Auch das VRAM OC zieht vom Powerlimit. Ihr müsst also einen Kompromiss eingehen. Ich habe das maximale VRAM OC bevorzugt. Dadurch aber weniger Takt erhalten. So und nun viel Spaß beim Testen und reges mitmischen im Benchmarkthread ^^ Bei Fragen einfach stellen. Keine PMs. Die anderen User intressieren die Fragen sicher auch und anschliesend werde ich den Guide entsprechend ergänzen.15 Punkte

-

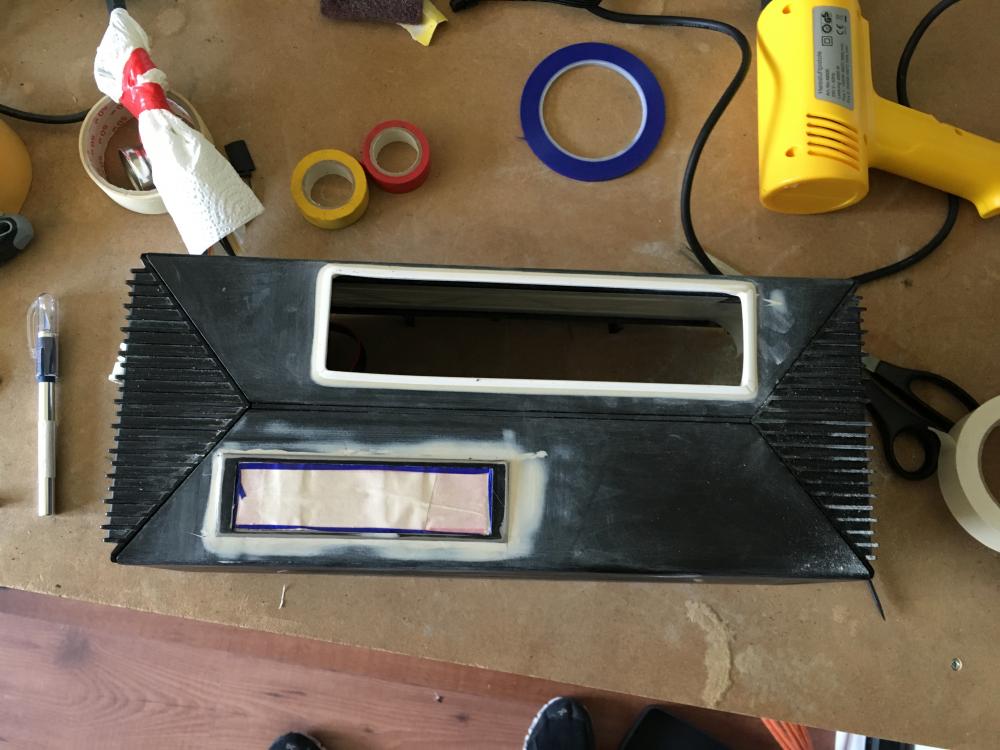

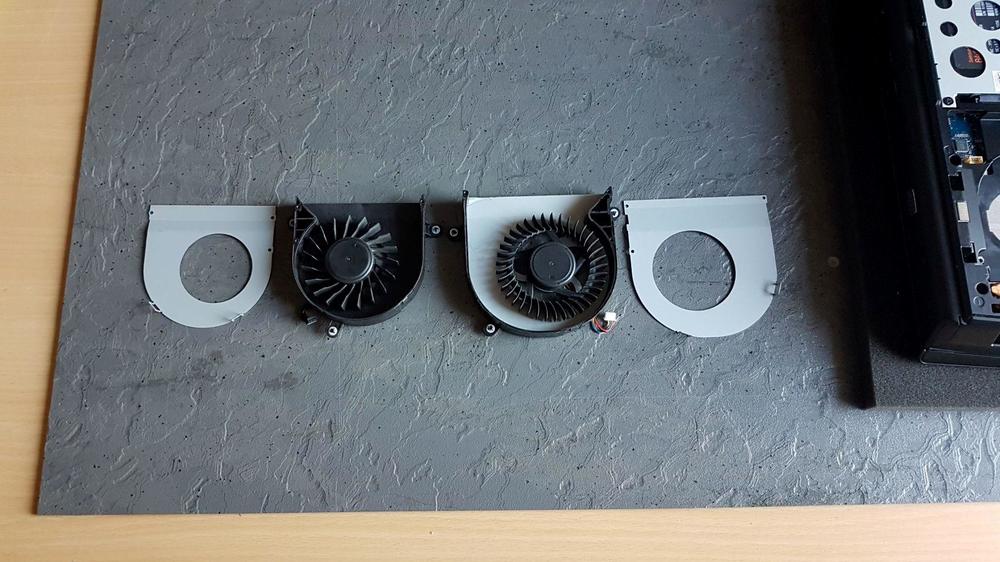

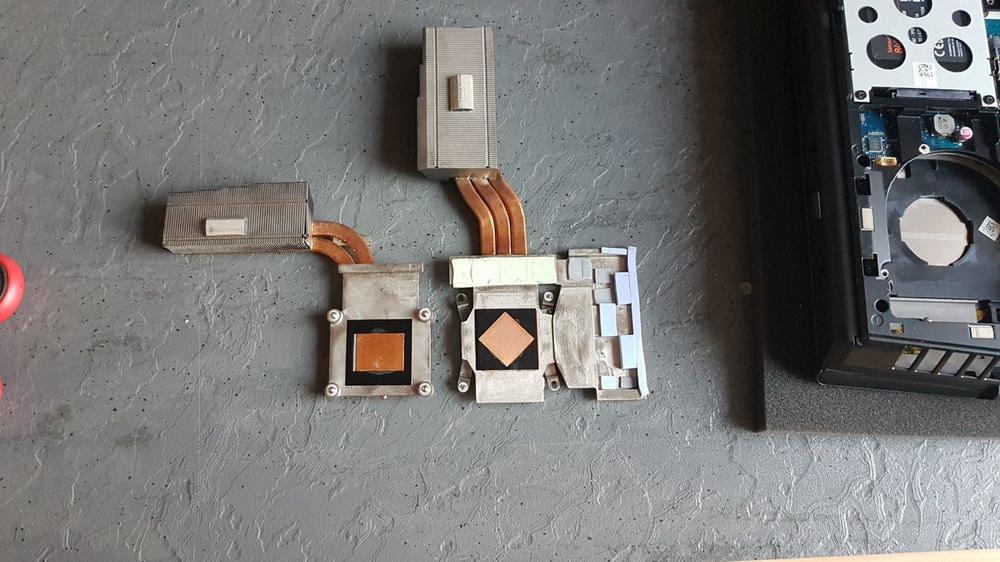

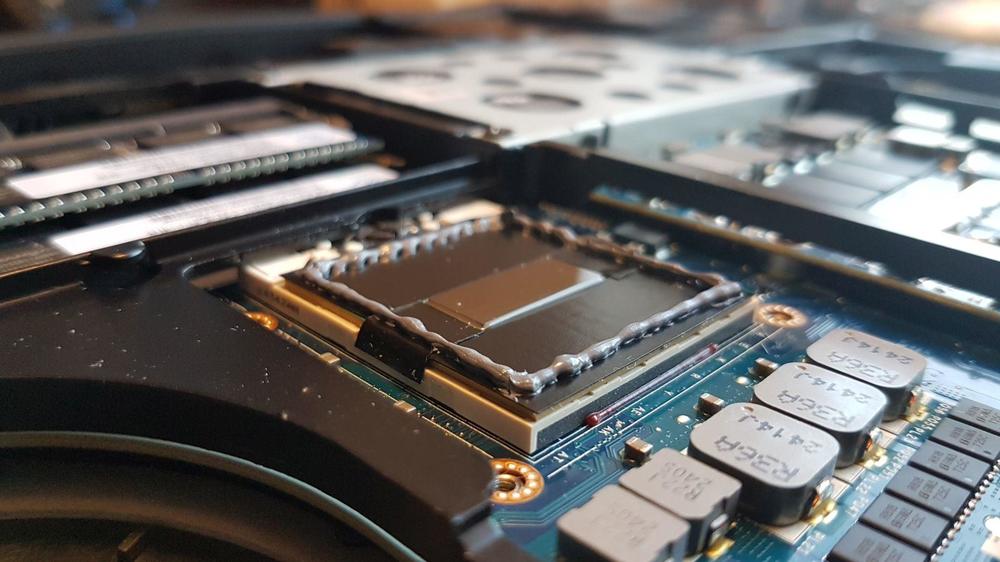

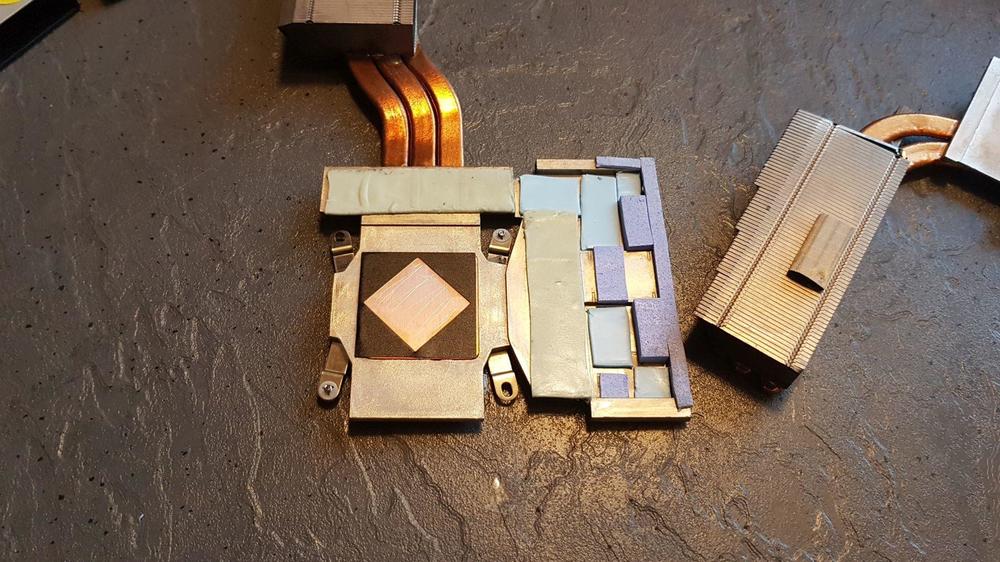

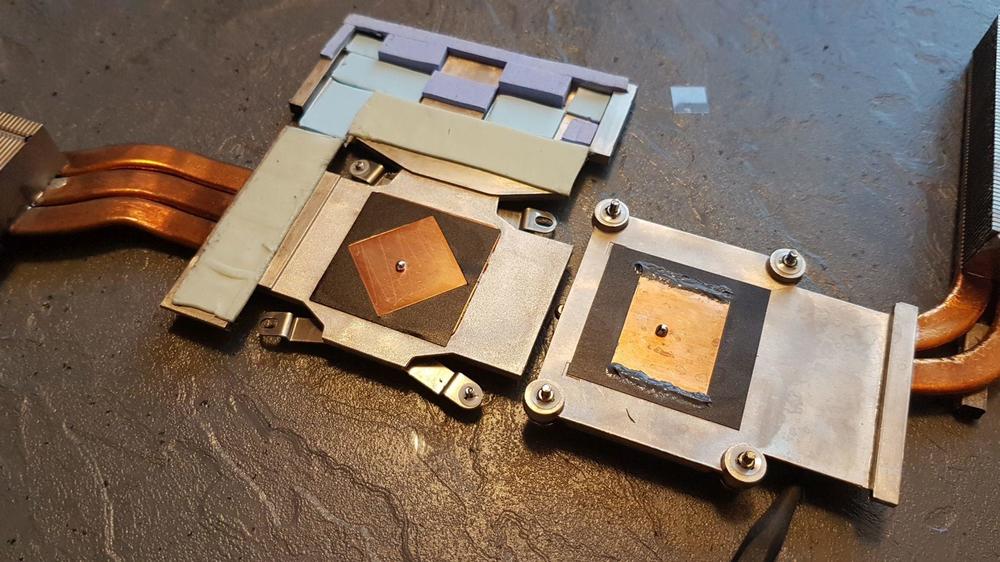

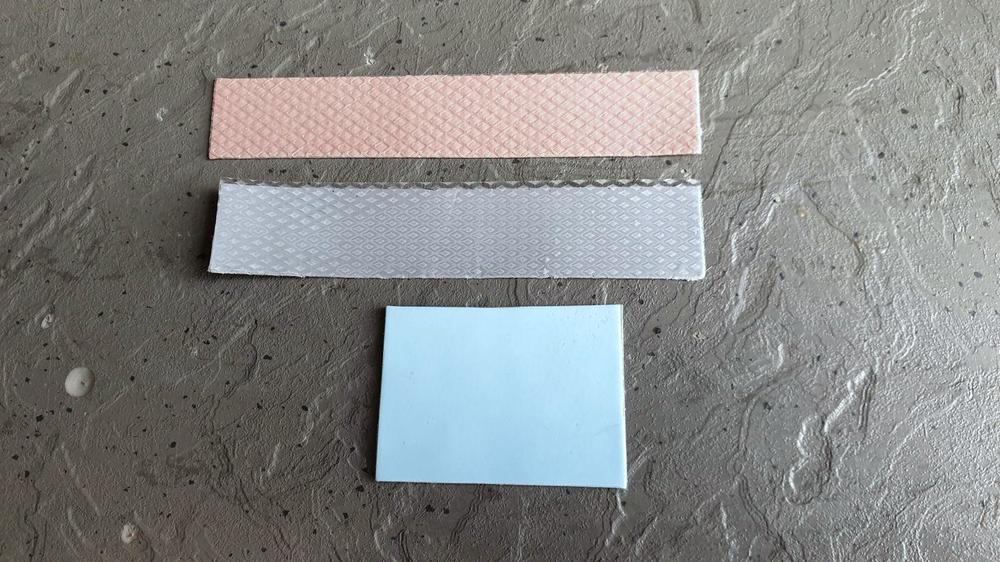

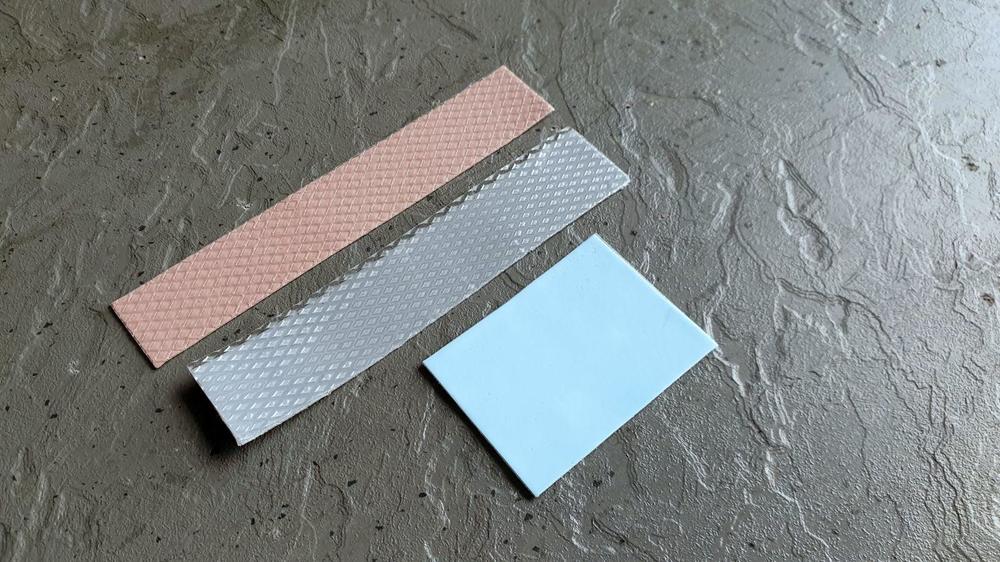

Hi Community sowie stille Mitleser in diesem Guide möchte ich euch zeigen wie man den Aw17 R4 sowie den AW15 R3 zerlegt und einen ordentlichen Repaste durchführt. In einem zweiten Guide wie ihr im Anschluss das Optimum aus eurem System herausholt. Wer kein Intresse an einem Repaste hat und nur seine Temperaturen etwas senken will kann gleich in dem folgenden Guide einsteigen: ##### Mein Repaste Guide soll keine Eigenkreation werden. Ich stütze mich da in weiten Teilen auf den englischen Guide von iunlock aus dem NBR Forum. Die Bilder werden momentan Verlinkt und später durch eigene Ersetzt. An dieser Stelle ein großes Danke an iunlock für seine Mühe und harte Arbeit! Ich verlinke hier seine Bilder und ergänze den Guide mit meinen persönlichen Erfahrungen. Original "Guide by - ::iunlock:: with Team LiquidHz" http://forum.notebookreview.com/threads/alienware-17r4-15r3-disassembly-repaste-guide-results.797373/ ##### #Vorarbeiten# Zuerst solltet ihr euch fragen ob ihr mit Liquid Metal (LM) oder normaler Wärmeleitpaste (WLP) arbeiten wollt. Der Vorteil von LM liegt auf der Hand. Die Wärmeleitfähigkeit ist einfach genial. Der Nachteil ist aber ebenso gravierend. LM ist nämlich elektrisch leitend. Wenn daher etwas daneben läuft und einen Kurzschluss verursacht produziert ihr einen teuren Briefbeschwerer. Wenn ihr aber dem Guide ordentlich und gewissenhaft folgt ist das Risiko durchaus tragbar. Ich habe aktuell seit 8 Monaten ein AW17R1 mit LM im Einsatz und bisher keine Probleme feststellen können. Zu Besorgen sind also: 1.1 Liquid Metal: Ich empfehle Thermal Grizzly Conductonaut. Coolaboratory Liquid Ultra geht auch. Die Temperaturen bei Conductonaut sind 2-4 Grad besser bei mir. https://www.caseking.de/thermal-grizzly-conductonaut-fluessigmetall-waermeleitpaste-1-gramm-zuwa-153.html ODER 1.2 Normale WLP. Da geht aktuell nichts über die Thermal Grizzly Kryonaut. https://www.caseking.de/thermal-grizzly-kryonaut-waermeleitpaste-5-55-gramm-1-5-ml-zuwa-126.html 2. Glasreiniger 3. Zewa Küchenrolle 4. Die Passenden Wärmeleitpads. 1x Thermal Grizzly Minus Pad 8 - 120 × 20 × 1,0 mm, 2 Stück https://www.caseking.de/thermal-grizzly-minus-pad-8-120-20-1-0-mm-2-stueck-zuwa-142.html 1x Thermal Grizzly Minus Pad 8 - 120 × 20 × 0,5 mm, 2 Stück https://www.caseking.de/thermal-grizzly-minus-pad-8-120-20-0-5-mm-2-stueck-zuwa-140.html 5. Passendes Werkzeug. Die meisten Fehler und Beschädigungen passieren durch falsches oder improvisiertes Werkzeug. Spart nicht am falschen Ende ich hab mir das besorgt: https://www.amazon.de/dp/B01ICZI51A/ref=sr_ph?ie=UTF8&qid=1482949630&sr=1&keywords=laptop+werkzeug da ist alles drin was ihr braucht 6. 7 kleine Teelichtgläser (mehr dazu im nächsten Schritt ) #Repaste# Ihr wundert euch über die Techlichtgläser? Natürlich braucht ihr die nicht unbedingt, aber mir waren sie eine große Hilfe. Darin habe ich die Schrauben aus jedem Montageschritt samt einem kleinen Zettel aufbewahrt. Damit wusste ich immer welche Schraube wo hin kommt. Dazu hatte ich die Gläser von einem Schritt immer in das Glas vom Schritt davor gestapelt und man konnte beim Zusammenbau einfach von oben die Gläser abarbeiten. Habt ihr ein eigenes System? Nur zu ich wollte euch nur mal meins aufzeigen. Jetzt muss das Gerät geöffnet werden und das Mainboard freigelegt werden. Vorweg: Achtet unbedingt darauf euch zu erden. Also entweder eine passende Unterlage mit Handgelenk Kontakt oder wenigtens mal ne Heizung anzufassen. Schritt 1 Ihr entfernt die 6 Schrauben links und rechts. Die obere Mittlere muss nur gelockert werden, da sie auf der Rückseite gekontert ist. Schritt 2 ALS ERSTES DIE BATTERIE ABKLEMMEN. BLAUER PFEIL Nun die Schauben vom Montagerahmen alle entfernen. Dazu die Stecker vom Mainboard lösen und die Festplatten sowie M.2 SSDs ausbauen. Vergesst nicht die 2 Schrauben auf der Rückseite von der Lüfterabdeckung. Jetzt die WLAN Karte ausbauen. seid bitte besonders vorsichtig bei den Kontakten der Antennen. Die können leicht brechen. Schritt 3 Das Lüftergitter entfernen. Ich musste da an der rechten Seite ganz schön ziehen um das abzubekommen. Es wird nur durch die Nasen und 2 Schrauben gehalten, die ihr bereits entfernt habt. Schritt 4 Die 2 Schrauben von den LED Leisten Lösen. Schritt 5 die letzten 3 Schrauben lösen Schritt 6 jetzt könnt ihr den Rahmen mit so einem Plastiktool lösen. Das ist in dem Set enthalten was ich euch verlinkt habe Damit geht das wirklich einfach. Schritt 7 Die markierten Schrauben lösen. Die Schrauben von den Kühlern bleiben noch drauf. Löst auch alle Stecker vom Board. Hier sind im englischen Guide nicht alle markiert. Einer ist noch unter dem rechten Lüfter, sowie die Stecker am unteren Rand (wenn sie noch nicht gelöst sind) Schritt 8 die restlichen Stecker lösen. Die befinden sich an der Oberkante. ich hab ne Weile suchen müssen weil in dem englischen Guide nicht steht wo die sein sollen ^^ Jetzt solltet ihr das Mainboard rausnehmen können um die Lüfterstecker auf der Rückseite abziehen zu können. Schritt 9 Jetzt entfernt ihr die alten Pads und bringt die neuen wie im Bild an. Achtet auch darauf das ihr ALLE Pads entfernt die eventuell noch auf dem Mainboard kleben geblieben sind! GTX 1070 GTX 1080 Schritt 10 Falls ihr LM nehmt, beklebt jetzt das Board wie im Bild mit ISO Tape um die Kontakte vor dem LM zu schützen falls ein Tropfen rausgedrückt wird. Streicht jetzt eure Paste der Wahl drauf. Bei normaler WLP jeweils eine kleine Erbse in die Mitte und dann den Kühler montieren. Die Paste wird dadurch Blasenfrei verteilt. Macht das NICHT mit LM. LM muss verstrichen werden das es am Ende aussieht wie im Bild Streicht nun etwas LM auf dem Kühler selbst bis es schön Glänzend aussieht und etwas spiegelt. Das kann eine Weile dauern. Schritt 11 Montiert jetzt wieder den Kühler und baut alles in der umgekehrten Reihenfolge zusammen. Da die Kühlerkonstruktion bei der CPU nicht symmetrisch ist empfiehlt es sich den einzelnen Arm ein wenig nach oben zu biegen um den Anpressdruck gleichmäßiger zu gestalten. ACHTUNG: Achtet bitte unbedingt darauf das ALLE Schrauben in die richtigen Löcher geschraubt werden. ich habe beim Mainboard eine falsch gehabt und am Ende eine Schraube vom Deckel nicht rein bekommen und musste ALLES wieder auseinander bauen. Wenn alles gut gegangen ist Könnt ihr euch auf solche Ergebnisse freuen: Anno 2205 53 Grad GPU mit OC und 55Grad CPU @ 4200mhz OCCT 3H 4.2GHZ So jetzt viel Spaß mit dem Guide wenn ihr Fragen habt stellt sie einfach hier im Thread. Ich würde mich freuen wenn ihr eure Ergebnisse hier postet bitte vergesst den HWinfo Screen dabei nicht. Gruß captn1ko14 Punkte

-

So, Schnuffel verraet nun etwas mehr... Am 10. Juni werden unter anderem 3 neue Noetbooks vorgestellt: 14" Single GPU (Optimus), 17"SGPU (Optimus) und 18" DGPU - wobei aber zu sagen ist, dass das was im 18" Gehaeuse kommt eigentlich dass 17" Dual GPU MP sein wird. Daher wird sich das 18" Gehaeuse auch in Qualitaet und Design etwas von dem 14" und 17" unterscheiden. Schnuffel vermutet, es dient nur noch zum Aufbrauchen der 18" Display's - aber das weiss er nicht wirklich. Der 14" und der 17" besitzen ein Magnesium-Chasis. Weiter wurden die Verschalungen nun komplett auf anodiziertes Alluminium gewechselt (ausser Bodenplatte). Das Video, welches im Netzt kommuniziert, ist sicher nicht das wirklich Marketingvideo. Darauf fehlen naemlich die beleuchteten Keyboards. Allerdings sind die neuen Touchpad's zu sehen. Es wird eine guenstige Version geben (ganzes Touchpad leuchtet) und spaeter eine teuerere (touchpad ist ein TFT). Bei der Auslieferung wird es natuerlich wieder beleuchtete Tastaturen geben. Die sind im Moment in der Ueberarbeitung. Qualitativ warden der 14" und der 17" wirklich Moehrenstark sein. Und Schnuffel sagt Euch schon heute: GREIFT NACH DEN IPS DISPLAYS. Die sind das Beste was man je gesehen hat. Sie schlagen sogar das beruehmte RGB LED TFT des m17xR2 - da sie heller sind. Gruesse vom Schnuffel14 Punkte

-

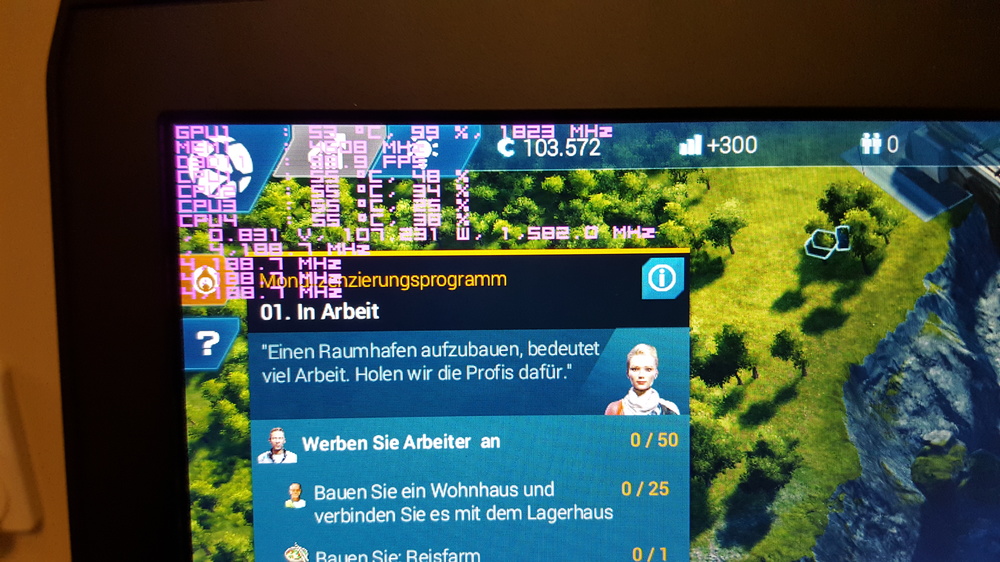

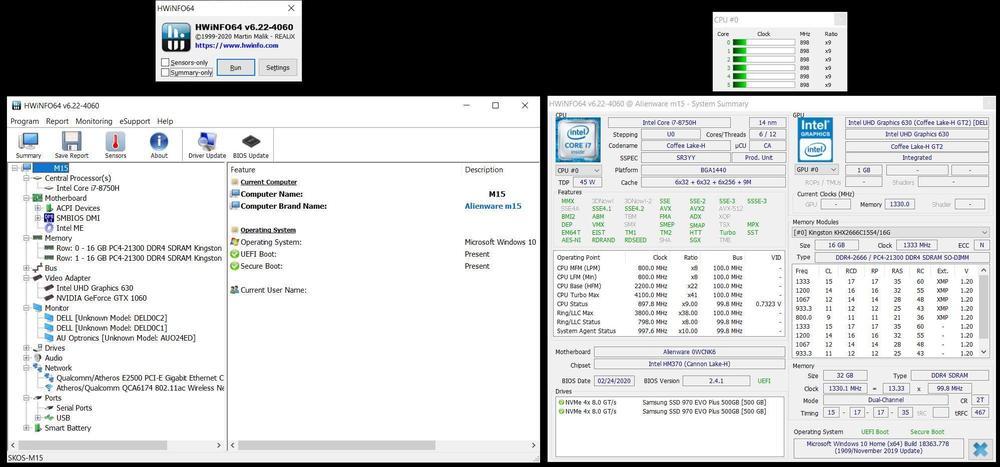

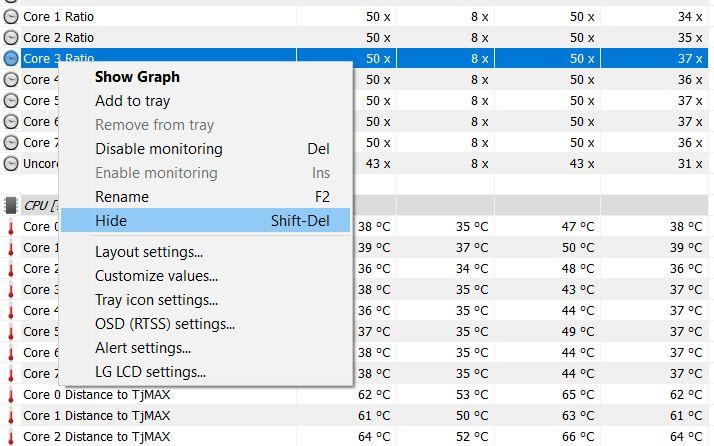

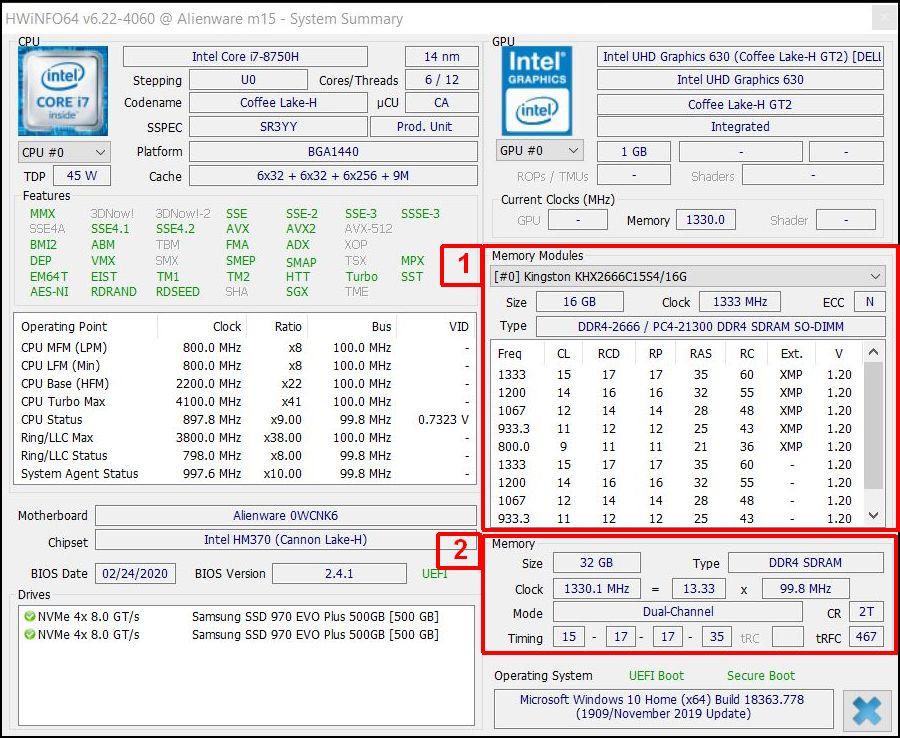

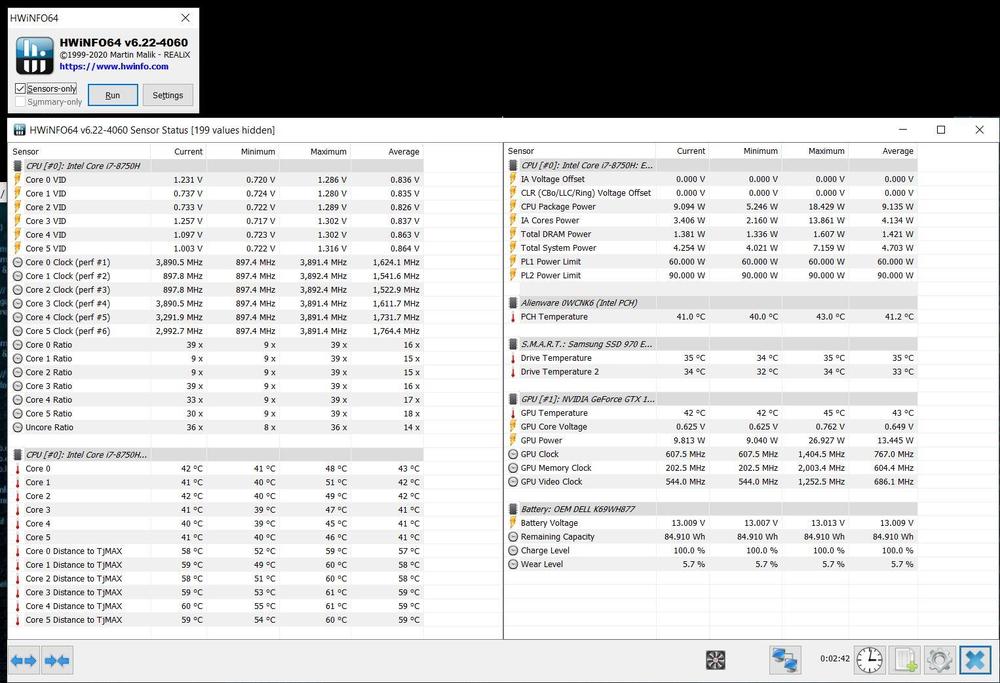

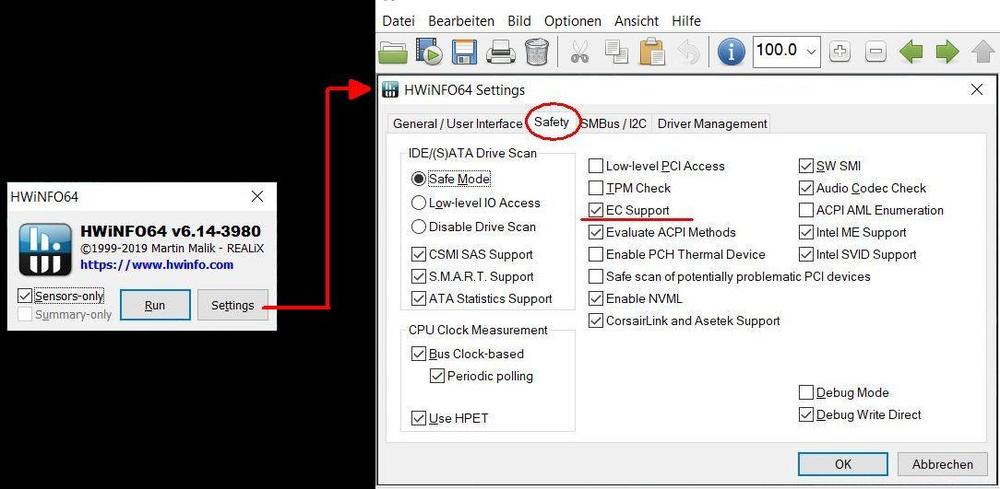

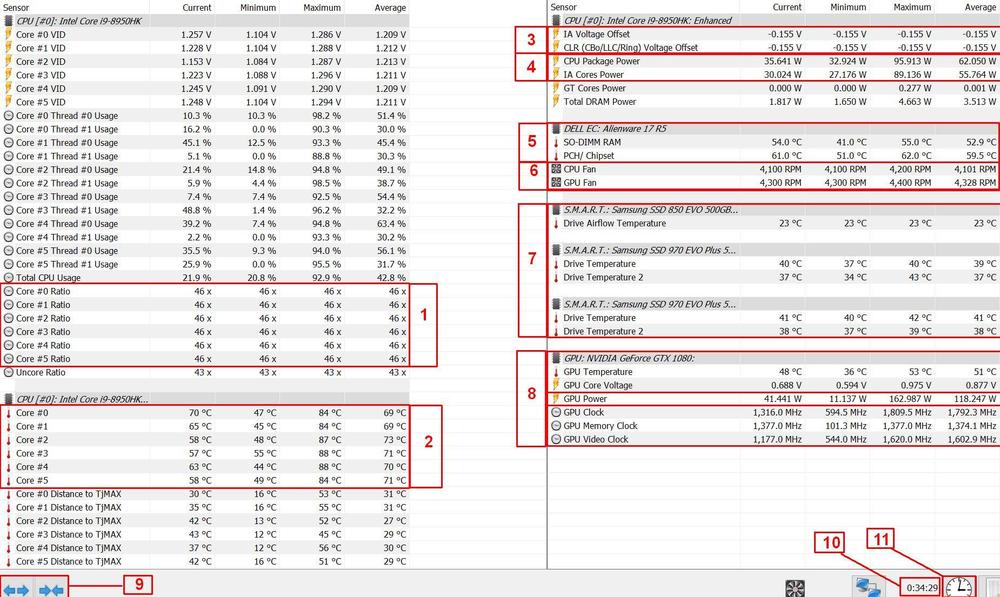

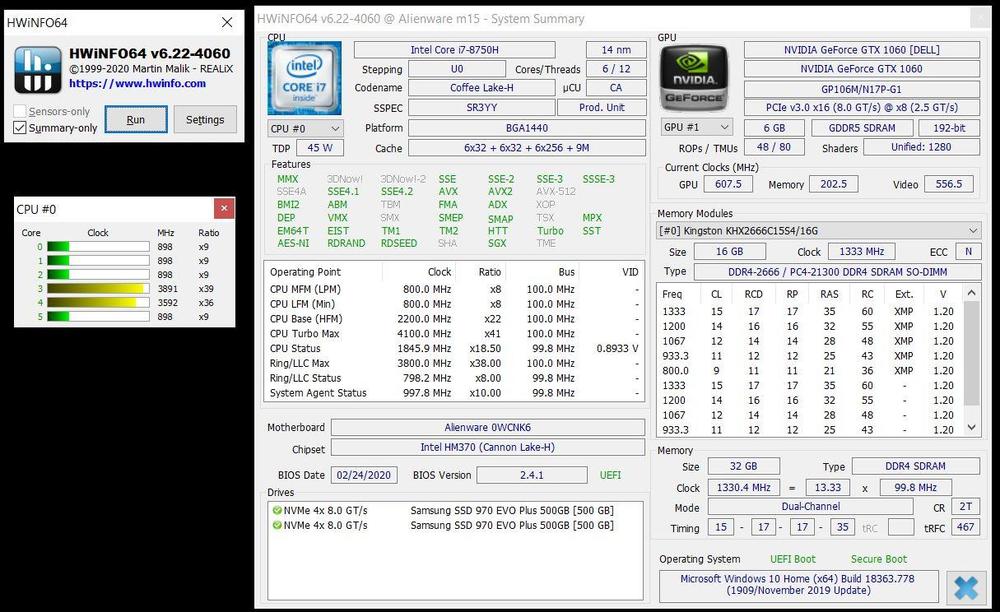

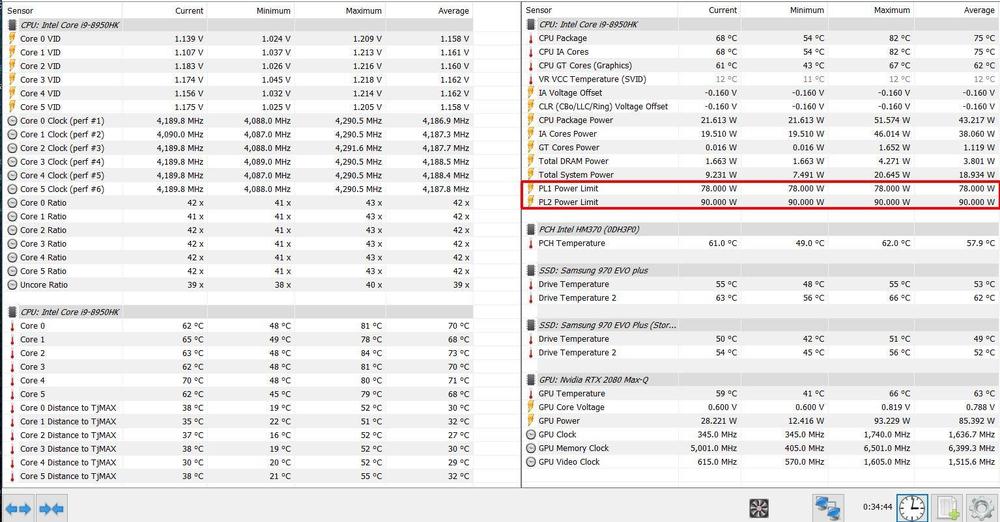

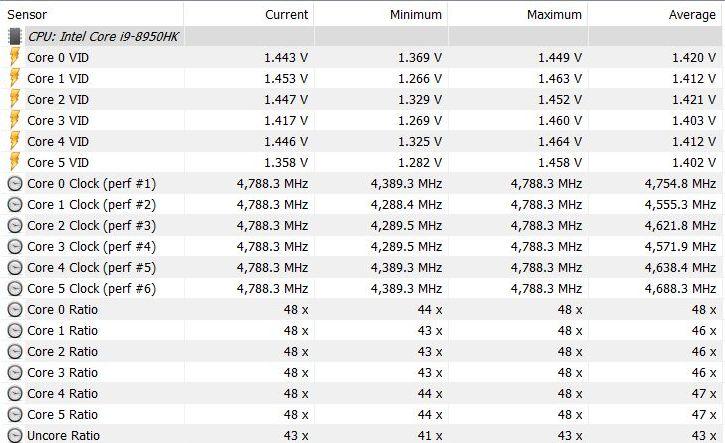

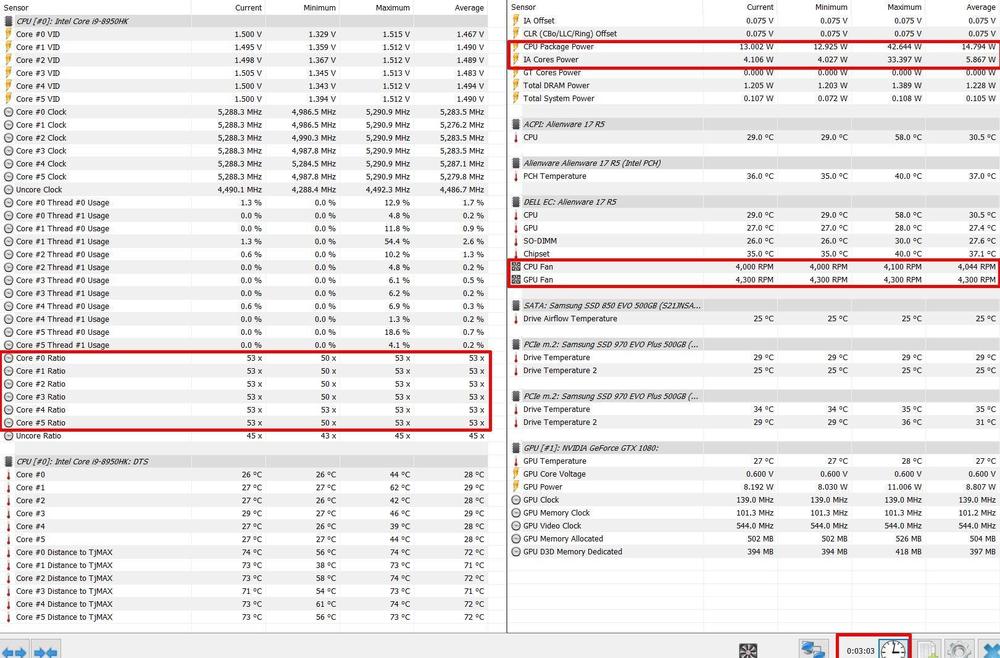

In der Vergangenheit kam es regelmäßig vor, dass Fragen mit irgendwelchen Temperatur- oder Taktwerten gestellt wurden. Um auf die Fragen gezielt eingehen zu können und überhaupt das ganze irgendwie sinnvoll zu bewerten, bedarf es oft weiterer Informationen. Ein dafür äußerst hilfreiches Tool ist HWinfo64. Damit lässt sich fast alles überwachen und das meiste bequem einstellen. Aus meiner Sicht ein Must-Have Tool, was auf keinem Rechner fehlen darf. Die Vergangenheit hat auch gezeigt, dass einige User mit dem Umgang Probleme haben oder bestimmte Werte falsch interpretiert werden. Deshalb wurde es schon lange Zeit für den HWinfo-Thread. 1. Installation Nicht selten kam die Frage auf: "Was muss ich auswählen?/ Welche Version muss ich nehmen?". Daher nehme diesen Punkt jetzt mal mit auf. Die Software lässt sich kostenlos auf der HWinfo-Homepage, im Download-Bereich runterladen. Die Version, die ich dafür immer nehme, ist Local (U.S.). Zur Installation gibt es nicht viel zu sagen. Ist halt eine Standard-Installation, wo man eigentlich nichts falsch machen kann. 2. Ansicht-Modus, Layout und Einstellungen Anfangs können einem die vielen Ansichtsmöglichkeiten, Einstellungen und Werte erschlagen und man weiß gar nicht wo anfangen soll. Gerade wenn sich das Layout im "Sensors only" noch in der Default-Ansicht befindet und einfach alles angezeigt wird. Ich gehe auf jede Ansicht kurz ein und nenne einige Gründe, wann welche Ansicht zu empfehlen ist. 2.1 Ansicht "all" Sobald man HWinfo installiert hat und es startet, fragt das Tool in welcher Ansicht man sich die Daten anzeigen lassen will. Wählt man gar nichts aus bzw. schränkt nichts ein, sprich keinen Haken bei Summary only und Sensors only, wird eine erweiterte Summary-Ansicht angezeigt. Das ganze sieht dann so aus: Man hat verschiedene Fenster, wo sich verschiedene Informationen ablesen lassen. Gerade die linke Anzeige kann sehr hilfreich sein, wenn man beispielsweise wissen möchte, welches Display man verbaut hat (sehr beliebte Frage bei Area51m) oder Detailinformationen über den RAM. 2.2 Ansicht "Summary only" Diese Ansicht ist eine Zusammenfassung (engl. Summary) aller wichtigen Daten. Bedeutet, welche CPU, GPU, welcher RAM, welche Festplatten-Konfig usw. ist verbaut + ein kleines Fenster, was die CPU so treibt. Ein beliebtes Beispiel, wo die angezeigten Informationen falsch interpretiert werden, ist der Arbeitsspeicher. Die Ansicht zeigt hier zwei Werte: Punkt 1 bezieht sich dabei nur auf den RAM und welche Profile auf seinem SPD-Chip hinterlegt sind. Das hat erstmal rein gar nichts damit zu tun, wie der Speicher im Notebook arbeitet. Man kann es mit den m.2 SSDs vergleichen. Nur weil 500 GB angezeigt werden, heißt es nicht, dass auch 500GB belegt sind. Genau dafür gibt es Punkt 2. Hier wird angezeigt, wie der eingesetzte RAM im Notebook arbeitet und welches Profil angelegt ist. In meinem Fall taktet der RAM auf 2.666 MHz mit den entsprechenden Timings. Der Takt wird oft als "Hälfte (1.333)" angezeigt und muss mal zwei multipliziert werden. Der Grund dafür ist, dass ein DDR = Double Data Rate Speicher zwei Signale pro Taktzyklus anlegt. Im Area51m, wo der RAM maximal auf 2.400 MHz läuft, steht dann dementsprechend der Taktwert auf 1.200 Mhz. 2.3 Ansicht "Sensors only" Hierbei handelt es sich über detaillierte Ansicht aller Sensoren und Werte mit Zeitangabe. Aus meiner Sicht, ist das die wichtigste Ansicht, da sich hier viele Rückschlüsse ziehen und Fehler, hohe Temperaturen, Leistung usw. gut bewerten lassen. Um diese Ansicht zu starten, einfach auf "Sensors only" klicken und Run. Anfangs im Standard-Layout bekommt man eine unübersichtliche Vielzahl an Informationen angezeigt. In der Regel braucht man nie derart viele Informationen. Glücklicherweise bietet HWinfo die Möglichkeit das Layout nach seinen Wünschen zu gestalten. Für die Temperatur- und Leistungsbewertung habe ich mein Layout wie folgt angepasst: Damit die Ansicht am Ende so aussieht, kann man mit Rechtsklick --> Kontextmenü --> "Hide" viele Werte ausblenden, die man nicht braucht. Mit "Rename" kann man die Werte umbenennen. Je nach Model, werden die Lüfter mal angezeigt und mal nicht. Werden die Lüfter nicht angezeigt, hat man die Möglichkeit über die Settings, zweiter Reiter Safety, durch das Deaktivieren des EC Supports, dass die Lüfter angezeigt werden. Soweit mir bekannt, ist das nur beim Area51m so. Beim AW17 R4/ R5 werden die Lüfter von Anfang an erkannt und tauchen auch in der Ansicht auf. Beim m15 & m17 R1 habe ich es nicht geschafft, dass mir die Lüfter angezeigt werden. Das liegt höchstwahrscheinlich daran, dass speziell Notebook-Mainboards "nicht bekannte" Controller einsetzen und HWinfo keine Informationen darüber bekommt oder diese nicht richtig interpretieren/ auslesen kann. Manchmal hilft ein Ausprobieren mit verschiedenen Einstellungen. Wo die Lüfter ebenfalls nicht anzeigt werden, ist wenn man HWinfo startet, die Lüfter aber still stehen (0 rpm). Sobald die Lüfter anlaufen wird ein Signal (rpm) ausgegeben und HWinfo führt sie dann in der Liste auf. Das kommt oft vor, wenn man sein Notebook im idle mit einem Kühler betreibt. 3. Verstehen Leistungsangaben und Temperaturwerte stehen unmittelbar mit anderen Faktoren im Verhältnis. Möchte man beispielsweise Temperaturen bewerten, so sind andere Werte ebenso zu berücksichtigen. Deshalb sind Antworten auf allgemeine Fragen wie "...sind die Temperaturen in Ordnung?" ohne Angabe weiterer Faktoren, die damit zusammenhängen, höchstens eine gutgemeinte Schätzung. Wenn man sein Layout mit "hide" und "rename" angepasst hat, sind folgende Werte mindestens zu empfehlen: 3.1 Verstehen der Werte Ganz oben in der Leiste finden sich verschiedene Angaben zur Zeiterfassung: Current: Aktueller Wert Minimum: Kleinster Wert in der gemessen Zeit Maximum: Höchster Wert in der gemessen Zeit Average: Durchschnittlicher Wert in der gemessen Zeit Punkt 1: Clock-Ratio Hierbei handelt es sich um den Multiplikator (kurz Multi), der zusammen mit dem Bus-Takt (üblicherweise 100 MHz FSB) den Kern-Takt ergibt. In dem Beispiel ist Multi 46x mal 100 MHz = 4.600 MHz/ 4,6 GHz. Durch die kleinen Zahlen ist dieser Wert schnell und einfach abgelesen. Punkt 2: Kern-Temperaturen Der Punkt sollte wohl selbsterklärend sein. Punkt 3: Voltage-Offset Dieser Punkt ist wichtig, um sein Undervolting zu überwachen. Gerne werden diese beiden Werte verallgemeinert oder gleichgesetzt, jedoch ist das nicht richtig. Wenn man beispielsweise mit ThrottleStop undervoltet, bezieht sich IA Voltage Offset im TS auf CPU Core UV und CLR Voltage Offset auf CPU Cache UV. Beim Undervolting sollten CPU Core und CPU Cache immer gleich hoch undervoltet werden, da in dem Fall immer nur der geringste Wert tatsächlich von der CPU angenommen wird. Undervoltet man beispielsweise CPU Core mit -150mV und CPU Cache mit -100mV, wird für die CPU insgesamt nur die -100mV übernommen. Punkt 4: CPU Package Power Ein besonders wichtiger Wert wenn man Leistung und Temperaturen bewerten möchte, wenn nicht sogar mit der wichtigste überhaupt. CPU Package Power zeigt an, was tatsächlich an Strom/ Leistung durch die CPU gegangen ist. Dieser Wert ist auch bekannt als TDP Leistung einer CPU. Zum Thema TDP werde ich mich hier jetzt nicht allzu detailliert äußern. Nur so viel: Die CPU ist mit 45w TDP Leistung spezifiziert und hätte ich die CPU nach Intel's Mess-Spezifikation mit Basistakt 2,9 GHz und 100%iger CPU-Auslastung betrieben, wäre ich auch irgendwo bei 45w gelandet. Da ich die CPU aber außerhalb der Intel-Spezifikation betreibe, ist es nicht überraschend, dass die Leistungsaufnahme bis sogar 95,913w im max hochging. Je nach Benchmark und Spiel wird die CPU verschiedenen hoch ausgelastet. Dadurch ergeben sich logischerweise auch andere CPU-Power Werte. Fließt weniger Strom durch die CPU, läuft sie natürlich kühler. Möchte man seine Temperaturen vergleichen, ist dieser Wert absolut wichtig zu beachten. Denn nur, wenn die gleiche Leistung generiert wurde, kann man überhaupt verschiedene Logs miteinander vergleichen. Zu einem Beispiel komm ich im Punkt 3.2. Punk 5: PCH und RAM Temperaturwerte des PCH und RAM. Sollte eigentlich auch selbsterklärend sein. Interessant wird dieser Punkt, wenn man beispielsweise einen PCH-Mod verbaut oder das System Freezes zeigt, welches sich auf zu hohe PCH-Temps zurückführen lässt. Der m15 R1, flach auf dem Tisch, im Out of the box Zustand ist da so ein Kandidat. Punkt 6: Lüfter Auch dieser Punkt sollte selbsterklärend sein. Jedoch ist er wichtig, wenn man Temperaturen vergleichen oder bewerten möchte. Drehen die Lüfter weniger, wird auch weniger Luft umgesetzt, was die Kühlleistung vermindert. Das sich die Lautstärke der Lüfter mit steigender RPM-Drehzahl erhöht, muss nicht extra erwähnt werden. Das sind alles so Faktoren, die bei der Bewertung wichtig sind. Punkt 7: SSD & HDD Sollte ebenfalls selbsterklärend sein. Auch diese Werte können unter bestimmten Voraussetzungen interessant und wichtig sein. Beispielsweise wenn man einen SSD-Kühler oder/ und zusätzlich einen externen Notebook-Kühler einsetzt. Natürlich auch wenn man die Festplatten mit großen Kopier-/ Schreibaufgaben belastet. Punkt 8: GPU Bei der Grafikkarte sollten die meisten Werte auch eigentlich klar sein. Anmerken muss ich hier ebenfalls den Punkt mit der Leistung und dem Strom (GPU Power). Auch das ist ähnlich zu vergleichen wie mit der CPU Package Power. Wird mehr Leistung gefordert, fließt auch mehr Strom, was logischerweise zur Temperaturerhöhung führt. Gerade wenn man eine "Shared-Heatsink-Konstruktion" hat, beeinflusst die Temperatur des einen Chips auch immer den anderen. Je nach Model, fällt das mal höher oder geringer aus. Punkt 9: Listenanzeige Mit diesem Button kann man sich die Listenanzeige auf mehrere Seiten ziehen. Ich wollte es mal erwähnen, bevor die Frage wieder auftaucht wie man die Liste auf mehrere Seiten bekommt. Punkt 10: Zeit Anzeige der gemessenen Zeit. Dieser Punkt ist besonders wichtig für das Loggen, dazu aber mehr im Punkt 3.2. Punkt 11: Reset-Button Eine Funktion zum resetten aller Werte. Zusammen mit dem Punkt 10 und dem Loggen eine wichtige Funktion. Zusätzliches: Noch einige Punkte, die hier jetzt nicht aufgelistet sind. Powerlimit 1 & 2: Die PL's tauchen normalerweise unter Punkt 4 auf. Es kann aber durch vorkommen, dass der Punkt hin und wieder verschwindet, so wie in meinem Chart halt. Die PL's begrenzen die Maximal-Leistung, die sich die CPU genehmigen darf. Je nach Lüfterprofil und Temperatur ändern sich die Limits. Meist ist das Setting so ausgelegt, dass mit erhöhter Lüfterdrehzahl auch die Powerlimits angehoben werden. Sprich, mit mehr Kühlleistung, darf sich die CPU auch mehr Leistung erlauben. Läuft man ins Thermal Throttling (Thermale Grenze 100°C), kann es vorkommen, dass die PL dynamisch angepasst und abgesenkt werden. Powerlimit 1 bezieht sich dabei auf das "Long Term Power Boost Window". Also das, was sich die CPU theoretisch die ganze Zeit gönnen darf, sofern sich nicht zu heiß wird. Powerlimit 2 bezieht sich dabei auf das "Short Term Power Boost Window". Also das, was sich die CPU im Boost genehmigen darf. Als Beispiel: Beim m15 R1 ist der Short Boost auf 30 Sekunden begrenzt und der Höchsttakt auf 4,8 GHz. Unter dem höchsten Lüfterprofil (Lüfter 100%), wird das Powerlimit auf PL1-78w/ PL2-90w angehoben. Wobei die All-Core Leistung mit 4,2 GHz sich ausschließlich nur auf PL1 dann bezieht. Distance to TjMax: Ein Punkt, der hin und wieder mal gefragt wird, ist TjMax. TjMax steht dabei für "Distance to Maximum Junction Temperature" (Wikipedia). Es gibt verschiedene Interpretationen wie dieser Wert verstanden oder gemessen wird. Es hängt zum einen von der eingesetzten Software ab und zum anderen auch ob CPU oder GPU gemeint ist. Da gibt's verschiedene Ansichtsweisen. Vereinfacht gesagt, HWinfo zeigt euch mit diesem Wert an, wie viel Luft (Headroom) noch im Temperaturbereich ist, bevor gedrosselt wird. Standardmäßig drosseln die CPUs bei 100°C. Jetzt im Beispiel oben hatte ich auf Core #0 beim Spielen 69°C im Durchschnitt. Distance to TjMax ist somit 31°C. Addiert man beide Werte zusammen, kommt man wieder auf 100°C. Bedeutet also soviel wie, dass ich theoretisch noch ein bisschen die Leistung aufdrehen könnte. Diese Anzeige kann schon praktisch sein, wenn man wissen möchte wie viel Spielraum man mit einem Setting bei Spiel A und wie viel bei Spiel B hat. Da verschiedene Spiele das System unterschiedlich stark belasten. Fehler-/ Warnmeldungen Ich werde hier jetzt nur die wichtigsten ansprechen, da der Beitrag ansonsten explodiert und ich bis morgen hier dran sitze. Der Begriff: "PROCHOT" steht für Processor Hot und taucht meist zusammen mit Thermal Limit auf, was bei den Notebooks meist bei 90-100°C erfolgt, je nach dem welches Limit gesetzt ist. Im Desktop-Bereich kann man thermale Grenzen meist selbst ein einem gewissen Rahmen bestimmten. Daher können zwei, auf den ersten Blick, gleiche Meldung sinnvoll erscheinen, da eine Meldung sich auf die Spezifikation der CPU bezieht und die andere auf das Mainboard-Setting. Der Begriff "Powerlimit exceeded" wird auch immer wieder mal gefragt. Diese Meldung tritt auf, wenn man an oder über sein Powerlimit kommt. Beispiel: Angenommen mein Notebook hat im Lüfterprofil "Silent" ein Powerlimit von PL1-45w/ PL2-60w. Mit ThrottleStop übertakte ich die CPU leicht und starte einen Cinebench. Die CPU gibt Vollgas und zieht so viel Strom, dass sie problemlos über die Powerlimits 45w/ 60w kommt. Das Mainboard, genauer gesagt der Voltage-Controller, der durch das BIOS, aufgrund des Lüfterprofils, die Powerlimits beschränkt, drosselt die Stromzufuhr. Kurz gesagt, erreichen der Powerlimits = Powelimit exceeded. Die CPU wird gezwungen sich runterzutakten, damit sie mit dem begrenzten Strombedarf wieder klar kommt. 3.2 Verstehen der Zusammenhänge In diesem Punkt führe ich verschiedene Beispiele auf, wie die Daten in Beziehung stehen und auf was zu achten ist, wenn man die richtigen Rückschlüsse ziehen will. Um die CPU-Temperaturen bewerten zu können braucht man mindestens drei Kriterien: CPU Package Power Lüfterdrehzahl Zeit Ist einer dieser Faktoren unbekannt, kann man keine logischen Rückschlüsse auf die Kühlleistung schließen. Man kann höchstens versuchen irgendwas zu schätzen, aber das war's auch schon. Natürlich sind noch andere Parameter wichtig, um eine Vergleichbarkeit bzw. genauere Bewertbarkeit zu schaffen, aber die drei oben genannten sind auch meiner Sicht die wichtigsten. Andere wichtige Faktoren sind: Log Start & Log Ende durchschnittlich gehaltener Takt Außentemperatur Undervolting Wärmeleitmittel Modding & externe Kühler Powerlimits Je nach dem was oder wie man bewerten möchte ist auch der Start- und Endpunkt des Logs enorm wichtig, weil man sonst mit idle-Werten seine Zahlen verfälscht/ schönt. Dann, zwischen den einzelnen CPUs/ GPUs gibt dann auch noch mal Unterschiede. Sprich, nicht jeder 9900K oder RTX 2080 performt gleich (auf Temps bezogen), jedoch jetzt für das Beispiel, lasse ich mal solche Faktoren außen vor. Zur Verdeutlichung was ich meine, hier mal zwei HWinfo Logs von meinem R5 im Vergleich. Im ersten Beispiel habe ich ca. 45 Minuten FC5 New Dawn gespielt. Der Log beläuft sich jedoch auf ca. 35 Minuten, weil ich immer ca. 10-15 Minuten warm spiele bevor ich den Log anfange. Dazu starte ich HWinfo und das Spiel. Nach der Warmlaufphase wechsel ich kurz auf HWinfo und resette die Werte (Uhr-Symbol). So kann ich sicher sein, dass ich meine eigenen Werte nicht mit Idle-Temps verfälsche. Später gehe ich dann während des Spiels wieder kurz auf HWinfo und mach dann den Screenshot. So bekommt man dann die reinen Ingame-Werte. Ein möglicher Log kann wie folgt aussehen: und jetzt noch mal ein 3 Minuten Log mit 5,3 GHz all Core: Deswegen ist der Takt für Temperatur-Bewertung zunächst erstmal uninteressant, weil Package Power + Kühlung (Lüfter) + Zeit die Temperaturen bestimmen. Deswegen ist Cinebench nicht unbedingt geeignet um Temperaturen zu bewerten. Der Benchmark ist einfach zu kurz und testet den absoluten Worst-Case für die CPU, was mit Gaming-Leistung/ Temperaturen nicht viel zu tun hat. Möchte man seine Werte später mit anderen Geräten vergleichen, sind auch die anderen Parameter interessant, damit man überhaupt eine Vergleichbarkeit schaffen kann. Beispielweise man möchte wissen, ob die Wärmeleitpaste MX-4 besser performt als Kryonaut oder ob sich Undervolting lohnt bzw. wie viel. ------------------------------------------------------------ Schlusswort Insgesamt betrachtet ist das natürlich schon recht viel Info und bei weitem nicht alles, was man so mit HWinfo noch machen kann. Dennoch hoffe ich, dass der Beitrag für den ein oder anderen interessant oder hilfreich war. Wenn ich noch etwas vergessen habe oder nicht richtig erklärt, sagt mir bitte bescheid. Dann ändere ich den Beitrag an der Stelle.13 Punkte

-

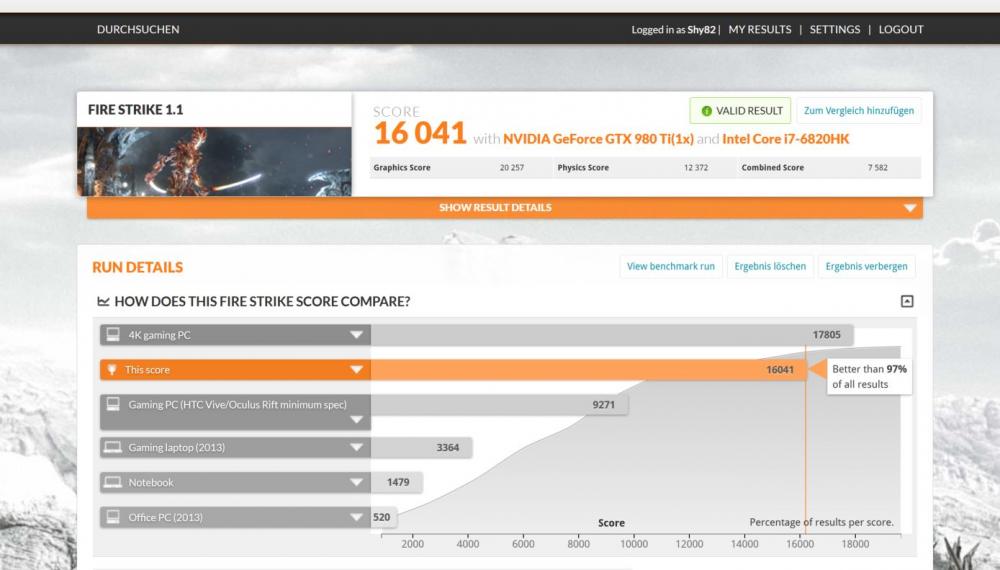

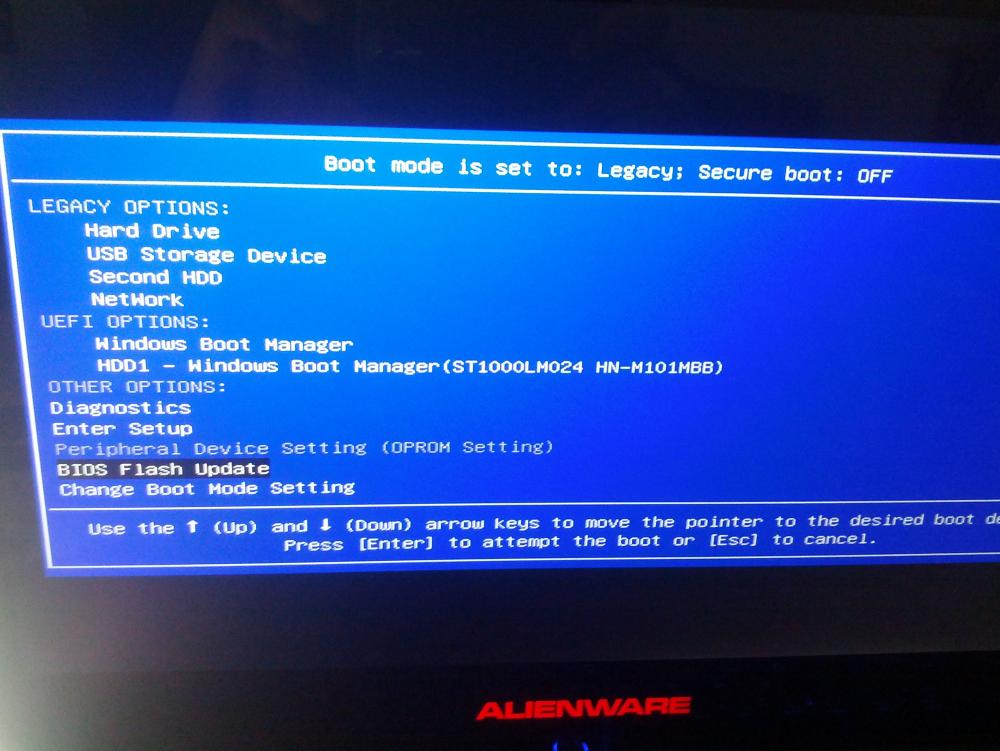

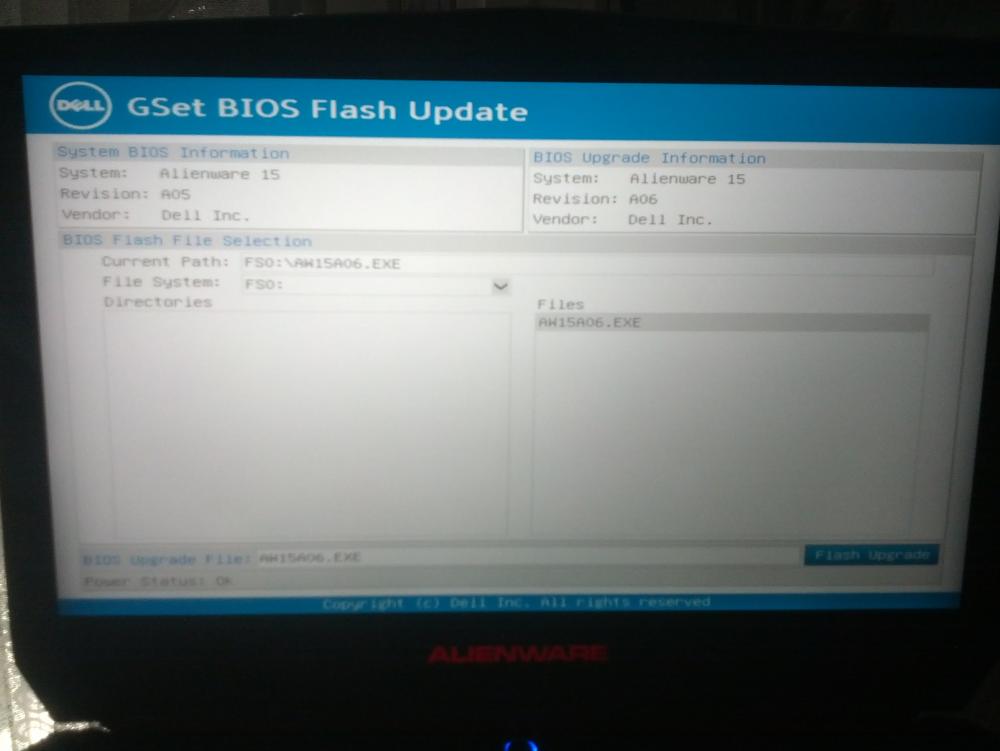

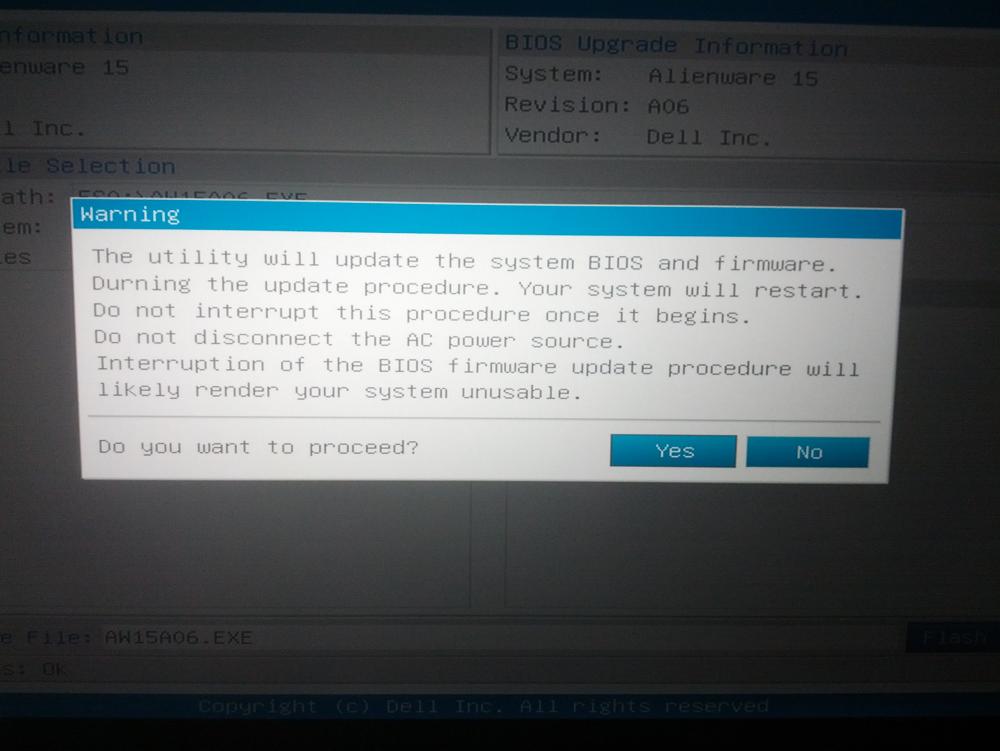

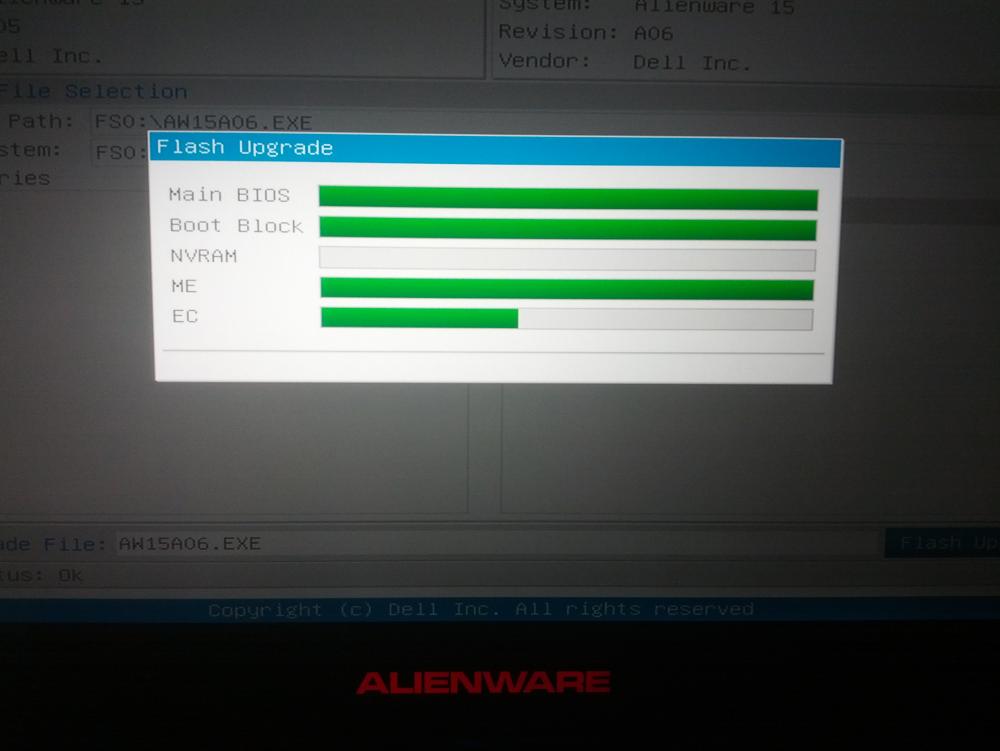

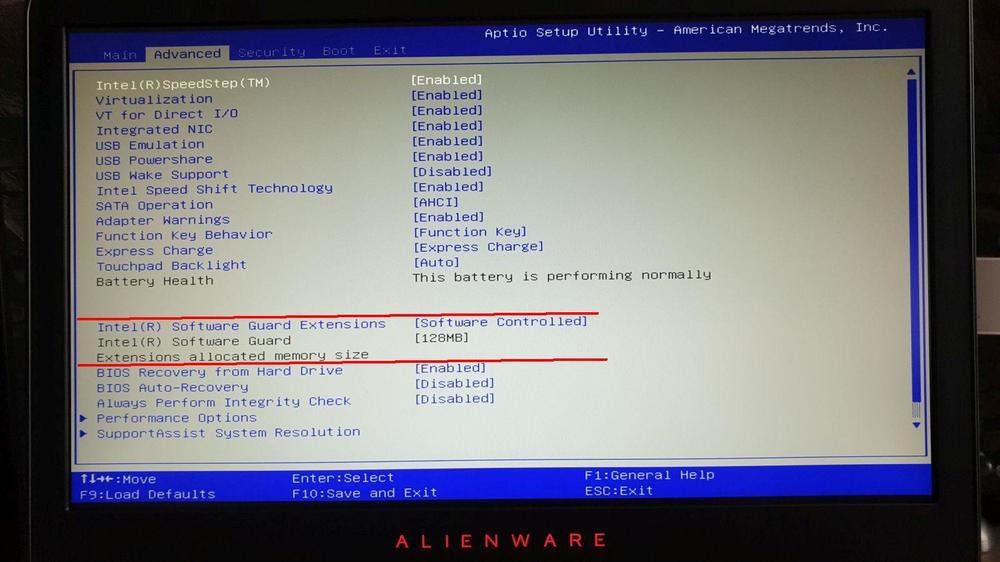

Eine überarbeitete Fassung dieser Anleitung findet ihr hier.: WIN10 Neuinstallation auf m.2 PCIe/NVMe SSD unter UEFI,RAID, SecureBoot on Achtung: Hier wird eine Clean-Installation beschrieben, bei der alle bisherigen Partitionen (auch OEM) auf der Boot-SSD gelöscht und von Windows neu erstellt werden. -in Stichworten/Fotos folgen in Kürze- Teil A ) Installation von Windows 10 unter UEFI Teil B ) Treiber und Programme nachinstallieren ************************************************************************** Teil A ) Installation von Windows 10 Voraussetzungen/Vorbereitungen: ⦁ BIOS-Einstellungen auf "default", dh. insbes. UEFI, SATA-Operation auf RAID und SecureBoot on ⦁ Aktuellste BIOS-Version, z.Zt. A05 / 1.2.7., mindestens A03/ 1.2.2. wg NVMe-Unterstützung ⦁ WIN10 ISO auf USB-Stick, zu erstellen via MediaCreationTool von MS-Seite, Optionen: "für anderen PC", "empfohlene Einstellungen für diesen PC wählen" "Updates herunterladen" ⦁ Intel Rapid Storage Technology (RST)-Treiber auf einem separaten USB-Stick, und zwar entzipped. Hierzu von Dell-Seite Treiberversion 14.6.1.1030 herunterladen, ausführen und dann, anstatt installieren, extrahieren auswählen und Dateien in einem wieder auffindbaren Ordner, zB. RSTunzipped, auf USB-Stick speichern. (USB-Stick kann auch andere, später benötigte Treiberdateien enthalten) Durchführung: ⦁ USB-Stick mit WIN10 ISO in USB-Slot einführen, PC starten, während des Bootens sofort einige Male F12 drücken, bis Fenster mit UEFI-Optionen usw. erscheint ⦁ Unter UEFI-Optionen den USB-Stick / Windows wählen, WIN 10-Installation und Annahme Lizenzbedingungen bestätigen, anschließend "Benutzerdefiniert" auswählen ⦁ Fenster mit Auswahl des Laufwerks für die Installation erscheint, allerdings nur mit Anzeige der HDD-Partitionen. Um die SSD sichtbar zu machen, Option "Treiber laden" auswählen ⦁ Separaten USB Stick mit RST-Treiber einführen und "durchsuchen" wählen ⦁ In dem darauf folgenden Explorerfenster, das USB-Laufwerk und den Speicherort für den RST-Ordner ausfindig machen. ⦁ Unterordner x64 markieren und mit "OK" bestätigen ⦁ Nach einiger Zeit erscheint im Fenster "zu installierender Treiber auswählen" der Eintrag mit dem Treiber "..\iaStorAC.inf", wenn markiert, mit "weiter bestätigen ⦁ Nach Installation erscheint wiederum Fenster mit Laufwerken, diesmal ergänzt um die SSD ⦁ Die Partitionen der SSD nacheinander jeweils markieren und löschen, bis am Ende unverändert die HDD und ein "nicht zugewiesener Speicherbereich" auf der SSD übrig bleiben. ⦁ Letztere markieren und "weiter" ⦁ Windows-Installationsroutine nicht unterbrechen, Interaktion erforderlich bei "Verbindung zum Netzwerk herstellen", wenn WLAN-Anschluss ausgewählt werden kann, bei "Einstellungen anpassen", Kontoanmeldung oder lokales Konto, wenn übersprungen ⦁ Nachdem erstmalig Desktop erscheint, installiert WIN10 unbekannte Geräte (anfangs Stück 16, siehe Geräte Manager während Installation), dabei nur bei ausdrücklicher Aufforderung zum Neustart aktiv werden, ansonsten abwarten, bis alle Geräte erkannt sind. ⦁ Windows Updates aktualisieren, Einstellungen individualisieren, insbes. Datenschutz, Desktop, Startkacheln anpassen ⦁ Vor eigenen Treiber bzw. Programminstallationen neu starten, sicherstellen, dass keine aktuellen Windows-Updates vorhanden sind. Teil B ) Treiber und Programme nachinstallieren Voraussetzungen/ Empfohlene Vorbereitungen: ⦁ Empfehlung: Erforderliche Treiber/Programme auf USB-Stick bereithalten. Hierzu Download aller Treiber für das spezielle Gerät von Dell-Seite, ggfs zusätzlich von Intel und Killer ⦁ Persönliche Stellungnahme: Nach heutigem Stand sind nahezu alle von Microsoft aktuell installierten Treiber zumindest rein nach der Versionsnummer identisch mit den Treibern von der Dell Seite. Eine Ausnahme bildet der aktuellere Dell-Treiber für Intel Management Engine Interface , ebenso sind aktuellere Treiberversionen für Bluetooth, Wlan, Ethernet, Intel Grafik, Nvidia Grafik auf Seiten der Hersteller vorhanden. Da nicht ersichtlich ist, inwieweit die von Dell angebotenen Treibern nicht eigens verändert wurden, ist es m.E. zumindest nicht verkehrt, diese auch bei gleicher Versionsnummer erneut zu installieren. Aus eigener Erfahrung weiche ich lediglich bei den Grafiktreibern von Intel (Intel Downloadcenter) und Nvidia (über GeForceExperience) sowie den Netzwerktreibern für WLAN, Ethernet und Bluetooth (alle über KillerNetworking) auf aktuellere Versionen aus. Es ist aber genausomöglich zunächst komplett bei den Dell Treiberversionen zu bleiben und diesen Schritt ggfs später zu unternehmen. ⦁ Nachstehend beispielhaft Liste der für mein Gerät (Konfiguration siehe unten) in Frage kommenden Treiberversionen/Programme (+ Version installiert, - nicht installiert) Stand 24.02.2016, in der Installationsreihenfolge, jeweils mit Neustart nach Installation. + BIOS 1.2.7/Dell - Chipsatz Device Driver, Version 10.1.1.7/ Dell Achtung: Obige Version 10.1.1.7 war wochenlang nicht zum Download erhältlich auf Dell-Seite, auch keine aktuellere, somit wären PCI-Bus Geräte unbenannt und mit MS-Treibern gesteuert anstatt Intel. Auf meine Nachfrage beim Support hieß es, man sollte davon ausgehen, dass es auch mit MS-Treibern funktioniert, insofern hatte ich den Treiber zuletzt erstmalig gar nicht installiert. Nun aber ist der alte Treiber wieder gelistet, kann also auch installiert werden * ) + Intel DPTF, Vers. 8.1.10603.192 /Dell + Intel Thunderbolt , Vers. 10.0.10125.21277/Dell + Intel Man.Engine Interface, Vers. 11.0.0.1173/Dell, installiert wird Treiber ("1172") + Realtek Card Reader, Vers. 15.2.32.250/Dell + Intel RST, Vers. 14.6.1.1030/Dell - Intel HD Gr., Vers. 20.19.15.4312/Dell -> oder gleich aktuellere Vers., siehe unten** - Nvidia Gr., Vers. 10.18.13.5442/Dell -> oder gleich aktuellere Vers., siehe unten** + Dell Airplane, Vers. 1.4.2.0/Dell - Killer Ethernet E2400 ) Vers. 1.1.56.1236/ Dell ) oder gleich - Killer WLAN 1535 )Vers. 1.1.56.1236/ Dell )aktuellere Version, - Qualcomm Bluetooth )Vers. 10.0.0.137/ Dell )siehe unten*** + Creative Soundblaster, Vers. 6.0.100.2058/ Dell - Kionix FreeFall, Vers. 1.1.4.0/ Dell, (auf nochmalige Installation verzichtet, da keine Änderungen,außer dass unter P&F dreimal Kionix auftaucht) + Synaptics Touchpad, Vers. 19.0.15.15/Dell + AW Command Center, Vers. 4.5.19.1/Dell + AW OnScreenDisplay, Vers. 0.33.0.20/Dell ------------------------------------------------------------------------------------------------------------- Anmerkungen: *) Wird kein Dell Chipsatztreiber installiert, ist es übrigens auch möglich, bei den betreffenden PCI-Bus-Geräten einfach mit "Treiber aktualisieren" via Gerätemanager auf die aktuellere Chipsatzversion 10.1.1.13 zu wechseln. Dann werden unter Systemgeräte 6 PCI-...-Brücken benannt (ein LPC Controller nebst 4 Root Ports sowie ein PCIe Controller), nun mit einem Treiber 10.1.1.13 von Intel anstatt MS Standardtreiber. Ebenso kann nach Installation der nun wieder verfügbaren Dell Version 10.1.1.7 ebenfalls via Gerätemanager auf 10.1.1.13 aktualisiert werden. Hinsichtlich der Funktionsweise sind mir bei all den genannten Versionen von Dell oder MS im Ergebnis gar keine Unterschiede aufgefallen, somit wäre Installation empfehlenswert, aber nicht zwingend, da die MS-Treiber offensichtlich auch ihren Dienst tun^^ Vielleicht bietet Dell bald wieder einen aktuelleren Chipsatz Device Driver zum Download an, genau so wie nun auch der Intel DPTF-Treiber aktualisiert wurde- **) + Intel HD Gr., Vers. 20.19.15.4352 v. 15.12.15/Intel ->Download "win64_154014.4352" von Intel Downloadcenter, entzippen auf separaten Ordner, dann 2 Optionen: -entweder gem. Beschreibung im Forum die Inf-Datei ausfindig machen und installieren oder -Intel Grafik unter Programme &Features deinstallieren, nach Neustart sofort auf Setup im separaten Ordner doppelklicken, fertig! + Nvidia Gr., Vers. 10.181.13.6191 v. 8.2.16/Nvidia ->Download GeForce-Experience Vers. 2.10.2.40 von Nvidia, nach Installation Grafiktreiber aktualisieren lassen auf Version 361.91, Express-Installation ***) + Killer Ethernet E2400 ) via Killer Suite , aktuelle Vers. 1.1.57.1686 + Killer WLAN 1535 )unter Support/Downloads "KillerNetworking" + Qualcomm Bluetooth )Bluetooth-Driver Suite, Vers. 10.0.0.191, auch "KillerNetw" ACHTUNG: Alle Informationen auf Basis eigener Erfahrungen, aber ohne Gewähr! Beschriebene Vorgehensweise ist nur ein Weg von vielen, so getestet auf System mit folgender Konfiguration: -i7 6820HK, 16GB RAM, Nvidia GTX 980M 4GB, Intel HD 530, -m.2 PCIe/NVMe SSD Samsung PM951 512 GB Firmware Version BXV7 (seit Bios Update auf 1.2.2), 1 TB, HDD, -Killer Wlan1535, Killer Ethernet E2400, Windows 10 Home. -SSD steckt in m.2-Slot Nr1. (der näher an Notebookaußenseite befindliche Slot mit 4 lanes) Kommentare/Korrekturen/Änderungswünsche sehr willkommen Viel Spaß beim Installieren & LG Blue13 Punkte

-

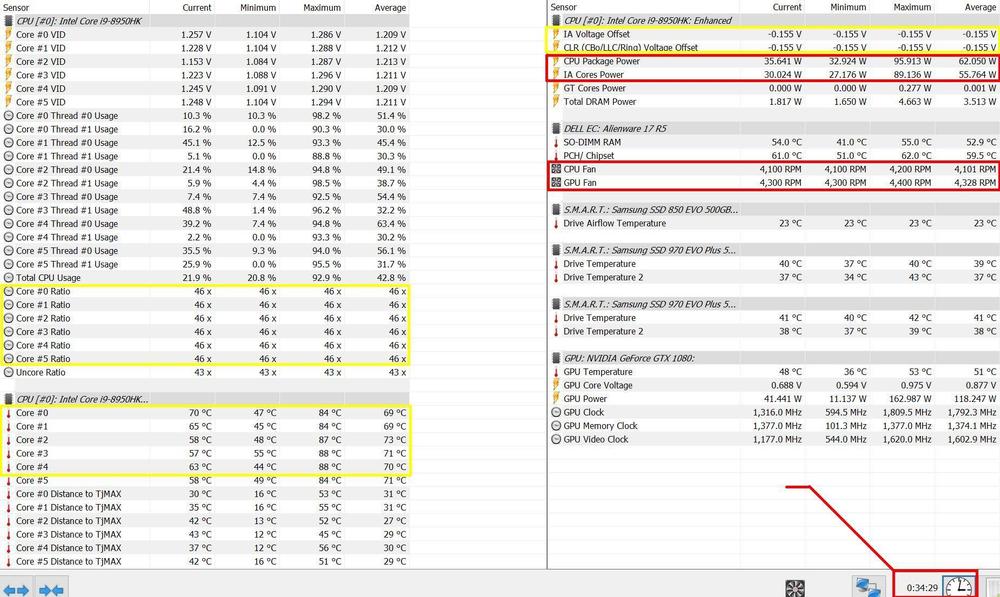

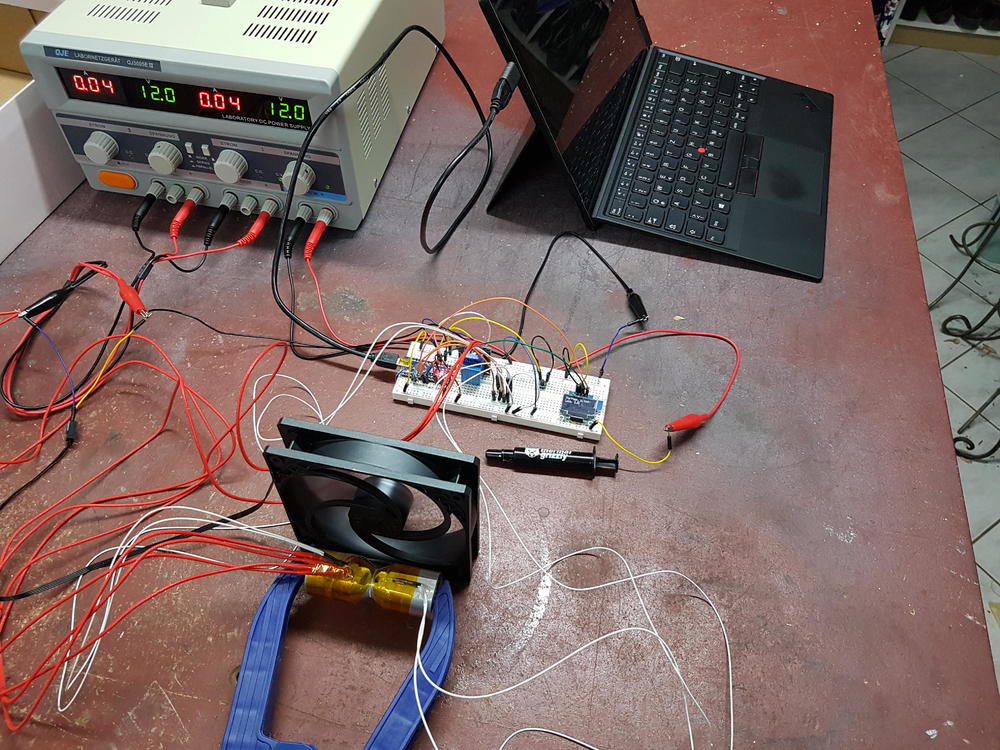

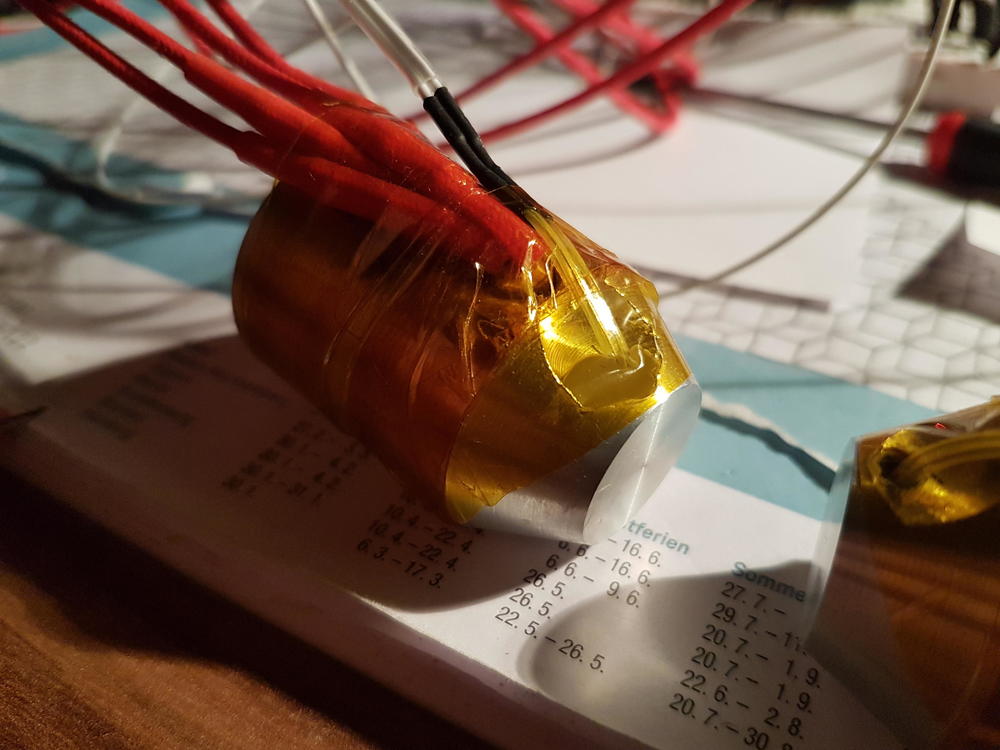

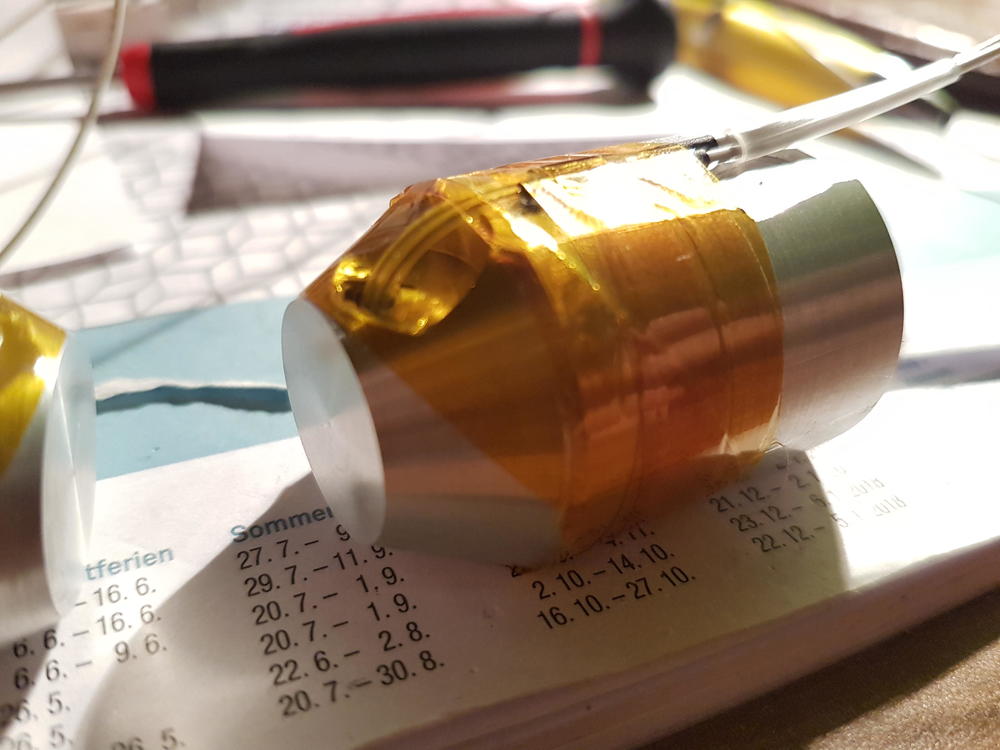

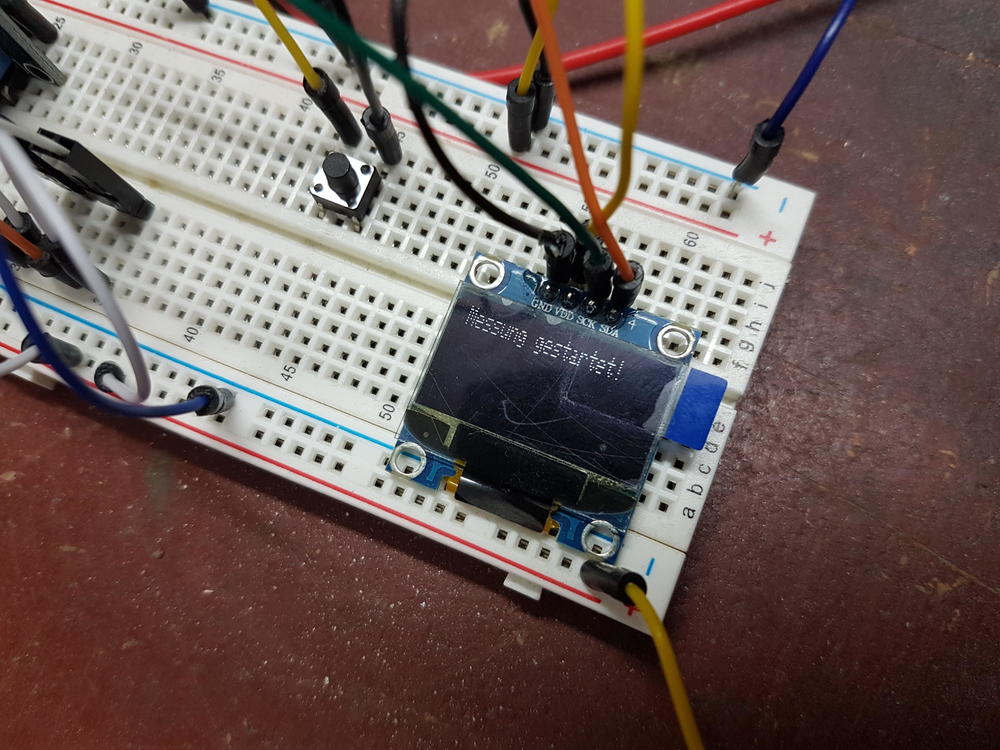

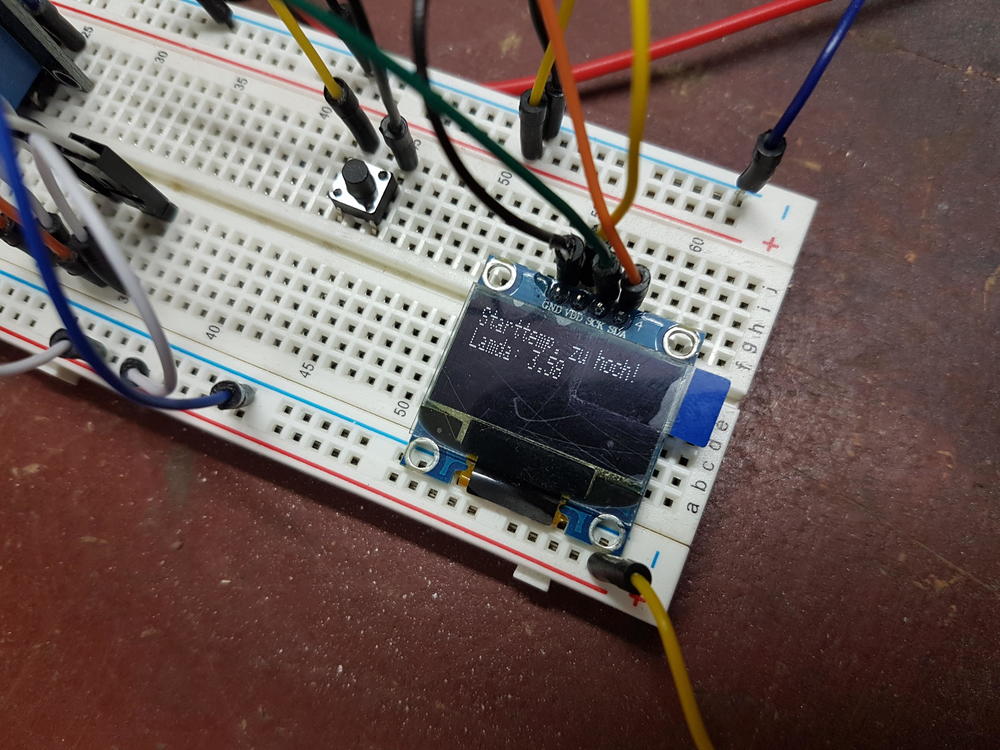

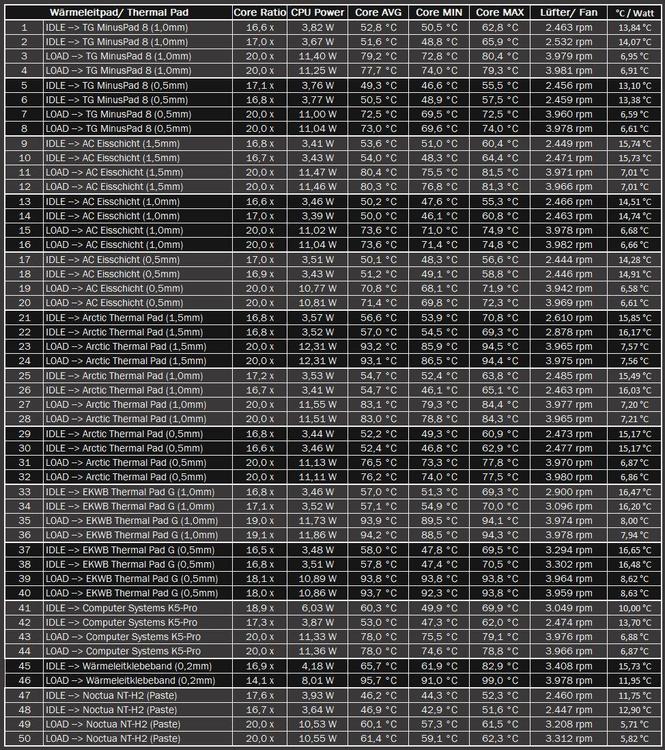

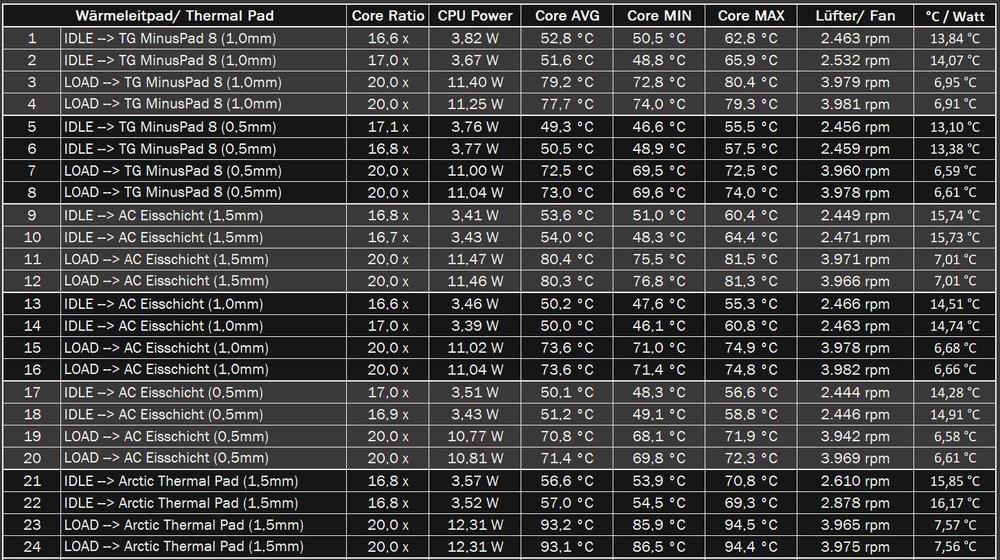

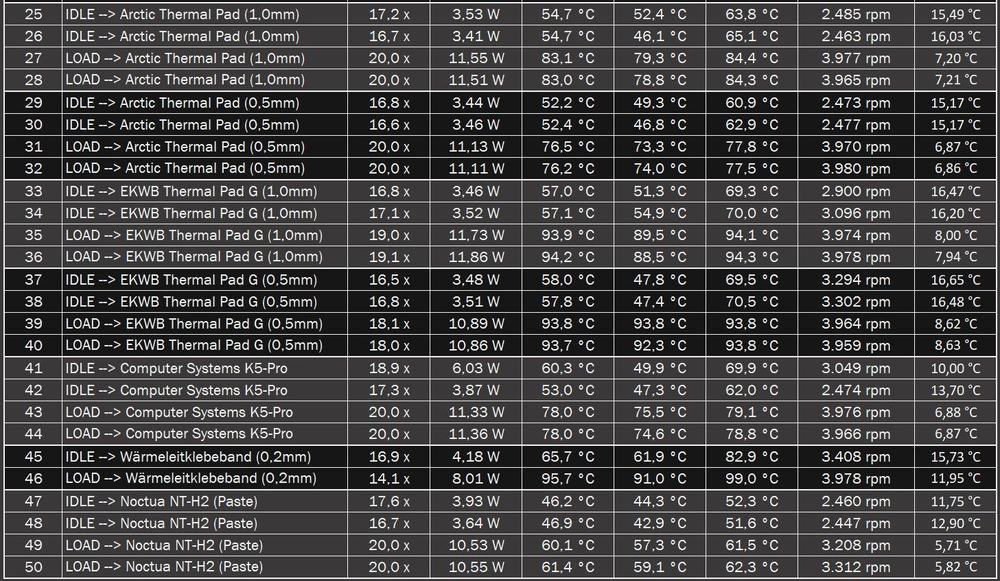

Moin zusammen, wie ihr sicher alle schon am eigenen Leib erfahren musstet, kann die Frage: "Was ist eigentlich die beste Wärmeleitpaste?" zu einem Kleinkrieg der Meinungen führen. Häufig kommen dabei Aussagen wie "Also bei mir läuft es seit dem 3°C kühler!" oder "Die Herstellerangaben stimmen nicht!" auf. Ich habe mir in den letzten zwei Wochen das Ziel gesetzt, mich mal wissenschaftlich mit dem Thema zu beschäftigen und, so hoffe ich, endlich Klarheit in diese Thematik zu bringen. Zunächst zu den oft gehörten und hier frei zitierten Aussagen: "Also bei mir läuft es seit dem 3°C kühler!" mag bei dem Autor stimmen, trägt aber keinerlei Aussagekraft für andere Systeme. Tatsächliche Abwärme, Lufttemperatur und Luftfeuchtigkeit, Nutzungsverhalten, Gehäuse, Kühloberfläche und Wärmeleitwege haben einen viel zu großen Einfluss. Selbst die Schlussfolgerung "besser als die alte Paste" ist mit Vorsicht zu genießen. Pasten altern viel zu unterschiedlich und auch die Temperatur, bei der sie getestet werden ist maßgeblich. Dazu aber im nächsten Absatz mehr. Sehr verwundert hat mich die Aussage: "Die Herstellerangaben stimmen nicht!". Ich konnte mir kaum vorstellen, dass die Hersteller auf ihren Verpackungen lügen. Viel zu groß ist die Gefahr sich damit selbst sein "Image-Grab" zu schaufeln. Bei der Recherche ist mir ein wesentlicher Punkt aufgefallen: Es steht nie dabei, in welchem Temperaturbereich der Wärmeleitwert gemessen wurde, oder bei welcher Schichtstärke. Die Wärmeleitfähigkeit von Flüssigkeiten (mit einem flüchtigen Bestandteil) nimmt mit steigender Temperatur ab. Das hängt mit dem Phasenverhalten der einzelnen Bestandteile der Paste zusammen. Wurde vom Hersteller also bei einer sehr geringen Temperatur gemessen, kann das die Wärmeleitfähigkeit positiv beeinflussen. Auch die Schichtdicke ist nicht uninteressant. Der Wärmeübergang an den Oberflächen der Paste ist schlechter als im Inneren. Also kann eine Dicke Schicht die Werte des Herstellers auch schönen. Aber Vorsicht! Das bedeutet nicht, dass eine dicke Schicht in PC besser ist. So oder so ist die Leitfähigkeit der Paste schlechter als die von Kupfer oder Aluminium. Daher sollte die Schicht natürlich IMMER so dünn wie möglich sein. Wie wir sehen konnten gibt es einige Möglichkeiten für die Hersteller die Ergebnisse zu beeinflussen. Doch wie bekommt man jetzt heraus welche Paste für welchen Anwendungsfall die beste ist? Zu diesem Zwecke habe ich mit einen Versuch überlegt. Wen nur die Ergebnisse interessieren, der kann weiter unten gucken. Für die technisch Interessierten unter euch (ich tippe auf die Mehrheit) habe ich versucht mein Vorgehen (hoffentlich verständlich) zusammen zu tragen. Grundaufbau und Idee: Der Versuch besteht aus einem leistungsstarken Labornetzteil, einem Steckbrett mit Arduino zur Datenverarbeitung, einem Laptop zur Anpassung der Prüfparameter, einem Lüfter zum schnelleren Abkühlen nach dem Versuch und.... dem eigentlichen Experiment. Das besteht aus zwei identischen Aluminiumkörpern mit Sensoren und Heizelementen. Beide Körper haben eine sehr ebene Prüffläche auf die die Wärmeleitpaste aufgetragen wird. Mit einer kräftigen Kunststoffklemme wird der Anpressdruck erzeugt. Die beiden Blöcke habe ich aus Aluminium gedreht und gefräst. Sie haben genau die gleichen Abmaße, was bei der Berechnung der thermischen Kapazität wichtig wird. Außerdem habe ich die Messoberfläche sehr fein geschlichtet, um eine spiegelnd glatte und Ebene Auftragsfläche für die Paste zu erzeugen. Anschließend habe ich den ersten Block mit zwei Keramikheizelementen ausgestattet. Diese eigenen sich besonders gut, da sie die Wärme über einen elektrischen Widerstand erzeugen und somit einen Wirkungsgrad von fast 100% haben. Jedes Element hat ca. 40W Wärmeleistung. Außerdem habe ich einen Temperaturfühler (NTC-Thermistor mit 100k) nur einen Millimeter hinter der Messfläche in der Mitte angebracht. Der zweite Block bekam nur einen Sensor und keine Heizelemente. Die Idee hinter dem Aufbau: Wenn der erste Block erwärmt wird beginnt ein Wärmestrom durch die Prüffläche und die Wärmeleitpaste in den zweiten Block zu fließen. Dieser Wärmestrom ist, in Abhängigkeit der Schichtdicke, der Auflagefläche und der Temperaturdifferenz, begrenzt durch den Wärmeleitwert zwischen den Prüfflächen. Thermodynamik 🤮 Ich muss zugeben, dass Thermodynamik nicht mein Lieblingsfach im Studium war. Jedoch ist das hier ein relativ einfacher Zusammenhang und somit nicht ganz so sauer, wie es meiner Überschrift aufstößt. Für die Berechnung des Wärmeleitwerts benötigen wir folgende Größen: Den Wärmefluss Qp [W] Den Abstand zwischen den Messflächen l [m] Die Fläche der Messflächen A [m²] Die Temperaturdifferenz der Messflächen dT [°K] Gesucht ist der Wärmeleitwert lamda [W/m*K] = [W*m/m²*K]. Nun ist leider die Wärmeleistung der Heizelemente nicht gleich dem Wärmefluss zwischen den Blöcken. Jeder kennt dieses Phänomen aus dem Alltag. Stellt man einen Topf auf den Herd, so dauert es eine Weile, bis er heiß genug zum kochen ist. Das liegt an der Wärmekapazität. Um das zu erklären ist es zunächst wichtig zu verstehen, dass Wärme und Temperatur nicht die gleichen Dinge sind. Wärme ist eine Energieform, weshalb ihre Einheit auch Joule oder Wattsekunde ist - daher auch der Wärmefluss in Watt! Die Temperatur gibt an, wie viel Energie in Abhängigkeit der Wärmekapazität ein einer bestimmten Menge eines bestimmten Stoffes enthalten ist. Das ist sehr kompliziert ausgedrückt, was im Grunde auch jeder von zuhause kennt. Man braucht mehr Energie um ein kg Wasser zu erhitzen als ein kg Luft. Die Einheit der Wärmekapazität ist J / kg * K (Joule pro Kilogramm mal Kelvin). Aluminium besitzt eine Wärmekapazität von 900 J/kg*K. Da ein Joule gleich einer Wattsekunde ist, kann man sagen, dass man 900W braucht um 1kg Alu um ein Grad Kelvin in einer Sekunde zu erwärmen. Werden nun beim Versuch die Blöcke erwärmt, kann man anhand dieses Zusammenhangs und der Heizdauer die Leistung berechnen, die in das Alu geflossen ist. Rechnet man die beiden Leistungen der Blöcke zusammen. Erhält man eine Leistung, die knapp unter der Elektrischen Leistung liegt. Die Differenz ist Wärme, die von den Blöcken an die Luft abgegeben wurde. Daraus wird ein Korrekturwert berechnet, der zusammen mit der Leistung des zweiten Blocks den Wärmestrom durch die Paste ergibt. Ab hier ist es einfach. Der Anstand der Messflächen ergab sich als 0,05mm und die Oberfläche ist aus der Konstruktion bekannt. Somit kann der Wärmeleitwert berechnet werden. Versuchsdurchführung und Ergebnisse Durch einen Druck auf einen kleinen Taster wir die Messung gestartet. Von der Raumtemperatur ausgehend habe ich auf 35°C, 50°C und 100°C erhitzt. Am Ende des Versuchs wurde mir das Messergebnis auf einem kleinen OLED angezeigt. Ich habe auch die Wärmeleitfähigkeit eines Motoröls gemessen, da diese dort sehr genau im Datenblatt angegeben wurde und konnte damit die Richtigkeit meiner Messergebnisse sehr gut belegen. Alle Werte lassen sich mit einer Genauigkeit von 0,02W/m*K reproduzieren. Ich habe folgende Pasten getestet: Thermal Grizzly Kryonaut fast 5 Jahre alt aber noch sehr flüssig und nicht eingetrocknet angegeben mit 12,5W/m*K Thermal Grizzly Kryonaut 1g Packung (war bei meinem Kühlblock dabei) kein Jahr alt aber schon ziemlich hart aber noch nicht trocken angegeben mit 12,5W/m*K Industrielle Wärmeleitpaste angegeben mit 1,73W/m*K Wärmeleitmittel 20°C bis 35°C 20°C bis 50°C 20°C bis 100°C Luftspalt (0,01mm) 0,17 W/m*K X X Thermal Grizzly (0,05mm) alt 7,03 W/m*K 4,24 W/m*K 1,68 W/m*K Thermal Grizzly (0,05mm) 1g Packung 2,40 W/m*K 1,48 W/m*K 1,48 W/m*K Motoröl 15W40 0,48 W/m*K 0,38 W/m*K 0,24 W/m*K Industriepaste 3,58 W/m*K 1,97 W/m*K 1,32 W/m*K Alle Angaben mache ich nach bestem Wissen und Gewissen aber ich hafte natürlich nicht für etwaige Fehler, die mir bei der Messung unterlaufen sein könnten. Als nächstes möchte ich gern von euch wissen, welche Pasten am interessantesten zum testen sind. Ich werde mir auf jeden Fall frische Thermal Grizzly Kryonaut und Arctic MX5 besorgen. Aber wenn ihr noch interessante Pasten für mich habt, lasst es mich gerne wissen. In Zukunft soll mein Prüfaufbau das Steckbrett verlassen. Ich werde eine Platine und ein eigenes Netzteil mit interner Leistungsmessung ergänzen um die Genauigkeit und die Bedienfreundlichkeit zu erhöhen. Falls ihr Ideen dazu habt auch immer her damit. Vielleicht hat ja sogar der eine oder andere an einem fertigen Produkt. Ich hoffe Ihr habt Spaß mit meinem kleinen Versuch und findet die Ergebnisse (die noch folgen werden) hilfreich. LG11 Punkte

-

Unser AlienFX ist ja richtig toll, man kann fast alle Farben einstellen wie man will, außer die Farbe Weiß. Wie dies geht möchte ich euch nun einmal zeigen. Erstellt euch ein eigenes Theme im CommanCenter und Speichert es ab. Nun liegt es unter Dokumente - AlienFX - Themes Öffnet nun so ein Theme mit dem EDITOR ( Bild 1 ) und sucht nach den Zonen die ihr ändern wollt ( Bild 2 ) und ändert dort Color1 und Color2 auf folgenden Schlüssel #FFFFFFFF ( Bild 3 ) Jetzt nur noch Speichern und das Theme im CommandCenter auswählen. Fertig MFG11 Punkte

-

Kurztest Razer Blade 18 und Asus Scar G18 So, hab sowohl das Blade 18 als auch das Scar G18 ausgepackt und getestet. Am interessantesten für mich war, wie viel Leistungsaufnahme die (starken) CPUs bei Dual-Load in einem noch erträglichen (4X dbA) Lüfter-Profil ("Balanced" oder ähnlich) abführen können/dürfen. Außerdem war für mich interessant, wie die Charakteristik der Lüfter ist. Zur (permanenten, also PL1) CPU-Leistungsaufnahme im „Balanced-Mode“. Bei z.B. FarCry 6, was auch ordentlich CPU-Leistung für viele fps möchte, fällt die CPU bereits nach kurzer Zeit auf ca. 45 W (Blade 18) bzw. 55 W (Scar G18). Das ist definitiv zu wenig, hierdurch fallen die fps auch ordentlich und CPU-Limits verschärfen sich deutlich. Für mich indiskutabel: FarCry 6 Savegame im CPU-Limit (wenig Load auf der GPU) im Leistungs-/Lüfter-Profil "Balanced" (beim Scar G18 heißt es „Leistung“) 10900K (Area 51m R2) bei um die 125 W: 92 fps 13950HX (Blade 18) bei um die 45 W: 103 fps 13980HX (Scar G18) bei um die 55 W: 118 fps 13900K (Mini-ITX-Desktop) bei um die 105 W: 161 fps Hinweis 1: Der in der Überschrift genannte Leistungs-/Lüfter-Modus bezieht sich natürlich nur auf das Blade 18 und Scar G18, das Area 51m R2 lief im Silent-Modus und der Desktop ja eh völlig individuell Hinweis 2: Beim Area 51m R2 wird bei um die 125 W im Silent-Profil (!) das langfristige Temp-Limit erreicht, sonst wären wohl noch paar fps mehr drinnen. Würde die GPU voll arbeiten, wären aber etwas weniger Watt möglich, aber wie gesagt: Silent-Profil! Die anderen beiden Laptops dürfen halt einfach langfristig gar nicht mehr (PL1) Hinweis 3: Egal ob die GPU voll arbeitet oder nicht, beim Desktop wird bei um die 105 W mein langfristige Temp-Limit erreicht (das Mini-ITX-Gehäuse ist ja sehr klein und es wird ein kleiner CPU-Kühler verwendet, den ich auch noch zusätzlich auf leise getrimmt habe. Was der 13900K aber bei um die 105 W abliefert, ist ja absolut beeindruckend). Mit mehr Lüfter-rpm und/oder einem größeren CPU-Kühler würden noch mehr als 161 fps möglich sein. Der Abstand zu den mobilen Top-CPUs bei Dual-Load in den 18er Laptops ist ja aber jetzt schon riesig. Bei um die 90 W liefert der 13900K übrigens noch immer 156 fps - wie gesagt 161 bei um die 105 W). Hinweis 4: In dem Beispiel / Spiel mögen für viele auch bereits die 92 fps des Alienware Area 51m R2 / 10900K ausreichend sein. Aber erstens gibt es üblere Stellen im Spiel, und zweitens gibt es mittlerweile so einige Spiele, wo man die fps quasi durch 2 teilen kann, und dann bleibt bei allen Laptops nicht mehr viel über bzw. nicht einmal stabile 60 fps in entsprechenden Szenen. Das mag bei solchen Spielen auf schlechte Entwicklung / Optimierung / Ports zurück zu führen sein, aber was will man machen, wenn einem diese Spiele gefallen... Das Scar G18 ist schneller als das Blade 18, was nicht nur durch die höhere Leistungsaufnahme zu erklären ist. Einer der Gründe ist die etwas besser taktende CPU, ein weiterer vielleicht der Ram (nicht verglichen). Beim maximalem Leistungs-/Lüfter-Profil (5X dbA) sind dann im gleichen Test ca. 65 W bei beiden dauerhaft möglich. Natürlich liegen die ersten wenigen Minuten bei beiden über 100 W an. Ein so lautes (Hilfe!) Lüfter-Profil ist für mich indiskutabel. Zudem ist die Leistungsaufnahme für meinen Geschmack immer noch zu wenig: FarCry 6 Savegame im CPU-Limit (wenig Load auf der GPU) im maximalen Leistungs-/Lüfter-Modus 10900K (Area 51m R2) bei um die 125 W: 92 fps 13950HX (Blade 18) bei um die 65 W: 110 fps 13980HX (Scar G18) bei um die 65 W: 118 fps 13900K (Mini-ITX-Desktop) bei um die 105 W: 161 fps Die ganzen Zahlen schwanken minimal, ist quasi jeweils ungefähr ein Mittelwert. Es geht ja auch nicht darum, ob es hier und da 1-2 fps weniger oder mehr sind, man sieht überall große Unterschiede. An der Stelle nochmal gesagt: Es geht hier um ein CPU-Limit, die GPU ist jeweils bei weitem nicht ausgelastet. Es spielt also keine Rolle, dass im Mini-ITX-Desktop eine schnellere 4080-Desktop-Karte verbaut ist, die fps-Differenzen kommen alleine durch die CPU-Unterschiede zu Stande. Übrigens werden die CPUs der beiden Laptops, auch im maximalen Leistungs-/Lüfter-Profil, im Dual-Load schon sehr heiß. Das künstliche Limit also z.B. mit ThrottleStop zu umgehen (sofern möglich) würde hier nicht viel bringen. Viel ist halt relativ, müsste man testen und schauen ob einem das reicht. Ich habe auch mal beim Blade die Leistung der GPU deutlich reduziert (weit unter 70 W), dann hat die CPU in FarCry 6 tatsächlich - scheinbar dauerhaft zwischen deutlich bessere 90-110 W geschwankt. Aber ab 70-80 W auf der GPU (und das braucht man ja mindestens schon...) fällt sie dann auf die genannten ca. 65 W ab. Wahrscheinlich irgendwann so oder so. 90-110 W bringen übrigens schon 12X-13X (je nach Laptop) fps bei FarCry 6, aber man wird sie halt nur in den ersten wenigen Minuten zu Gesicht bekommen... (im CPU-Limit in genau diesem Savegame bzw. an der Stelle im Spiel). Wie ich gestern schon gepostet habe, kann das MSI GT77 Titan oder auch das XMG Neo 16 (sicher auch 17) teilweise mehr als 65 W durchschnittlich abführen (laut computerbase.de), und das auch bei Dual-Load. Das Blade 18 und Scar G18 jedoch nicht, wenn die GPU stock oder auch mit UV arbeitet. Und das ist definitiv in manchen Spielen ein riesen Nachteil (heftigeres CPU-Limit hier und da). Ich glaube nicht daran, dass es beim m18 großartig anders sein wird. Und das MSI oder das XMG gefällt mir nicht bzw. lässt so viel Leistungsaufnahme auf der CPU auch nur in (für mich) viel zu lauten Leistungs-/Lüfter-Profilen zu, was ja bekanntermaßen für mich sowieso ein absolutes Ausschlusskriterium ist. Das würde natürlich auch das m18 betreffen. Zur Charakteristik der Lüfter Blade 18: Gar nicht so übel, auch wenn ich es nicht rauschig nennen würde. Rauschig ist es für mich erst, wenn ein Lüfter sich mehr rauschig anhört, als die anderen Geräusche. Ein Area 51m R2 würde ich als rauschig bezeichnen, auch wenn man dort noch was anderes raushört, aber das macht eben keine 50% aus. Richtig rauschig sind meines Erachtens z.B. gewisse Desktop-Lüfter von Noctua Scar G18: Schlechter finde ich. Hat noch weniger mit Rauschen zu tun, irgendwie mehrere unangenehme Geräusche. Zudem heftiges coil-whine, was ich beim Blade 18 nicht bemerkt habe. Es ist lauter wie bei einigen Highend-Desktop-GPUs... Auf die Lautstärke jeweils brauche ich nicht einzugehen - beide viel zu laut. Und leiser betreiben ist wegen zu starker Drosselung, sei es thermisch oder künstlich, nicht vernünftig möglich. Display: Allgemein: 18 Zoll wirken erstmal mega toll und modern (dünner Rand für so ein großes Display). Und man benötigt eigentlich auch kein 27“ mehr auf dem Schreibtisch, man ist ja näher dran. Aber viele von euch nutzen ja eh größere Displays als 27 Zoll auf dem Schreibtisch. Blade 18: Katastrophe, wie @pitha1337 schon schrieb. Flickering vom Feinsten (auch in Windows - das wird sicher noch irgendwann gefixt), dazu sieht man das „Netz“ des Displays. Bei der Auflösung bei 18“ müsste das nicht sein, ist einfach kein gutes Panel. Scar G18: Deutlich besseres / zufriedenstellendes Panel, ohne die Farben beurteilt zu haben. Ich gehe auch nicht auf Glowing und Clouding ein, das haben beide ganz gut gehabt... Anmutung & Qualität Blade 18: Natürlich super gut. Scar G18: In live deutlich wertiger als ich bisher so an Bildern und Videos gesehen habe. Ich habe es aber auch bisher nur kurz mit Tageslicht gesehen. Meine aber auch die Oberflächen und das wenig knarrt oder sowas. Sollte man sich aber auf jeden Fall live anschauen, wenn der Rest passt / es einen interessiert Auf Tastatur, Design, Sound, Webcam, Akkulaufzeit usw. gehe ich jetzt nicht ein. Wenn ihr Fragen habt, schießt los. Dann noch für @captn.ko Undervolting @ CPU: Hab wirklich keinen Nerv das noch zu testen, sorry, zumindest nicht mehr heute. Ich schicke es aber erst Montag oder so zurück, insofern ist noch Zeit. Wie im Artikel von gestern steht, geht beim Scar G18 nur 30 mV übers Bios, beim Blade sicher nicht mehr. Und selbst wenn, die CPU hat andere Probleme - auch mit UV… PL-Reduktion @ GPU: Ist bei beiden über z.B. Afterburner möglich, im Gegensatz zu älteren Ampere-/Turning-Laptops. Noch besser - vorallem für Teillast - ist natürlich die Reduktion der Maximalspannung (UV) über z.B. den Afterburner Curve Editor (was natürlich auch wie immer funktioniert). Computerbase hatte aber mit der PL-Reduktion über Afterburner teilweise Probleme, so dass sich nicht alle Spiele daran gehalten haben. Das habe ich jetzt nicht getestet. Fazit Wie ich hier geschrieben hatte, benötige ich (nun definitiv glücklicherweise) nicht mehr unbedingt ein Gaming-Laptop, und werde mein Mini-ITX-Desktop behalten bzw. einen Zweiten für meine Frau bauen (welcher das Area 51m R2 Laptop ersetzt. Für mobile Zwecke bzw. Mitnahme Urlaube / Hotels, wo wir nicht zocken, haben wir ein 16" Macbook Pro). Nach diesem Test sind im Prinzip alle Gaming-Laptops - unabhängig vom Lüfter-Profil - nicht für mich (als Haupt-Spiele-PC) zu gebrauchen. Ein Area 51m (R2) durfte noch im Silent-/Balanced-Profil ins CPU-Temperatur-Limit laufen (und das entsprechende Kühlsystem hierzu war vorhanden!), das hätte man wenigstens wieder so machen können, anstatt in leisen und mittleren Lüfter-Profilen künstliche Leistungsaufnahme(TDP)-Limits zu setzen. Schade, aber schon seit Jahren bei allen Herstellern und Modellen die ich kenne Normalität. Aber manche Modelle würden auch wegen schlechtem Kühlsystem nicht mehr Leistungsaufnahme im entsprechenden Lüfter-Profil schaffen, teilweise macht es also Sinn... außerdem liegen so nicht immer 95-100 Grad an, was den Käufer beruhigt. Im Vergleich zum 13900K im Desktop ist die mobile Variante - unabhängig der Leistungsaufnahme - deutlich langsamer wie man sieht. Aber das war ja schon immer so und wird wohl auch so bleiben. Das einzige was wirklich toll ist, ist natürlich die Effizienz bzw. die Perfomance der CPUs bei nur 45-65 W. Aber wenn man den Desktop-13900K auf 45-65 W reduzieren würde, wäre das ähnlich. Ich glaube man muss abschließend einfach festhalten und akzeptieren, dass eine hohe dauerhafte (PL1) Leistungsaufnahme von z.B. um die 100 W auf der mobilen CPU bei gleichzeitiger GPU-Load - wenn überhaupt (bei vielen Gaming-Laptops schon mal nicht) - nur mit sehr lautem Leistungs-/Lüfter-Profil möglich ist, was für mich absolut nicht in frage kommt. Es müsste sich vorher für mich also grundlegend das Kühlsystem ändern und/oder die Chips dürften nicht mehr so viel Leistungsaufnahme benötigen. Vorher kann wohl kein Gaming-Laptop mehr für mich in frage kommen. Eine absolute Ausnahme war eigentlich das Area 51m (R2). Möglicherweise auch das Clevo X170KM-G/XMG Ultra 17 (hatte ich nie getestet und wird wie das Area 51m nicht mehr mit aktueller Gen versorgt). Im Grunde hat sich also mit der neuen Gaming-Laptop-Generation jetzt gar nichts geändert. Die 18 Zoll Gaming-Laptops sind in allem etwas besser, aber eben halt auch nicht mehr. edit: Drei Hinweise unter den fps-Werten (FarCry 6 Test) hinzugefügt.10 Punkte

-